Sai gia tutto sull’ottimizzazione dei motori di ricerca (SEO), l’importanza di un sito ben strutturato, le parole chiave pertinenti, standard tecnici e molti contenuti ma è probabile che non hai mai pensato di ottimizzarlo per la scansione da parte di Googlebot.

L’ottimizzazione per Googlebot non è la stessa della SEO perché va oltre. La SEO è più focalizzata sul processo di ottimizzazione per le query degli utenti. L’ottimizzazione per Googlebot si concentra su come il crawler di Google accede al tuo sito web.

Ci sono aspetti comuni, ovviamente, ma fare la distinzione è importante, perché la scansione di un sito è un passaggio fondamentale per garantire una buona SEO.

Che cos’è Googlebot?

Googlebot è il robot (detto anche spider) di ricerca di Google che esegue la scansione del web e crea un indice. Il bot passa attraverso ogni pagina a cui ha accesso e la aggiunge all’indice: può quindi offrire questa pagina agli utenti utilizzando il motore di ricerca di Google.

Il modo in cui uno spider Googlebot esegue la scansione del tuo sito è fondamentale per comprendere come ottimizzare il processo. Ecco le basi:

- Google bot impiega più tempo ad esplorare siti con un pagerank significativo. Il tempo che Googlebot offre al tuo sito viene chiamato crawl budget o budget di scansione. Maggiore è l’autorità di una pagina, più avrà budget di scansione.

- Il crawler di Google naviga costantemente nel tuo sito e più trova contenuti, backlink e menzioni social recenti, più è probabile che il tuo sito venga visualizzato nei risultati di ricerca. È importante notare che non esegue la scansione di tutte le pagine del tuo sito in modo permanente. Approfittiamo per ribadire l’importanza di un’efficace strategia di content marketing : i nuovi contenuti catturano sempre l’attenzione del crawler e migliorano la probabilità di ottenere pagine con un ranking più alto.

- Googlebot crawler accede innanzitutto al file robots.txt di un sito per scoprire le regole per esplorare il sito. Tutte le pagine non autorizzate del robots.txt non verranno indicizzate.

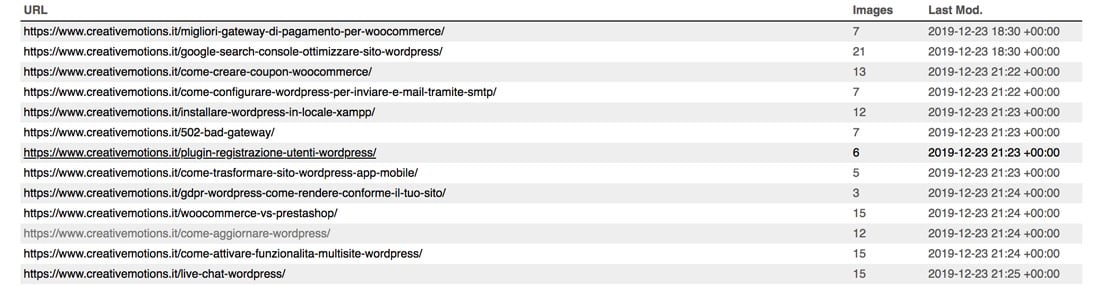

- Il Google-crawler utilizza le sitemap.xml per scoprire tutte le aree del sito da esplorare e indicizzare. A causa dei diversi modi in cui i siti sono costruiti e organizzati, lo spider potrebbe non esplorare automaticamente ciascuna pagina o sezione. Contenuti dinamici, pagine scarsamente posizionate o archivi di contenuti di grandi dimensioni con pochi collegamenti interni potrebbero trarre vantaggio da una Sitemap stilata correttamente.

Ottimizzare le pagine per la scansione da parte del crawler di Google

Poiché l’ottimizzazione per il crawler Google precede quella per i motori di ricerca (SEO), è importante che il tuo sito sia indicizzato nel modo migliore e il più preciso possibile. Vediamo come farlo.

- Googlebot non scansiona i contenuti JavaScript, gli iframe, DHTML, Flash e AJAX. O meglio, Google non è stato molto esplicito su come il suo spider analizza JavaScript e AJAX. Poiché le opinioni sull’argomento sono diverse, è meglio non registrare gli elementi importanti del tuo sito e / o il suo contenuto negli script AJAX / JavaScript. Se non riesci a visualizzare i tuoi contenuti in un browser di testo, gli spider dei motori di ricerca potrebbero avere lo stesso problema nella navigazione del tuo sito.

- Migliora il tuo file robots.txt. Uno dei motivi per cui il file robots.txt è essenziale è che funge da direttiva di scansione per Googlebot. Googlebot ha una quota di scansione e spenderà il suo budget di scansione su qualsiasi pagina del tuo sito. Devi dire a Googlebot dove dovrebbe e non dovrebbe spendere questo budget. Se sul tuo sito sono presenti pagine che non devono essere sottoposti a scansione, modifica il file robots.txt di conseguenza. Meno tempo trascorre Googlebot in sezioni non necessarie del tuo sito, più può navigare nelle sezioni più importanti. La modalità predefinita per Googlebot è la scansione e l’indicizzazione di tutto. Lo scopo del robots.txt è di dire a Googlebot dove non dovrebbe andare. Orienta il crawler solo sul contenuto che desideri posizionare su Google.

- Crea nuovi contenuti. Il contenuto sottoposto a scansione frequente ha maggiori probabilità di guadagnare traffico. È fondamentale sottoporre a scansione le pagine peggio posizionate il più spesso possibile. A Google piacciono le novità e il suo spider arriverà immediatamente dopo che hai fatto clic su “Pubblica”!

- I link interni sono una mappa che Googlebot può seguire mentre naviga nel tuo sito. Più solida è la struttura dei tuoi collegamenti interni, più Googlebot crawler sarà in grado di navigare nel tuo sito. Per analizzare la struttura dei tuoi collegamenti interni, vai su Google Search Console > Collegamenti interni. Se le pagine in cima all’elenco sono pagine con contenuti che vuoi vedere nelle SERP, allora tutto procede bene.

- Non dimenticare di creare il tuo file Sitemap!

Se desideri migliorare le prestazioni e la SEO del tuo sito, dovresti dedicare tempo e risorse anche all’ottimizzazione per Googlebot. Alcuni webmaster non si rendono conto della quantità di traffico che stanno trascurando, semplicemente perché non hanno prestato la necessaria attenzione all’ottimizzazione per Googlebot. Se hai bisogno di un esperto per applicare questi suggerimenti, contattaci.

Buon lavoro!