Immagina che il tuo sito sia un grattacielo con mille stanze. Ogni giorno, Google manda un robot che può visitarne solo alcune. Se scegli male le porte da aprire, puoi avere le pagine migliori del mondo, ma nessuno le vedrà mai. È qui che entra in gioco il crawl budget, una delle variabili SEO più strategiche e meno comprese.

Ogni sito ha un budget, invisibile ma concreto, che stabilisce quante pagine Googlebot può e vuole scansionare in un dato periodo. Questo budget non è infinito. E non è nemmeno equamente distribuito. Google decide dove spendere il suo tempo in base a segnali ben precisi: struttura del sito, velocità del server, frequenza di aggiornamento, errori 404, contenuti duplicati. Se sprechi risorse, perdi occasioni di posizionamento.

La maggior parte dei siti oggi non ha un problema di contenuti, ma un problema di gestione tecnica. Anche siti con centinaia di articoli ben scritti non riescono a emergere perché Googlebot visita pagine irrilevanti o inutili, lasciando fuori proprio quelle che potrebbero performare meglio. Questo succede quando non c’è controllo sul crawling budget.

L’ottimizzazione del crawl budget è quindi il primo passo per una SEO tecnica davvero efficace. Significa pulire, indirizzare, strutturare. Significa aiutare Google a vedere ciò che davvero conta. E soprattutto, significa non sprecare energia SEO in pagine che non porteranno mai traffico.

In questa guida scoprirai come funziona davvero il crawl budget, quali sono i segnali che ne influenzano la distribuzione, come evitare gli sprechi più comuni e quali strumenti usare per monitorarlo in modo preciso. Nessuna teoria astratta, solo esempi concreti, strategie applicabili e un obiettivo chiaro: fare in modo che ogni pagina utile venga scansionata, indicizzata e posizionata. Perché se Google non vede, Google non mostra. E se non mostri, non esisti.

Cos’è il Crawl Budget e Perché È Fondamentale per la SEO

Dietro ogni indicizzazione, ogni snippet e ogni click su Google, c’è un’attività invisibile e costante: la scansione. Ma Google non scansiona tutto. Non può, e non vuole. Ogni sito riceve un’attenzione limitata, una finestra di tempo durante la quale Googlebot decide quante e quali pagine visitare. Questo tempo si chiama crawl budget.

Comprendere il crawl budget è il primo passo per chiunque voglia davvero dominare la SEO tecnica. Si tratta di una risorsa limitata e fluida, che Google assegna a ciascun sito in base a due fattori principali: il crawl rate limit (cioè la capacità tecnica del server di reggere la scansione) e il crawl demand (l’interesse di Google verso i contenuti del sito). Se il tuo sito ha un’architettura confusa, pagine lente, molti errori o contenuti duplicati, Googlebot riduce drasticamente le sue visite, indipendentemente dalla qualità dei contenuti.

Ed è qui che inizia il vero problema. Molti siti, anche con buoni contenuti, non vengono mai visti dal motore di ricerca, semplicemente perché finiscono fuori dal radar della scansione. E ciò che non viene scansionato, non può essere indicizzato. Il crawl budget diventa quindi un vero e proprio collo di bottiglia: se sprecato, anche la strategia SEO più brillante non porta risultati.

Ma non è solo un tema tecnico. Ottimizzare il crawl budget significa ottimizzare la comunicazione tra il tuo sito e Google. Significa creare le condizioni ideali affinché Googlebot trovi le pagine giuste, quelle davvero rilevanti per il tuo business, e lo faccia nel minor tempo possibile. Il crawl budget non è solo una metrica: è un moltiplicatore invisibile di visibilità, indicizzazione e traffico. Ignorarlo equivale a giocare una partita in cui le tue carte migliori non entrano mai in gioco.

Crawl budget: la risorsa invisibile che decide chi sale su Google

Il crawl budget è la quantità massima di URL che Googlebot è disposto a scansionare su un determinato sito in un certo lasso di tempo. Non è una cifra fissa, né uguale per tutti. È una variabile dinamica che Google gestisce in base a segnali che riceve durante il crawling, e che aggiorna costantemente. Il problema è che nessun webmaster riceve un messaggio da Google con scritto: “Hai 12.000 URL al giorno”. Il crawl budget si intuisce, si misura indirettamente e si ottimizza con intelligenza.

Tutti i siti ricevono un’attenzione proporzionata alla loro rilevanza percepita. Se Google ritiene che il tuo sito abbia valore, sarà più incline a visitarne un numero maggiore di pagine. Ma se incontra errori, contenuti duplicati o segnali negativi (come redirect infiniti, catene di pagine inutili o tempi di risposta lenti), ridurrà il tempo e le risorse destinate al tuo dominio.

Ecco perché il crawl budget può diventare una barriera invisibile alla scalabilità. Anche se pubblichi decine di nuovi articoli al mese, se questi non vengono scansionati, è come se non esistessero. Google non li vede, e quindi non può nemmeno indicizzarli. E senza indicizzazione, non ci sarà mai posizionamento.

Pensare al crawl budget come a una risorsa da gestire è una mossa strategica. Significa capire che non tutte le pagine hanno lo stesso peso, e che ogni URL non strategico scansionato è un’opportunità persa per un altro URL più rilevante. Quando il crawling diventa selettivo, ogni spreco si trasforma in un danno. Per questo è fondamentale ottimizzare il crawl budget e guidare Google verso ciò che davvero conta.

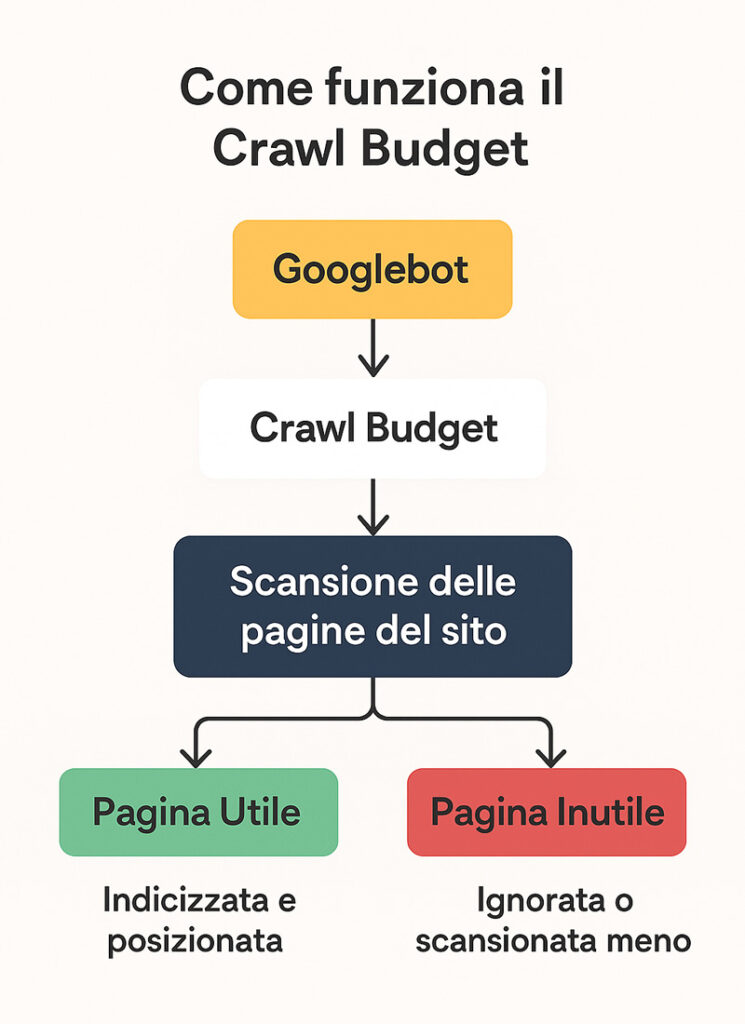

Il diagramma seguente mostra in modo chiaro come funziona il crawl budget e in che modo Googlebot decide quali pagine scansionare.

Cosa influenza davvero il crawling budget e come funziona dietro le quinte

Dietro il comportamento di Googlebot ci sono logiche precise, che si possono capire e sfruttare. Il crawling budget dipende principalmente da due variabili: il crawl rate limit, ovvero il numero massimo di richieste che Googlebot può inviare senza sovraccaricare il server, e il crawl demand, cioè l’interesse di Google nei confronti dei tuoi contenuti.

Il primo parametro è tecnico: Google monitora la risposta del server. Se il sito rallenta, riduce la frequenza di scansione per non danneggiarlo. Se invece il server è veloce e reattivo, aumenta progressivamente il numero di richieste. Ecco perché le performance influiscono direttamente sul crawl budget.

Il secondo parametro è editoriale: quanto valore Google attribuisce ai tuoi contenuti? Se pubblichi spesso, ricevi link, generi interazioni e aggiornamenti, il tuo sito viene considerato “vivo” e rilevante. In quel caso, Google aumenta la sua attenzione, visitando più spesso le nuove pagine. Se invece il sito è statico, disorganizzato o carico di contenuti duplicati, Googlebot ne limita l’accesso.

A questo si aggiunge un elemento spesso trascurato: la struttura del sito. Pagine difficili da raggiungere, link rotti, URL troppo profondi o non interlinkati vengono spesso ignorati. Ottimizzare la crawlability significa proprio facilitare questo processo: rendere ogni pagina importante accessibile, veloce e ben collegata.

La buona notizia? Il crawling SEO è una variabile che si può indirizzare. Attraverso sitemap XML pulite, robots.txt ben configurati, architetture leggere e contenuti sempre aggiornati, è possibile guidare Googlebot. Perché la verità è semplice: Google è un utente come gli altri. Se lo accompagni dove vuoi tu, può diventare il tuo miglior alleato.

Come Googlebot Usa il Crawl Budget sul Tuo Sito (e Cosa Può Andare Storto)

Il crawl budget non è una risorsa teorica: è ciò che decide quanto del tuo sito entra realmente in gioco nei risultati di ricerca. Anche se l’indicizzazione sembra un processo automatico, dietro le quinte Googlebot valuta, sceglie, ignora. Ogni URL deve guadagnarsi l’attenzione. E ogni volta che il tuo sito viene scansionato, c’è una lista invisibile che stabilisce cosa viene visto e cosa no.

Google non scansiona tutto. E non lo fa nemmeno nei siti grandi o autorevoli. Anzi: più contenuti hai, più è facile sprecare crawl budget se non organizzi il sito in modo intelligente. Per capire come evitare questo rischio, serve entrare nella logica di funzionamento di Googlebot: una macchina razionale, ottimizzata per risparmiare tempo, risorse e banda. Non esplora a caso. Segue regole, segnali, priorità.

Due sono i meccanismi chiave: il crawl rate (quanto può scansionare tecnicamente) e il crawl demand (quanto gli interessa farlo). Il primo dipende dalla salute tecnica del sito, il secondo dalla sua rilevanza. Se il tuo server è lento, se ci sono troppi errori, o se il sito appare “morto”, Googlebot se ne va. E non torna tanto facilmente.

Ciò che complica il tutto è che molti problemi passano inosservati: pagine duplicate, fac-simili generati da filtri, URL infiniti con parametri dinamici, pagine con poco testo o senza valore semantico. Tutto questo confonde Googlebot e lo distrae dalle pagine che contano davvero. E quando accade, la tua SEO si arena, anche se hai ottimi contenuti.

Capire come Google usa il tuo crawl budget è il primo passo per ottimizzarlo. E soprattutto, per smettere di buttare via traffico, indicizzazione e occasioni di posizionamento. Perché se Google non vede, non mostra. E ciò che non è mostrato, non esiste.

Crawl rate, crawl demand e segnali che riducono la scansione

Googlebot non esplora ogni sito con la stessa intensità. Il suo comportamento è regolato da due variabili precise: crawl rate limit e crawl demand. La prima indica la quantità massima di richieste che il crawler può inviare al tuo server senza sovraccaricarlo. La seconda misura quanto è interessato a scansionare i tuoi contenuti.

Il crawl rate è modulato in tempo reale: se il server è veloce e stabile, Google aumenta la frequenza di visita. Se invece rallenta o genera errori 5xx, la scansione viene automaticamente ridotta. Il risultato? Meno pagine esplorate, quindi meno possibilità di indicizzazione.

Il crawl demand, invece, si costruisce nel tempo. Si basa su segnali come freschezza dei contenuti, link in ingresso, traffico organico, aggiornamenti frequenti. Un sito “vivo” viene considerato più interessante e riceve una quota maggiore di crawling. Un sito fermo o disorganizzato, anche se tecnicamente corretto, viene declassato nelle priorità di scansione.

Questi due parametri lavorano insieme per determinare il tuo crawling budget reale. Ma c’è un terzo fattore da non sottovalutare: la struttura del sito. Se le pagine importanti sono troppo profonde, non collegate bene, o nascoste dietro parametri dinamici, Googlebot fatica a trovarle. E spesso rinuncia.

Ottimizzare la SEO tecnica oggi significa gestire proattivamente questi tre livelli. La velocità non basta. Serve rendere chiara la priorità delle pagine, mantenere il sito pulito, evitare dispersioni e sprechi. Ogni risorsa che Googlebot dedica a una pagina non utile è una risorsa sottratta a una pagina strategica.

La tabella seguente confronta in modo chiaro il crawl rate e il crawl demand, i due fattori che determinano come Google gestisce il crawl budget di un sito.

| Crawl Rate | Crawl Demand |

|---|---|

| Rappresenta la frequenza con cui Googlebot può scansionare il sito | Indica quanto interesse ha Google nel visitare e aggiornare le pagine |

| Dipende dalla capacità tecnica del server (velocità, errori, uptime) | Dipende dal valore SEO percepito: contenuti freschi, autorevoli, linkabili |

| Google lo regola in tempo reale: lo riduce se il sito rallenta o genera errori | Google lo calibra nel tempo: cresce se il sito è attivo e aggiornato |

| È migliorabile con ottimizzazione tecnica e hosting performante | È migliorabile con contenuti aggiornati, SEO on-page e segnali editoriali |

| Influisce su quante pagine vengono scansionate in un determinato periodo | Influisce su quali pagine e quanto spesso Googlebot decide di scansionare |

Ciò che complica il tutto è che molti problemi passano inosservati: pagine duplicate, fac-simili generati da filtri, URL infiniti con parametri dinamici, pagine con poco testo o senza valore semantico. Tutto questo confonde Googlebot e lo distrae dalle pagine che contano davvero. E quando accade, la tua SEO si arena, anche se hai ottimi contenuti.

Capire come Google usa il tuo crawl budget è il primo passo per ottimizzarlo. E soprattutto, per smettere di buttare via traffico, indicizzazione e occasioni di posizionamento. Perché se Google non vede, non mostra. E ciò che non è mostrato, non esiste.

Sintomi di spreco crawl budget e come individuarli

Molti siti web, anche apparentemente ben strutturati, soffrono di problemi invisibili che consumano il crawl budget in modo silenzioso ma costante. Uno dei segnali più comuni è la presenza di pagine irrilevanti che ricevono molte più visite di quelle importanti. Ad esempio: tag di blog non gestiti, filtri di e-commerce che generano centinaia di URL simili, archivi datati o contenuti sottili che Google continua a esplorare… a vuoto.

Un altro sintomo critico è l’eccessiva presenza di redirect: catene 301 mal configurate, loop infiniti, o peggio, pagine che portano a 404. Ogni tentativo di crawling su un errore è tempo sprecato. E Google se ne accorge. Quando i segnali negativi si accumulano, la risposta è sempre la stessa: meno crawlability, meno priorità, meno posizionamento.

Ci sono strumenti per diagnosticare tutto questo: i log server (che mostrano cosa visita Googlebot), Google Search Console (che segnala quali URL vengono scansionati e con quale frequenza), e crawler SEO come Screaming Frog o Sitebulb. Ma lo strumento più importante è la consapevolezza strategica: sapere cosa non andrebbe mai scansionato, e come bloccarlo in modo mirato.

Un buon punto di partenza? Rivedere tutto ciò che è generato dinamicamente (parametri URL, filtri, query), eliminare contenuti duplicati, evitare pagine con poco testo o senza keyword reali, ottimizzare la sitemap, pulire il file robots.txt. Sono azioni semplici che possono restituire respiro al tuo crawl budget SEO, e aiutare Google a vedere le pagine che fanno davvero la differenza.

In fondo, l’ottimizzazione SEO non è solo una corsa alla pubblicazione. È una corsa a far vedere le cose giuste, alle persone giuste, nel momento giusto. E questo comincia sempre con una scansione efficiente.

I Principali Sprechi di Crawl Budget che Bloccano la Scalabilità SEO

Quando un sito fatica a posizionarsi, la causa non è sempre nei contenuti o nei backlink. Molto più spesso, è nascosta in profondità: sotto cartelle inutili, URL infiniti, contenuti fotocopia, errori tecnici che consumano risorse senza produrre alcun valore. Questo è ciò che accade quando il crawl budget viene sprecato.

Ogni secondo che Googlebot dedica a una pagina irrilevante è un secondo in meno che potrebbe dedicare a una pagina strategica. Se queste ultime restano fuori dal radar della scansione, non verranno mai indicizzate. E se non sono indicizzate, per Google semplicemente non esistono.

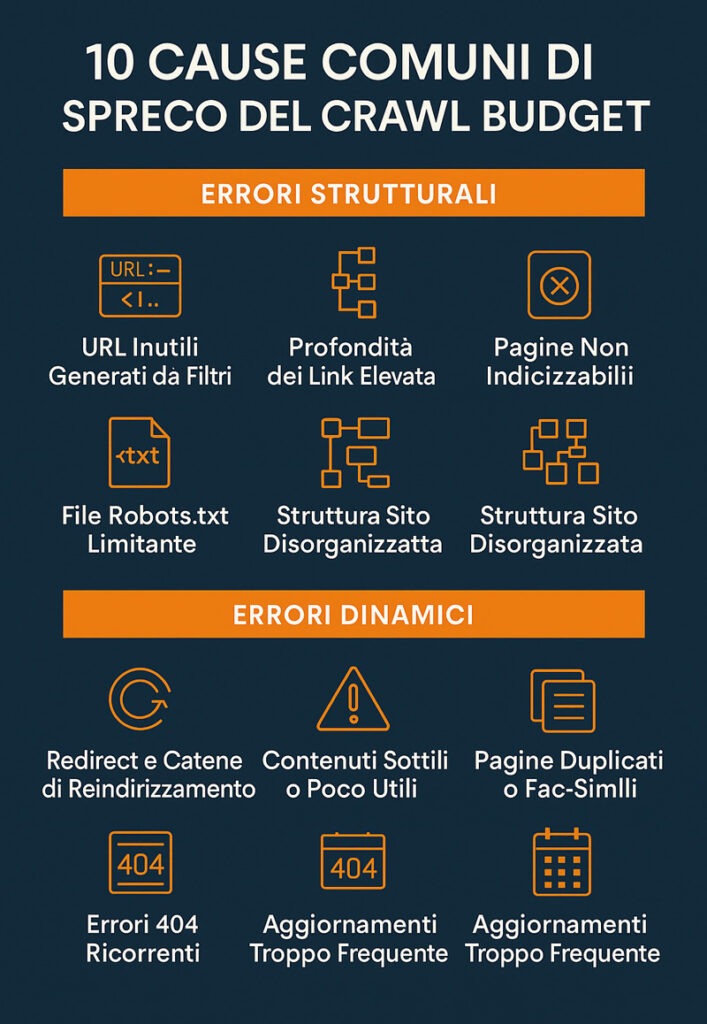

Gli sprechi più comuni nascono da una cattiva gestione della struttura del sito. Tag, categorie, filtri, parametri URL, archivi infiniti: elementi che, se non controllati, generano centinaia di pagine che sembrano diverse ma non lo sono. Questo moltiplicatore silenzioso crea rumore, disorienta Googlebot e lo allontana dalle pagine ad alto valore SEO.

Il problema si aggrava quando si usano CMS senza logica SEO integrata. WordPress, ad esempio, crea automaticamente tag, autori, date e archivi: tutte pagine accessibili, scansionabili e spesso inutili. Senza una strategia di ottimizzazione crawl budget, si finisce con l’avere un sito dove il 70% delle risorse disponibili viene sprecato.

E non finisce qui. Anche gli errori 404, i redirect loop, le pagine con contenuti sottili (thin content) o duplicati, e la mancata gestione di fac-simili (pagine quasi identiche tra loro) incidono pesantemente sulla crawlability. Google non ha tempo da perdere: se trova ostacoli, passa oltre. Non punisce, ma ignora. E in SEO, l’indifferenza è peggio della penalizzazione.

Il primo passo per scalare è smettere di sprecare. E per farlo, bisogna sapere dove si disperde energia e crawl budget. Perché ogni pagina inutile che Google scansiona è un’occasione persa per mostrare quella che davvero conta.

Pagine inutili, duplicati, redirect infiniti e fac-simili: i nemici invisibili

I nemici del crawl budget sono spesso silenziosi, ma letali. Non lanciano errori evidenti, non bloccano il sito, non rallentano drasticamente le performance. Ma si accumulano e intasano. Il primo gruppo da tenere sotto controllo è quello delle pagine inutili: tag non gestiti, archivi di date o autori mai visitati, pagine “grazie” post-form, risultati di ricerca interni, URL con parametri superflui. Tutti elementi che Google scansiona… senza mai posizionare.

Poi ci sono i contenuti duplicati, spesso generati involontariamente: lo stesso prodotto presente in due categorie diverse, lo stesso articolo accessibile da URL con e senza trailing slash, versioni mobile e desktop duplicate, versioni con “www” e senza. Anche le varianti di filtro in un eCommerce possono generare centinaia di fac-simili, tutti simili ma non abbastanza diversi da meritare una scansione indipendente.

Altro incubo: i redirect infiniti. Una pagina che rimanda a un’altra, che a sua volta ne richiama una terza, e così via. Oppure redirect mal configurati che portano a un 404 o a una pagina vuota. Google segue i redirect, ma non all’infinito. Dopo 5–6 passaggi, abbandona. E ogni tentativo fallito consuma crawl budget senza restituire nulla.

Infine, i fac-simili: pagine tecnicamente diverse, ma con contenuti troppo simili per essere utili. Google li considera duplicazioni leggere e, di solito, ne indicizza solo una. Ma prima, li scansiona tutti. Ed è lì che avviene lo spreco.

L’obiettivo è chiaro: limitare l’accesso a tutto ciò che non ha valore strategico. Questo non significa nascondere, ma guidare Google. E per farlo serve una mappa pulita, un’architettura efficiente e un controllo chirurgico su tutto ciò che il crawler può incontrare.

Crawl budget SEO: perché troppe pagine inutili penalizzano anche quelle buone

Il problema di avere troppe pagine inutili non è solo legato allo spreco. È un problema sistemico. Ogni volta che Googlebot entra nel tuo sito e si imbatte in URL ridondanti, perde fiducia. La frequenza di visita diminuisce, il tempo di permanenza si accorcia, l’interesse generale cala. E a pagarne il prezzo sono anche le pagine che meriterebbero attenzione.

In altre parole, il crawl budget SEO non è distribuito in modo meritocratico. Google lo assegna in blocco. E se il blocco è pieno di contenuti spazzatura, anche i contenuti di qualità finiscono per essere ignorati. Un sito con 100 pagine valide e 1.000 inutili sarà sempre penalizzato rispetto a uno con solo le 100 giuste. Perché Google non sa, in partenza, quali sono buone e quali no. Le deve visitare. E questo costa tempo.

Il crawling SEO efficace non si basa sulla quantità di contenuti, ma sulla qualità dell’ecosistema. Ogni pagina deve avere una funzione, un obiettivo, un valore. Non esistono pagine “neutre”: o aiutano, o ostacolano. E nella gestione del crawl budget, la zavorra pesa moltissimo.

Un altro effetto collaterale è il rallentamento dell’indicizzazione. Se Google impiega giorni a trovare e scansionare la pagina giusta perché prima deve attraversare un labirinto di contenuti inutili, il tuo tempo di reazione SEO si allunga. E in un contesto competitivo, dove la velocità conta, questo può fare la differenza.

Pulire l’indicizzabile, razionalizzare l’accesso, limitare i percorsi inutili: sono tutte pratiche che hanno un impatto diretto sulla performance organica. Perché sì, ottimizzare il crawl budget migliora anche il posizionamento delle pagine giuste. Non si tratta di bloccare. Si tratta di prioritizzare.

Come Ottimizzare il Crawl Budget: Tutte le Azioni Che Contano Davvero

Una delle convinzioni più diffuse — e più dannose — è che il crawl budget sia un parametro immutabile, gestito unicamente da Google, quindi fuori dal nostro controllo. In realtà, tutto ciò che accade dentro il sito incide direttamente su come e quanto viene scansionato. E la buona notizia è che ogni webmaster, SEO o creator digitale può migliorare questo parametro… a patto di sapere dove mettere le mani.

Ottimizzare il crawl budget non significa fare un audit una tantum, ma impostare un sistema intelligente di gestione delle risorse: ogni pagina, ogni directory, ogni URL dev’essere valutato per il suo impatto reale sulla SEO. Googlebot non ha tempo per tutto. E tocca a noi decidere dove indirizzarlo. Questo significa dare priorità alle pagine strategiche, bloccare quelle inutili, e creare percorsi chiari, veloci, diretti.

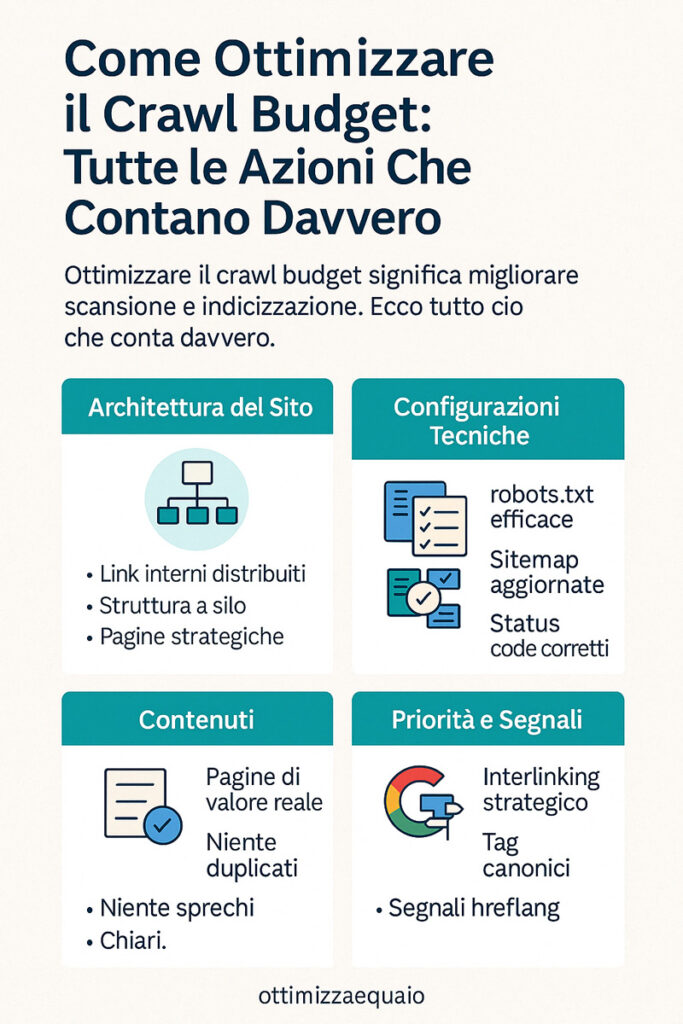

Le azioni fondamentali ruotano attorno a tre pilastri: architettura del sito, configurazioni tecniche e contenuti. L’architettura deve essere piatta, con link interni ben distribuiti e pagine importanti a pochi clic dalla home. Le configurazioni tecniche includono file robots.txt, sitemap XML aggiornate, redirect puliti e status code corretti. Infine, i contenuti: niente duplicati, niente pagine sottili, niente sprechi.

Un altro aspetto cruciale è la coerenza delle risorse: ogni pagina deve esistere per un motivo. Se non ha valore SEO, se non serve all’utente, se non genera traffico o conversioni, allora consuma spazio senza produrre nulla. E in un ecosistema SEO efficiente, tutto ciò che non aiuta, ostacola.

La chiave sta nel controllo. Google ama i siti prevedibili, ordinati, chiari. Ogni segnale che riduce l’ambiguità — link interni ben costruiti, canonical precisi, contenuti aggiornati — migliora la capacità del crawler di muoversi in modo utile. E quando Google trova quello che cerca senza perdere tempo, il tuo sito viene premiato con una scansione più profonda e frequente.

La seguente infografica mostra in modo sintetico ed efficace tutte le azioni strategiche per ottimizzare il crawl budget e migliorare la scansione del sito da parte di Google.

Gestione del file robots.txt, sitemap XML e status code intelligenti

Il file robots.txt è il primo punto di contatto tra il tuo sito e Googlebot. È qui che dichiari cosa può e non può essere scansionato. Una gestione errata può bloccare pagine importanti o, peggio, lasciare via libera a directory inutili. Ecco perché il primo passo per ottimizzare il crawl budget è rivedere questo file con attenzione maniacale.

Devi bloccare tutti gli URL che non hanno valore SEO: risultati di ricerca interni, filtri dinamici, pagine duplicate, cartelle tecniche. Non è censura: è gestione delle priorità. Google apprezza quando lo guidi. E non si offende se dici “questo no, passa oltre”.

Subito dopo viene la sitemap XML. Deve essere pulita, aggiornata, priva di errori o URL che restituiscono status code problematici. Non basta generarla una volta: va monitorata. Se contiene link a pagine 404, redirect o non canoniche, comunica a Google un’immagine distorta del sito. La sitemap è il tuo curriculum SEO: ogni voce deve valere la pena di essere letta.

Parlando di status code, il principio è semplice: ogni pagina deve rispondere con il codice corretto. Un 200 quando tutto va bene. Un 301 solo se è davvero un redirect permanente. Mai abusare di 302, mai lasciare 404 attivi per mesi. Ogni errore è un ostacolo per Googlebot. E ogni ostacolo consuma crawling.

La somma di queste tre configurazioni — robots.txt, sitemap e status code — definisce la logica di accesso al tuo sito. Se funziona bene, Googlebot si muove come un treno su binari dritti. Se è confusa, rallenta, si ferma, cambia direzione. E il tuo crawl budget evapora.

Come guidare Google con priorità e segnali chiari

Una delle domande più importanti in SEO tecnica non è “quanto contenuto stai producendo?”, ma “quanto del tuo contenuto è effettivamente scansionato e indicizzato?”. La risposta dipende da come comunichi le priorità a Google. E no, non è sufficiente scrivere contenuti eccellenti: serve anche costruire strade visibili e segnali forti che dicano “questa pagina conta”.

Il primo strumento è l’interlinking interno. Le pagine importanti devono essere collegate da più punti del sito. Se una pagina riceve link solo dalla sitemap, ma nessun collegamento reale nei contenuti, Googlebot la considera meno centrale. Al contrario, se una risorsa è citata in più articoli, in home, nelle categorie, sale di livello.

Poi ci sono i tag canonici: indicano quale versione di una pagina è quella da indicizzare. Usarli correttamente evita duplicazioni e dispersione di crawl budget. Allo stesso modo, le hreflang aiutano a gestire le versioni internazionali, evitando che Googlebot sprechi tempo a confrontare contenuti simili in lingue diverse senza capirne la destinazione.

Non va dimenticato l’aggiornamento dei contenuti. Le pagine aggiornate di frequente attirano più attenzione da parte di Google. Se una pagina cambia spesso, Googlebot la visita più spesso. Se è sempre identica, viene considerata “stabile” e la scansione si dirada.

Infine, la struttura a silos. Organizzare i contenuti in aree tematiche collegate tra loro migliora l’efficienza della scansione. Googlebot entra in un silo, ne segue i link, capisce l’argomento e indicizza in modo più coerente. È una logica semplice, ma potentissima per guidare il crawling SEO in modo mirato.

Il messaggio è chiaro: puoi costruire contenuti straordinari, ma se non li metti nel radar di Google, non arriveranno mai a chi li cerca. E ottimizzare il crawl budget serve esattamente a questo: mettere sotto gli occhi giusti, nel momento giusto, il contenuto giusto.

Crawlability e Architettura del Sito: Il Fattore Chiave per la Scansione Intelligente

Molti pensano che la SEO sia fatta solo di keyword e contenuti. Ma la verità è che, se Google non riesce a raggiungere le pagine giuste, tutto il resto è irrilevante. Ecco perché crawlability e struttura del sito non sono solo elementi tecnici, ma fondamentali per la visibilità organica. La crawlability è la capacità di un sito di farsi scansionare in modo efficiente da Googlebot. E in larga parte dipende da come è costruita la sua architettura interna.

Un sito ben strutturato aiuta Google a capire subito cosa è importante e cosa no. La gerarchia dei contenuti, la profondità degli URL, la distribuzione dei link interni: tutto comunica valore. Se invece la struttura è disorganica, con troppe pagine isolate, collegamenti deboli e directory caotiche, il crawling diventa lento, dispendioso e inefficace. Il risultato? Google vede solo una parte del sito. E spesso, non la migliore.

La seguente infografica mostra i principali elementi architetturali che influenzano la crawlability di un sito e il modo in cui Googlebot ne esplora i contenuti.

Una buona architettura è piatta, coerente, prevedibile. Ogni clic deve avvicinare l’utente e il crawler alle pagine che contano. Nessuna risorsa importante dovrebbe essere a più di tre livelli di profondità dalla home. Le pagine fondamentali devono ricevere link interni da più percorsi. E ogni area del sito dovrebbe avere un ruolo preciso e riconoscibile.

Questo vale ancora di più per siti dinamici o eCommerce, dove le combinazioni URL possono diventare infinite. In questi casi, la progettazione dell’alberatura e la gestione dei parametri diventano vitali. Non si tratta di semplificare per forza, ma di guidare la scansione come un flusso logico, ottimizzando ogni passaggio.

Quando la struttura funziona, il crawling SEO diventa naturale, fluido, scalabile. E Google non solo scansiona di più, ma lo fa con maggiore precisione. Il sito appare più ordinato, affidabile, solido. E questo si traduce in una maggiore frequenza di visita, migliore indicizzazione e performance SEO più stabili.

Struttura interna, collegamenti e profondità delle pagine

Il modo in cui organizzi le tue pagine incide direttamente sulla crawlability. Una struttura interna ben progettata permette a Googlebot di trovare rapidamente i contenuti importanti, seguire percorsi chiari e dedicare il crawl budget a ciò che davvero conta. Ma quando il sito è troppo profondo, caotico o dispersivo, la scansione si blocca nei punti sbagliati.

Una delle regole d’oro è mantenere la profondità degli URL entro 3 clic dalla home. Le pagine più importanti devono essere facili da raggiungere sia per l’utente che per il crawler. Non servono URL complicati o gerarchie labirintiche. Anzi, più la struttura è piatta, più è efficace. E quando una pagina è difficile da trovare per Google, anche l’indicizzazione rallenta.

I collegamenti interni giocano un ruolo fondamentale. Linkare una pagina da diverse altre sezioni del sito ne aumenta il valore percepito. È un segnale forte per Googlebot: “questa pagina è rilevante”. Al contrario, una pagina senza link in ingresso rischia di non essere mai scoperta, o di essere considerata marginale.

Attenzione anche ai link rotti, ai loop e ai percorsi non coerenti. Ogni volta che Googlebot trova un vicolo cieco, riduce la scansione. Ogni errore è un invito a fermarsi. Per questo, monitorare la struttura interna e correggere regolarmente i problemi è parte integrante della gestione del crawling budget.

Infine, considera la gerarchia semantica. Un sito ben strutturato non solo si scansiona meglio, ma viene anche interpretato meglio. Google capisce più facilmente di cosa parlano le varie sezioni, a chi servono, e quali sono i contenuti core. E quando capisce, premia.

Ottimizzare la crawlability per aumentare l’efficienza del crawling SEO

Ottimizzare la crawlability significa rendere il sito facilmente percorribile da Googlebot. Non è solo una questione di performance tecniche, ma di logica architetturale. Se il sito è chiaro, ordinato, coerente, Google scansiona di più, più velocemente, e meglio. E questo migliora tutto il processo SEO.

Un primo passo è identificare le zone morte: sezioni del sito che non ricevono link, o che sono isolate da percorsi principali. Anche se sono nella sitemap, se non hanno collegamenti reali, Google potrebbe trascurarle. Per questo è fondamentale creare ponti: ogni contenuto importante deve essere raggiunto da più direzioni.

La gestione dei menu, delle categorie e dei filtri è altrettanto decisiva. In un eCommerce, ad esempio, è facile generare migliaia di combinazioni URL con filtri applicati. Senza controllo, il crawler si perde in varianti inutili. E consuma tutto il crawl budget. La soluzione? Noindex per i filtri, gestione dei parametri tramite Search Console, disallow selettivi nel robots.txt.

Anche i breadcrumb, spesso trascurati, sono ottimi alleati. Aiutano Google a capire la gerarchia del contenuto e migliorano la navigazione interna. Ogni dettaglio conta. Anche un singolo link ben posizionato può fare la differenza tra una pagina ignorata e una pagina indicizzata.

La crawlability è l’anello di congiunzione tra architettura e visibilità. Se salta, la SEO perde efficacia. Ma quando funziona, potenzia tutto: il crawling diventa mirato, il sito appare più autorevole, e Google sa esattamente dove guardare. E quando Google guarda, mostra. E quando mostra, tu posizioni.

Strumenti per Monitorare e Migliorare il Crawl Budget: GSC, Log e Tool Pro

Ottimizzare il crawl budget non è solo una questione di interventi mirati: è anche e soprattutto un lavoro di monitoraggio continuo. Sapere dove, come e quanto Googlebot si muove all’interno del tuo sito ti permette di anticipare sprechi, correggere errori e spingere le pagine giuste al momento giusto. Ma per farlo serve una cassetta degli attrezzi adatta. E sapere esattamente dove guardare.

Ci sono tre livelli fondamentali di osservazione: Google Search Console, l’analisi dei log server e i crawler SEO professionali. Ognuno fornisce una lente diversa, ma complementare. La GSC ti dice cosa Google ha visto. I log ti dicono dove è realmente passato. I crawler simulano il comportamento di un bot per individuare colli di bottiglia, errori e sprechi.

Il vero vantaggio è la visione integrata. Nessuno strumento, preso da solo, ti dà un quadro completo. Ma insieme, permettono di costruire una mappa dinamica del comportamento di Googlebot, con tutte le deviazioni, le zone cieche e le opportunità inespresse. E più comprendi il movimento del crawler, più puoi indirizzarlo dove ti serve.

Non serve per forza essere sviluppatori per leggere questi segnali. Con una strategia chiara, e gli strumenti giusti, è possibile identificare in pochi minuti le aree critiche che consumano risorse senza produrre visibilità. Ed è qui che il lavoro tecnico incontra il vero impatto SEO: nella capacità di trasformare i dati in azione.

Monitorare il crawl budget non è una fase a sé, ma un processo continuo. Più il sito cresce, più serve controllo. E solo chi mantiene alta la visibilità sul comportamento di Googlebot riesce a tenere le redini della scalabilità SEO nel tempo.

Google Search Console: dove guardare e cosa leggere davvero

Google Search Console è il primo strumento gratuito — e indispensabile — per monitorare l’attività di Googlebot sul tuo sito. Ma per sfruttarlo davvero, serve sapere esattamente dove guardare e come leggere i segnali. La maggior parte degli utenti si limita a controllare lo stato di indicizzazione o le performance, ma ignora la sezione “Statistiche di scansione”. Ed è lì che si nasconde il vero potenziale per gestire il crawl budget.

In quella sezione trovi un grafico che mostra il numero di pagine scansionate quotidianamente, la velocità media di download e i kilobyte trasferiti. Se noti picchi di attività seguiti da cali drastici, o se la velocità di caricamento è troppo alta, è il momento di intervenire. Google potrebbe star incontrando ostacoli che lo portano a ridurre la scansione, con impatto diretto sulla tua visibilità.

Un’altra area chiave è il report “Copertura”. Qui puoi individuare URL esclusi, scansionati ma non indicizzati, o con errori. Ogni voce è un indizio: pagine che Google visita ma decide di ignorare sono un segnale chiaro di spreco di crawling. Capire perché succede è fondamentale per ottimizzare la qualità del sito agli occhi del crawler.

Anche il report Sitemap gioca un ruolo strategico. Ti permette di verificare quanti URL proposti sono stati effettivamente scansionati e indicizzati. Una discrepanza elevata è sintomo di problemi tecnici o di priorità sbagliate. Correggere questi sbilanciamenti è uno dei modi più rapidi per migliorare la gestione del crawl budget SEO.

Infine, controlla regolarmente i segnali di allarme: aumento degli errori 404, incremento di pagine escluse o redirect inutili. La GSC non è solo uno strumento di diagnosi: è una bussola che ti aiuta a guidare la scansione di Google dove serve davvero.

Analisi dei log server e tool SEO per controllare lo spreco

L’analisi dei log server è il metodo più potente — e sottoutilizzato — per capire come Googlebot interagisce realmente con il tuo sito. I log registrano ogni richiesta ricevuta dal server, compresi gli user-agent come Googlebot. A differenza di strumenti come la Search Console, che mostrano solo una parte del quadro, i log ti dicono con precisione chirurgica quali URL sono stati scansionati, quando e con quale frequenza.

Grazie ai log puoi individuare facilmente se Google sta perdendo tempo su pagine inutili, se ignora sezioni importanti, se visita troppe volte la stessa risorsa o se non raggiunge affatto intere directory. È qui che scopri i veri sprechi di crawl budget: pagine con zero valore SEO che ricevono decine di accessi del crawler ogni giorno, mentre le pagine chiave restano ignorate.

Per interpretare i log in modo efficace, puoi usare strumenti come Screaming Frog Log Analyzer, Log File Analyser di JetOctopus o combinare dati con Google Data Studio. Anche piattaforme più complesse come OnCrawl e Botify integrano log e crawling per offrire una visione unificata.

In parallelo, i classici crawler SEO (Screaming Frog, Sitebulb, Ahrefs Site Audit, SEMrush Audit) permettono di simulare il comportamento del bot, individuare problemi di accesso, loop, link rotti, redirect chain e problemi di profondità. Sono strumenti ideali per chi vuole un’analisi visiva e operativa, senza dover entrare nei dettagli del server.

Il punto non è solo misurare, ma agire. Ogni dato che rivela una dispersione di crawling è un’opportunità concreta per migliorare. Ottimizzare significa ridurre la confusione, rafforzare le priorità e liberare risorse per le pagine che meritano davvero visibilità. E gli strumenti giusti ti permettono di farlo con metodo, non a tentoni.

Errori da Evitare: Quando le Ottimizzazioni SEO Tecniche Rovinano il Crawl Budget

Nel mondo della SEO tecnica, non tutto ciò che sembra “ottimizzazione” lo è davvero. Anzi, alcuni degli errori peggiori che compromettono il crawl budget derivano proprio da interventi ben intenzionati ma mal eseguiti. E la cosa più pericolosa è che spesso passano inosservati. Il sito continua a funzionare, le pagine si caricano, nessun errore apparente. Ma nel frattempo, Googlebot spreca risorse su URL inutili o resta bloccato in loop che ne riducono l’efficienza.

Quando si parla di crawl budget SEO, l’equilibrio è tutto. Troppa automazione, configurazioni errate di redirect, sitemap sporche o robots.txt mal gestiti sono tra gli errori più gravi e frequenti. Ogni azione tecnica deve essere pensata non solo per l’utente, ma anche per il crawler. Se Googlebot si perde, si blocca o spreca tempo, le conseguenze sono dirette: meno pagine strategiche scansionate, indicizzazione rallentata, performance organiche compromesse.

Uno degli errori più comuni è affidarsi completamente a plugin SEO o CMS che generano in automatico decine di URL non necessari: tag, categorie, archivi autore, filtri, parametri UTM lasciati aperti. Anche se tecnicamente accessibili, queste pagine non portano valore SEO, ma Googlebot le esplora comunque, consumando crawl budget prezioso.

Un altro problema ricorrente è l’overdose di redirect: redirect 301 in cascata, redirect a pagine che a loro volta sono redirectate, o redirect verso pagine 404. Ogni passaggio inutile aggiunge latenza e complessità. Dopo un certo numero di salti, Google semplicemente abbandona la visita. E ogni tentativo fallito è una scansione buttata.

E poi ci sono le pagine “noindex” che però non vengono escluse dal crawling, sitemap che includono pagine bloccate, hreflang mal configurati che creano duplicazioni internazionali. Tutti dettagli che da fuori sembrano innocui, ma che all’interno della macchina SEO creano attrito e inefficienza.

Evitare questi errori non significa essere perfetti. Significa essere consapevoli. E sapere che ogni linea di codice, ogni scelta tecnica, ogni URL lasciato aperto ha un impatto sulla capacità di Google di vedere — e valorizzare — il tuo lavoro.

SEO automatica mal gestita, tag dinamici e filtri URL fuori controllo

L’automazione è una delle armi più potenti della SEO moderna. Ma come tutte le armi potenti, se usata male può fare più danni che benefici. I CMS moderni, WordPress in primis, generano dinamicamente centinaia di URL: tag, categorie, archivi, pagine autore, risultati di ricerca interni. E ogni singolo URL viene considerato da Google come una possibile risorsa da scansionare.

Il problema nasce quando nessuna di queste pagine ha valore SEO. Nessun contenuto originale, nessuna keyword utile, solo aggregazioni di articoli o prodotti già esistenti. In questi casi, Googlebot spreca tempo prezioso, scansionando pagine che non verranno mai indicizzate, mentre le pagine chiave restano fuori dal radar.

Lo stesso accade con i filtri URL, soprattutto negli eCommerce. Taglie, colori, prezzi, disponibilità: ogni filtro può generare combinazioni infinite. Se non gestiti tramite parametri noindex o robots.txt, questi URL vengono scansionati in massa. E il crawl budget evapora. Non basta avere contenuti buoni: se Google non arriva a vederli, non entreranno mai in competizione nei risultati di ricerca.

Un altro errore diffuso è lasciare attivi i risultati di ricerca interna del sito. Questi generano URL dinamici spesso infiniti, senza contenuti reali. Google li visita, li valuta vuoti e se ne va. Intanto, ha sprecato parte del tuo crawling budget.

Soluzione? Pulizia chirurgica. Bloccare via robots.txt le aree non strategiche, marcare con noindex le pagine non indicizzabili, rimuovere dalle sitemap le risorse inutili. Meno Google vede spazzatura, più riesce a concentrarsi sul valore.

Molti sprechi di crawl budget nascono da errori ricorrenti che possono essere corretti con semplici interventi strategici. Ecco alcuni esempi concreti:

| ❌ Errore Comune | ✅ Soluzione Efficace |

|---|---|

Pagine con noindex incluse nella sitemap | Rimuovi dalla sitemap tutte le pagine noindex |

| URL dinamici con parametri scansionati senza controllo | Filtra i parametri via robots.txt o GSC (Search Console) |

| Tag e categorie WordPress indicizzate senza contenuto | Applica noindex o disattiva la generazione automatica |

| Catene di redirect multiple o infinite | Limita i redirect a max 1 passaggio diretto |

| Sitemap contenente 404 o redirect | Monitora e aggiorna regolarmente le sitemap XML |

| Risultati di ricerca interna accessibili ai crawler | Blocca via robots.txt i risultati di ricerca on-site |

| Contenuti duplicati accessibili da più URL | Usa canonical tag e struttura URL coerente |

| Sitemap contenente pagine duplicate o inutili | Includi solo pagine strategiche e con valore SEO reale |

Redirect 301 verso URL noindex | Verifica che i redirect puntino a pagine attive e indicizzabili |

| Performance tecniche trascurate (server lento, tempo risposta alto) | Ottimizza server, CDN e caricamento risorse per aumentare il crawl rate |

Crawling SEO vs performance: come bilanciare tecnica e visibilità

Uno degli errori più insidiosi è pensare che la SEO tecnica sia una corsa a chi ottimizza di più. Ma il crawling SEO non è questione di quantità, è questione di equilibrio. Non tutte le pagine devono essere scansionate, e non tutte le ottimizzazioni sono utili. Alcune, se spinte troppo, diventano controproducenti.

Prendiamo ad esempio l’eccessiva compressione delle pagine per aumentare la velocità. Ottimo per l’utente, ma se porta a eliminare contenuti o elementi importanti per Googlebot (come breadcrumb, link interni, markup semantico), si rischia di ridurre la comprensione strutturale del sito, compromettendo la scansione.

Altro caso: il blocco eccessivo di risorse tramite robots.txt. Alcuni sviluppatori bloccano intere directory CSS o JS per “alleggerire il crawler”. Ma Googlebot ha bisogno di accedere anche a queste risorse per valutare correttamente il layout, la mobile-friendliness e i Core Web Vitals. Bloccarle può ridurre la qualità percepita del sito, influenzando negativamente il ranking.

Anche l’abuso di tag canonical può creare problemi: se tutte le pagine rimandano a una sola versione senza logica, Google potrebbe ignorare le varianti realmente rilevanti. Idem per i redirect: troppi passaggi confondono, rallentano e portano Google a saltare le pagine strategiche.

La chiave è una sola: coerenza. Ogni intervento tecnico deve avere un obiettivo chiaro e misurabile. Migliorare la scansione non significa bloccare tutto o velocizzare a tutti i costi. Significa guidare Google in modo efficiente, mostrandogli ciò che davvero conta e togliendo di mezzo ciò che lo confonde o lo rallenta.

Solo così si ottiene un crawling sano, stabile, sostenibile. Dove ogni visita di Googlebot è un’opportunità, non una perdita.

Conclusioni: Dominare il Crawl Budget È la Prima Mossa per Vincere la SEO Tecnica

Il crawl budget non è un parametro tecnico da specialisti. È il confine invisibile tra ciò che Google vede e ciò che ignora. Tra le pagine che competono nei risultati di ricerca e quelle che restano sepolte nel silenzio digitale. E in un web dove ogni secondo conta, dove la visibilità si conquista sul filo dei dettagli, gestire consapevolmente il crawl budget significa proteggere e valorizzare ogni singolo contenuto.

Non basta più scrivere articoli ottimizzati, migliorare i Core Web Vitals o curare i backlink. Se Googlebot non scansiona le tue pagine migliori, il posizionamento non arriva. E senza posizionamento, tutta la strategia si inceppa. È per questo che la SEO tecnica parte da qui: dalla capacità di creare un sito che non solo funzioni, ma comunichi in modo chiaro con il motore di ricerca.

Ogni azione, ogni impostazione, ogni collegamento interno è un messaggio che indirizza Google. E se quel messaggio è confuso, disordinato o dispersivo, Google risponde con disinteresse. Inizia a scansionare di meno, più lentamente, lasciando indietro proprio le risorse che avrebbero potuto fare la differenza.

Riconoscere i sintomi di spreco, intervenire su struttura e performance, guidare la scansione con priorità logiche e segnali forti: queste sono le vere mosse vincenti. Non c’è una ricetta segreta. C’è solo un principio semplice: più faciliti il lavoro di Googlebot, più il tuo sito viene premiato.

Il crawl budget non si può comprare. Ma si può costruire, pagina dopo pagina. Ogni errore evitato, ogni URL ottimizzato, ogni percorso pulito contribuisce ad aumentare il valore percepito del tuo sito. E quando Google si accorge che il tempo speso dentro le tue pagine è tempo ben investito, ti restituisce attenzione, indicizzazione, traffico.

La sfida non è farsi vedere. La sfida è farsi trovare al momento giusto, con la pagina giusta, dallo strumento giusto. E tutto parte da un dettaglio spesso trascurato: come, dove e quanto il tuo sito viene scansionato.

Perché nel mondo della SEO, non vince chi pubblica di più, ma chi viene visto meglio. E il crawl budget è la chiave di tutto.

Domande Frequenti sul Crawl Budget: Tutto Quello che Devi Sapere per Ottimizzarlo

Cos’è il crawl budget e da cosa dipende?

Il crawl budget è la quantità di risorse che Google dedica alla scansione di un sito. Non è uguale per tutti: varia in base alla capacità del server di reggere le richieste (crawl rate limit) e all’interesse di Google verso i contenuti del sito (crawl demand). Più il sito è performante, aggiornato e utile, più crawl budget riceve.

Come capire se sto sprecando il crawl budget?

Segnali di spreco includono: molte pagine scansionate ma non indicizzate, frequenti errori 404, URL inutili generati da filtri o parametri, e contenuti duplicati. Google Search Console e l’analisi dei log server sono gli strumenti principali per rilevare dispersioni e ottimizzare il crawling budget in modo mirato.

Quali strumenti usare per analizzare il crawl budget?

Gli strumenti chiave sono: Google Search Console (sezione statistiche di scansione), analisi dei log server (per vedere dove Googlebot passa davvero) e tool SEO professionali come Screaming Frog, Sitebulb, JetOctopus o Botify. Usarli in sinergia consente un controllo completo sul crawl budget SEO.

Come migliorare la crawlability del mio sito?

Per migliorare la crawlability devi ottimizzare la struttura interna del sito: collegamenti logici, profondità degli URL ridotta, link interni coerenti, eliminazione dei contenuti duplicati. Gestisci in modo strategico robots.txt, sitemap XML e parametri URL per guidare Google verso le pagine che contano davvero.

Il crawl budget incide anche sui siti piccoli?

Sì, anche i siti con poche pagine possono risentire di una cattiva gestione del crawl budget. Se ci sono errori, contenuti inutili o una struttura confusa, Googlebot potrebbe ignorare le pagine importanti. Ottimizzare la scansione è utile anche per blog e siti in crescita.

È vero che basta avere una sitemap per risolvere tutto?

No. La sitemap è solo uno degli strumenti che aiutano Google a scoprire le pagine, ma non garantisce la scansione né l’indicizzazione. Se il sito è lento, disorganizzato o pieno di URL non utili, Google potrebbe comunque ignorare molte risorse. La sitemap va curata, ma non sostituisce un’ottimizzazione completa del crawl budget.