A volte è necessario escludere contenuti o file specifici di WordPress dall’indicizzazione nei risultati di ricerca di Google. Indice, o “indicizzazione” prima dell’emergere di Google e di altri motori di ricerca era una parola per lo più associata ai libri. Di solito risiede sul retro della maggior parte dei libri, ed è per questo che il dizionario lo definisce in questo contesto come:

Indice: un elenco alfabetico, come quello stampato sul retro di un libro che mostra su quale pagina si trova un soggetto, un nome, ecc.

Passiamo rapidamente al 1995, durante il boom di Internet, abbiamo servizi come il motore di ricerca di Yahoo, e dal 1997, la ricerca di Google ha cambiato radicalmente il modo in cui cerchiamo e accediamo alle informazioni su Internet.

Secondo un sondaggio condotto a gennaio 2018, ci sono 1.805.260.010 (oltre 1,8 miliardi) di siti web su Internet e molti di questi siti web non ottengono visitatori.

Che cos’è l’indicizzazione di Google?

Esistono diversi motori di ricerca con un diverso formato di indicizzazione, ma i popolari motori di ricerca includono, Google, Bing e, per le persone attente alla privacy, duckduckgo.

L’indicizzazione di Google si riferisce generalmente al processo di aggiunta di nuove pagine web, inclusi contenuti digitali come documenti, video e immagini, e la loro memorizzazione nel suo database. In altre parole, affinché i contenuti del tuo sito vengano visualizzati nei risultati di ricerca di Google, devono prima essere archiviati nell’indice di Google.

Google è in grado di indicizzare tutte queste pagine e contenuti digitali utilizzando i suoi spider, crawler o robot che eseguono la scansione ripetuta di diversi siti web su Internet. Questi robot e crawler (Googlebot nel caso dei bot di Google) seguono le istruzioni dei proprietari del sito web su cosa scansionare e cosa deve essere ignorato durante la scansione.

Perché i siti web devono essere indicizzati?

Nell’era digitale, è quasi impossibile navigare attraverso miliardi di siti web alla ricerca di un particolare argomento e contenuto. Sarà molto più semplice se esiste uno strumento per mostrarci quali siti sono affidabili, quali contenuti sono utili e pertinenti per noi. Ecco perché Google esiste e classifica i siti web nei risultati di ricerca.

L’indicizzazione diventa una parte indispensabile del funzionamento dei motori di ricerca in generale e di Google in particolare. Aiuta a identificare parole ed espressioni che descrivono meglio una pagina e contribuisce in generale al posizionamento di pagine e siti web. Per apparire sulla prima pagina di Google, il tuo sito web, incluse pagine web e file digitali come video, immagini e documenti, deve prima essere indicizzato.

L’indicizzazione è un passaggio preliminare per i siti web per posizionarsi bene sui motori di ricerca in generale e Google in particolare. Utilizzando le parole chiave, i siti possono essere visti e scoperti meglio dopo essere stati indicizzati e classificati dai motori di ricerca. Questo apre quindi le porte a più visitatori, abbonati e potenziali clienti per il tuo sito web e la tua attività.

Il posto migliore per nascondere un cadavere è la seconda pagina di Google.

Pur avendo molte pagine indicizzate, i tuoi siti non si posizionano automaticamente più in alto, se anche il contenuto di tali pagine è di alta qualità, puoi ottenere una spinta in termini di SEO.

Perché e come bloccare il motore di ricerca nell’indicizzazione dei contenuti

Mentre l’indicizzazione è ottima per i proprietari di siti web e aziende, ci sono pagine che potresti non voler mostrare nei risultati di ricerca. potresti rischiare di esporre anche file e contenuti sensibili su Internet. Senza password o autenticazione, il contenuto privato è a rischio di esposizione e accesso non autorizzato se i bot accedono gratuitamente alle cartelle e ai file del tuo sito web.

All’inizio degli anni 2000, gli hacker hanno utilizzato la ricerca di Google per visualizzare informazioni sulle carte di credito da siti web con semplici query di ricerca. Questa falla di sicurezza è stata utilizzata da molti hacker per rubare informazioni sulle carte dai siti web di e-commerce.

Un altra recente falla di sicurezza è accaduto a box.com , un popolare sistema di archiviazione cloud. La falla nella sicurezza è stata scoperta da Markus Neis, responsabile dell’intelligence sulle minacce di Swisscom. Ha riferito che semplici exploit dei motori di ricerca tra cui Google e Bing potrebbero esporre file e informazioni confidenziali di molte aziende e singoli clienti.

Casi come questi si verificano online e possono causare una perdita di vendite e ricavi per i proprietari di attività. Per i siti web aziendali, di e-commerce e di membership, è di fondamentale importanza innanzitutto bloccare l’indicizzazione della ricerca di contenuti riservati e file privati e quindi probabilmente metterli dietro un sistema di autenticazione utente decente.

Diamo un’occhiata a come puoi controllare quali contenuti e file possono essere sottoposti a scansione e indicizzati da Google e altri motori di ricerca.

Utilizzo di Robots.txt per le immagini

Robots.txt è un file che si trova nella radice del tuo sito e fornisce a Google, Bing e altri robot dei motori di ricerca istruzioni su cosa scansionare e cosa no. Il file robots.txt viene solitamente utilizzato per controllare il traffico di scansione e i crawler web (mobile vs desktop) ma potrebbe anche essere utilizzato per impedire la visualizzazione delle immagini nei risultati di ricerca di Google.

Un file robots.txt dei normali siti web WordPress sarebbe simile al seguente:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Il file robots.txt standard inizia con un’istruzione per user-agent e un simbolo di asterisco. L’asterisco è un’istruzione per tutti i robot che arrivano sul sito web a seguire tutte le regole fornite di seguito.

Tieni i robot lontano da file digitali specifici usando il file Robots.txt

Robots.txt può anche essere utilizzato per interrompere la ricerca per indicizzazione dei file digitali come PDF, JPEG o MP4 nei motori di ricerca. Per bloccare la ricerca per indicizzazione di file PDF e JPEG, questo snippet dovrebbe essere aggiunto al file robots.txt:

File PDF

User-agent: * Disallow: /pdfs/ # Blocca la cartella /pdfs/. Disallow: *.pdf$ # Bloccca i file pdf a tutti i bot. Anche se non standard,funziona con i maggiori motori di ricerca.

Immagini

User-agent: Googlebot-Image Disallow: /immagini/gatto.jpg #Blocca l'immagine gatto.jpg specificatamente a Googlebot

Nel caso in cui si desideri bloccare l’indicizzazione e la visualizzazione di tutte le immagini GIF sulla ricerca immagini di Google, pur consentendo altri formati di immagine come JPEG e PNG, è necessario utilizzare le seguenti regole:

User-agent: Googlebot-Image Disallow: /*.gif$

Importante: gli snippet di cui sopra impedirà semplicemente che i tuoi contenuti vengano indicizzati da siti di terze parti come Google. Sono ancora accessibili se qualcuno sa dove cercare. Per rendere i file privati in modo che nessuno possa accedervi, è necessario utilizzare un altro metodo, come un plugin di restrizione del contenuto .

Googlebot-Image può essere utilizzato per bloccare la visualizzazione di immagini e una particolare estensione di immagini nella ricerca immagini di Google. Nel caso in cui si desideri escluderli da tutte le ricerche di Google, ad esempio la ricerca sul web e le immagini, è consigliabile utilizzare un user agent di Googlebot.

Altri user agent di Google per elementi diversi su un sito web includono Googlebot-Video per i video da applicare nella sezione video di Google sul web. Allo stesso modo, l’utilizzo dello user agent di Googlebot bloccherà la visualizzazione di tutti i video nei video di Google, nella ricerca web o nella ricerca web mobile.

Tieni presente che l’utilizzo di Robots.txt non è un metodo appropriato per bloccare file e contenuti sensibili o riservati a causa delle seguenti limitazioni:

- Robots.txt può solo istruire i crawler ben educati; altri motori di ricerca e robot non conformi potrebbero semplicemente ignorare le sue istruzioni.

- Robots.txt non impedisce al server di inviare tali pagine e file a utenti non autorizzati su richiesta.

- I motori di ricerca potrebbero comunque trovare e indicizzare la pagina e i contenuti che blocchi nel caso siano collegati da altri siti web e fonti.

- Robots.txt è accessibile a chiunque possa quindi leggere tutte le istruzioni fornite e accedere direttamente a tali contenuti e file

Per bloccare l’indicizzazione della ricerca e proteggere le tue informazioni private in modo più efficace, utilizza invece i seguenti metodi.

Utilizzo di meta tag no-index per le pagine

L’uso del metatag no-index è un metodo corretto ed efficace per bloccare l’indicizzazione della ricerca di contenuti sensibili sul tuo sito web. A differenza di robots.txt, il metatag no-index viene inserito nella sezione <head> di una pagina web con un tag HTML molto semplice:

<html> <head> <title>...</title> <meta name="robots" content="noindex"> </head>

Qualsiasi pagina con queste istruzioni nell’intestazione non verrà visualizzata nei risultati di ricerca di Google. Altre direttive come nofollow e notranslate possono anche essere usate per dire ai web crawler di non eseguire la scansione dei collegamenti e non servire rispettivamente la traduzione di quella pagina.

Puoi istruire più crawler utilizzando più metatag su una pagina come segue:

<html> <head> <title>...</title> <meta name="googlebot" content="nofollow"> <meta name="googlebot-news" content="nosnippet"> </head>

Esistono due modi per aggiungere questo codice al tuo sito web. La tua prima opzione è quella di creare un tema child di WordPress , quindi nelle tue funzioni.php puoi utilizzare l’hook dell’azione wp_head di WordPress per inserire un noindex o qualsiasi altro meta tag. Di seguito è riportato un esempio di come non indicizzare la tua pagina di login.

add_action( 'wp_head', function() {

if ( is_page( 'login' ) ) {

echo '<meta name="robots" content="noindex">';

}

} );

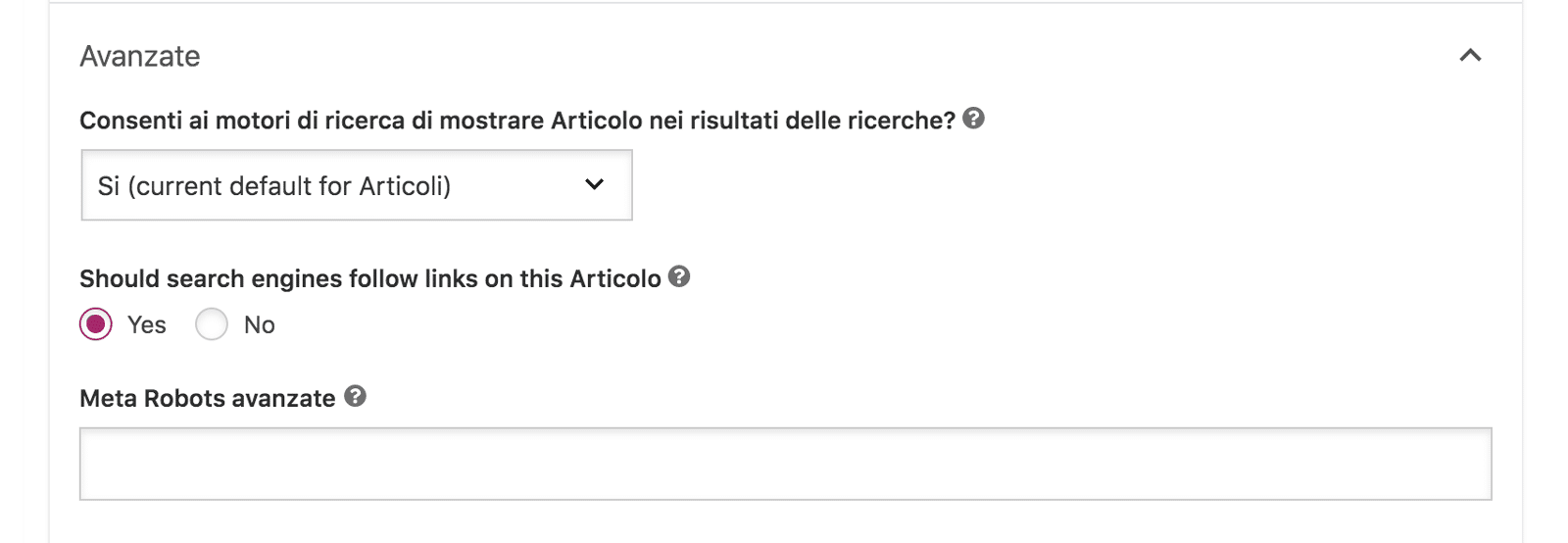

La tua seconda opzione è quella di utilizzare il tuo plugin SEO per controllare la visibilità di una pagina. Ad esempio, con Yoast SEO puoi andare alla sezione delle impostazioni avanzate di una pagina e semplicemente scegliere “No” per le opzioni che consentono al motore di ricerca di mostrare la pagina:

Utilizzo dell’intestazione HTTP X-Robots-Tag per altri file

Il tag X-Robots ti offre maggiore flessibilità per bloccare l’indicizzazione della ricerca di contenuti e file. In particolare, se confrontato con il meta tag no-index, può essere utilizzato come risposta dell’intestazione HTTP per qualsiasi URL specificato. Ad esempio, è possibile utilizzare l’X-Robots-Tag per file di immagini, video e documenti in cui non è possibile utilizzare i meta tag robot.

Puoi leggere la guida completa ai meta tag dei robot di Google , ma di seguito è indicato come puoi istruire i crawler a non seguire e indicizzare un’immagine JPEG usando l’X-Robots-Tag sulla sua risposta HTTP:

HTTP/1.1 200 OK Content-type: image/jpeg Date: Sat, 27 Nov 2018 01:02:09 GMT (…) X-Robots-Tag: noindex, nofollow (…)

Eventuali direttive che potrebbero essere utilizzate con un meta tag robot sono applicabili anche a un tag X-robot. Allo stesso modo, puoi anche istruire più robot dei motori di ricerca:

HTTP/1.1 200 OK Date: Tue, 21 Sep 2018 21:09:19 GMT (…) X-Robots-Tag: googlebot: nofollow X-Robots-Tag: bingbot: noindex X-Robots-Tag: otherbot: noindex, nofollow (…)

È importante notare che i robot dei motori di ricerca scoprono i meta tag Robots e le intestazioni HTTP X-Robots-Tag durante il processo di scansione. Quindi, se vuoi che questi robot seguano le tue istruzioni per non seguire o indicizzare contenuti e documenti riservati, non devi interrompere la scansione di questi URL di pagine e file.

Se vengono bloccati dalla ricerca per indicizzazione utilizzando il file robots.txt, le tue istruzioni sull’indicizzazione non verranno lette e quindi ignorate. Di conseguenza, nel caso in cui altri siti web rimandino a contenuti e documenti, verranno comunque indicizzati da Google e da altri motori di ricerca.

Utilizzo delle regole .htaccess per i server Apache

Puoi anche aggiungere l’intestazione HTTP X-Robots-Tag al tuo file .htaccess per bloccare i crawler dalle pagine di indicizzazione e dai contenuti digitali del tuo sito web ospitati su un server Apache. A differenza dei meta tag no-index, le regole .htaccess possono essere applicate a un intero sito web o a una cartella particolare. Il supporto delle espressioni regolari offre una flessibilità ancora maggiore per indirizzare più tipi di file contemporaneamente.

Per impedire a Googlebot, Bing e Baidu di eseguire la scansione di un sito web o di una directory speciale, utilizzare le seguenti regole:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (googlebot|bingbot|Baiduspider) [NC]

RewriteRule .* - [R=403,L]

Per bloccare l’indicizzazione della ricerca di tutti i file .txt, .jpg, .jpeg, .pdf nell’intero sito web, aggiungi il seguente snippet:

<Files ~ "\.(txt|jpg|jpeg|pdf)$"> Header set X-Robots-Tag "noindex, nofollow" </FilesMatch>

Utilizzo dell’autenticazione della pagina con nome utente e password

I metodi sopra indicati impediranno la visualizzazione dei tuoi contenuti e documenti privati nei risultati di ricerca di Google. Tuttavia, tutti gli utenti con il link possono raggiungere i tuoi contenuti e accedere direttamente ai tuoi file. Per motivi di sicurezza, si consiglia vivamente di impostare l’autenticazione corretta con nome utente e password, nonché i permessi dei ruoli utente WordPress.

Ad esempio, le pagine che includono profili personali del personale e documenti sensibili a cui non possono accedere utenti anonimi devono essere inserite dietro un gate di autenticazione. Pertanto, anche quando gli utenti riescono in qualche modo a trovare le pagine, verranno loro richieste le credenziali prima di poter controllare il contenuto.

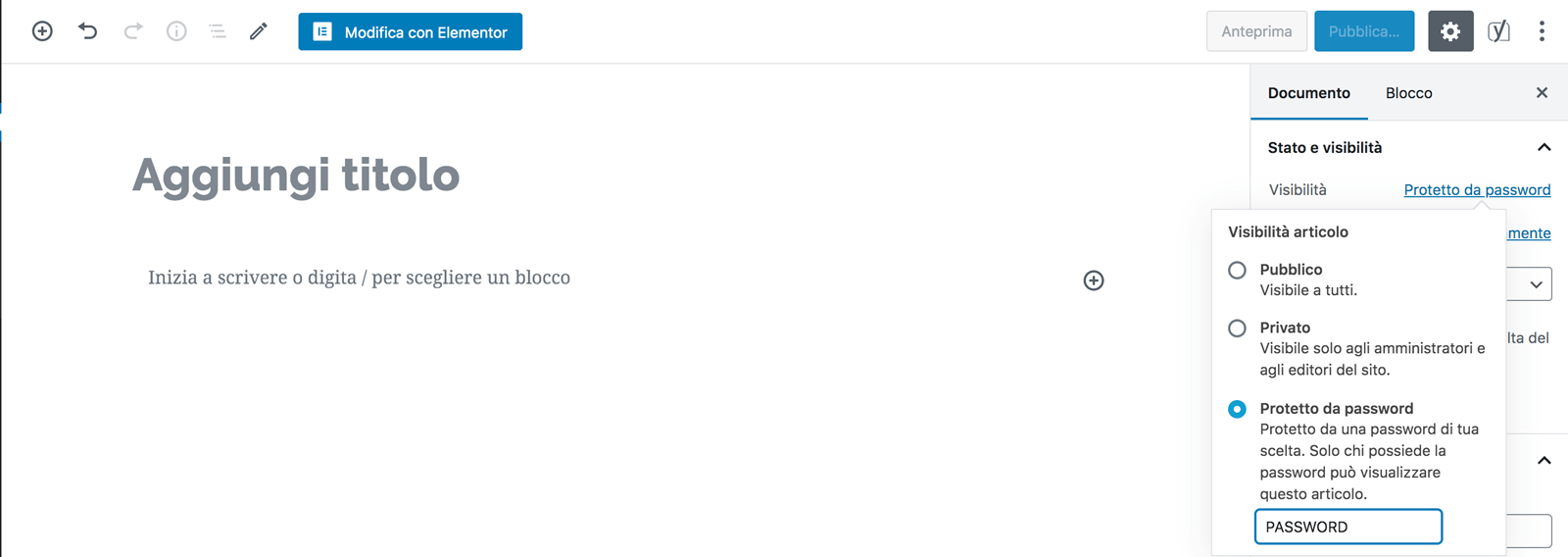

Per fare ciò con WordPress è sufficiente impostare la visibilità di un post su protetto da password . In questo modo è possibile selezionare una password richiesta per visualizzare il contenuto in quella pagina.

Tieni presente che le pagine protette da password o nascoste dai motori di ricerca e dai visitatori non proteggono necessariamente i documenti, i video e le immagini allegati al suo contenuto.

Conclusione

Nella gara per essere presente nella prima pagina di Google, i proprietari di attività commerciali potrebbero non prendere in considerazione ciò che i motori di ricerca possono vedere o no. Che tu stia bloccando i bot da un file specifico, nascondere una pagina di accesso personalizzata o protegga con password le directory degli utenti privati … ci sono molte pagine da considerare no-index quando si tratta di motori di ricerca.

Buon lavoro!