Capire cosa c’è oltre il testo visibile è sempre stato l’obiettivo più ambizioso dell’ottimizzazione semantica. Le parole non sono solo contenitori di significati: sono vettori che si muovono all’interno di uno spazio informazionale fatto di relazioni latenti, associazioni implicite, concetti condivisi. In questo scenario, il latent semantic indexing si presenta come uno dei modelli teorici più affascinanti e allo stesso tempo più controversi. Nato da una necessità scientifica – quella di trovare somiglianze tra documenti anche in assenza di parole identiche – l’LSI ha trasformato il concetto stesso di rilevanza.

È qui che avviene la svolta. Quando il motore di ricerca smette di cercare la parola chiave esatta e inizia a comprendere che “scarpa da corsa” può parlare anche di “ammortizzazione”, “maratona”, “tallone”, siamo in piena era semantica. E se oggi Google utilizza modelli ben più avanzati, il paradigma inaugurato dal latent semantic indexing ha definito le fondamenta della SEO semantica contemporanea. In un mondo che va oltre il semplice matching testuale, chi domina le relazioni concettuali è in grado di progettare contenuti che anticipano l’intento e catturano l’attenzione in modo naturale.

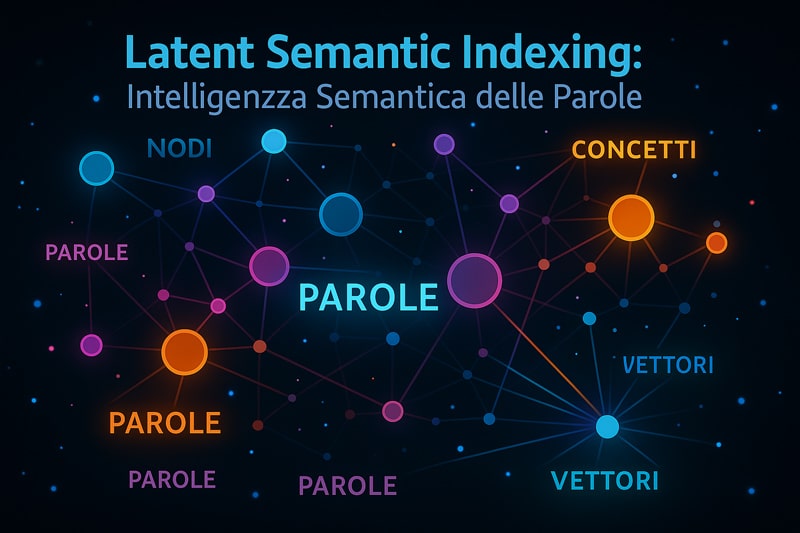

Molti si chiedono ancora cos’è il latent semantic indexing: non è solo un algoritmo, ma un approccio matematico in grado di scomporre, ridurre, mappare e inferire. Attraverso la decomposizione SVD, ogni termine viene associato a una dimensione semantica, creando uno spazio concettuale che supera la semplice co-occorrenza. Il semantic indexing in questa prospettiva diventa una forma di intelligenza distribuita. È una lente, un filtro, una rete che connette sinonimi, contesti, polarità e sfumature.

Il vero potere di questa tecnica non risiede nel suo utilizzo storico, ma nel concetto che introduce: la SEO non è solo keyword, è costruzione semantica. È prevedere le connessioni che l’utente farà tra ciò che scriviamo e ciò che cerca. È interpretare i segnali deboli che emergono da una query e trasformarli in risposte forti, precise, persuasive. In questa guida, attraverseremo il cuore pulsante dell’indicizzazione semantica: teoria, evoluzioni, strumenti e applicazioni. Se vuoi davvero migliorare la SEO con parole correlate, sei nel posto giusto.

Teoria fondamentale di LSI / LSA: SVD, matrici e coseni

Ogni tecnica che ambisce a superare i limiti della ricerca testuale tradizionale deve affrontare una sfida matematica precisa: interpretare ciò che le parole non dicono apertamente. È su questo principio che si fonda il latent semantic indexing, una metodologia che ha rivoluzionato l’approccio al recupero dell’informazione. Ma il suo cuore batte dentro una struttura molto più profonda e rigorosa: l’analisi semantica latente, nota come LSA, alimentata da strumenti matematici come la matrice termine-documento, la decomposizione SVD e il concetto di cosine similarity.

Per comprendere davvero il funzionamento di questo modello, è necessario scendere al livello delle matrici che rappresentano la realtà testuale. Ogni documento è un vettore. Ogni parola è una dimensione. Ogni spazio semantico si forma attraverso l’interazione tra frequenze, distribuzioni e co-occorrenze. Il sistema non si accontenta di contare parole: riduce, proietta, astrae. Ed è in questo movimento matematico che si attiva il potere dell’LSI, capace di trasformare un testo in una mappa concettuale navigabile.

La funzione della decomposizione SVD è fondamentale in questo processo, ma anche il modo in cui viene costruita la matrice di partenza lo è. Ogni riga contiene un termine, ogni colonna un documento, e le celle rappresentano un punteggio: può essere un semplice conteggio, oppure un valore tf-idf ponderato. Su questa base, si attiva il processo di fattorizzazione, che condensa l’informazione nei suoi assi semantici principali. A quel punto, non è più necessario che due documenti contengano le stesse parole: basta che occupino lo stesso spazio concettuale. È questa l’essenza dell’indicizzazione semantica latente.

Che cos’è la decomposizione SVD e come la usa il latent semantic indexing

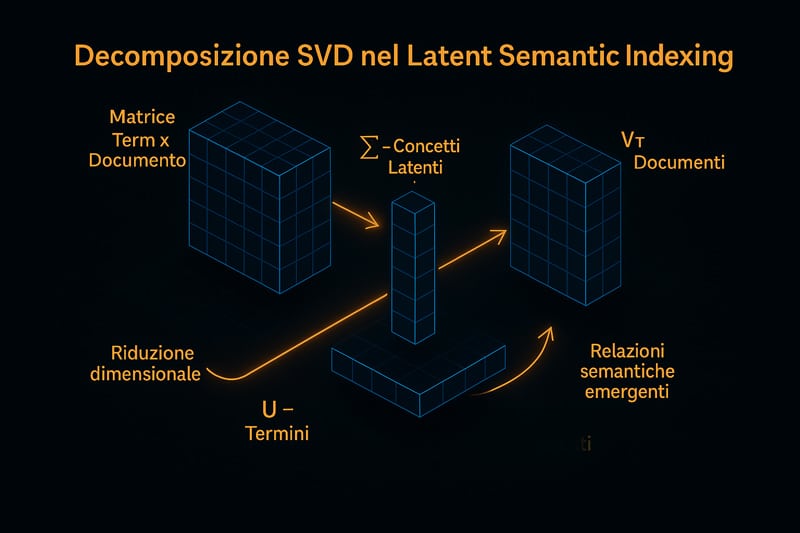

Capire la decomposizione ai valori singolari significa entrare nel laboratorio matematico in cui le parole diventano vettori e le frasi superfici semantiche. L’algoritmo SVD – acronimo di Singular Value Decomposition – prende in input una matrice termine-documento e la scompone in tre sotto-matrici che rappresentano, rispettivamente, i concetti fondamentali (U), le relazioni di peso (Σ) e le proiezioni documentali (Vᵗ). In altre parole, il contenuto testuale viene trascritto in un linguaggio geometrico.

Il latent semantic indexing sfrutta questa trasformazione per individuare schemi latenti: associazioni che sfuggono al confronto diretto tra termini, ma emergono come tendenze distribuzionali. Un esempio pratico: due documenti potrebbero non condividere alcuna parola, ma se parlano dello stesso argomento, la riduzione SVD li collocherà nello stesso spazio semantico. Questo perché la SVD è in grado di comprimere l’informazione mantenendo solo le componenti più significative, scartando il rumore.

Per la SEO, questo concetto cambia le regole. Non è necessario ripetere la stessa keyword per essere rilevanti: basta inserirsi correttamente nel campo semantico. È così che nascono le keyword LSI, ovvero quei termini che, pur non essendo sinonimi, coesistono in contesti simili e rafforzano la pertinenza del contenuto. La SVD per semantic indexing quindi non è solo una formula, ma una chiave per capire come scrivere testi ricchi, coerenti, tematicamente forti.

Per comprendere visivamente come opera la decomposizione SVD nel Latent Semantic Indexing, osserva la rappresentazione seguente:

Cosine similarity nel semantic indexing: perché conta per la rilevanza

Quando due documenti sembrano parlare della stessa cosa, ma non condividono alcuna keyword, è probabile che sia entrata in gioco la cosine similarity. Questo indice, largamente usato in ambito NLP e latent semantic indexing, misura l’angolo tra due vettori nello spazio semantico. Un angolo piccolo indica alta affinità: i contenuti sono simili, anche se le parole sono diverse. È la distanza concettuale, non quella testuale, a determinare la pertinenza.

Nel contesto SEO, questo concetto è rivoluzionario. Se il contenuto è costruito per rispondere davvero a un intento di ricerca, allora anche con lessico vario può ottenere un’elevata somiglianza semantica. Questo spiega perché contenuti ottimizzati con keyword correlate possono posizionarsi meglio di pagine che ripetono meccanicamente lo stesso termine. La cosine similarity è la matematica che traduce la qualità semantica in rilevanza algoritmica.

Tuttavia, perché questa metrica funzioni, la base vettoriale deve essere costruita in modo preciso. Ciò avviene tramite SVD o altri metodi di embedding. Ma in tutti i casi, ciò che conta è la distribuzione delle parole, il contesto, la coerenza semantica. Ecco perché strumenti come il semantic indexing non valutano semplicemente il testo, ma il significato che emerge dalla sua struttura. E quando la struttura è ben progettata, il posizionamento segue in modo naturale.

Evoluzione probabilistica: PLSA e LDA

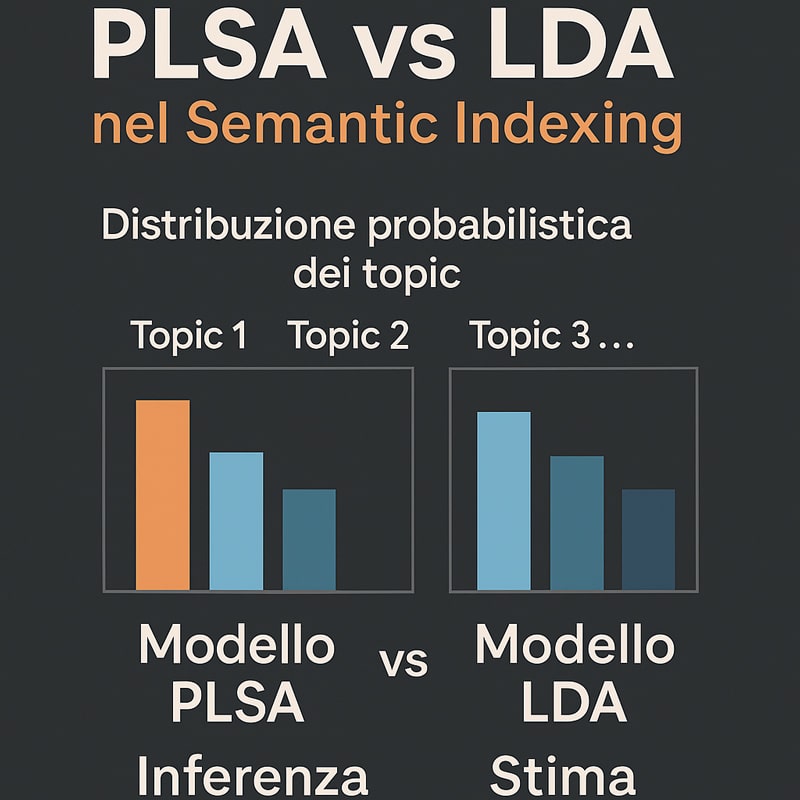

Nel corso del tempo, il latent semantic indexing ha rappresentato un punto di partenza fondamentale per la costruzione di modelli più sofisticati in grado di comprendere la semantica dei testi. Tuttavia, nonostante la sua eleganza geometrica, basata sulla riduzione tramite SVD, l’LSI ha mostrato limiti evidenti nel trattamento dell’ambiguità e della variabilità lessicale. Per superare queste rigidità, si è passati a modelli probabilistici, in particolare alla Probabilistic Latent Semantic Analysis (PLSA) e, successivamente, alla Latent Dirichlet Allocation (LDA). Questi approcci segnano un’evoluzione concettuale netta: non più spazi semantici statici, ma strutture probabilistiche dinamiche in grado di adattarsi alla complessità reale dei testi.

Il cambiamento fondamentale introdotto da PLSA sta nell’abbandonare la visione deterministica della semantica per abbracciare una rappresentazione basata su distribuzioni di probabilità tra documenti, termini e concetti latenti. In pratica, PLSA non riduce lo spazio: lo modella, e lo fa cercando di comprendere quali temi siano sottostanti a un insieme di parole osservate. Questo approccio, centrato sull’utilizzo dell’algoritmo EM (Expectation Maximization), consente di costruire un modello generativo dove i termini sono osservati come espressioni di uno o più topic non visibili. L’indice semantico non è più solo una mappa, ma una previsione strutturata dei contenuti.

Con LDA si compie un ulteriore salto: non solo si rappresentano i temi in modo probabilistico, ma si considera anche la possibilità che ogni documento sia una miscela di argomenti, ognuno con la sua distribuzione di parole. Questo rende il sistema più flessibile, più realistico e più efficiente dal punto di vista computazionale. È in questo spazio probabilistico che la semantica trova una nuova dimensione: non si tratta più di vicinanza vettoriale, ma di affinità distribuzionale. E quando l’obiettivo è comprendere in profondità l’intento di un testo, questi modelli diventano alleati preziosi per ogni strategia SEO orientata alla pertinenza reale.

PLSA vs LSI: come migliora l’analisi semantica iterativa

Il confronto tra latent semantic indexing e probabilistic latent semantic analysis segna il passaggio da un modello basato su trasformazioni geometriche a uno che costruisce il significato a partire dalla probabilità di co-occorrenza tra parole e concetti latenti. La PLSA parte da un presupposto diverso: non si limita a scomporre una matrice, ma cerca di scoprire quali temi nascosti siano responsabili delle parole che osserviamo nei documenti. È un modello generativo in grado di inferire la presenza di argomenti che non sono dichiarati esplicitamente ma emergono come distribuzioni interne.

Il vantaggio più significativo della PLSA rispetto al classico LSI è la capacità di gestire la polisemia e la sinonimia in modo dinamico, adattando il modello all’evidenza testuale. Mentre l’LSI attribuisce significato tramite proiezioni spaziali fisse, la PLSA ricalibra continuamente le sue assunzioni grazie all’algoritmo di massimizzazione dell’attesa. Questo rende il sistema più sensibile al contesto e più capace di cogliere le variazioni semantiche che si verificano in documenti lunghi o misti.

Dal punto di vista SEO, l’applicazione di modelli PLSA apre scenari nuovi: i contenuti non vengono più valutati solo in base alla presenza di keyword, ma in funzione della distribuzione di argomenti latenti. Questo permette di creare testi che rispondano a più intenti contemporaneamente, aumentando la copertura semantica e migliorando la rilevanza percepita sia dagli utenti sia dagli algoritmi di ricerca. È una strategia evoluta, che sposta l’attenzione dalle parole alle relazioni probabilistiche che quelle parole costruiscono nella mente del lettore e del motore di ricerca.

LDA per topic modeling: quando è meglio di LSI

Con l’introduzione della Latent Dirichlet Allocation, l’analisi semantica fa un salto qualitativo decisivo. LDA non cerca solo di rappresentare concetti latenti: li genera. A differenza del latent semantic indexing, che si basa sulla scomposizione lineare di relazioni note, LDA costruisce un modello generativo nel quale ogni documento è considerato come una combinazione di argomenti, ciascuno associato a un insieme di parole con una propria distribuzione probabilistica. Questo approccio consente una maggiore flessibilità semantica, rendendo il sistema adatto ad analizzare corpora ampi, eterogenei e dinamici.

La forza di LDA risiede nella sua struttura matematica basata su una distribuzione Dirichlet: una funzione che permette di generare infinite combinazioni di argomenti a partire da un set limitato di dati. Questo significa che, anche in presenza di contenuti frammentari o incoerenti, l’algoritmo è in grado di inferire relazioni tematiche coerenti e informativamente dense. A differenza dell’LSI, che offre uno snapshot rigido della semantica, LDA evolve con il testo, adattandosi ai pattern linguistici emergenti.

Quando si lavora in ambito SEO, questo livello di granularità offre vantaggi notevoli. Un contenuto strutturato secondo i principi dell’LDA sarà naturalmente predisposto a rispondere a intenti multipli, ad anticipare le query correlate e a occupare più spazio semantico nei motori di ricerca. Questo si traduce in una maggiore probabilità di posizionamento, specialmente in contesti informativi dove la varietà lessicale e la coerenza semantica sono elementi premianti. In breve, quando l’obiettivo è coprire un argomento con profondità e varietà, LDA è superiore a LSI per performance, adattabilità e precisione concettuale.

Per chiarire visivamente le differenze chiave tra PLSA e LDA nell’indicizzazione semantica, osserva l’infografica comparativa seguente:

Tecniche moderne NLP: embedding, modelli transformer e dense retrieval

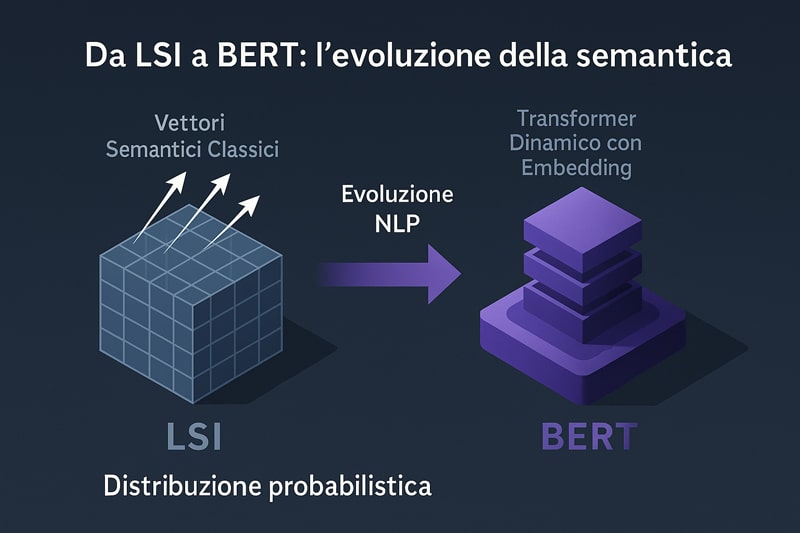

L’evoluzione del latent semantic indexing non si è fermata alla modellazione probabilistica. Con il progressivo affinamento delle tecniche di Natural Language Processing, si è aperta una nuova era in cui l’obiettivo non è più solo mappare lo spazio semantico, ma comprendere il contesto linguistico in tempo reale. L’ingresso di architetture come word2vec, GloVe e soprattutto i modelli transformer come BERT ha modificato radicalmente il modo in cui il significato viene rappresentato nei modelli computazionali. In questo scenario, il concetto stesso di indicizzazione assume un significato completamente diverso: non si tratta più di identificare termini correlati, ma di prevedere le relazioni concettuali a partire dalla posizione, dal contesto e dalla struttura sintattica.

Il latent semantic index viene così superato non per obsolescenza, ma per cambiamento di paradigma. Non è più sufficiente individuare schemi distribuzionali latenti: ora serve modellare l’interazione contestuale tra ogni singolo termine e la frase che lo circonda. È per questo che i moderni modelli NLP impiegano reti neurali profonde e meccanismi di attenzione, che assegnano peso semantico dinamico in base alla funzione che ogni parola ricopre all’interno del discorso. In questo modo, non è più necessario appoggiarsi a una rappresentazione statica del lessico: ogni parola viene ricalibrata continuamente in funzione del suo ruolo comunicativo.

L’adozione di queste tecnologie ha trasformato anche l’ambito SEO. Mentre una volta si cercava di ottimizzare per keyword specifiche, oggi si lavora sulla pertinenza semantica dinamica, sull’intento espresso e sull’interazione concettuale che il contenuto sviluppa con le query. In questo nuovo scenario, strumenti come BERT e modelli di embedding rappresentano l’infrastruttura invisibile della SEO avanzata, quella che permette di parlare la lingua dell’algoritmo senza sacrificare la naturalezza del testo. È qui che si realizza l’equilibrio perfetto tra precisione matematica e capacità narrativa.

Word embeddings e BERT vs latent semantic indexing

Il confronto tra modelli di embedding e latent semantic indexing rivela una trasformazione epocale nel modo in cui il significato viene calcolato, rappresentato e applicato. LSI parte da una matrice termine-documento, la riduce via SVD e costruisce uno spazio concettuale basato sulla co-occorrenza. I word embeddings, invece, apprendono da miliardi di frasi reali e associano a ogni parola un vettore continuo multidimensionale, capace di catturare relazioni sintattiche e semantiche profonde. Questo significa che due parole semanticamente affini saranno vicine nello spazio, anche se non compaiono mai insieme in un documento.

Il salto ulteriore si verifica con l’introduzione dei modelli transformer. BERT – acronimo di Bidirectional Encoder Representations from Transformers – non solo tiene conto della vicinanza, ma valuta ogni parola nel suo contesto bidirezionale. Ogni termine viene aggiornato dinamicamente in base a ciò che lo precede e lo segue, trasformando la rappresentazione semantica in un processo continuo e non più statico. A differenza di LSI, che utilizza una sola rappresentazione per ogni parola, BERT genera embedding contestuali, aggiornati istante per istante durante la lettura del testo.

Questo approccio è particolarmente efficace per la SEO. I motori di ricerca non cercano più corrispondenze esatte: analizzano l’intenzione semantica, la struttura narrativa, l’allineamento del contenuto con la query. Grazie ai transformer, è possibile scrivere contenuti che anticipano le domande, risolvono i dubbi impliciti e abbracciano più significati. Ecco perché il futuro dell’ottimizzazione non passa più dalla keyword density, ma dalla precisione narrativa potenziata dall’NLP. Un contenuto costruito con modelli di embedding non è solo rilevante: è anche strategico, contestuale e semanticamente solido.

Per visualizzare chiaramente l’evoluzione dai modelli LSI ai transformer come BERT, osserva lo schema comparativo seguente:

Dense retrieval e SPIKE: la frontiera avanzata dell’indicizzazione semantica

Mentre il latent semantic indexing agiva come un raffinato traduttore delle relazioni testuali implicite, le tecnologie di dense retrieval hanno portato il concetto di indicizzazione a un livello di accuratezza senza precedenti. In questo modello, le query e i documenti non vengono confrontati tramite parole chiave, ma vengono convertiti in vettori ad alta densità, capaci di catturare l’intera struttura semantica in un’unica rappresentazione numerica. Non si tratta più di confrontare parole, ma significati interi compressi in coordinate geometriche.

Uno degli strumenti più avanzati in questo contesto è SPIKE, un sistema di retrieval neurale sviluppato per affrontare scenari complessi di interrogazione linguistica. SPIKE unisce l’efficienza dell’indicizzazione densa alla precisione dei modelli transformer, permettendo di effettuare ricerche basate non su parole esatte, ma su concetti. È un cambio di paradigma: dalla corrispondenza letterale all’inferenza semantica automatizzata. I documenti non sono più semplici insiemi di frasi, ma nodi all’interno di una rete semantica ad alta precisione.

Per la SEO, il dense retrieval introduce una nuova metrica: la coerenza semantica vettoriale, un valore che esprime quanto un contenuto sia vicino all’intento latente di una query. Questo significa che non basta più scrivere testi ben costruiti: serve progettare contenuti geometricamente vicini all’interpretazione dell’algoritmo, capaci di intercettare non solo ciò che viene digitato, ma anche ciò che viene pensato. In questo quadro, SPIKE rappresenta il ponte tra NLP avanzato e strategie SEO evolute, trasformando l’indicizzazione in una vera e propria architettura di comprensione.

Scalabilità e limiti del Latent Semantic Indexing

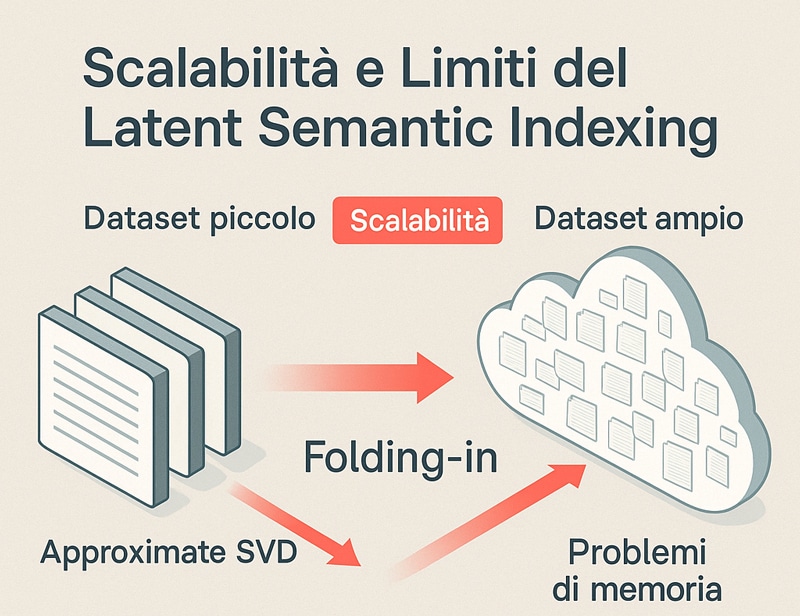

Quando si affronta la questione della scalabilità del latent semantic indexing, ci si scontra con una realtà matematica e computazionale non più eludibile. Le promesse teoriche di questo modello, pur straordinarie in ambienti controllati o dataset contenuti, iniziano a mostrare fragilità strutturali man mano che si estende l’ampiezza e la complessità del corpus da indicizzare. La matrice termine-documento cresce esponenzialmente, e con essa i tempi e le risorse necessarie alla decomposizione ai valori singolari. Questo fenomeno impone un ripensamento del modello classico, non tanto per negarne l’efficacia, ma per capire come mantenerla su scala industriale.

In ambito SEO avanzato, il concetto di semantic index si intreccia con l’esigenza di lavorare su migliaia di contenuti, su più lingue, su fonti aggiornate continuamente. Qui il latent semantic indexing si trova a operare in condizioni per cui non è stato progettato. Ogni nuova riga nella matrice rappresenta un termine in più. Ogni colonna un nuovo documento. La loro moltiplicazione porta a matrici così vaste che diventa impraticabile conservarle in RAM, figuriamoci calcolarne la SVD. A questo si aggiunge l’inefficienza del modello classico rispetto ai moderni motori basati su embedding neurali, capaci di apprendere e aggiornarsi in tempo reale.

Ma prima di liquidarlo come superato, è fondamentale considerare le tecniche di ottimizzazione strutturale, che permettono al modello LSI di adattarsi a carichi computazionali maggiori. Queste soluzioni non lo trasformano, ma lo alleggeriscono, conservandone l’essenza. È proprio qui che entrano in gioco approcci come il folding-in, la decomposizione approssimata e l’indicizzazione incrementale. Strumenti matematici che non sostituiscono la semantica latente, ma la rendono più agile, più efficiente, più scalabile. La questione allora non è se il latent semantic indexing sia ancora utile, ma come usarlo al meglio quando il volume dei dati si espande senza controllo.

Folding-in: come scalare il latent semantic indexing su milioni di documenti

Quando il corpus cresce, e il numero di documenti supera le migliaia, diventa necessario trovare un modo per aggiornare lo spazio semantico senza ricostruirlo da zero. È qui che interviene la tecnica del folding-in, una procedura matematica che consente di integrare nuovi documenti all’interno dello spazio semantico esistente, sfruttando le matrici U e Σ già calcolate nella precedente decomposizione SVD. Questo significa che si possono aggiungere nuovi contenuti al modello senza dover ripetere l’intero processo, con un risparmio di risorse che può arrivare a ordini di grandezza.

Il vantaggio principale del folding-in è la sua compatibilità con architetture scalabili. È possibile segmentare il corpus in blocchi, calcolare il modello semantico di base e poi procedere all’integrazione progressiva di nuovi dati. Questa tecnica, sebbene più approssimativa rispetto alla rigenerazione completa della SVD, garantisce una continuità semantica sufficiente per la maggior parte delle applicazioni SEO e di retrieval informazionale. In pratica, si rinuncia a una minima parte di precisione per ottenere una drastica riduzione del costo computazionale.

Dal punto di vista operativo, il folding-in è particolarmente utile nei contesti editoriali digitali, dove ogni giorno vengono prodotti nuovi articoli, schede prodotto o contenuti tematici. È possibile mappare ogni nuovo testo nello spazio semantico già costruito, verificando quanto sia distante o affine rispetto ai topic già esistenti. Questo consente un controllo avanzato della semantica del sito e una profilazione più precisa delle keyword latenti. In definitiva, il folding-in non è solo una soluzione tecnica: è una strategia intelligente per scalare il latent semantic indexing in ambienti ad alto volume.

Per comprendere le sfide legate alla scalabilità del Latent Semantic Indexing, osserva lo schema comparativo seguente:

Limitazioni pratiche del latent semantic index su big data

Quando il volume dei dati cresce in modo esponenziale, anche i modelli semantici più eleganti iniziano a mostrare i propri limiti. Il latent semantic indexing, pur essendo uno strumento potente nella modellazione del significato, soffre di problemi strutturali che emergono con particolare evidenza nei sistemi big data. Il primo è la complessità computazionale della decomposizione SVD, che richiede un’enorme quantità di memoria e una potenza di calcolo elevata. Ogni aggiornamento del modello, in assenza di strategie come il folding-in, comporta un riavvio dell’intero processo, con un impatto notevole in termini di tempi e costi.

A questo si aggiungono i problemi legati alla memorizzazione delle matrici, che diventano rapidamente ingestibili. Anche utilizzando tecniche di compressione o riduzione dimensionale, la base del modello resta rigida. Non è possibile adattare dinamicamente l’insieme delle dimensioni semantiche senza ripercussioni sulla coerenza dell’intero sistema. Questo porta a un paradosso: più si cerca di ampliare la copertura semantica, più si aumenta l’instabilità del modello. A differenza degli embedding neurali, che imparano in modo incrementale, LSI è fragile nei contesti dinamici ad alta variabilità.

Il terzo limite critico è legato alla perdita di granularità semantica. In presenza di dati molto eterogenei, la riduzione SVD tende a unificare concetti distinti in assi comuni, sacrificando le sfumature. Questo effetto, chiamato sovrapposizione semantica, può ridurre la precisione dell’indicizzazione, specialmente nei settori verticali dove ogni parola ha significati specialistici. Per la SEO, questo significa perdere potere discriminante nella scelta delle keyword e nella corrispondenza con le query dell’utente. Ed è qui che si rende necessario integrare o sostituire il modello con approcci più flessibili e adattivi.

LSI e SEO oggi: keyword correlate e posizionamento semantico

La connessione tra latent semantic indexing e SEO moderna ha attraversato molte fasi evolutive, ma resta un punto cardine per chi desidera ottenere posizionamenti organici duraturi. Il concetto di LSI viene spesso frainteso o semplificato: si riduce talvolta a una tecnica per “inserire sinonimi” o “ampliare le keyword”, ma in realtà si tratta di un approccio matematico alla costruzione di contenuti semanticamente coerenti. Le keyword correlate, quando correttamente selezionate e integrate, non servono a ingannare gli algoritmi, ma a comunicare un’intenzione completa, profonda e multilivello.

Nel contesto della SEO semantica, il latent semantic indexing ha la funzione di fornire uno strato intermedio tra il linguaggio umano e quello computazionale. Non si tratta solo di trovare parole simili: si tratta di costruire un reticolo concettuale dove ogni elemento rafforza gli altri, creando un senso che va oltre la somma delle parti. Questo è particolarmente importante per i contenuti di qualità, quelli che non si limitano a rispondere alla query, ma che anticipano le domande latenti dell’utente, migliorando così l’interazione e il tempo di permanenza.

La sfida oggi consiste nel bilanciare la densità delle keyword con la naturalezza espressiva. I motori di ricerca non valutano più solo la presenza di parole chiave, ma la loro distribuzione semantica, la pertinenza con il contesto e la profondità del discorso. Un contenuto costruito attorno a un asse semantico solido, sostenuto da keyword correlate selezionate con criterio, ha molte più possibilità di posizionarsi rispetto a uno che punta solo sulla frequenza. In questo panorama, il latent semantic indexing diventa strumento strategico per progettare contenuti organici, costruiti sulla logica della comprensione, non della ripetizione.

Keyword LSI nel copywriting: come usare latent semantic keywords per migliorare il posizionamento

Scrivere contenuti ottimizzati oggi significa padroneggiare la relazione tra keyword principali e keyword latenti, ovvero quelle che, pur non essendo espressamente richieste, rafforzano il significato del testo agli occhi degli algoritmi semantici. L’utilizzo corretto delle LSI keywords non è un semplice inserimento meccanico, ma una strategia narrativa e concettuale. Ogni parola correlata ha la funzione di creare risonanza semantica, e più alta è la coerenza, maggiore sarà la rilevanza percepita dal motore di ricerca.

Quando si scrive un paragrafo, la scelta delle parole non può essere casuale. Integrare keyword LSI significa disegnare un campo semantico coerente che abbracci sinonimi, concetti associati, metafore e perfino esempi concreti. Se si parla di “ottimizzazione dei contenuti”, le keyword latenti possono essere: “struttura dei paragrafi”, “leggibilità”, “esperienza utente”, tutte espressioni che, pur non essendo keyword primarie, rafforzano l’intento complessivo. È questo che l’algoritmo interpreta come valore semantico.

La scrittura SEO non è più solo tecnica: è diventata ingegneria del significato. Un contenuto che utilizza le keyword correlate in modo strategico viene percepito come più utile, completo e pertinente. Non perché “contiene più parole”, ma perché conferisce profondità e contesto all’informazione trasmessa. In questo senso, il latent semantic indexing diventa non solo un modello teorico, ma una bussola concreta per il copywriter moderno, che desidera generare contenuti duraturi e resistenti ai cambi di algoritmo.

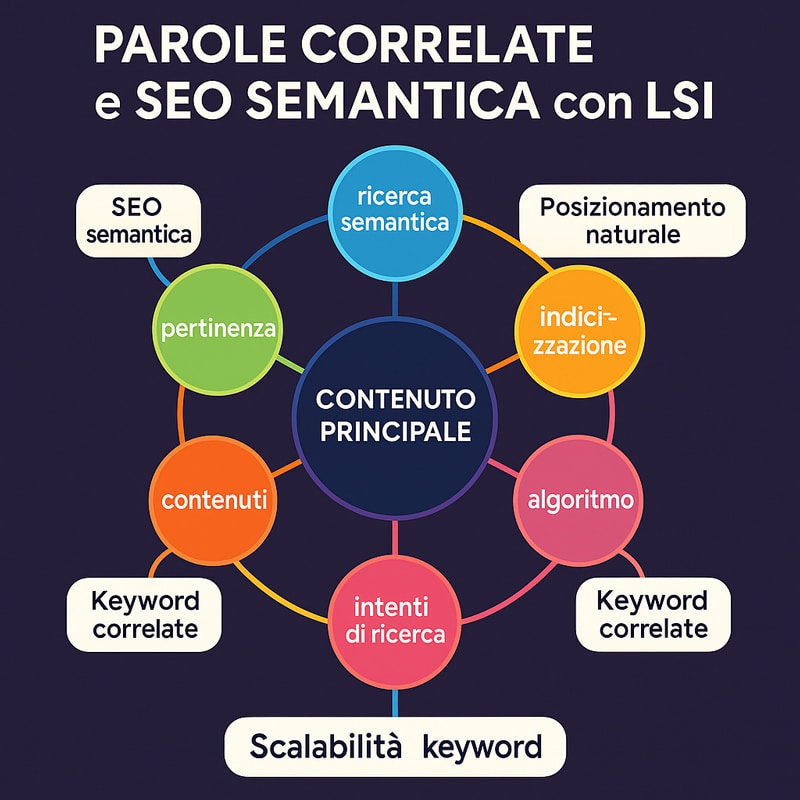

Per comprendere la struttura concettuale di una strategia basata su keyword correlate LSI, osserva la mappa semantica seguente:

Differenza tra stuffing e SEO semantico con LSI

Uno degli errori più comuni nella scrittura SEO è confondere la ripetizione forzata di parole chiave con una vera strategia semantica. Il cosiddetto keyword stuffing è ormai un segnale negativo per i motori di ricerca, che penalizzano i contenuti percepiti come artificiali. Al contrario, il latent semantic indexing promuove un approccio opposto: non concentrare, ma distribuire senso. Le keyword devono essere inserite in un contesto che le giustifichi, che ne potenzi il significato senza snaturare la fluidità del testo.

Mentre lo stuffing punta sulla densità, la SEO semantica valorizza la pertinenza. È meglio usare una parola chiave una sola volta in un paragrafo ben strutturato, che ripeterla inutilmente in frasi scollegate. La differenza la fa la densità semantica, cioè la capacità del contenuto di esprimere un tema attraverso una molteplicità di sfumature e varianti linguistiche. In questo scenario, il latent semantic indexing diventa il modello teorico che guida l’autore nella scelta delle combinazioni più efficaci.

La qualità del contenuto si misura quindi non tanto dalla presenza delle parole “giuste”, ma dalla coerenza tra il linguaggio utilizzato e l’intento dell’utente. Un testo ottimizzato semantico non forza il significato, lo costruisce. Utilizza sinonimi, metafore, esempi, referenze implicite per creare una rete concettuale densa ma naturale. In questo modo, il contenuto non solo è apprezzato dagli algoritmi, ma mantiene un valore comunicativo autentico, capace di coinvolgere e convincere l’essere umano prima ancora del motore di ricerca.

Semantic Hashing vs Latent Semantic Indexing

Il confronto tra semantic hashing e latent semantic indexing non è solo una questione tecnologica, ma riflette due concezioni profondamente diverse del trattamento semantico dei dati testuali. Da una parte, il latent semantic indexing si basa sulla riduzione dimensionale tramite SVD, puntando su un’analisi concettuale profonda, strutturata e iterativa. Dall’altra, il semantic hashing si muove verso una compressione binaria dello spazio semantico, finalizzata alla velocità estrema nei sistemi di retrieval massivo.

Comprendere la differenza tra i due modelli significa capire quali obiettivi si desiderano raggiungere: se la priorità è la precisione semantica, allora il latent semantic indexing resta uno strumento insostituibile per la sua capacità di catturare relazioni latenti e strutture concettuali nascoste. Ma quando il dataset supera soglie di miliardi di documenti, l’approccio LSI comincia a mostrare i suoi limiti computazionali. In quei casi, entra in gioco il semantic hashing, con la sua capacità di rappresentare il contenuto semantico in vettori binari ultra-compatti, utilizzabili in architetture distribuite e sistemi real-time.

Tuttavia, la scelta non è mai assoluta. Esistono ambienti in cui i due approcci possono persino coesistere. Il latent semantic indexing può essere usato per costruire lo spazio concettuale e il semantic hashing per indicizzarlo in modo rapido. Non è una questione di sostituzione, ma di sinergia: precisione e velocità non sono sempre in conflitto, e la loro armonizzazione può generare modelli ibridi più performanti, specialmente in ambito SEO semantico avanzato dove la latenza e la rilevanza devono convivere.

Cosa è il semantic hashing e come confrontarlo con il latent semantic indexing

Il semantic hashing è una tecnica di indicizzazione semantica che trasforma documenti e frasi in codici binari altamente compatti. Questi codici, chiamati hash semantici, permettono di effettuare ricerche per similarità in modo estremamente rapido, riducendo drasticamente il tempo di retrieval rispetto al latent semantic indexing. A differenza della matrice termine-documento del modello LSI, il semantic hashing si basa su architetture neurali, spesso autoencoder, che apprendono rappresentazioni semantiche dense e poi le comprimono in vettori binari.

Ma come si confrontano davvero questi due approcci? Il latent semantic indexing si affida a trasformazioni lineari (SVD) che preservano il significato attraverso proiezioni nello spazio semantico, mentre il semantic hashing compie un salto nel discreto: da significati continui a chiavi binarie, dove ogni bit rappresenta una dimensione concettuale appresa. Questo rende il hashing incredibilmente veloce, ma più fragile nei casi di ambiguità semantica o polisemia, dove il LSI conserva un vantaggio strutturale evidente.

La scelta tra i due dipende dal contesto applicativo. Per grandi portali editoriali che gestiscono flussi costanti di contenuti, il semantic hashing può fornire performance ideali per classificazione e clustering. Ma se l’obiettivo è produrre contenuti ottimizzati SEO che rispondano con precisione alle intenzioni di ricerca, allora il latent semantic indexing rimane ancora oggi più affidabile. La sua capacità di individuare relazioni tra parole lontane nel testo e identificare tematiche profonde lo rende insostituibile nei processi di ottimizzazione semantica dei contenuti.

Precisione vs velocità: scegliere il latent semantic indexing o hashing

Ogni modello semantico porta con sé una scelta implicita tra accuratezza e rapidità. Il latent semantic indexing è noto per la sua elevata precisione concettuale, grazie alla SVD che riesce a scomporre i significati nascosti in assi semantici interpretabili. Ma questa raffinatezza ha un costo: in ambienti ad alta scala, il tempo di calcolo può diventare un fattore limitante, sia nella fase di training che in quella di aggiornamento. Per contro, il semantic hashing, pur sacrificando parte della granularità semantica, offre un accesso istantaneo al contenuto indicizzato, ideale per casi d’uso real-time.

Per chi opera in ambito SEO, questa dicotomia si traduce in due strategie operative differenti. Con il latent semantic indexing si possono produrre contenuti ottimizzati che coprono le aree semantiche centrali e periferiche della query. Si lavora in profondità, mappando ogni termine in relazione a concetti latenti. Con il semantic hashing, invece, l’obiettivo è velocizzare il matching tra query e documento, ma con un rischio maggiore di errori semantici, specialmente su keyword a coda lunga o ambigue.

La scelta tra precisione e velocità deve quindi rispondere a una domanda fondamentale: quale valore si vuole privilegiare nel proprio ecosistema informativo? Per il posizionamento organico stabile e duraturo, la ricchezza semantica offerta dal latent semantic indexing rimane preferibile. Per sistemi automatizzati e servizi su larga scala, la velocità del semantic hashing è un asset irrinunciabile. Non si tratta di una rivalità, ma di un trade-off strategico, che ogni professionista deve valutare in base agli obiettivi specifici del progetto.

Per visualizzare le differenze tra LSI e Semantic Hashing in termini di struttura, prestazioni e logica di indicizzazione, guarda l’infografica tecnica seguente:

Strumenti per keyword semantiche e monitoraggio

L’efficacia di un contenuto oggi non dipende soltanto dalla sua forma, ma dalla profondità semantica che riesce a esprimere attraverso parole chiave ben selezionate e interconnesse. Per raggiungere questo risultato, non è sufficiente affidarsi all’intuito o all’esperienza editoriale: serve una mappa precisa del significato latente nascosto nelle query degli utenti. È qui che entrano in gioco gli strumenti che operano secondo i principi del latent semantic indexing, capaci di identificare non solo le keyword visibili, ma le relazioni semantiche implicite che strutturano un argomento.

Nell’ambito SEO, l’utilizzo strategico di keyword LSI consente di aumentare la coerenza concettuale di una pagina, migliorando il posizionamento non soltanto per la keyword principale, ma anche per le sue varianti tematiche e semantiche. Tuttavia, per farlo con efficacia, è indispensabile disporre di tool che non si limitino a fornire un elenco di sinonimi, ma che siano in grado di mappare le reti concettuali tra i contenuti esistenti, le query emergenti e le entità rilevanti. Solo in questo modo il latent semantic indexing può essere applicato con rigore, producendo risultati tangibili e misurabili.

Questo vale soprattutto per chi opera in mercati competitivi, dove la differenza tra una pagina visibile e una invisibile può dipendere da una singola relazione semantica non intercettata. Avere a disposizione strumenti capaci di estrarre, ordinare e confrontare keyword LSI e correlate in tempo reale significa anticipare le esigenze dell’utente, rafforzare il campo semantico del contenuto e ottimizzare l’indicizzazione organica. L’indice semantico, in questo contesto, non è più teoria astratta: è una tecnologia applicata, una struttura dinamica che guida ogni scelta redazionale con logica scientifica.

I migliori tool per estrarre keyword LSI e keyword semantiche correlate

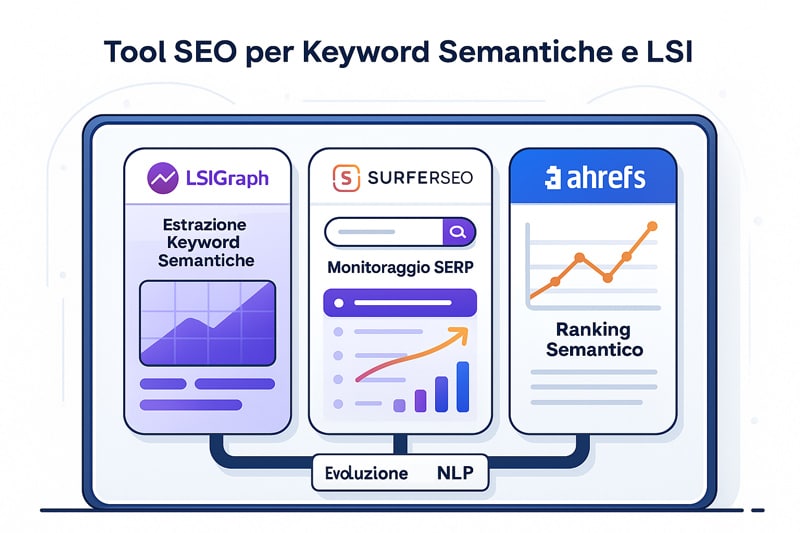

Per applicare in modo efficace i principi del latent semantic indexing al content marketing, è fondamentale disporre di strumenti capaci di evidenziare le relazioni semantiche latenti nei testi. Tra i tool più affidabili, LSIGraph si distingue per la capacità di generare cluster di keyword correlate partendo da una parola chiave principale, offrendo una visione organizzata del campo semantico da esplorare. Questo permette al copywriter di costruire contenuti che non si limitano a ripetere keyword, ma espandono la semantica della pagina in modo coerente e strategico.

SurferSEO rappresenta un’altra risorsa potente. La sua funzione di analisi semantica si basa sull’estrazione delle entità e delle correlazioni presenti nei contenuti top-ranking, con una precisione che riflette direttamente i meccanismi dell’indicizzazione semantica moderna. Il sistema propone non solo keyword, ma anche frasi, contesti e concetti, utili per ottimizzare il testo in linea con le aspettative degli algoritmi. Questo approccio applica indirettamente i principi del latent semantic indexing, permettendo di agire su interi campi semantici anziché su parole isolate.

Infine, strumenti come Ahrefs e Ubersuggest offrono la possibilità di esplorare content gap semantici, confrontando i termini utilizzati nei propri contenuti con quelli presenti nei siti competitor. Questo consente non solo di trovare nuove keyword, ma anche di individuare vuoti informativi e temi latenti non ancora trattati, allineando la scrittura a un modello di pertinenza semantica coerente con l’intento dell’utente. Ogni parola scelta attraverso questi strumenti rafforza l’intero indice semantico, migliorando il posizionamento SEO in modo sostenibile e strutturato.

Per vedere come i tool SEO moderni integrano il Latent Semantic Indexing per l’analisi semantica, osserva la dashboard seguente:

Monitoraggio keyword semantiche: metriche da tenere d’occhio

La forza di una strategia SEO basata sul latent semantic indexing non risiede solo nella fase di scrittura, ma soprattutto nella capacità di monitorare l’evoluzione semantica dei contenuti nel tempo. Un contenuto ben ottimizzato oggi può risultare debole domani se il suo campo semantico non viene mantenuto allineato con le query emergenti. Per questo motivo, è essenziale misurare non solo il ranking delle keyword primarie, ma anche il comportamento delle keyword latenti, il loro impatto sul posizionamento e il modo in cui vengono percepite dagli algoritmi.

Tra le metriche più rilevanti da monitorare ci sono la coerenza semantica (semantic consistency), ovvero quanto le keyword utilizzate restano aderenti al tema centrale; la visibilità semantica in SERP (semantic spread), cioè il numero di query correlate che il contenuto intercetta; e il tempo medio di permanenza nei contenuti ottimizzati con keyword LSI. Questi dati aiutano a comprendere quanto il contenuto è rilevante non solo per una query specifica, ma per un intero ecosistema semantico.

In questo contesto, il ruolo dei tool di SEO intelligence è cruciale. Piattaforme come SEOZoom, Semrush e Google Search Console offrono viste aggregate sul rendimento semantico, permettendo di rafforzare o aggiornare l’indice semantico del contenuto in base al comportamento degli utenti e alle evoluzioni dell’algoritmo. In questo modo, il latent semantic indexing diventa una metodologia operativa, capace di guidare l’ottimizzazione con logica predittiva. Ogni aggiornamento diventa una scelta informata, ogni keyword inserita un atto strategico.

Applicazioni reali oltre la SEO

Il latent semantic indexing non è confinato al mondo della SEO. La sua architettura concettuale, basata sulla scomposizione semantica e la mappatura delle relazioni tra termini e significati, si presta a una moltitudine di utilizzi in settori ad alta complessità informativa, dove è fondamentale comprendere, categorizzare e interpretare testi anche in assenza di uniformità linguistica. L’impiego dell’LSI in ambiti come l’eDiscovery giuridico, il summarization automatico, l’analisi documentale aziendale o i sistemi di gestione della conoscenza è già una realtà operativa in molti ambienti produttivi avanzati.

La forza del latent semantic indexing in questi contesti risiede nella sua capacità di identificare tematiche ricorrenti all’interno di documenti disomogenei, riducendo il rumore informativo e portando alla luce strutture concettuali comuni anche in testi scritti in modo diverso. Nei sistemi di eDiscovery, ad esempio, è impiegato per cercare corrispondenze semantiche tra documenti legali, contratti o email, facilitando l’individuazione di prove, pattern o correlazioni che sfuggirebbero a una lettura letterale. Lo stesso avviene nella generazione automatica di riassunti, dove l’LSI contribuisce a selezionare frasi ad alta densità semantica, filtrando le informazioni irrilevanti.

Ciò che rende l’applicazione del latent semantic indexing davvero interessante è la sua versatilità. Può essere integrato in pipeline aziendali per il document tagging, nelle piattaforme AI per la classificazione dei contenuti, nei motori di raccomandazione, o come filtro semantico nei sistemi di accesso alla conoscenza. Non è solo una tecnologia per la SEO: è una grammatica computazionale del significato. E il fatto che sia interpretabile matematicamente lo rende ideale anche per ambienti regolamentati, dove la trasparenza e la ripetibilità dei modelli sono requisiti essenziali.

Come il latent semantic indexing supporta eDiscovery e text summarization

L’ambito dell’eDiscovery è uno dei contesti applicativi più significativi per il latent semantic indexing, poiché richiede una capacità avanzata di esplorare grandi volumi di testo in modo non superficiale. In questo processo, che coinvolge l’analisi automatica di documentazione legale, email aziendali o repository di compliance, la precisione semantica è tutto. LSI consente di identificare contenuti semanticamente simili anche quando non condividono lo stesso lessico, un vantaggio enorme in ambienti dove le parole possono cambiare ma i significati devono essere tracciati.

Attraverso la decomposizione SVD, il modello costruisce una rappresentazione concettuale dei documenti, trasformando ogni testo in un vettore posizionato nello spazio semantico. Questo consente di trovare corrispondenze latenti tra comunicazioni ambigue, vaghe o scritte con formulazioni diverse, ma che veicolano la stessa intenzione o trattano lo stesso argomento. Il risultato è una maggiore efficienza nella selezione dei documenti rilevanti, una riduzione drastica del tempo di revisione manuale e una maggiore accuratezza nelle fasi preliminari dei processi giudiziari.

Nel campo del text summarization automatico, il latent semantic indexing è utilizzato per valutare quali frasi o paragrafi all’interno di un documento contribuiscano in misura maggiore al significato complessivo. L’algoritmo calcola quali segmenti presentano il maggior peso semantico all’interno della struttura latente del testo, restituendo un output che privilegia densità informativa e coerenza tematica. Questo tipo di sintesi è particolarmente utile per report aziendali, analisi tecniche e aggregazioni di notizie, dove la capacità di riassumere senza perdere significato è un vantaggio competitivo reale.

LSI all’interno dei processi intelligenti in azienda

Il latent semantic indexing sta diventando un componente strategico nei processi di gestione della conoscenza aziendale, in particolare in ambienti caratterizzati da grande eterogeneità informativa. Le imprese producono ogni giorno documenti, email, report, contratti, note operative: un universo linguistico che spesso non segue regole formali, ma che veicola informazioni essenziali. Integrare il LSI nei processi aziendali significa trasformare questo patrimonio testuale in un’infrastruttura semantica attiva, capace di rispondere a query complesse, suggerire connessioni nascoste e migliorare il ciclo decisionale.

Attraverso il document tagging automatizzato, il latent semantic indexing permette di etichettare testi con categorie semantiche anche in assenza di segnali espliciti. Questo significa che un documento tecnico su “riduzione del rischio operativo” potrà essere associato automaticamente ai temi “compliance”, “processo” o “normativa”, anche se queste parole non sono direttamente presenti. In una pipeline semantica ben progettata, l’LSI consente di organizzare contenuti in base alla loro coerenza tematica e non alla sola presenza testuale di keyword, offrendo un vantaggio critico in ambito knowledge management.

Nel contesto dell’automazione intelligente, il latent semantic indexing si rivela particolarmente utile nei sistemi di risposta automatica, nei modelli predittivi di comportamento e nei motori di raccomandazione. La sua capacità di mappare significati rende possibile collegare eventi, documenti e flussi di dati in modo più logico, riducendo i colli di bottiglia informativi e migliorando l’efficienza operativa. Per le aziende che lavorano con intelligenza artificiale applicata, l’LSI rappresenta una struttura semantica affidabile, facilmente integrabile e matematicamente tracciabile.

Per comprendere come il Latent Semantic Indexing viene applicato oltre la SEO, osserva la seguente scena d’uso in ambito aziendale e legale:

Metriche di efficacia: recall, precision e cosine similarity

Ogni tecnologia semantica, per poter essere applicata con rigore e continuità, necessita di criteri misurabili. È questo che distingue una suggestione teorica da uno strumento operativo. Il latent semantic indexing, per quanto potente nel costruire spazi concettuali, deve poter dimostrare la propria efficacia nei contesti applicativi, attraverso metriche affidabili che ne validino l’utilizzo. In ambito informativo, giuridico o SEO, le dimensioni fondamentali di questa valutazione sono recall, precision e, nel contesto più strettamente vettoriale, cosine similarity.

Il latent semantic indexing non lavora con le corrispondenze letterali, ma con affinità distribuzionali. Per questo motivo, la precisione del matching non è sempre intuitiva. Serve una valutazione oggettiva della rilevanza semantica restituita rispetto a un set di documenti target. La recall misura la capacità del sistema di trovare tutte le occorrenze semantiche pertinenti, mentre la precision verifica quanto ciò che è stato trovato sia davvero utile. È dalla combinazione di queste due dimensioni che emerge il valore effettivo dell’algoritmo LSI, inteso come strumento di classificazione e recupero del significato.

Nel contesto SEO, applicare il latent semantic indexing implica non solo scrivere contenuti coerenti, ma anche monitorarne la performance semantica. Se un contenuto si posiziona su una keyword ma non intercetta le query correlate, la recall semantica è bassa. Se intercetta molte query ma solo parzialmente pertinenti, la precision è debole. Ecco perché diventa fondamentale misurare le performance del contenuto anche a livello concettuale, e non solo in base al traffico generato. In questa visione, l’LSI non è solo un modello: è un ambiente di verifica semantica continuo.

Precision e recall: quali metriche misurano davvero l’efficacia dell’LSI

Nel valutare l’efficacia del latent semantic indexing, le due metriche più rilevanti sono precision e recall, concetti mutuati dall’information retrieval classico, ma reinterpretati in chiave semantica. La precisione rappresenta la percentuale di risultati semanticamente rilevanti tra quelli individuati dal sistema. In altre parole, misura quanto LSI è selettivo. La recall, invece, indica la capacità di trovare tutti i documenti pertinenti: valuta quanto LSI è completo nel suo recupero semantico. L’equilibrio tra queste due metriche descrive la performance reale del modello.

Quando si applica il latent semantic indexing per l’ottimizzazione dei contenuti, queste metriche diventano fondamentali. Se un contenuto contiene keyword LSI coerenti ma si posiziona solo su una minima parte delle query semanticamente compatibili, significa che la recall è insufficiente. Viceversa, se si posiziona su molte query che portano traffico non qualificato, la precision è compromessa. L’obiettivo deve essere quello di massimizzare entrambe, creando testi che siano semanticamente densi ma anche specifici, evitando generalizzazioni e ambiguità.

Per ottenere questo, è possibile utilizzare strumenti di analisi semantica che calcolano semantic coverage, topic dispersion e query overlap. Ma la metrica più diretta resta la cosine similarity, che misura l’angolo tra i vettori semantici di un documento e quelli delle query target. Più l’angolo è piccolo, maggiore è l’affinità semantica. Questo approccio, integrato con precision e recall, permette di valutare il comportamento del contenuto nel tempo, trasformando l’ottimizzazione SEO in un processo misurabile, basato su evidenze semantiche e non su ipotesi superficiali.

Ambiguità e negazioni: dove il latent semantic indexing può fallire

Nonostante la sua eleganza teorica, il latent semantic indexing non è esente da limiti, specialmente in presenza di ambiguità lessicali o forme negative che alterano la relazione tra parola e significato. LSI, basandosi su co-occorrenze e proiezioni nello spazio semantico, fatica a gestire frasi in cui la negazione rovescia l’intenzione comunicativa. Una frase come “questo prodotto non è utile” può essere semanticamente vicina a “questo prodotto è utile” se il contesto non viene interpretato con sufficiente profondità. Questo è uno dei punti in cui il modello mostra una fragilità strutturale rilevante.

Le ambiguità semantiche, come i termini polisemici, creano un altro punto critico. Se una parola ha più significati a seconda del contesto, LSI può non riuscire a distinguere tra loro. Il problema nasce dal fatto che il modello assegna a ogni parola un’unica rappresentazione vettoriale, ignorando il contesto sintattico e pragmatico. A differenza di modelli più moderni, come BERT, che costruiscono embedding dinamici, il latent semantic indexing opera con rappresentazioni statiche, rendendolo meno adatto a scenari dove il contesto determina il significato.

Questo non implica l’inutilizzabilità del modello, ma ne definisce il campo d’applicazione ottimale. Per contenuti generici o ben strutturati, l’LSI offre ottimi risultati. Ma in testi brevi, ironici, colloquiali o con molte negazioni, la rilevanza semantica può degradare rapidamente. Per ridurre questo rischio, è utile combinare il latent semantic indexing con modelli contestuali, o quantomeno affiancarlo a filtri sintattici in grado di riconoscere inversioni di significato. La precisione semantica, in questi casi, non si costruisce solo con il calcolo, ma con la comprensione attiva della struttura linguistica.

Architettura dei contenuti e SEO semantica

Nel momento in cui si affronta la progettazione di un sito ottimizzato per i motori di ricerca, la struttura dei contenuti diventa un fattore determinante per il successo organico. Non si tratta più di inserire parole chiave all’interno di testi scollegati, ma di costruire un’architettura semantica coerente, in grado di guidare sia l’utente che l’algoritmo verso una comprensione profonda e gerarchica dell’argomento trattato. In questo contesto, il latent semantic indexing non è solo un modello teorico: è la base fondante su cui si costruisce la SEO semantica di nuova generazione.

La capacità del latent semantic indexing di identificare relazioni tra concetti apparentemente distanti permette di progettare contenuti che non siano semplicemente vicini per tema, ma connessi per significato. Questo consente la creazione di strutture basate su nuclei semantici condivisi, capaci di potenziare l’intero ecosistema informativo del sito. Ogni contenuto diventa un nodo in una rete semantica, e l’ottimizzazione avviene non per singolo documento, ma per interconnessione strategica tra argomenti affini. La SEO smette di essere lineare e diventa multidimensionale.

L’implementazione efficace del latent semantic indexing a livello architetturale consente di migliorare il crawl path, rafforzare la rilevanza tematica delle pagine, ridurre la dispersione semantica e aumentare le possibilità di essere posizionati per long-tail e query emergenti. È un processo che va oltre l’ottimizzazione della singola keyword: agisce su entità, topic, relazioni e priorità semantiche, traducendo ogni contenuto in un asset algoritmico. E in uno scenario dove la competizione è ormai semantica, l’architettura del contenuto diventa un vettore strategico di posizionamento.

Creare cluster semantici con LSI e interlinking tematico

La creazione di cluster semantici rappresenta una delle applicazioni più concrete del latent semantic indexing nella SEO avanzata. Un cluster non è una semplice raccolta di articoli correlati: è una struttura logica fondata sulla coerenza semantica, dove ogni contenuto rafforza gli altri attraverso un reticolo di significati condivisi. Il latent semantic indexing permette di identificare quali contenuti abbiano una base concettuale comune, anche in assenza di keyword evidenti, creando così un sistema informativo coerente, navigabile e ottimizzato per l’intento dell’utente.

L’interlinking tematico non può essere lasciato al caso. Ogni collegamento tra contenuti deve rispecchiare una relazione semantica autentica, e non solo un’affinità superficiale. Utilizzare le proiezioni vettoriali offerte dal latent semantic indexing consente di capire quali articoli appartengano allo stesso asse concettuale, e quindi vadano raggruppati in un silo logico. Questo approccio permette non solo di migliorare la navigazione, ma di guidare l’algoritmo verso una comprensione profonda dell’organizzazione del sito, facilitando l’indicizzazione e il posizionamento per query complesse.

Il valore di questa strategia emerge nella capacità di scalare la visibilità del sito su un’intera area tematica. Non si posiziona più solo una pagina, ma un sistema semantico interconnesso, in cui ogni contenuto svolge una funzione precisa all’interno di una rete ottimizzata. Il latent semantic indexing, in questo contesto, diventa una mappa per la costruzione di strutture SEO resilienti, che resistono agli aggiornamenti di algoritmo e si adattano alla dinamicità della domanda informativa online. È l’equilibrio tra architettura logica e significato distribuito a definire la forza del posizionamento.

Schema markup per entità correlate e FAQ semantiche

L’efficacia del latent semantic indexing può essere amplificata quando si integra con tecniche di schema markup avanzato, in particolare per la dichiarazione di entità correlate e la costruzione di FAQ semanticamente arricchite. Il markup strutturato non è solo un supporto alla visualizzazione nei risultati di ricerca: è un linguaggio con cui si comunica direttamente con l’algoritmo. Dichiarare le entità chiave attraverso JSON-LD consente ai motori di ricerca di riconoscere la struttura concettuale del contenuto, rafforzando la pertinenza semantica e migliorando la qualità del matching informativo.

L’uso delle proprietà mainEntity, about, mentions o knowsAbout permette di specificare la relazione semantica tra il contenuto e le entità esterne, collegando ogni pagina a un campo semantico esplicito e strutturato. Questo è particolarmente potente quando applicato a contenuti ottimizzati secondo i principi del latent semantic indexing, perché permette di trasformare la coerenza semantica interna in segnali machine-readable che migliorano l’indicizzazione e la classificazione nei knowledge graph.

Allo stesso modo, la sezione FAQ può essere progettata come un’estensione del campo semantico, non come semplice aggiunta. Le domande frequenti devono riflettere le query latenti identificate attraverso l’analisi semantica e rispondere con precisione, arricchendo ulteriormente il contesto del contenuto. Il latent semantic indexing guida la selezione delle domande più coerenti e significative, mentre lo schema markup ne amplifica la visibilità. Il risultato è un contenuto che non solo comunica, ma si fa comprendere, entrando in sintonia con l’algoritmo e anticipando l’intento dell’utente.

Tutti i concetti, le relazioni e i significati distribuiti che abbiamo esplorato trovano rappresentazione visiva nella seguente rete neurale semantica costruita secondo i principi del Latent Semantic Indexing:

Riepilogo strategico: valore a lungo termine del Latent Semantic Indexing

L’intero percorso di analisi, confronto e applicazione del latent semantic indexing restituisce una certezza fondamentale: la semantica non è un’opzione, ma una condizione strutturale dell’ottimizzazione moderna. Dalle origini teoriche legate alla scomposizione SVD, alle evoluzioni che l’hanno portato a confrontarsi con modelli neurali, fino alle applicazioni in ambito SEO, giuridico, aziendale, il latent semantic indexing ha dimostrato una solidità concettuale e una versatilità applicativa che ne fanno ancora oggi uno strumento di valore strategico.

Chi lavora con i contenuti e desidera dominarne l’impatto nel tempo non può ignorare la necessità di andare oltre la keyword apparente e costruire un campo semantico articolato, coerente e misurabile. Il latent semantic indexing offre la possibilità concreta di mappare il significato, creare connessioni nascoste, rafforzare la rilevanza e incrementare il posizionamento organico in modo distribuito e duraturo. La sua forza non sta nella sua storicità, ma nella capacità di adattarsi ai nuovi paradigmi, integrandosi perfettamente con modelli NLP moderni, tecniche di structured data e strategie di content clustering avanzato.

Il futuro della SEO, come quello della gestione documentale e dell’intelligenza informativa, richiede architetture semantiche flessibili e costantemente aggiornate. È qui che il latent semantic indexing, affiancato da strumenti di analisi predittiva e sistemi di monitoring semantico, dimostra il suo valore a lungo termine. La sua interpretabilità, la sua matematica esplicita e la sua capacità di essere monitorato ne fanno un alleato stabile per ogni strategia SEO evoluta, ma anche per ogni ecosistema informativo che voglia essere leggibile, rilevante e competitivo.

Scegliere di adottare il latent semantic indexing non significa solo ottimizzare un contenuto, ma entrare in una logica progettuale diversa, in cui il significato è il perno dell’intero processo. In un’epoca in cui ogni dato testuale è interrogato, collegato, valutato semanticamente, avere una struttura in grado di organizzare, spiegare e prevedere il comportamento delle keyword rappresenta un vantaggio reale, concreto, misurabile. E quando il contenuto smette di essere scritto per piacere all’algoritmo e inizia a dialogare con esso, il risultato non è solo più ranking: è più comprensione, più durata, più autorevolezza.

Domande frequenti sul Latent Semantic Indexing

❓Cos’è il latent semantic indexing e a cosa serve nella SEO?

Il latent semantic indexing è una tecnica matematica basata su decomposizione SVD e analisi dei significati nascosti all’interno dei testi. Nella SEO moderna, viene utilizzato per individuare keyword correlate, migliorare la pertinenza semantica e aumentare la visibilità nei motori di ricerca grazie alla comprensione profonda del contenuto.

Le keyword LSI sono ancora utili per il posizionamento?

Sì, le keyword LSI sono ancora strategicamente rilevanti, anche se oggi vanno interpretate come parte di una più ampia semantic keyword strategy. L’uso intelligente di queste keyword aiuta a costruire contenuti completi e rilevanti che rispondono meglio agli intenti di ricerca, migliorando CTR e ranking organico.

❓Qual è la differenza tra latent semantic indexing e semantic hashing?

Il latent semantic indexing si basa su analisi matematica del significato, mentre il semantic hashing punta a un recupero rapido attraverso codifiche binarie. LSI offre maggior precisione semantica, mentre l’hashing è più veloce ma meno accurato nei contesti complessi. Entrambi possono essere utili, ma con obiettivi differenti.

❓Come si usano le keyword semantiche in un articolo SEO?

Per integrare correttamente keyword semantiche e latent semantic indexing keywords, occorre inserirle naturalmente nei testi, mantenendo una struttura coerente. Vanno distribuite in modo contestuale, sfruttando clustering semantico, interlinking tematico e, se possibile, markup strutturato come FAQ, HowTo e mainEntity.

❓Il latent semantic indexing è compatibile con l’intelligenza artificiale moderna?

Sì, molte tecnologie attuali, come i modelli transformer o gli embedding contestuali, incorporano concetti derivati dal latent semantic indexing. Anche se superato da modelli più sofisticati in certi ambiti, LSI è ancora utilizzato in sistemi intelligenti aziendali, ediscovery, text mining e processi di semantic retrieval.

❓Quali sono i migliori strumenti per trovare keyword LSI?

Tra i migliori tool per identificare keyword LSI troviamo LSIGraph, SurferSEO, Ahrefs e Keyword Cupid. Questi strumenti utilizzano approcci basati su latent semantic indexing, co-occorrenze e analisi della SERP per generare liste di keyword correlate semanticamente e con alto potenziale di posizionamento

❓Qual è la metrica migliore per valutare l’efficacia dell’LSI?

Le metriche più usate sono precision, recall e cosine similarity. In ambito SEO, l’efficacia dell’LSI si misura anche attraverso aumento di rilevanza semantica, riduzione del bounce rate, miglioramento del CTR e posizionamento stabile delle pagine ottimizzate.