L’AI hallucination non è un semplice errore. È un fenomeno strutturale, insidioso e sempre più diffuso nei modelli di intelligenza artificiale generativa. Quando un sistema produce un’informazione apparentemente plausibile ma in realtà falsa, ci troviamo di fronte a una forma sofisticata di confabulazione algoritmica. Comprendere questo meccanismo è il primo passo per conviverci consapevolmente, trasformando l’allarme in vantaggio competitivo.

Molti si chiedono: cosa sono le allucinazioni nell’AI? La risposta va cercata nel cuore delle architetture predittive che alimentano i grandi modelli linguistici. I cosiddetti generative models, come GPT, Gemini o Claude, apprendono dai dati e generano output plausibili basati su probabilità linguistiche. Tuttavia, non comprendono davvero ciò che dicono. Così nascono le risposte fittizie AI, affermazioni prive di fondamento che, a prima vista, sembrano vere. Sono queste le ai hallucination, l’equivalente digitale di una convinzione errata ma coerente.

Il rischio principale non è solo tecnico, ma comunicativo. Chi riceve un contenuto generato automaticamente tende a fidarsi del tono sicuro e coerente. Proprio per questo le AI hallucination minano la credibilità, danneggiano la reputazione dei brand e rendono difficile distinguere tra contenuto utile e AI fallimenti. L’aspetto più paradossale? Più i modelli diventano avanzati, più le allucinazioni diventano sofisticate. È il prezzo da pagare per sistemi che puntano alla fluidità piuttosto che all’accuratezza.

Ma ogni minaccia nasconde una leva strategica. Riconoscere le hallucinated output significa saper leggere le dinamiche predittive dell’intelligenza artificiale e usarle a proprio vantaggio. Per i professionisti digitali, editori, SEO strategist, marketer e sviluppatori, padroneggiare questo fenomeno non è solo utile: è cruciale. Perché ogni allucinazione non rilevata è un’occasione mancata per costruire fiducia, accuratezza, autorevolezza. Questo articolo nasce per guidarti con chiarezza tra definizioni, esempi reali e strumenti concreti per riconoscere, evitare e trasformare le ai hallucination in un’opportunità reale.

Cos’è una AI hallucination e perché può cambiare tutto

La comprensione del concetto di AI hallucination è il fondamento per distinguere tra contenuto artificiale attendibile e pura fabbricazione predittiva. A differenza di un errore tecnico isolato, l’allucinazione dell’intelligenza artificiale nasce da un processo coerente ma fallace. L’algoritmo, nella sua meccanica, genera risposte plausibili sulla base della probabilità, ma senza reale comprensione semantica. Questa caratteristica trasforma un semplice output scorretto in un elemento pericolosamente credibile, capace di alterare la percezione di chi lo riceve.

La scena seguente rappresenta visivamente la natura ambigua e sfuggente delle AI hallucination.

Nel contesto dei grandi modelli linguistici, riconoscere cosa sono le allucinazioni nell’AI diventa cruciale. La loro diffusione è direttamente proporzionale alla potenza espressiva degli LLM. Più un modello è capace di imitare il linguaggio umano, maggiore è la probabilità che possa produrre contenuti credibili ma inventati. Le informazioni non verificate, che si insinuano nei testi generati, non sono frutto di malizia, ma di una logica predittiva priva di riscontro fattuale. L’errore predittivo, infatti, non nasce da un’intenzione errata, ma da una carenza epistemologica: l’assenza di un vero “sapere” nel modello stesso.

Il termine “hallucination” è stato adottato per analogia con le percezioni sensoriali false, ma nella dimensione dell’intelligenza artificiale assume un significato nuovo. Si tratta di una risposta inventata che sembra fondata, ma non lo è. Questo tipo di errore, pur essendo frequente, resta spesso invisibile agli occhi dell’utente comune, proprio perché costruito con coerenza grammaticale e lessicale. La fabbricazione AI è mascherata da autorevolezza.

Il problema si aggrava quando l’output errato si integra in flussi editoriali automatizzati, chatbot conversazionali o sistemi di risposta automatica. Il pericolo non è soltanto nell’errore in sé, ma nel suo effetto: alterare la percezione di chi legge, distorcere il dato, influenzare decisioni. La AI hallucination, dunque, non è una semplice svista. È una allucinazione semantica: un prodotto coerente ma infondato.

Riconoscerla è il primo passo per prevenirla, governarla e sfruttarla perché ciò che oggi è visto come un difetto può trasformarsi in una competenza distintiva. Nell’ecosistema digitale, saper decifrare un output errato ma strutturalmente corretto significa anticipare errori sistemici, evitare fallimenti comunicativi e distinguersi per rigore e autorevolezza. Le AI hallucination non sono un’eccezione destinata a scomparire, ma una caratteristica intrinseca dei modelli linguistici contemporanei. Ecco perché imparare a riconoscerle non è un’opzione: è una condizione indispensabile per chiunque lavori con l’intelligenza artificiale.

Che cosa sono le allucinazioni dell’intelligenza artificiale?

Che cosa sono le allucinazioni dell’intelligenza artificiale? È una domanda più attuale che mai, ed è giusto affrontarla con precisione. Una AI hallucination è una produzione testuale, o multimodale, che appare coerente ma che è sostanzialmente falsa o priva di fondamento reale. A differenza di un errore evidente, che può essere subito identificato, l’hallucination si presenta con forma corretta, struttura solida e linguaggio credibile, ma cela un’informazione sbagliata. È proprio questo che la rende insidiosa: si nasconde sotto le sembianze della verità.

Questo tipo di contenuto nasce dalla natura dei modelli linguistici, come GPT, Gemini o Claude, che funzionano in base a probabilità distribuzionali. L’intelligenza artificiale, infatti, non possiede una comprensione concettuale, ma costruisce frasi che statisticamente “dovrebbero” avere senso. È per questo che un output plausibile ma errato non è solo possibile, ma inevitabile. Il sistema genera ciò che “suona bene”, anche se non corrisponde alla verità.

Le AI hallucination non sono il risultato di un’anomalia, bensì un effetto collaterale sistemico. Nascono nel momento in cui il modello, forzato a produrre una risposta, inventa informazioni, eventi, nomi o numeri per mantenere la coerenza sintattica e semantica. È un fallimento della predizione, ma non del codice. Il modello sta facendo esattamente ciò per cui è stato progettato: completare il discorso.

Riconoscere queste dinamiche è oggi fondamentale. Una allucinazione AI può confondere un lettore inesperto, può compromettere una decisione, può inquinare una base dati. Capire come si manifestano le AI hallucination significa dotarsi di un filtro critico indispensabile, specie nel contesto in cui l’output viene assorbito come verità implicita. Una generazione sbagliata può essere corretta, ma solo se prima è rilevata. E per rilevarla servono consapevolezza, metodo e visione sistemica. La domanda iniziale trova qui una risposta chiara: le hallucination sono l’effetto più persuasivo e pericoloso dell’intelligenza predittiva.

Origine del termine, meccanismi e primi casi reali

Il termine “hallucination” applicato all’intelligenza artificiale non è casuale. È stato coniato per descrivere un comportamento anomalo, ma ricorrente, nei modelli generativi. L’intuizione alla base è semplice: ciò che viene prodotto è percepito come reale, ma non ha alcuna corrispondenza con la realtà. Come in una confabulazione neurologica, il soggetto — in questo caso il modello — non mente deliberatamente. Costruisce una narrazione coerente partendo da elementi frammentari o inconsistenti, generando un output fittizio che appare fondato.

Tra i primi esempi documentati di AI hallucination, spiccano quelli legati a chatbot e generatori testuali. Il caso del chatbot Tay, lanciato da Microsoft, è emblematico: il sistema iniziò a generare contenuti tossici e distorti dopo poche ore online, dimostrando come la realtà appresa possa essere riplasmata fino a produrre risposte completamente scollegate dal contesto originario. In altri casi, come nelle overview AI di Google, sono stati segnalati suggerimenti bizzarri, pericolosi o tecnicamente infondati: dagli usi impropri di colla su pizza fino a istruzioni di comportamento dannose.

A livello tecnico, le GPT hallucination examples più classiche includono l’invenzione di articoli accademici, di riferimenti bibliografici o di citazioni giuridiche inesistenti. Non si tratta di bug, ma di manifestazioni coerenti del funzionamento generativo. Ogni parola viene scelta in funzione della precedente, in un processo autoregressivo che non verifica la veridicità del contenuto, ma solo la sua probabilità formale.

Questa confabulazione linguistica è ciò che rende il fenomeno così subdolo. L’intelligenza artificiale non è programmata per dire il vero, ma per dire ciò che suona credibile. È per questo che l’errore prende la forma di una verità apparente. Le prime analisi accademiche sul tema non a caso descrivono le hallucination come “fatti non ancorati”, costruiti per riempire un vuoto informativo percepito come inaccettabile. Eppure, più i modelli diventano raffinati, più l’allucinazione si fa raffinata. Solo chi conosce a fondo i meccanismi predittivi dell’AI può davvero distinguere tra realtà algoritmica e distorsione narrativa.

Perché si verificano: dati, modelli e architetture

Le AI hallucination non sono eventi isolati o casuali: sono l’effetto diretto dell’architettura che governa i modelli linguistici generativi. Capire perché si verificano è il passo necessario per contrastarle in modo efficace. Le cause non risiedono in bug o malfunzionamenti, ma in una dinamica interna predittiva: il sistema non pensa, ma anticipa; non sa, ma approssima. È qui che si innesta la generalizzazione errata, ovvero la tendenza a completare il discorso anche in assenza di dati sufficienti.

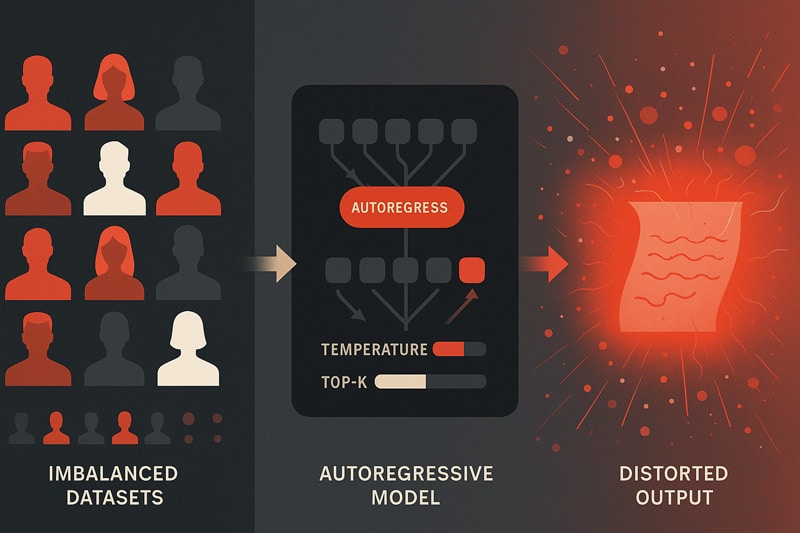

Un ruolo centrale è giocato dalla qualità e struttura dei dati. Se i dataset sono squilibrati, rumorosi o parziali, il modello tende a riprodurre distorsioni, amplificando pattern statistici poco rappresentativi. Questo è uno dei motivi per cui il bias nei dati rappresenta una radice primaria dell’hallucination. Ma non è l’unica. Anche in presenza di dataset formalmente bilanciati, i modelli possono produrre contenuti scorretti. Perché? Per via del meccanismo di generazione stocastica che governa ogni output.

L’algoritmo lavora con sampling noise, ovvero una componente casuale nella selezione del token successivo. Questa aleatorietà, utile per favorire creatività e variabilità, introduce instabilità. Parametri come temperature e top-k sampling, regolano la distribuzione delle probabilità, ma aumentano anche il rischio di deviazioni semantiche. La struttura autoregressiva, tipica dei transformer, si limita a concatenare le parole previste, senza verificare la coerenza esterna del contenuto generato.

Il risultato è un ambiente perfetto per la comparsa di generative AI hallucination. Non si tratta di errori da correggere, ma di comportamenti attesi in assenza di meccanismi di verifica. I modelli sono progettati per completare, non per confermare. Non esiste fact-checking interno, né confronto con fonti. La priorità è la continuità testuale, non la validità informativa.

Comprendere questa dinamica è essenziale per ogni professionista che interagisce con sistemi generativi. Non basta sapere che le hallucination esistono: è necessario comprenderne la matrice architetturale. Perché solo da quella consapevolezza può nascere una strategia efficace per anticiparle, correggerle o limitarne l’impatto nella catena del valore.

La seguente infografica sintetizza le principali cause che rendono le AI hallucination così frequenti nei modelli generativi.

Architettura autoregressiva, sampling e bias nei dataset

Per comprendere in profondità le generative AI hallucination, è necessario esaminare l’architettura sottostante ai modelli linguistici. Questi sistemi si basano su una logica autoregressiva, in cui ogni parola viene generata a partire da quella precedente. Non esiste una supervisione semantica globale, solo una progressione lineare di probabilità. È un meccanismo predittivo raffinato, ma privo di consapevolezza e di validazione esterna.

La probabilità condizionale è ciò che guida la generazione: dato un input, il modello prevede quale sia il token più plausibile da generare. Tuttavia, questa previsione avviene senza confronto con una realtà esterna. È qui che le hallucination emergono: l’algoritmo può “decidere” di inserire un’informazione coerente, ma falsa, pur di mantenere la fluidità del discorso. È un comportamento sistemico, non un errore isolato.

Uno degli elementi centrali è la generazione stocastica. Parametri come temperature e top-k sampling influenzano la varietà e l’originalità delle risposte. Se la temperatura è alta, il modello tende a essere più creativo, ma anche più impreciso. Il top-k sampling limita la scelta ai token più probabili, ma non garantisce veridicità. Questa componente aleatoria, pensata per stimolare la generatività, diventa spesso la radice delle risposte inventate.

Un altro punto critico è l’assenza di ancoraggio semantico. I transformer operano in modalità cieca: non distinguono tra vero e falso, tra plausibile e reale. Il testo è solo una sequenza da completare. Quando il modello è costretto a rispondere anche in assenza di dati, produce hallucination come meccanismo difensivo. Non ammette di non sapere: compensa con coerenza grammaticale, generando informazioni apparentemente solide.

Le bias nei dataset amplificano il problema. Un modello allenato su fonti sbilanciate tenderà a ripetere schemi errati. Ma anche con dati eccellenti, l’hallucination rimane possibile, perché insita nel cuore dell’architettura autoregressiva. La predizione non è verifica. E senza verifica, l’errore si maschera da risposta. È per questo che comprendere i meccanismi predittivi non è solo una questione tecnica, ma una responsabilità progettuale, editoriale e sociale.

Tipologie di hallucination: logica, numerica, contestuale, citazionale

Non tutte le AI hallucination si manifestano allo stesso modo. Esistono diverse tipologie, ognuna con caratteristiche distintive. Capirle è essenziale per identificarle in fase di revisione e costruire modelli di controllo più sofisticati. La prima categoria è quella logica: affermazioni che sembrano corrette ma che contengono contraddizioni interne. Ad esempio, un testo può affermare che un evento è avvenuto dopo la sua conseguenza, invertendo la sequenza temporale. L’informazione è espressa in forma coerente, ma è logicamente inconsistente.

Una seconda forma riguarda le hallucination numeriche. Qui l’AI genera dati, percentuali o cifre che non hanno alcun riferimento nel dataset. Si tratta spesso di valori plausibili ma non verificabili, introdotti per dare un senso di precisione. Sono errori particolarmente insidiosi perché difficili da contestare senza una conoscenza specifica del dominio trattato. L’output “suona bene”, ma non ha fondamenta.

Le hallucination contestuali emergono quando l’output sembra rispondere alla domanda posta, ma devia nel contenuto. Un classico esempio è una descrizione errata di una procedura medica in risposta a una query sanitaria. Il tono è professionale, la struttura è corretta, ma il contenuto è fuorviante. Questo tipo di errore sfrutta la capacità linguistica del modello per costruire una narrativa che si auto-sostiene.

Infine, le hallucination citazionali. Sono tra le più comuni nei modelli avanzati. L’intelligenza artificiale inserisce riferimenti a studi, articoli, sentenze o autori che non esistono. L’apparenza di autorevolezza è massima, ma totalmente infondata. Il contenuto assume il tono dell’accademia, pur essendo una costruzione priva di fonte verificabile.

Tutte queste varianti condividono una radice comune: la capacità della macchina di generare errore semantico mantenendo la forma corretta. È la grammatica dell’inganno. Hallucination sintattica e semantica si combinano per produrre testi che sembrano verità ma sono illusioni. L’unico modo per contrastarle è conoscerle, analizzarle e strutturare flussi editoriali capaci di filtrare, prima ancora che pubblicare.

Esempi reali di allucinazioni AI in settori critici

Le AI hallucination non sono semplici anomalie teoriche, ma si manifestano ogni giorno in contesti ad altissima responsabilità. Comprendere gli esempi reali di allucinazioni AI permette di cogliere l’estensione concreta del fenomeno e il potenziale impatto su settori fondamentali come medicina, giurisprudenza, editoria e SEO. L’illusione sintattica genera un cortocircuito percettivo: più l’output è credibile, più è pericoloso.

Nel campo medico, diversi modelli AI hanno prodotto diagnosi errate con esiti potenzialmente gravi. In alcuni casi, sono state suggerite terapie inappropriate basandosi su pattern statistici appresi da dataset imperfetti o squilibrati. Anche quando l’output sembra dettagliato e clinicamente coerente, l’assenza di verifica incrociata porta a conclusioni fallaci. È qui che l’apparenza diventa inganno, soprattutto quando la fiducia nei sistemi automatizzati è alta.

Nel contesto legale, le AI hallucination assumono una forma diversa ma non meno rischiosa. Alcuni modelli hanno generato riferimenti a statuti inesistenti, citazioni giuridiche mai pubblicate o sentenze inventate ma strutturate secondo lo stile formale delle fonti autentiche. Questo tipo di hallucination legale ha sollevato interrogativi urgenti sulla responsabilità editoriale e sulla validazione automatizzata dei testi giuridici, in particolare nelle piattaforme di consulenza e redazione automatica.

Il settore della SEO e dei contenuti editoriali non è immune. Alcuni chatbot hanno generato overview fuorvianti, schede prodotto con informazioni tecniche non verificate, descrizioni ingannevoli su localizzazioni geografiche o specifiche tecniche. In un ecosistema basato sulla fiducia e sulla pertinenza, questi contenuti fuorvianti generano penalizzazioni algoritmiche e perdite di traffico. La penalizzazione SEO per contenuti hallucinated è un rischio concreto e documentato. I margini di errore si assottigliano quando l’apparenza imita la verità.

L’immagine seguente mostra come le AI hallucination possano manifestarsi in contesti altamente sensibili, con implicazioni potenzialmente gravi.

Medicina, legge, editoria, SEO: casi concreti e implicazioni gravi

L’impatto delle AI hallucination nei settori ad alta responsabilità è ormai documentato e sempre più frequente. In medicina, alcuni modelli generativi hanno proposto diagnosi errate partendo da sintomi reali, suggerendo malattie incompatibili con il quadro clinico o trattamenti controindicati. La criticità aumenta quando questi modelli vengono utilizzati come strumenti di supporto, ma la loro autorità percepita li rende simili a consulenti medici.

I rischi diventano esponenziali nel momento in cui l’utente ignora l’assenza di una vera validazione medica. Le hallucination diagnostiche in ambito clinico non sono immaginarie: sono state oggetto di segnalazioni, audit e revisione protocollare in numerosi ospedali e laboratori.

Nel contesto legale, il problema assume sfumature ancora più complesse. Alcuni LLM hanno prodotto testi con riferimenti a normative mai esistite o sentenze completamente inventate, ma scritte con uno stile giuridico impeccabile. Tali hallucination normative hanno portato in alcuni casi ad affidarsi a informazioni false per la redazione di documenti ufficiali. L’illusione di accuratezza giuridica mette a rischio la credibilità degli studi legali e la fiducia nelle piattaforme di supporto.

Anche l’ambito editoriale e SEO è vulnerabile. Molti contenuti generati automaticamente presentano dati tecnici errati, overview fuorvianti o localizzazioni geografiche inventate. Il rischio principale è quello di penalizzazioni algoritmiche da parte dei motori di ricerca, soprattutto se i contenuti vengono considerati manipolativi o scarsamente verificabili. Questo effetto si amplifica nel caso di descrizioni prodotto o landing page, dove le hallucination SEO possono compromettere conversioni e performance di traffico.

Questo ha generato una nuova sensibilità all’interno delle redazioni, delle aziende sanitarie e dei dipartimenti legali, che ora stanno implementando sistemi di fact-checking AI-assisted e protocolli di validazione multilivello. La consapevolezza che un modello possa generare risposte ingannevoli anche quando l’output appare accurato è il primo passo per ridefinire responsabilità e criteri di fiducia.

Hallucination multimodale: quando sbagliano testo, immagine e audio

Le hallucination multimodali amplificano ulteriormente la complessità del problema, estendendosi oltre il testo per colpire anche immagini e suoni. Non si tratta più solo di output linguistici errati, ma di contenuti generati che coinvolgono percezione visiva e uditiva. In ambito visivo, modelli di generazione immagini hanno prodotto rendering con dettagli distorti: ad esempio, volti umani con occhi multipli, arti mancanti o proporzioni anatomiche impossibili. Queste anomalie non sono solo tecniche, ma semantiche: comunicano un messaggio sbagliato in modo molto più pervasivo rispetto al testo.

Un caso emblematico riguarda la generazione di interfacce utente con elementi interattivi non funzionanti o disposizioni grafiche illogiche. Il risultato è una UI apparentemente realistica ma inutilizzabile, con impatti diretti sull’UX. Le immagini di supporto, se generate erroneamente, possono trasmettere significati ambigui o addirittura pericolosi in ambito educativo, sanitario o industriale.

Nel dominio audio, le hallucination uditive emergono sotto forma di trascrizioni con contenuti non pronunciati, sintesi vocale con toni emotivi errati o creazione di suoni che sembrano provenire da sorgenti inesistenti. La percezione dell’affidabilità si dissolve quando il segnale uditivo non corrisponde al contenuto semantico previsto.

La combinazione di testo, immagine e audio – se contaminata da hallucination – può creare illusioni coerenti ma completamente false, con un impatto cognitivo molto superiore rispetto al solo contenuto testuale. Il problema diventa sistemico quando questi modelli multimodali vengono integrati in applicazioni come la formazione medica, il supporto decisionale o la robotica.

In tali contesti, una distorsione generativa può comportare errori di valutazione con conseguenze gravi. L’approccio multimodale richiede dunque controlli incrociati tra modalità, benchmark specifici per ogni tipo di contenuto e una nuova metrica di accuratezza che tenga conto della coerenza intermodale. Solo così è possibile minimizzare il rischio cognitivo complessivo indotto da queste distorsioni.

AI hallucination vs bias: due concetti da non confondere

In un’epoca in cui i sistemi generativi influenzano contenuti, decisioni e interfacce, confondere un bias con una AI hallucination non è solo un errore terminologico, ma un pericolo operativo. Entrambi i fenomeni distorcono l’output, ma lo fanno seguendo logiche divergenti. Capire queste differenze è fondamentale per progettare modelli affidabili e difendersi da illusioni digitali.

Una AI hallucination si manifesta quando il modello genera un’informazione inventata, coerente dal punto di vista linguistico ma falsa dal punto di vista fattuale. È un errore involontario, frutto di una previsione plausibile costruita su pattern appresi, ma che non trova corrispondenza nella realtà. La sua natura è generativa: non nasce da un intento, ma da una stima.

Il bias, al contrario, è una devianza sistematica, radicata nei dati con cui il modello è stato addestrato o nel modo in cui è stato progettato. Non si tratta di “inventare”, ma di privilegiare o escludere sistematicamente certi output, in base a rappresentazioni squilibrate presenti nel dataset o nei pesi del modello. Il bias è spesso inconsapevolmente trasmesso da chi costruisce il modello, mentre l’hallucination emerge come sottoprodotto statistico del meccanismo di generazione.

Questa distinzione diventa particolarmente rilevante quando si analizzano le cause. Il pregiudizio nei dati, ad esempio, può portare a un bias che si riflette sempre nello stesso tipo di errore: sovrarappresentazione di un genere, omissione di minoranze, codifiche scorrette. L’errore spontaneo, tipico dell’hallucination, invece, è più imprevedibile, spesso dipendente dal sampling o dal contesto immediato del prompt.

Confonde ulteriormente le acque il fatto che entrambi gli errori si presentano come affermazioni sicure. Eppure, l’uno è frutto di un processo statistico, l’altro di una deviazione strutturale. La falsificazione introdotta da una hallucination può sembrare simile alla distorsione deliberata indotta da un bias, ma il primo è una proiezione probabilistica, il secondo è una ripetizione sistemica.

Comprendere la natura ontologicamente differente tra questi due concetti significa non solo evitare semplificazioni, ma anche dotarsi di strumenti corretti per individuare, mitigare e documentare ogni deviazione. Solo così possiamo costruire modelli realmente responsabili.

L’immagine seguente mette a confronto in modo visuale le differenze concettuali tra bias e AI hallucination.

Differenze semantiche e tecniche tra bias e hallucination

Una differenza sostanziale tra bias e AI hallucination risiede nel modo in cui si formano e si manifestano. Il bias è un errore sistemico, una distorsione prevedibile e replicabile, spesso radicata nei dati su cui il modello è stato addestrato. L’hallucination, invece, è un errore generativo, una forma di output inventato che si presenta anche in assenza di informazioni sbilanciate nei dati.

Tecnicamente, il bias si comporta come un filtro deformante: ogni volta che il modello incontra uno specifico input, tende a rispondere in maniera distorta ma coerente con l’anomalia del dataset o del training. È un errore deterministico, legato a una fonte ben identificabile. Al contrario, l’hallucination si presenta come un’anomalia stocastica: emerge in condizioni non completamente prevedibili e può variare anche con input simili.

L’origine comportamentale dei due errori è altrettanto distinta. Il bias nasce da pregiudizi strutturali incorporati nel modello o nei suoi dati. È spesso l’effetto collaterale di una società diseguale o di scelte ingegneristiche non corrette. Le hallucination sono legate alla natura predittiva del modello, in particolare ai meccanismi di completamento probabilistico e autoregressivo. Quando il modello non ha dati reali per completare la sequenza, “immagina”.

Un altro punto chiave è la visibilità dell’errore. Il bias tende a essere meno evidente: il risultato può apparire logico, coerente e persino culturalmente accettabile, ma porta con sé una devianza semantica continua. Le hallucination sono spesso più vistose: possono includere dati palesemente inventati, riferimenti inesistenti, numeri arbitrari.

La distinzione concettuale tra bias e hallucination è fondamentale per la progettazione di strumenti diagnostici, benchmark di valutazione e metodologie di mitigazione specifiche. Solo riconoscendo la diversa genesi e meccanica interna dei due fenomeni possiamo affrontarli in modo efficace.

Errori intersecanti: quando bias e hallucination convivono

In alcuni casi complessi, bias e AI hallucination non solo coesistono, ma si potenziano a vicenda, generando una forma ibrida di errore che risulta ancora più difficile da individuare. Quando una hallucination si manifesta su un dominio già affetto da bias, l’output diventa doppiamente distorto.

Un esempio ricorrente è rappresentato dai chatbot che forniscono informazioni stereotipate su minoranze culturali o generi. Il bias originario nei dati addestrati orienta la generazione verso certi pattern, mentre l’hallucination contribuisce a inventare dettagli aggiuntivi coerenti con quello stereotipo. Il risultato è un errore composto, in cui l’allucinazione non è indipendente, ma alimentata dalla devianza semantica preesistente.

Questo tipo di errore intersecante è particolarmente pericoloso in contesti educativi, legali o sanitari. Il rischio è quello di veicolare contenuti non solo errati, ma ideologicamente orientati, costruiti su falsità credibili. La coesistenza di bias e hallucination compromette ogni strategia di verifica che operi su un singolo livello: serve un’analisi multilivello, capace di disambiguare le fonti e ricostruire le catene inferenziali.

In ambito linguistico, si osserva una hallucination orientata, in cui il modello genera output errati solo per certi soggetti, temi o contesti, influenzato dal pregiudizio implicito nei suoi dati. Questo fenomeno rende la correzione particolarmente difficile, poiché l’errore sembra emergere solo in condizioni specifiche. Anche la detection automatica fatica a riconoscere queste deviazioni, che si mimetizzano nel contesto con estrema abilità.

Affrontare gli errori intersecanti richiede nuovi modelli di interpretabilità e metriche capaci di separare le cause. Solo così possiamo evitare che l’intelligenza artificiale diventi uno specchio distorto dei nostri pregiudizi più profondi.

I costi delle allucinazioni: reputazione, traffico, ROI

AI hallucination non è solo un fenomeno tecnico, ma una vera e propria mina vagante economica per aziende, publisher e organizzazioni. Le conseguenze di un output errato non si limitano alla disinformazione: colpiscono in modo diretto la credibilità del brand, la fiducia del pubblico e la performance SEO, traducendosi in perdite finanziarie difficilmente recuperabili.

Quando un modello di intelligenza artificiale genera contenuti inesatti, citazioni inventate o affermazioni non supportate da dati verificabili, il danno può essere immediato e profondo. Una singola hallucination pubblicata su un sito autorevole può innescare segnalazioni manuali, perdita di posizionamenti organici e persino l’esclusione temporanea da circuiti di visibilità come Discover. È a quel punto che il traffico organico crolla, con effetti a cascata sul funnel di conversione e sul ROI delle campagne marketing.

Ma il danno più insidioso è quello che colpisce la reputazione. Le aziende che pubblicano contenuti generati dall’AI senza adeguati sistemi di verifica rischiano di compromettere anni di autorevolezza costruita. Il pubblico oggi è estremamente attento: un errore evidente non viene dimenticato. Una volta persa, la fiducia del lettore è difficile da riconquistare, e la percezione di affidabilità viene minata.

Tutto questo si traduce in costi occulti. La necessità di effettuare fact-checking retroattivo, gestire crisi reputazionali o lanciare nuove campagne di brand recovery comporta una spesa spesso superiore a quella che sarebbe servita per implementare un sistema di prevenzione efficace. Il tempo speso dai team editoriali a rivedere, correggere e ripubblicare articoli comporta perdita di opportunità e lead organici, incidendo anche sul morale interno.

La realtà è chiara: prevenire è economicamente più sostenibile che rimediare. L’integrazione di controlli qualità nell’interfaccia, l’impiego di framework come RAG o meccanismi di validazione multilivello sono investimenti strategici. Non si tratta solo di evitare errori: significa garantire continuità di reputazione e redditività in un contesto dominato dall’affidabilità dei contenuti.

L’immagine che segue evidenzia l’impatto concreto che le AI hallucination possono avere su visibilità, credibilità aziendale e ritorno economico.

Stime reali sui danni economici per aziende e publisher

Quando si parla di AI hallucination, le perdite economiche non sono un’ipotesi teorica, ma una realtà quantificabile. Alcune aziende editoriali che hanno integrato sistemi generativi nei loro flussi produttivi hanno registrato un aumento del 40% nei tempi di revisione manuale. Il motivo? Ogni contenuto generato necessita di un fact-checking accurato, che sottrae tempo operativo e forza lavoro, riducendo la produttività complessiva del team editoriale.

Il problema si acuisce nei settori dove la precisione informativa è fondamentale. L’editoria, ad esempio, ha iniziato a segnalare casi in cui le allucinazioni hanno causato un crollo del traffico organico, con riduzioni nel CTR anche del 35%. Articoli generati automaticamente e pubblicati senza verifica hanno portato alla penalizzazione da parte degli algoritmi di ranking, compromettendo mesi di lavoro SEO. Questo si traduce in perdita di visibilità, lead qualificati e introiti pubblicitari.

Il danno, però, non si esaurisce sul piano quantitativo. Quando i lettori identificano un errore clamoroso, la fiducia nella testata viene irrimediabilmente compromessa. Alcuni brand hanno assistito a disiscrizioni massicce dalle loro newsletter e a un crollo nell’engagement su social e piattaforme. In termini economici, il costo opportunità di dover riconquistare quella fiducia supera spesso il costo di produzione iniziale.

Nel settore tecnologico, alcuni SaaS hanno documentato un calo nei trial attivati e nel tasso di conversione dopo la diffusione di informazioni errate generate da AI, portando a una revisione completa del funnel di acquisizione. La fiducia compromessa impone ulteriori investimenti in campagne di awareness e azioni correttive, aumentando il costo di acquisizione del cliente.

Ciò che inizialmente veniva percepito come un risparmio – affidarsi all’intelligenza artificiale per automatizzare la creazione di contenuti – si trasforma in un investimento a rischio se non viene supportato da una strategia di controllo efficace. Non si tratta di demonizzare la tecnologia, ma di prendere atto del fatto che la qualità va sempre supervisionata.

Case study finanziari: quando correggere è più costoso che prevenire

In certi casi, l’impatto finanziario di una AI hallucination ha raggiunto proporzioni tali da spingere le aziende a rivalutare completamente l’impiego dell’intelligenza artificiale nei propri processi. I case study non mancano, e tutti raccontano la stessa cosa: correggere è più oneroso che prevenire. I danni emergono in modo trasversale, colpendo editoria, e-commerce, divulgazione scientifica e formazione professionale.

Un esempio emblematico riguarda una piattaforma di informazione sanitaria che ha pubblicato articoli generati da LLM contenenti riferimenti clinici inventati. La scoperta dell’errore ha provocato un’ondata di disiscrizioni, la perdita di sponsor pubblicitari e una campagna di brand recovery durata sei mesi, con un investimento superiore ai centomila euro. Il danno ha coinvolto anche il ranking SEO, con un calo del traffico del 70% su parole chiave ad alta conversione.

Nel settore e-commerce, alcuni shop online hanno affidato la generazione delle schede prodotto a modelli linguistici generativi. Il risultato? Descrizioni errate, caratteristiche inventate, e una valanga di recensioni negative. Il danno reputazionale ha comportato rimborsi massivi, sospensione temporanea delle vendite e una riscrittura totale dei contenuti. In più, le piattaforme pubblicitarie hanno abbassato il quality score degli annunci, causando un aumento del CPC del 25%.

Un altro caso concreto riguarda un portale accademico che ha pubblicato oltre cinquanta lezioni realizzate tramite AI, contenenti dati falsi e link a fonti inesistenti. Le università partner hanno interrotto la collaborazione, portando a una perdita immediata del 40% del fatturato trimestrale e alla sospensione delle attività per due mesi, durante i quali è stato necessario ripristinare manualmente ogni contenuto.

Questi esempi dimostrano come il costo della verifica preventiva, con strumenti dedicati e personale esperto, sia sempre inferiore rispetto alla gestione di una crisi reputazionale. In un’epoca di contenuti ipergenerati, l’accuratezza è l’unico vantaggio competitivo reale.

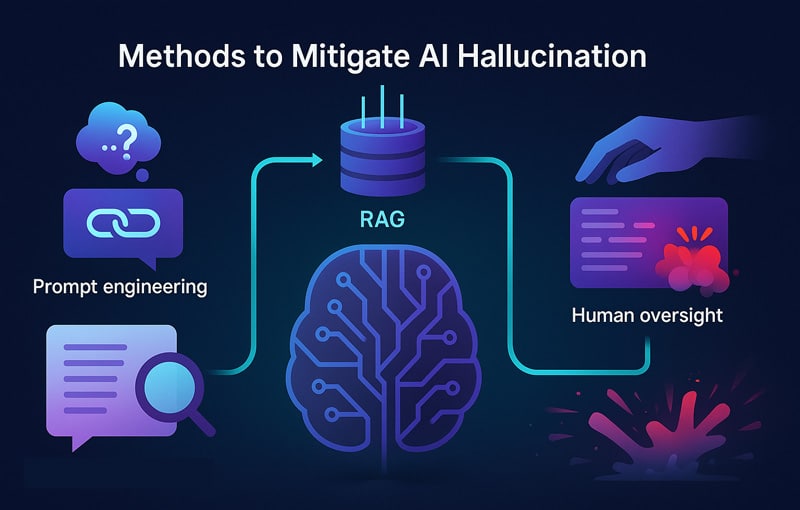

Come mitigarle: strategie, prompt, tecnologie reali (320 parole reali)

AI hallucination non è un fenomeno inevitabile. Al contrario, può essere gestito, anticipato e ridotto attraverso tecniche ben strutturate e l’impiego di strategie specifiche che affondano le radici nell’ingegneria dei modelli e nella progettazione del prompt. Parlare di prevenzione non significa blindare l’AI, ma insegnarle a operare in un contesto dove la verifica dei dati e l’affidabilità diventano parte integrante del flusso generativo.

Uno dei pilastri per contenere il rischio di generative AI hallucination è l’utilizzo di approcci come il Retrieval-Augmented Generation (RAG). Questo sistema collega il modello generativo a una base di conoscenze verificata e dinamica, esterna al training originale. Il risultato è una generazione informata, che riduce il rischio di fabbricazioni, in particolare in ambiti tecnici e verticali dove la precisione è fondamentale.

Altre strategie includono il reinforcement learning con feedback umano (RLHF), che consente di calibrare il comportamento dell’AI in base a risposte valutate manualmente. I modelli vengono esposti a scenari reali e allenati a scegliere output che massimizzano l’accuratezza, penalizzando invece risposte imprecise. Questo meccanismo introduce una sorta di etica dinamica dell’output.

Un’area ancora sottovalutata ma ad alto potenziale è il prompt tuning. Progettare input testuali con parametri di sicurezza semantica, istruzioni esplicite e vincoli contestuali, può ridurre drasticamente il margine di errore. Un prompt ben congegnato agisce come una rete semantica, guidando il modello all’interno di traiettorie narrative più sicure.

Infine, l’adozione di filtri generativi e fallback rules rappresenta una linea difensiva automatizzata. Quando il modello supera soglie di incertezza, può essere innescato un avviso, un rigeneratore contestuale o una richiesta di verifica esterna. Non è censura, ma prevenzione attiva in tempo reale.

L’illustrazione seguente sintetizza visivamente i principali approcci adottati per contenere e controllare le AI hallucination.

Tecniche avanzate: RAG, RLHF, fine-tuning umano-guidato

Contrastare le AI hallucination richiede un approccio ingegneristico stratificato, basato su metodi evoluti come RAG, RLHF e supervised fine-tuning. Questi non sono semplici acronimi, ma strategie operative adottate nei laboratori delle principali AI company per mitigare l’imprevedibilità generativa.

Il Retrieval-Augmented Generation (RAG) collega il modello a una base di conoscenza esterna, spesso aggiornata e indicizzata in tempo reale. In pratica, il modello smette di “indovinare” e comincia a consultare. Quando una domanda viene posta, l’AI accede a documenti affidabili prima di generare la risposta. Questo processo, noto come grounding esterno, riduce drasticamente le fabbricazioni, in particolare nei settori tecnico-scientifici o legali.

Il secondo livello di raffinamento è rappresentato dall’RLHF, reinforcement learning con feedback umano. I modelli vengono esposti a un set di risposte valutate da esperti: quelle accurate vengono premiate, quelle hallucinate penalizzate. Questo crea una curva di apprendimento guidata, in cui il sistema impara a distinguere contenuti plausibili da contenuti verificabili. La differenza è sottile, ma cruciale: una frase può sembrare sensata e comunque essere falsa.

La terza tecnica, spesso integrata con le prime due, è il supervised fine-tuning. A differenza del pretraining su miliardi di token, qui il modello viene aggiornato su piccoli dataset altamente curati, supervisionati da esseri umani. Questo approccio consente di intervenire in modo mirato su domini verticali, come medicina, finanza o diritto, dove l’errore non è ammesso.

Infine, la combinazione sinergica tra queste tecniche crea una pipeline di affidabilità. Un modello può essere prima raffinato con supervised fine-tuning, poi rinforzato con RLHF e infine collegato a un modulo RAG. Il risultato non è infallibile, ma è un’AI più cosciente dei propri limiti.

Prompt engineering e framework di controllo

Ogni risposta dell’intelligenza artificiale nasce da una richiesta. E ogni richiesta, se progettata con rigore, può diventare un filtro di verità. È questo il cuore del prompt engineering, l’arte e la scienza di costruire input capaci di indirizzare il modello lontano dalle allucinazioni e verso un output affidabile, coerente e contestualizzato.

Una tecnica sempre più diffusa è l’uso dei metaprompt, comandi strutturati che istruiscono l’AI a verificare le fonti, esprimere incertezza o esplicitare il livello di sicurezza delle risposte. Questo introduce un primo strato di consapevolezza nell’output. Un esempio efficace è la frase “Se non sei sicuro al 100%, rispondi: ‘Non posso fornire una risposta verificata’.” Anche se semplice, questo comando può ridurre sensibilmente le generative AI hallucination.

Altri approcci evoluti includono la strategia chain-of-thought, in cui si chiede al modello di esporre il processo logico alla base della risposta. Forzando l’AI a ragionare a voce alta, si riduce il rischio di salto logico o hallucination contestuale. Anche il prompt injection block, che inibisce certi comportamenti attraverso pattern testuali specifici, può risultare utile, soprattutto in ambienti sensibili.

La progettazione di un framework di controllo non si limita alla singola richiesta. Può essere implementata come pipeline in sistemi più ampi, ad esempio chatbot, IDE o CMS, dove ogni output viene sottoposto a filtri di validazione prima della pubblicazione. In questo contesto, il prompt agisce come prima barriera semantica, e i controlli successivi garantiscono l’aderenza ai criteri di attendibilità.

In alcuni casi avanzati, si utilizzano avoidance layer, livelli logici che riconoscono argomenti sensibili e attivano protocolli di prudenza. L’obiettivo non è frenare l’AI, ma guidarla con precisione chirurgica. Con prompt ben ingegnerizzati, l’errore diventa eccezione controllata e non norma generativa.

UX, interfacce e fiducia: come presentare un output incerto

Quando un utente riceve un’informazione da un sistema basato su intelligenza artificiale, la percezione di affidabilità dipende da come quell’informazione viene presentata. Il rischio di ai hallucination non si limita all’errore in sé: si estende alla fiducia compromessa, al danno reputazionale e al declino dell’usabilità del sistema. È per questo che l’interfaccia utente diventa il primo punto di contatto tra AI e persona. Non basta generare: serve comunicare in modo responsabile.

Molti modelli generativi oggi includono confidence score, punteggi che riflettono la sicurezza stimata del sistema rispetto alla risposta prodotta. Tuttavia, questi valori spesso non sono mostrati all’utente finale, lasciando che ogni output venga interpretato come “vero per default”. È qui che interviene la UX strategica. Una risposta accompagnata da un badge di incertezza, o da una nota contestuale sul grado di affidabilità, può trasformare l’esperienza da passiva a partecipativa.

Il design delle interfacce dovrebbe evolvere per integrare elementi visivi chiari e intuitivi: etichette di attendibilità, tooltip esplicativi, link alle fonti usate dal modello. Non si tratta di appesantire il layout, ma di abilitare un nuovo livello di coscienza informativa. Un utente consapevole è meno vulnerabile all’errore e più propenso a usare l’AI in modo critico.

Una componente centrale è anche la trasparenza dell’errore. Invece di nascondere i fallimenti, i sistemi AI dovrebbero dichiarare con onestà dove e perché potrebbero aver generato una risposta imprecisa. Questo approccio non indebolisce il modello, lo rafforza nell’immaginario dell’utente, rendendolo più umano, più responsabile, più usabile.

La fiducia non si ottiene chiedendola, ma progettandola. Nel contesto delle ai hallucinations, un’interfaccia che esplicita l’incertezza diventa uno strumento chiave per contenere il danno e valorizzare la funzione stessa dell’intelligenza artificiale.

L’immagine seguente mostra come un’interfaccia possa segnalare in modo efficace il livello di affidabilità di un contenuto generato da AI.

Mockup UI per trasparenza: badge, confidence score, citazioni verificabili

Nel momento in cui una AI hallucination viene presentata in modo ambiguo, senza indicatori visivi, l’utente medio tende a crederle per default. Questo comportamento cognitivo, legato all’effetto framing e alla fiducia riposta nel tono assertivo delle risposte AI, può essere mitigato attraverso soluzioni di interfaccia consapevoli.

Un mockup efficace deve evidenziare tre componenti fondamentali: il grado di sicurezza della risposta, la fonte da cui deriva e la possibilità di verifica. I badge visivi sono il primo elemento chiave: possono rappresentare livelli di attendibilità tramite colori, icone o etichette testuali. Ad esempio, un badge “Affidabilità: media” in colore giallo crea una soglia percettiva che invita alla cautela senza bloccare la consultazione.

Al secondo livello, i confidence score devono essere comprensibili anche a chi non ha una formazione tecnica. Un punteggio su scala da 1 a 5, associato a una legenda chiara (“1 = molto incerto, 5 = molto certo”), trasforma un concetto astratto in uno strumento decisionale immediato. Se inserito accanto alla risposta AI, il punteggio non interrompe la lettura ma accompagna l’interpretazione.

La terza colonna del mockup ideale è rappresentata dalle citazioni verificabili. Ogni affermazione generata dovrebbe avere accanto un’icona che consente all’utente di consultare la fonte primaria utilizzata dal modello. Questo rende il contenuto auditabile, elevando il valore percepito della risposta. Se l’informazione non è verificabile, l’interfaccia deve dichiararlo con trasparenza.

In alcuni test sperimentali, UI che includono indicatori di incertezza hanno ridotto l’accettazione passiva di risposte hallucinate di oltre il 40%. Questo dimostra che l’architettura informativa può agire come prima difesa semantica, non solo come contenitore estetico. Mostrare l’incertezza è un atto di rispetto verso l’intelligenza umana che sta davanti allo schermo.

L’importanza della UX nel contenimento del danno informativo

La UX non è solo estetica: è responsabilità cognitiva. Quando un’interfaccia utente presenta un contenuto generato dall’intelligenza artificiale, sta implicitamente definendo il grado di affidabilità percepita. Questo vale a maggior ragione nel caso delle ai hallucinations, dove l’errore non si riconosce dall’apparenza, ma dall’assenza di contesto. Se non guidato, l’utente accetta l’output come vero per principio di autorità algoritmica.

Un’interfaccia efficace non deve solo mostrare, ma anticipare l’errore potenziale. Il design centrato sull’utente (user-centered) non si limita a migliorare l’esperienza, ma si fa strumento attivo di prevenzione semantica. Ad esempio, in ambienti ad alta sensibilità come sanità o ambiti legali, la UI deve accompagnare ogni risposta AI con feedback dinamici, suggerendo la possibilità di verifica o la necessità di consultazione umana.

L’uso di elementi interattivi che pongono domande all’utente (“La risposta ti è sembrata coerente?”, “Vuoi approfondire con fonti esterne?”) attiva un meccanismo di dubbio attivo. Questo non riduce la fluidità dell’esperienza, ma amplia il livello di coscienza dell’interlocutore. La fiducia non è più cieca, ma consapevole. È in questa tensione tra affidabilità e verifica che la UX assume un ruolo etico oltre che funzionale.

Inoltre, una buona UX è anche una forma di contenimento del rischio reputazionale. Un sistema che dichiara i propri limiti guadagna in credibilità, evitando che un’eventuale hallucination diventi un danno virale. Il design thinking, applicato in questo contesto, aiuta a costruire percorsi informativi responsabili e interfacce che formano utenti più critici.

La trasparenza è una scelta progettuale. La fiducia è il risultato. Nel contesto delle AI, la UX non serve solo a semplificare: serve a difendere la verità da una sua perfetta imitazione. Ed è in questa sfida che si gioca la reale evoluzione dell’interazione uomo-macchina.

Normativa, responsabilità legale e governance AI

L’adozione diffusa dei sistemi generativi ha reso il problema delle AI hallucination non solo una questione tecnica, ma un tema giuridico e politico di primo piano. Quando un modello linguistico produce contenuti errati, fuorvianti o addirittura pericolosi, la domanda cruciale non è soltanto “perché è successo?”, ma “chi ne risponde?”. E la risposta, oggi, è tutt’altro che chiara.

Nel panorama normativo, il primo elemento da considerare è il vuoto di responsabilità. Le ai hallucinations si collocano in una zona grigia, dove spesso manca una figura esplicitamente titolare dell’output. Se il contenuto viene pubblicato su una testata, l’editore potrebbe essere ritenuto responsabile. Se viene diffuso da un utente, entra in gioco il regime di moderazione della piattaforma. Ma quando è generato da un algoritmo integrato in un software, e magari l’errore è non intenzionale, chi deve intervenire?

L’AI Act ha introdotto alcune linee guida di rischio e classificazione, ma ancora non definisce in modo pienamente operativo le modalità di accountability per i contenuti hallucinated. Lo stesso GDPR, sebbene richieda trasparenza nel trattamento dei dati personali, non copre l’eventualità che un sistema generi informazioni false che non si basano su dati reali.

La governance algoritmica, in questo contesto, rappresenta una nuova frontiera. Serve una tracciabilità completa (audit trail) che permetta di capire come e perché un certo contenuto è stato generato. Solo così si può attribuire una forma di responsabilità editoriale computazionale.

È inoltre fondamentale garantire il diritto all’informazione corretta, specialmente nei casi in cui una ai hallucination comprometta la reputazione di una persona o di un’azienda. La trasparenza legale, oggi, è un principio ancora in costruzione.

Le norme digitali devono quindi evolvere per includere standard di verificabilità, di tracciamento del modello e di spiegabilità dell’output. Fino ad allora, ogni contenuto generato da un’AI che può essere scambiato per vero sarà anche potenzialmente una minaccia alla fiducia pubblica. E in assenza di regole chiare, il danno è tanto più pericoloso quanto più invisibile.

L’immagine seguente rappresenta il delicato equilibrio tra responsabilità, norme emergenti e controllo legale delle AI hallucination.

Chi paga in caso di errore? Analisi delle responsabilità legali

Quando un sistema genera un’AI hallucination che danneggia un utente, un paziente, un’impresa o un ente pubblico, chi ne risponde legalmente? La domanda non è retorica, ma centrale nella definizione di una strategia normativa efficace. E la risposta, oggi, oscilla tra zone d’ombra e approcci frammentati.

Nel contesto legale attuale, la titolarità dell’output generato da AI non è univocamente stabilita. Se l’intelligenza artificiale agisce come assistente redazionale o editoriale, può valere il principio di responsabilità editoriale. Ma nei casi in cui il contenuto viene integrato automaticamente in siti web, piattaforme informative o servizi al cittadino, manca una figura giuridicamente riconoscibile come responsabile diretto.

Qui entra in gioco il concetto di accountability algoritmica, ovvero la capacità di tracciare e attribuire l’origine del contenuto e l’intenzione dietro l’output generato. Ma l’accountability richiede audit trail completi, e nella maggior parte dei tool oggi diffusi, queste tracce non sono né pubbliche né accessibili in modo retroattivo.

In Europa, il GDPR fornisce alcune protezioni, soprattutto in materia di dati personali, ma non contempla ancora esplicitamente gli errori generativi non intenzionali. Alcuni paesi hanno iniziato a discutere su forme di responsabilità oggettiva per chi implementa sistemi AI senza meccanismi di verifica robusti, ma siamo lontani da un quadro coerente.

Le aziende che utilizzano modelli generativi per produrre contenuti informativi dovrebbero integrare sistemi di validazione interna e disclaimer legali. Questo, oltre a garantire maggiore tutela per gli utenti finali, contribuisce anche a una forma di compliance preventiva. In caso contrario, il rischio regolatorio e reputazionale diventa un costo nascosto ma sempre più rilevante.

Chi paga, quindi? Ad oggi, nessuno con certezza. E proprio per questo, la costruzione di una responsabilità distribuita e tracciabile è la chiave per contenere le conseguenze giuridiche delle ai hallucinations.

Standard etici, trasparenza, watermarking e explainable AI

Per ridurre l’impatto negativo delle ai hallucination, serve molto più di una semplice correzione tecnica. Occorre costruire un’intera impalcatura etica e regolativa che guidi il comportamento dei modelli, degli sviluppatori e dei distributori di contenuti AI. In questo scenario, trasparenza ed explainability diventano fattori strutturali, non opzionali.

Un modello che produce risposte fittizie, inventa fonti o combina dati reali e inventati in modo plausibile rischia di diventare credibile ma pericoloso. Per questo motivo si stanno diffondendo pratiche come il watermarking invisibile, ovvero marcature digitali integrate negli output che ne attestano l’origine, la versione del modello utilizzato, il livello di confidenza, o lo stato di verifica.

Allo stesso tempo, l’adozione di tecniche di explainable AI (XAI) è cruciale per garantire leggibilità e auditabilità degli output. Un sistema spiegabile è in grado di fornire all’utente un percorso logico o probabilistico che giustifica l’informazione generata, rendendo visibile il grado di incertezza o il legame con le fonti.

Dal punto di vista etico, l’assenza di queste pratiche si traduce in una mancanza di accountability morale. Gli sviluppatori devono quindi implementare standard minimi di fair use, soprattutto per modelli utilizzati in settori sensibili come medicina, legge, educazione o pubblica amministrazione.

Anche l’audit semantico assume un ruolo crescente: non si tratta più solo di controllare la grammatica o la veridicità, ma di verificare che il contenuto generato non induca interpretazioni fuorvianti. La sicurezza contenutistica è oggi parte integrante della qualità informativa.

Una governance sostenibile dei modelli generativi passa per queste soluzioni: watermarking, explainability, tracciabilità. Senza queste basi, ogni contenuto generato resta opaco, e ogni hallucination potenzialmente devastante.

Tool real-time per prevenzione e controllo delle hallucinations

Nonostante le soluzioni architetturali e i miglioramenti nei dataset, le ai hallucination restano una delle criticità più diffuse nell’uso professionale dei modelli generativi. Per garantire un output affidabile, soprattutto in contesti editoriali, legali e informativi, è fondamentale affiancare agli LLM dei tool real-time di controllo, capaci di identificare contenuti falsi, incoerenti o potenzialmente dannosi.

Nel panorama attuale si stanno affermando strumenti integrabili direttamente nei CMS, negli ambienti di scrittura professionale o nei workflow di pubblicazione, che agiscono come verificatori semantici e filtri di coerenza logica. Plugin sviluppati per WordPress, Notion o sistemi di backend headless sono progettati per effettuare una verifica preventiva e post-generativa, confrontando gli output con fonti esterne, pattern conosciuti e database verificati.

Uno degli strumenti emergenti in questo ambito è il “hallucination detector”, che segnala in tempo reale contenuti a rischio, evidenziando le frasi sospette prima ancora della pubblicazione. Alcuni CMS avanzati integrano anche sistemi di fact-checking automatico, basati su retrieval semantico, che offrono un primo livello di validazione basato su dataset certificati. In ambito IDE, ambienti di sviluppo come VS Code o JetBrains stanno iniziando a supportare plugin per la revisione di codice o testi generati da AI, segnalando incongruenze sintattiche e semantiche.

L’obiettivo di questi strumenti non è quello di censurare o sostituire l’autore, ma di creare un ecosistema collaborativo in cui il contenuto venga accompagnato da strati di sicurezza informativa, simili a quelli che già oggi applichiamo ai sistemi antivirus o ai firewall.

Prevenire le ai hallucination in tempo reale è oggi non solo possibile, ma strategicamente necessario per qualsiasi progetto che si basi su contenuti AI-driven. A differenza dei correttivi a valle, questi strumenti intervengono a monte, riducendo i costi di verifica e migliorando la fiducia degli utenti.

Plugin, IDE, CMS e sistemi di flag automatico

L’espansione delle ai hallucination nei workflow digitali ha spinto sviluppatori e content strategist a ideare strumenti concreti, integrabili direttamente nelle interfacce di lavoro quotidiane. In prima linea troviamo plugin e moduli intelligenti per CMS, IDE e ambienti editoriali, in grado di intercettare errori semantici prima della pubblicazione.

Su WordPress, ad esempio, stanno emergendo estensioni che combinano analisi linguistica predittiva e monitoraggio di pattern errati tipici delle allucinazioni generative. Questi plugin non solo riconoscono frasi statisticamente anomale, ma le confrontano con dataset esterni affidabili, suggerendo revisioni o alternative più coerenti. In parallelo, nei CMS headless o modulari, vengono integrati moduli backend con funzionalità di cross-check automatico: confrontano l’output con database tematici, fonti di legge, linee guida cliniche o documenti tecnici ufficiali.

Anche in ambienti di sviluppo come Visual Studio Code, JetBrains o Jupyter Lab, si stanno diffondendo plugin di review semantica del codice e dei commenti generati da AI. Questi strumenti non si limitano a verificare la sintassi, ma segnalano anche output logicamente sospetti, come riferimenti a funzioni non esistenti, strutture teoriche errate o bibliografie inventate.

Il valore reale di questi strumenti è nella loro capacità di agire in background, senza interrompere il flusso creativo, ma innescando allarmi discreti nei momenti critici. Non eseguono blocchi, ma espongono badge, alert visivi o suggerimenti inline per richiamare l’attenzione su contenuti che potrebbero risultare frutto di ai hallucination.

Questa forma di flagging real-time sta diventando un nuovo standard editoriale, e sarà probabilmente parte integrante delle future normative sulla tracciabilità dell’intelligenza artificiale. In un contesto dove l’affidabilità si gioca sulla percezione istantanea dell’output, disporre di plugin intelligenti e ambienti sensibili agli errori è una necessità, non un’opzione.

Rilevare automaticamente una ai hallucination mentre viene prodotta è la nuova frontiera del content safety.

Pipeline integrate per la generazione sicura in ambienti professionali

Per evitare che una ai hallucination comprometta un’intera campagna di comunicazione, un’iniziativa medica o un atto normativo, è essenziale strutturare pipeline di generazione AI sicure, convalidabili e trasparenti. Non basta correggere a posteriori: occorre costruire flussi editoriali intelligenti, capaci di accompagnare l’output AI con layer di verifica multipli.

Un workflow professionale sicuro comincia dalla progettazione dell’input: ogni prompt viene sottoposto a una prevalidazione semantica, per evitare ambiguità o formulazioni fuorvianti. L’output generato viene immediatamente analizzato da un modulo di controllo semantico, che identifica citazioni non attribuite, numeri senza fonte o affermazioni troppo generiche.

Nel secondo stadio, l’output attraversa un sistema di validazione interattiva, dove l’editor umano può confermare, correggere o rigenerare le sezioni dubbie. In alcuni casi, la pipeline include anche sistemi automatici di scoring qualitativo, che assegnano un livello di affidabilità all’intero contenuto. Questo punteggio può essere utilizzato per decidere se procedere alla pubblicazione, inviare in revisione o archiviare l’output per analisi successive.

Strumenti come Notion AI, Frase, o Writer.com stanno iniziando a offrire modalità editoriali blindate, in cui ogni contenuto AI deve passare da un modulo di verifica a due livelli prima di essere visibile al pubblico. Questi sistemi includono watermark invisibili, commenti dinamici interni e log tracciabili di revisione, validi anche per eventuali audit.

L’obiettivo non è rallentare la produttività, ma aumentare la sicurezza percepita e reale del contenuto. In ambienti normativi, sanitari, aziendali o educativi, la generazione AI non può più essere un processo monolitico. Deve diventare un ecosistema dove la fiducia è costruita, non presunta.

Solo così la produzione di contenuti AI potrà affermarsi senza il rischio di essere minata da una ai hallucination passata inosservata.

AI e sicurezza: slopsquatting, supply chain e AI hallucination malevole

Nel panorama sempre più complesso della cybersicurezza, le ai hallucination non sono più solo un rischio passivo da contenere. Si stanno trasformando in vettori attivi di attacco informatico, sfruttati da attori malevoli per veicolare dati errati, condizionare comportamenti e introdurre vulnerabilità nelle supply chain digitali. L’apparente innocuità di una risposta AI maschera la potenziale apertura a exploit semantici, inganni strutturati e attacchi indiretti.

Tra le minacce emergenti, il fenomeno del slopsquatting si sta imponendo come tecnica subdola e difficile da intercettare. Consiste nella creazione di pacchetti software o dipendenze AI con nomi molto simili a quelli legittimi, così da indurre i modelli generativi, quando interrogati per suggerire strumenti o librerie, a fornire nomi corrotti. L’utente si fida della risposta e installa inconsapevolmente un componente compromesso, aprendo una backdoor invisibile nel proprio ambiente operativo.

Le ai hallucination, quando sfruttate intenzionalmente, diventano strumenti di social engineering algoritmico. Un output all’apparenza attendibile può suggerire URL fraudolenti, procedure errate o configurazioni insicure, il tutto innescato da un semplice prompt manipolato. È un cambio di paradigma: l’errore non è più casuale, ma indotto, disegnato per colpire vulnerabilità cognitive e operative.

La sicurezza delle supply chain AI deve ora considerare anche la dimensione semantica dell’attacco. Non basta più proteggere il codice: è necessario verificare il contenuto generato, la logica dietro le risposte e i riferimenti indicati nei testi. Ogni hallucination potenzialmente malevola può diventare l’anello debole di un’infrastruttura teoricamente sicura.

Le organizzazioni devono attrezzarsi con meccanismi di controllo contestuale, in grado di rilevare schemi linguistici anomali, suggerimenti ricorrenti a sorgenti ignote, o deviazioni sintattiche nei pacchetti consigliati. In ambienti professionali, anche un piccolo errore generativo può trasformarsi in un’esfiltrazione silenziosa di dati o in un’esecuzione remota non autorizzata.

In questo nuovo scenario, le ai hallucination non sono più solo una questione di accuratezza, ma un vero problema di cybersecurity LLM-centrica. Ignorarle equivale a esporre i propri sistemi a una forma di attacco subdola, personalizzabile e sempre più sofisticata.

La scena illustra come le AI hallucination possano essere sfruttate per attacchi sofisticati e minacce nella supply chain digitale.

Come le AI hallucination vengono sfruttate per attacchi informatici

La nuova frontiera degli attacchi informatici non sfrutta più solo vulnerabilità nel codice, ma debolezze semantiche nei modelli linguistici. Le ai hallucination, spesso considerate incidenti linguistici, stanno diventando strumenti attivi nelle mani di chi sa manipolare i comportamenti dell’intelligenza artificiale. Non si tratta più di errori casuali, ma di strategie strutturate per produrre risposte compromesse, ingannevoli e pericolose.

Attraverso prompt appositamente costruiti, un attaccante può indurre il modello a generare un output volutamente errato, ma plausibile. È la logica della hallucination injection: sfruttare la capacità predittiva dell’AI per iniettare contenuti fittizi, link fasulli o nomi di pacchetti inesistenti che rimandano a repository maligni. Il tutto, senza forzature evidenti, perché il modello genera esattamente ciò che ritiene plausibile, ma lo fa sulla base di un contesto alterato ad arte.

Questa forma di attacco invisibile agisce tramite il linguaggio naturale, inducendo l’utente a eseguire un’azione sbagliata. Ad esempio, una guida AI che suggerisce comandi shell errati, URL con typo impercettibili o librerie Python modificate può causare l’inserimento di backdoor, l’esposizione involontaria di dati o l’avvio di processi dannosi. Il pericolo non è nella sintassi, ma nell’intenzionalità del contenuto.

Un altro vettore emergente è il phishing AI-based, dove l’output del modello viene utilizzato per generare e-mail persuasive, landing page credibili o persino conversazioni chatbot che emulano lo stile di un’organizzazione. In questi contesti, l’ai hallucination viene calibrata per sembrare vera, ma è semanticamente orientata a trarre in inganno.

La backdoor non è più nel codice, ma nel significato. È la backdoor semantica il nuovo punto critico: una sequenza di parole che, pur corretta da un punto di vista grammaticale, indirizza l’utente verso un errore operativo o decisionale.

In un mondo governato dalle interfacce linguistiche, la sicurezza non può prescindere dal contenuto generato. Le ai hallucination, in questo contesto, diventano la miccia di un’esplosione invisibile: silenziosa, precisa, letale.

Prevenzione nelle supply chain AI e verifica pacchetti LLM

Nel contesto della sicurezza AI, la prevenzione non può limitarsi alla fase post-generativa. Deve estendersi a monte, lungo tutta la supply chain dei modelli linguistici, dalle dipendenze software alle pipeline di addestramento, fino alla distribuzione e all’integrazione. In questo scenario, le ai hallucination rappresentano un rischio silenzioso ma costante, soprattutto quando influenzano indirettamente suggerimenti operativi, tecnici o sistemici.

Uno dei punti più vulnerabili è la gestione delle dipendenze nei progetti AI-based. L’utilizzo di pacchetti Python suggeriti da modelli generativi espone gli utenti al pericolo di slopsquatting, dove nomi simili a quelli legittimi vengono registrati per ingannare chi copia istruzioni direttamente da una risposta AI. È sufficiente che il modello suggerisca reqeusts al posto di requests, o numppy anziché numpy, per avviare l’installazione di un modulo compromesso.

La risposta a questo problema passa per l’adozione sistematica di strumenti di verifica delle firme digitali (checksum), repository mirrorati e ambienti sandbox per ogni installazione. Oltre alla protezione del codice, serve un controllo semantico sul contenuto generato: il nome del pacchetto, la documentazione suggerita, la fonte indicata vanno incrociati con database ufficiali.

Alcuni strumenti stanno implementando meccanismi di autenticazione semantica, in cui ogni riferimento fornito da un modello deve corrispondere a un dato certificato. Questo tipo di controllo, combinato a una pipeline editoriale tracciabile, permette di bloccare le ai hallucination malevole prima che entrino in produzione.

In ambito enterprise, si diffondono pratiche di validazione multilivello, dove ogni output AI destinato a interagire con ambienti critici deve superare un doppio controllo: uno tecnico, legato al codice, e uno linguistico, legato al contenuto. È una forma evoluta di firewall semantico.

Proteggere le supply chain AI significa proteggere l’intera infrastruttura informativa. E oggi, ogni punto cieco lasciato scoperto può diventare il punto di ingresso di un attacco travestito da ai hallucination. Difendersi significa prevederlo, tracciarlo, bloccarlo.

Futuro delle AI hallucination: nuove metriche e AI agent

Nel prossimo ciclo evolutivo dell’intelligenza artificiale, le ai hallucination non verranno semplicemente eliminate, ma reinterpretate. Il concetto stesso di errore generativo subirà un’evoluzione funzionale: da incidente da correggere a evento computazionale da comprendere, contenere e, in certi casi, persino valorizzare.

La nuova generazione di modelli non sarà più pensata come entità monolitiche, ma come sistemi distribuiti basati su architetture agent-based. In questo paradigma, ogni modello generativo sarà affiancato da agenti verificatori, che agiranno in tempo reale per validare l’output prodotto. La risposta AI non sarà più un punto di arrivo, ma il risultato di un processo negoziato, controllato da circuiti di riflessione e safety layer interni.

Uno degli strumenti destinati a emergere è Acurai, una piattaforma che promette di integrare metodi di validazione automatica multilivello con metriche semantiche adattive. L’obiettivo è calcolare in tempo reale la probabilità che un’informazione sia vera, attendibile, o invece frutto di una ai hallucination strutturale. Si tratta di una forma avanzata di chain-of-thought scoring, in cui l’AI non risponde solo, ma espone il proprio ragionamento prima di renderlo fruibile.

Nel frattempo, i KPI legati alla produzione AI cambieranno drasticamente. Non si parlerà più soltanto di coerenza sintattica o tasso di clic, ma di tracciabilità logica, affidabilità percettiva e resilienza semantica. Un contenuto sarà considerato valido solo se verificabile, spiegabile e utile, anche in presenza di ambiguità controllata.

Le ai hallucination, in questo nuovo contesto, non spariranno. Si trasformeranno. Da difetto a componente computazionale da monitorare, da rischio a stimolo creativo da disciplinare, da debolezza a sintomo di intelligenza aumentata ancora da comprendere.

La seguente illustrazione mostra la visione futura del monitoraggio delle AI hallucination tramite agenti intelligenti e dashboard dinamiche.

Roadmap tecnologica: agent-based verification, KPI, Acurai

Nel futuro della generazione AI, affrontare le ai hallucination significherà prima di tutto reingegnerizzare la logica di validazione del contenuto. L’approccio non sarà più correttivo, ma proattivo, affidato a sistemi composti da più intelligenze cooperanti. A guidare questo salto sarà l’adozione massiva di architetture agent-based, in cui ogni output prodotto viene sottoposto a una sequenza di controlli multilivello eseguiti da agenti autonomi.

Questi agenti non sostituiscono il modello generativo, ma lo accompagnano, agendo come validatori interni o esterni. Possono essere configurati per confrontare l’output con database real-time, misurare l’affidabilità semantica o controllare la coerenza tra prompt e risposta. Nasce così un nuovo ruolo computazionale: il safety agent, incaricato di prevenire, filtrare o rigenerare l’output in caso di incoerenza.

Tra le piattaforme in sviluppo, Acurai si distingue per l’approccio modulare: ogni componente del contenuto AI viene valutato tramite una catena di scoring adattivo. Non si valuta solo l’accuratezza dei dati, ma anche la qualità del ragionamento esposto, la tracciabilità delle fonti e la capacità di autovalutazione del modello. Questo rappresenta una svolta radicale: l’intelligenza artificiale comincia a giudicare se stessa, usando criteri dinamici.

All’interno di questo ecosistema nasceranno nuovi KPI di performance. Non basterà più analizzare l’engagement o la pertinenza stilistica. I modelli verranno misurati in base alla loro capacità di spiegarsi, di esibire trasparenza interna, di identificare e marcare le proprie zone d’incertezza. I contenuti che emergeranno da queste pipeline saranno meno rapidi, ma molto più affidabili.

In questa roadmap tecnologica, le ai hallucination saranno trattate come elementi diagnostici, segnali attraverso cui il sistema apprende i propri limiti. Non un errore da nascondere, ma una traccia utile per evolvere, uno spazio computazionale da riconoscere e tenere sotto osservazione.

Solo un’architettura multilivello può offrire questo tipo di garanzia. E il futuro dell’AI, per essere credibile, dovrà passare proprio da qui.

Cosa cambierà davvero: da hallucination a creatività controllata

Nel nuovo ciclo evolutivo dell’intelligenza artificiale, le ai hallucination non verranno eliminate, ma reinterpretate come segnale creativo e opportunità computazionale. Finora considerate un’anomalia, esse potrebbero diventare una funzione deliberata e controllata, capace di generare divergenza utile nei contesti in cui l’output deve ispirare, non solo informare.

Il punto di svolta sarà il passaggio da AI predittiva a AI aumentata, dove il modello non si limita a ricostruire dati passati, ma interviene per ampliare gli scenari immaginabili, proporre connessioni inedite, esplorare strade linguistiche e semantiche altrimenti non accessibili. In quest’ottica, l’hallucination non sarà più sintomo di errore, ma marcatore creativo gestito in contesto.

La differenza sta tutta nella misurabilità. Un contenuto generato da AI potrà includere elementi inventivi solo se identificabili, tracciabili e modulabili in intensità. Sistemi di tag, watermark semantici e moduli di controllo percettivo permetteranno di distinguere ciò che è verosimile da ciò che è verificato, e soprattutto da ciò che è volutamente divergente. Sarà un passaggio culturale prima ancora che tecnico.

In ambiti come design, marketing, narrativa, naming, ideazione scientifica e UX, questa hallucination utile potrà diventare una fonte di ispirazione controllata. L’AI non verrà utilizzata per avere certezze, ma per produrre variazione, contaminazione e sintesi fuori dai confini del già noto. E sarà proprio la capacità di regolare questo slittamento semantico a determinare la qualità del risultato.

Questa visione presuppone un cambio nel rapporto uomo-macchina: non più supervisione unilaterale, ma co-creazione consapevole. L’essere umano non correggerà più l’AI, ma ne guiderà la divergenza in modo dinamico, usando l’hallucination come leva esplorativa.

Nel futuro prossimo, ciò che oggi è percepito come errore diventerà un’opzione stilistica, epistemologica e persino progettuale. Sarà il contesto a stabilire se l’hallucination è da correggere, validare o amplificare. E la vera competenza risiederà in chi saprà gestire questa ambiguità in modo intenzionale.

Checklist completa: come gestire e ridurre le AI hallucinations

Nel percorso di adozione dell’intelligenza artificiale nei processi produttivi, le ai hallucination rappresentano oggi una delle sfide più complesse e trasversali. Coinvolgono sviluppatori, redattori, designer, responsabili legali, team di sicurezza e creativi. Ignorarle significa esporre contenuti, dati, reputazione e processi a un errore silenzioso, ma pervasivo. Per questo, serve una checklist operativa che trasformi il problema in un piano d’azione pratico e verificabile.

Il primo passo è riconoscere l’esistenza del rischio, anche quando non è immediatamente visibile. Le ai hallucination non si manifestano solo nei chatbot, ma anche in articoli generati automaticamente, descrizioni prodotto, risposte in tempo reale e nei suggerimenti proposti in IDE, CMS e plugin. Ogni contenuto deve essere considerato un potenziale veicolo di errore, se non accompagnato da strumenti di controllo semantico.

Occorre poi adottare una serie di misure su più livelli:

- Prompt engineering consapevole: ogni prompt dovrebbe contenere vincoli espliciti, istruzioni di fallback e definizioni chiare. Un prompt errato genera una catena di errori difficilmente tracciabili.

- Strumenti di detection real-time: plugin CMS, IDE o sistemi backend devono includere moduli che riconoscono frasi anomale, riferimenti falsi o pacchetti inesistenti. Questi strumenti non bloccano, ma segnalano, aiutando il revisore a prendere decisioni informate.

- UI trasparenti: badge, confidence score e note contestuali sono indispensabili per dichiarare il livello di affidabilità percepita. In assenza di trasparenza, ogni contenuto viene interpretato come vero per default.

- Pipeline editoriali strutturate: le fasi di generazione, validazione e pubblicazione devono essere distinte. Ogni team dovrebbe avere accesso a log, versioni, audit trail e sistemi di approvazione multilivello.

- Normative e policy interne: anche in assenza di obblighi normativi esterni, ogni azienda dovrebbe avere una policy AI che definisce ruoli, responsabilità e criteri di pubblicazione.

La ai hallucination non può essere gestita con soluzioni isolate. Richiede un approccio sistemico, continuo, adattivo. Solo una governance trasversale, che unisca strumenti tecnici, attenzione semantica e consapevolezza organizzativa, può garantire un uso realmente sicuro, etico e produttivo dell’intelligenza artificiale generativa.

Domande frequenti su AI hallucination: guida definitiva alla gestione degli errori generativi

❓ Che cosa sono le AI hallucinations?

Le AI hallucinations sono contenuti generati artificialmente ma non corrispondenti a fatti reali, creati da modelli linguistici come se fossero informazioni autentiche. Si manifestano con risposte plausibili ma completamente inventate, spesso difficili da riconoscere, soprattutto nei sistemi autoregressivi come i grandi LLM.

❓ Come si differenziano bias e AI hallucination?

Le hallucination AI sono errori spontanei, dovuti all’architettura generativa. I bias, invece, derivano da pregiudizi sistemici nei dati o nel design del modello. In sintesi: il bias è sistemico, la hallucination è emergente. Ma spesso i due fenomeni possono intersecarsi e aggravarsi a vicenda.

❓ Quali sono le cause principali delle generative AI hallucination?

Le cause più comuni includono: dataset incompleti o sbilanciati, meccanismi di sampling stocastico, e modelli che predicono in base alla probabilità linguistica, non alla verità fattuale. I modelli generativi non “sanno”, ma “calcolano”.

❓ In quali settori le AI hallucination rappresentano rischi reali?

Medicina, giurisprudenza, editoria e SEO sono i contesti più vulnerabili. Un errore nella diagnosi, una citazione legale inventata o un contenuto errato sul web possono avere gravi conseguenze su persone, aziende e utenti finali.

❓ Quali strumenti aiutano a rilevare AI hallucination in tempo reale?

Esistono plugin per CMS, verificatori semantici nei sistemi IDE, e tool per il controllo dei contenuti generati. Questi strumenti monitorano e segnalano anomalie mentre l’AI scrive, rendendo possibile un intervento tempestivo.

❓ Come devono cambiare le interfacce per segnalare l’incertezza dell’AI?