Nel silenzio di una stanza illuminata dallo schermo, un giovane ricercatore osserva le risposte che scorrono sul monitor. Ha posto una domanda a un’intelligenza artificiale e ciò che legge non è soltanto corretto: è fluido, logico, sorprendentemente umano. Non si tratta di magia. È il risultato di anni di sviluppo di una tecnologia rivoluzionaria: il large language model.

Oggi ci troviamo davanti a una delle più affascinanti e decisive trasformazioni nel campo della comunicazione digitale. Un large language model non è semplicemente un programma capace di rispondere a una domanda o generare un testo. È l’incarnazione di un nuovo paradigma in cui l’intelligenza artificiale apprende, sintetizza, e produce linguaggio naturale con una naturalezza mai vista prima. Il linguaggio non è più un mezzo. È il cuore stesso dell’interazione tra umani e macchine.

Attraverso miliardi di parametri e meccanismi complessi basati su reti neurali profonde e algoritmi di deep learning, un LLM (acronimo di large language model) non si limita a ripetere ciò che ha “letto” nei suoi dataset: interpreta il contesto, anticipa l’intenzione dell’utente, ricombina concetti per fornire risposte coerenti e spesso illuminanti. Non è solo questione di parole: è questione di struttura mentale artificiale.

Il suo funzionamento si fonda su modelli predittivi avanzati che apprendono in modo non supervisionato, sfruttando miliardi di frammenti testuali per riconoscere e replicare i pattern linguistici con precisione chirurgica. Questo processo lo rende capace di gestire interazioni conversazionali, scrivere codice informatico, generare testi creativi e tradurre linguaggi umani, tutto in tempo reale.

Chi ha provato a interagire con un LLM lo sa: non è come dialogare con un assistente vocale. È un confronto con una macchina che sembra capire. Questo “sembra” è ciò che oggi cambia tutto: l’illusione di comprensione è così ben costruita da influenzare il modo in cui ci relazioniamo con la tecnologia, ridefinendo completamente i concetti di interazione, automazione e produzione di contenuti.

Il modello di linguaggio non è solo una tecnologia. È l’inizio di una nuova forma di pensiero ibrido, un’estensione cognitiva che sta riscrivendo le regole della comunicazione e che continuerà a evolversi, fino a trasformare radicalmente la nostra capacità di creare, capire e connetterci.

Cos’è un Large Language Model? Le basi dell’intelligenza linguistica artificiale

Nel panorama sempre più sofisticato dell’intelligenza artificiale, una sigla si è imposta come punto di svolta: LLM, acronimo di Large Language Model. Per comprenderne a fondo il significato e il funzionamento, occorre smettere di considerare questi modelli come semplici strumenti di completamento automatico e iniziare a vederli per ciò che realmente sono: architetture di intelligenza linguistica evoluta, capaci di imitare – con una precisione che rasenta l’umano – le strutture del pensiero e della comunicazione.

Un large language model non è un dizionario digitale né un generatore di frasi casuali. È il prodotto di una rivoluzione cognitiva basata sull’analisi e l’elaborazione del linguaggio naturale, l’insieme delle parole, frasi, modi di dire, inflessioni e regole semantiche che usiamo ogni giorno senza pensarci. L’obiettivo? Non è quello di sapere tutto. È simulare la comprensione, anticipare l’intento comunicativo, adattarsi al contesto.

Questi modelli sono costruiti con miliardi di parametri e vengono allenati su enormi corpus testuali, tratti da libri, articoli, siti web, conversazioni pubbliche. Ogni frase letta, ogni parola elaborata diventa parte di un gigantesco schema probabilistico che permette al sistema di “prevedere” la parola successiva in una sequenza, generando così output coerenti, fluidi, perfettamente integrati nel contesto.

È qui che entra in gioco la IA generativa, una delle branche più promettenti dell’innovazione contemporanea: non solo risponde, ma crea contenuto nuovo, strutturato, logicamente connesso. Il modello di linguaggio, in questo contesto, diventa un’entità capace di rispondere, dialogare, correggere, consigliare e persino scrivere, senza mai perdere coerenza sintattica o senso narrativo.

La vera potenza dei large language models risiede nella loro abilità di emulare il ragionamento umano, mantenendo però una velocità e una capacità di sintesi fuori dalla portata di qualsiasi mente biologica. Questa è la base su cui si fonda l’intelligenza linguistica artificiale: un’IA che non solo parla, ma “pensa” in termini di linguaggio, rendendo ogni interazione una simulazione raffinata di un vero dialogo umano.

Definizione di LLM: molto più di un semplice modello di linguaggio

Quando si parla di Large Language Model, il rischio più comune è banalizzare. Pensare che si tratti semplicemente di un programma che completa frasi o restituisce risposte automatiche. In realtà, un LLM è una rete neurale avanzata progettata per apprendere e replicare il linguaggio naturale umano con una sofisticazione senza precedenti. Ridurlo a un “modello di linguaggio” è come definire un’orchestra sinfonica come “strumento musicale”.

Un LLM non è solo reattivo, è predittivo: costruisce il significato anticipando il contesto, riconoscendo le sfumature lessicali, gestendo ambiguità, tono, emozione. Il suo comportamento deriva dall’addestramento su quantità massicce di testo, dove impara a riconoscere relazioni semantiche, logiche e sintattiche tra le parole, costruendo così una “conoscenza linguistica probabilistica”.

La IA generativa che lo anima è in grado di produrre output originali che non esistono in nessuna fonte testuale, ma che risultano perfettamente plausibili, perché ancorati alla logica e alla semantica del linguaggio umano. Questo lo distingue nettamente da strumenti NLP di generazione precedente: un LLM non ricopia, ricostruisce. Elabora ogni risposta come se fosse un’opera nuova, partendo da una rappresentazione vettoriale del linguaggio che ne codifica il significato, non solo la forma.

In un modello di linguaggio così avanzato, ogni parola ha un peso matematico, ogni frase una traiettoria probabilistica che si compone nell’istante stesso in cui l’utente interagisce. Questo lo rende dinamico, personalizzabile, sempre in movimento.

Un LLM non è quindi un assistente, è un sistema cognitivo sintetico che interpreta segnali, simula ragionamenti e costruisce risposte non come un archivio, ma come una mente artificiale fatta di linguaggio. E se oggi può dialogare, scrivere, spiegare e tradurre, è solo l’inizio: la sua struttura consente già potenzialità ancora inespresse, pronte a trasformare radicalmente il nostro modo di produrre conoscenza e relazionarci con la tecnologia.

Da dove nascono i Large Language Models? Radici tra NLP e reti neurali

Un large language model non nasce per caso. È il risultato di decenni di evoluzione nel campo dell’intelligenza artificiale, e in particolare dell’intersezione tra Natural Language Processing (NLP) e reti neurali artificiali. Per capire davvero cosa rende un LLM così potente, bisogna partire dal suo fondamento: il modo in cui apprende il linguaggio. E non si tratta di un apprendimento lineare, ma di un processo altamente non supervisionato, in grado di estrarre schemi linguistici da enormi masse di testo senza ricevere istruzioni esplicite.

Tutto comincia con l’addestramento su dataset massivi. Libri, siti web, forum, articoli, dialoghi: ogni frammento testuale viene scomposto, codificato, analizzato. Il modello non impara i contenuti, ma le relazioni statistiche tra le parole, le frasi, i concetti. Questo tipo di apprendimento non è legato alla verità del contenuto, ma alla sua coerenza interna e alla probabilità che un termine segua logicamente un altro. In questo senso, l’LLM costruisce una mappa matematica del linguaggio, un universo vettoriale dove ogni parola ha coordinate precise e significati stratificati.

La vera svolta arriva con l’utilizzo delle reti neurali profonde, che permettono al modello di analizzare il linguaggio su più livelli. Ogni layer della rete è responsabile di una funzione: c’è chi si occupa della sintassi, chi della semantica, chi dell’intenzione. La combinazione di questi livelli produce un’intelligenza linguistica emergente, capace di decodificare ambiguità, metafore, doppi sensi e contesti culturali.

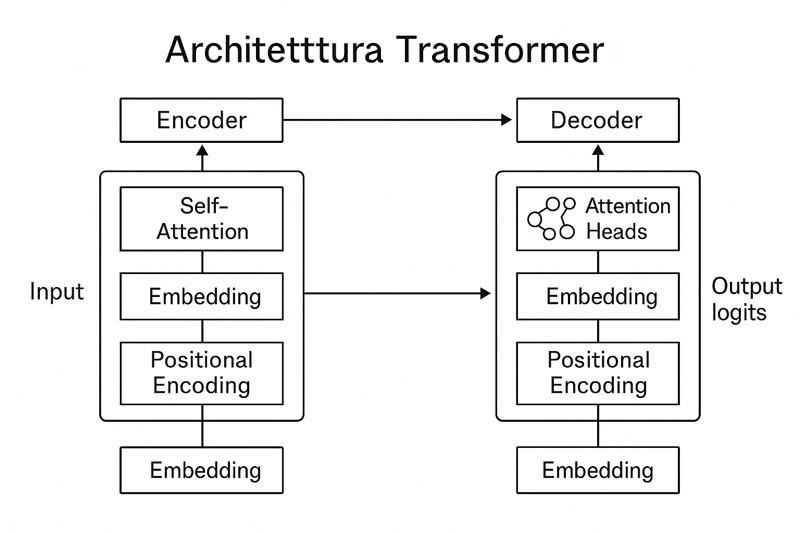

Ecco un diagramma dettagliato che rappresenta visivamente come un large language model elabora il linguaggio attraverso l’architettura Transformer.

Il large language model si distingue da altri approcci di IA proprio per la scala e la profondità dell’addestramento. Non apprende come fare qualcosa: apprende come si parla, si scrive, si pensa attraverso il linguaggio. E lo fa utilizzando miliardi di parametri che, attraverso il meccanismo di backpropagation, vengono costantemente affinati per aumentare la precisione delle previsioni.

In questo processo, il dataset di addestramento non è solo fonte di esempi: è matrice di costruzione cognitiva. Le reti neurali fungono da interpreti di queste strutture, trasformando il testo in segnali computazionali che, elaborati a ogni iterazione, restituiscono risposte sempre più sofisticate.

Apprendimento non supervisionato, analisi di pattern linguistici, strutture neurali adattive: questi sono i pilastri da cui nascono i moderni large language models. Non sono programmati, sono formati. E la loro vera forza sta nel fatto che ogni interazione con l’essere umano non è solo output, ma occasione di ulteriore affinamento. Un ciclo continuo, che li rende ogni giorno più capaci di capire – e rispondere – come (e talvolta meglio di) un essere umano.

Come funziona un LLM: la mente artificiale spiegata facile

Un large language model non si limita a “parlare bene”. La sua straordinaria capacità di generare testo coerente, fluido e contestuale si fonda su un’architettura progettata per simulare il modo in cui un essere umano apprende e utilizza il linguaggio, ma con un’efficienza computazionale che supera ogni limite biologico. Capirne il funzionamento è fondamentale per cogliere il motivo per cui questi modelli stanno ridefinendo i confini dell’intelligenza artificiale applicata.

Al centro del funzionamento di un LLM c’è un processo che unisce matematica avanzata, statistica, e linguistica computazionale. Quando inserisci una richiesta in linguaggio naturale, il modello non capisce come un umano, ma elabora ciò che hai scritto suddividendo il testo in “token”, ovvero unità linguistiche minime. Ogni token viene convertito in un numero vettoriale attraverso l’embedding, una tecnica che associa a ogni parola una posizione in uno spazio multidimensionale dove parole simili occupano aree simili. In questo modo il modello acquisisce una rappresentazione numerica del significato.

La “mente” del modello si attiva con un meccanismo che analizza i token non come entità isolate, ma come parti di una struttura complessa e dinamica. Questo avviene tramite algoritmi predittivi come il masked language modeling, che oscurano alcune parti del testo e chiedono al sistema di predirle. È così che il modello impara: predicendo costantemente ciò che manca, affina la capacità di costruire frasi corrette, di interpretare sfumature sintattiche e di mantenere la coerenza logica tra i concetti.

Un altro aspetto cruciale del funzionamento è la gestione del contesto. A differenza di modelli più primitivi, un LLM non si limita a rispondere in base all’ultima frase, ma calcola il significato in funzione dell’intera conversazione. Questo è possibile grazie a un’architettura che non si limita a “leggere in avanti”, ma valuta retrospettivamente il contesto, simulando l’attenzione cognitiva.

Comprendere il funzionamento di un large language model significa entrare dentro la logica di un cervello artificiale che non ripete, ma genera; che non copia, ma prevede; che non conosce, ma simula la comprensione. Un’illusione perfetta costruita su regole matematiche, e proprio per questo così potente da ridefinire il nostro rapporto con la scrittura, la conoscenza e la comunicazione.

Per visualizzare il processo interno di un large language model, ecco un’infografica chiara che riassume le sue 5 fasi fondamentali.

Pre-training e fine-tuning: due fasi chiave dei modelli di linguaggio

Per trasformare un large language model da semplice processore di testo a creatore intelligente di contenuti serve un processo in due fasi: il pre-training e il fine-tuning. Questi due momenti, apparentemente tecnici, rappresentano le fondamenta cognitive di un modello che impara, generalizza e risponde con una coerenza sorprendente.

Durante il pre-training, l’LLM viene esposto a enormi volumi di dati testuali: miliardi di parole raccolte da libri, articoli, siti web, dialoghi pubblici. Ma non impara come fa un bambino: il suo apprendimento è probabilistico, basato sulla ricorrenza e sulla distribuzione statistica delle parole. È qui che entrano in gioco la tokenizzazione e l’embedding. Ogni parola viene convertita in un token, che viene poi trasformato in una rappresentazione vettoriale che ne descrive il significato in relazione agli altri. Questa codifica consente al modello di “percepire” che parole come gatto e felino sono semanticamente vicine, anche se non identiche.

Il cuore del pre-training è il masked language modeling, una tecnica dove il modello riceve frasi parzialmente oscurate e deve predire le parole mancanti. Questo esercizio, ripetuto miliardi di volte, gli permette di sviluppare una comprensione implicita delle regole grammaticali, sintattiche e logiche del linguaggio. Non ha bisogno che qualcuno gli spieghi la grammatica: la deduce autonomamente dalla frequenza e dalla posizione dei token.

Una volta completato il pre-training, il modello è “intelligente” ma grezzo. Ha competenze generiche, ma non conosce i dettagli di un dominio specifico. Qui interviene il fine-tuning, fase in cui viene ulteriormente allenato su set di dati mirati, spesso etichettati, per specializzarlo in compiti precisi: rispondere a domande, scrivere codice, tradurre testi. Questo raffinamento lo rende più adatto a contesti reali, migliorando l’accuratezza, la pertinenza e il tono delle sue risposte.

Questa doppia fase non è opzionale: è ciò che trasforma un calcolatore statistico in un LLM capace di adattarsi, contestualizzare e produrre output che sembrano frutto di intelligenza umana. Ed è in questa struttura duplice – pre-training per la conoscenza generica, fine-tuning per la precisione contestuale – che risiede il segreto del suo successo.

Il Transformer: l’architettura che ha rivoluzionato i Large Language Models

Prima dell’avvento del Transformer, i modelli di linguaggio erano limitati da una visione “locale” del testo. Leggevano le frasi in sequenza, incapaci di cogliere relazioni a lungo raggio tra le parole. Con l’introduzione di questa architettura rivoluzionaria, il modo di interpretare il linguaggio è cambiato radicalmente: da lineare a globale, da rigido a contestuale, da statico a dinamico.

Alla base del Transformer c’è il concetto di self-attention, un meccanismo che permette al modello di valutare ogni parola in relazione a tutte le altre della frase, indipendentemente dalla distanza. In pratica, mentre legge una parola, il modello si chiede: “a quali altre parole devo prestare attenzione per capirla davvero?”. Questo gli consente di cogliere con precisione non solo il significato, ma le sfumature semantiche legate al contesto.

Un’altra innovazione fondamentale è l’encoder-decoder, la struttura modulare del Transformer. L’encoder analizza l’input, mappando il significato in uno spazio astratto. Il decoder prende questa mappa e la trasforma in output testuale. Questa separazione tra comprensione e generazione garantisce una qualità superiore nella produzione linguistica, perché ogni parte del modello è ottimizzata per uno scopo preciso.

Un problema che i modelli precedenti non riuscivano a risolvere era quello della sequenza: come far capire a una macchina che l’ordine delle parole conta? La risposta sta nel positional encoding, un sistema che aggiunge informazioni sulla posizione di ogni token, permettendo al modello di comprendere la struttura grammaticale e la coerenza sintattica delle frasi.

Il Transformer ha fatto da trampolino per tutti i modelli di linguaggio moderni, compresi gli LLM più avanzati. Ha reso possibile l’elaborazione simultanea di interi blocchi di testo, aumentando esponenzialmente la velocità e la qualità del training. Ed è proprio grazie a questa architettura che oggi possiamo dialogare con intelligenze artificiali che, pur prive di coscienza, simulano il pensiero linguistico umano con una precisione spiazzante.

Dove si usano i Large Language Models? Applicazioni nella vita di tutti i giorni

Parlare di large language models non significa più trattare un tema relegato ai laboratori di ricerca o ai team di ingegneri dell’intelligenza artificiale. Oggi, un LLM è parte integrante della nostra quotidianità, anche quando non ne siamo consapevoli. Le interazioni digitali si sono trasformate radicalmente: ciò che prima sembrava complesso, macchinoso, distante, ora è diventato fluido, naturale, quasi umano. La differenza la fa proprio lui, il modello di linguaggio.

Ogni volta che interagiamo con un chatbot sul sito di un’assicurazione, ogni volta che riceviamo un suggerimento coerente da un assistente virtuale, ogni volta che un contenuto sembra creato apposta per noi, dietro c’è un large language model. Non una semplice sequenza di regole o script, ma un sistema capace di comprendere input ambigui, contestualizzare e restituire un output che pare scritto da una persona. Questo è il nuovo standard con cui ci confrontiamo: intelligenze addestrate a comunicare.

Gli LLM non sono invisibili. Sono integrati. In piattaforme e-commerce, nei software gestionali, nelle app educative. Non è un futuro ipotetico. È ciò che accade già ora, silenziosamente, mentre leggiamo una newsletter ottimizzata, mentre parliamo con un assistente vocale, mentre un sistema ci traduce istantaneamente una pagina web. Queste non sono funzionalità “accessorie”. Sono interfacce cognitive costruite su modelli linguistici evoluti.

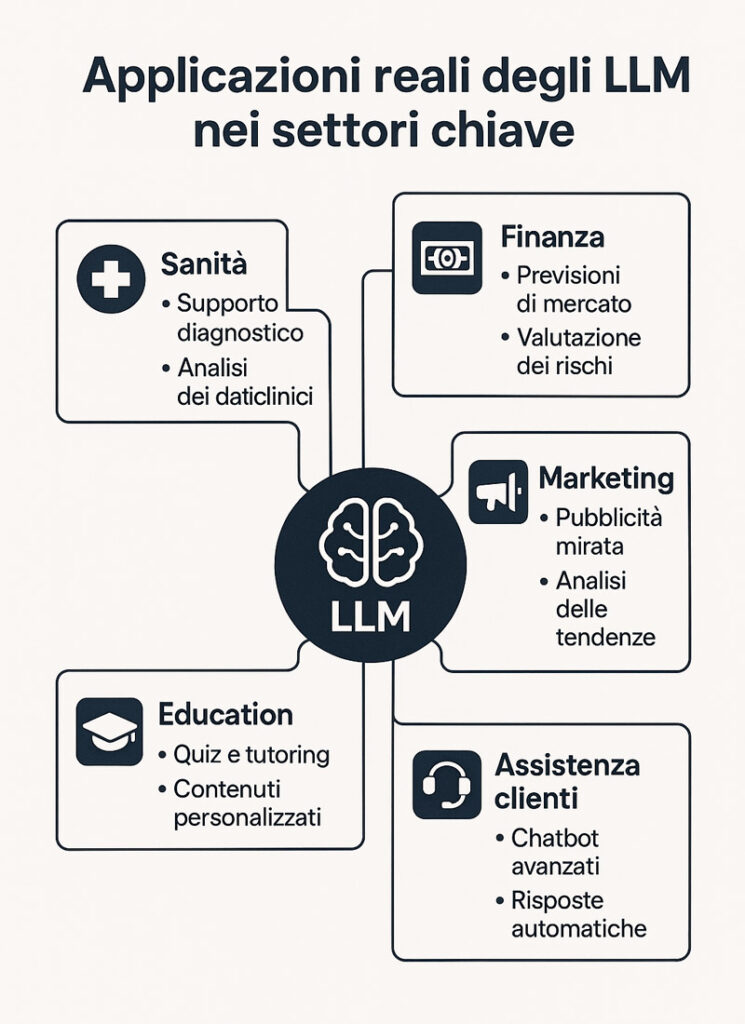

In uno scenario dominato dall’interconnessione, la capacità di un sistema di capire e generare linguaggio naturale non è solo utile: è strategica. Che si tratti di sanità, istruzione, customer care, marketing o intrattenimento, l’integrazione di un LLM non riguarda più l’efficienza. Riguarda l’esperienza. E un’esperienza più umana, più empatica, più intelligente è il nuovo punto di riferimento per ogni settore che aspiri a evolvere davvero.

Dalla medicina al marketing: esempi concreti di LLM in azione

Non serve guardare al futuro: i large language models sono già protagonisti in molti settori chiave. Non perché sostituiscano gli umani, ma perché moltiplicano la capacità di comprensione, analisi e comunicazione. In medicina, ad esempio, un LLM può analizzare in pochi secondi referti clinici, sintetizzare cartelle, proporre piani terapeutici coerenti con linee guida internazionali. Non prende decisioni, ma fornisce supporto cognitivo al medico, accelerando processi e migliorando la qualità dell’informazione.

Nel marketing, invece, la trasformazione è ancora più visibile. Gli LLM alimentano sistemi di content generation capaci di produrre testi pubblicitari, articoli SEO, descrizioni prodotto e script video. Non testi “a caso”, ma ottimizzati per target, tono, canale. Il risultato è un flusso continuo di contenuti personalizzati, adattivi, progettati per aumentare conversioni e fidelizzazione. In questo contesto, la capacità del modello di analizzare semanticamente le esigenze del pubblico diventa un vantaggio competitivo enorme.

Anche il settore legale comincia ad affidarsi agli LLM: analisi contrattuali, redazione di pareri preliminari, interpretazione giurisprudenziale. Lo stesso vale per il giornalismo e la ricerca accademica, dove la generazione automatica di testi sintetici e coerenti consente agli esperti di risparmiare tempo su compiti ripetitivi per concentrarsi sull’analisi critica.

E poi ci sono gli chatbot evoluti, non più semplici risponditori di FAQ, ma interfacce conversazionali intelligenti, in grado di affrontare domande complesse, gestire conversazioni multilivello, mantenere coerenza e tono. Che si tratti di un cliente che chiede assistenza o di uno studente che fa domande, l’LLM risponde come un consulente esperto, sempre contestualizzato, sempre reattivo.

In ogni scenario, l’efficacia dell’LLM non si misura solo nei risultati, ma nel tipo di relazione che costruisce con l’utente: una comunicazione fluida, naturale, affidabile. È questa la vera rivoluzione.

Creatività, supporto clienti, apprendimento: l’impatto degli LLM

Un modello di linguaggio oggi non è soltanto un elaboratore testuale. È un alleato creativo, un mentore digitale, un assistente personalizzato. Ecco perché l’impatto degli LLM sulla nostra vita va ben oltre l’efficienza operativa: trasforma il modo in cui apprendiamo, risolviamo problemi e costruiamo contenuti.

Nel mondo della creatività, gli LLM stanno ridefinendo i confini del possibile. Scrivono articoli, sceneggiature, poesie, lettere, prompt artistici. Ma non lo fanno in modo meccanico. Apprendono il tono, l’intenzione, il registro. Collaborano con il creatore umano, suggerendo strutture, migliorando frasi, proponendo idee. Lungi dall’essere meri strumenti di copia, diventano co-autori virtuali in grado di amplificare l’ispirazione.

Nel supporto clienti, il modello di linguaggio ha già cambiato tutto. Un’azienda può offrire assistenza 24/7 in decine di lingue, senza dover gestire un team globale. Il sistema capisce l’urgenza, distingue richieste semplici da quelle critiche, reindirizza se necessario ma spesso risolve in autonomia. Il risultato? Clienti soddisfatti, costi ridotti, brand percepito come presente e competente.

Anche nell’apprendimento, l’LLM si rivela trasformativo. Non è un motore di ricerca. È un tutor interattivo. Può spiegare un concetto con esempi personalizzati, adattare il linguaggio in base all’età dell’utente, proporre esercizi, correggere errori. Che si tratti di uno studente delle superiori o di un professionista in formazione continua, l’LLM si modella sull’utente, offrendo un’esperienza educativa realmente flessibile.

E infine c’è il text-to-speech, che trasforma il linguaggio scritto in parlato naturale. Un’integrazione fondamentale per rendere i contenuti accessibili, creare podcast, guide vocali, o migliorare l’interazione con assistenti virtuali. Non si tratta più di “robot che parlano”, ma di voci che interpretano il senso del discorso, enfatizzano, modulano, coinvolgono.

È così che i modelli di linguaggio stanno ridefinendo il nostro rapporto con l’intelligenza artificiale: non come meri strumenti, ma come compagni cognitivi. Assistono, imparano, suggeriscono. E in molti casi, ci sorprendono.

Perché i modelli di linguaggio stanno conquistando il mondo del lavoro e del web

Il cambiamento non è più futuro. È in corso. L’ascesa dei modelli di linguaggio nel contesto lavorativo e digitale non è una moda né un trend momentaneo, ma il risultato di un’evoluzione tecnologica che ha finalmente reso l’intelligenza artificiale accessibile, operativa, strategica. In un mondo dove la comunicazione è sempre più centrale e il tempo è la risorsa più preziosa, il large language model rappresenta la convergenza perfetta tra efficienza e intelligenza.

Oggi le aziende non cercano solo strumenti che automatizzano. Cercano soluzioni che comprendano. Un large language model, a differenza dei software tradizionali, è in grado di leggere un input testuale, decodificarne l’intento, riconoscerne la tonalità, adattare la risposta in base al contesto. Non è semplicemente “reattivo”. È attivamente contestuale, ed è proprio questa capacità che sta ridefinendo le dinamiche produttive, le interazioni cliente-brand, le strategie editoriali e persino i flussi decisionali.

La sua integrazione nelle realtà aziendali è trasversale: customer care, content strategy, formazione interna, business intelligence, lead generation. E ogni volta che entra in azione, il risultato è lo stesso: risposte più rapide, contenuti più efficaci, processi più snelli. Sul web, poi, l’effetto è amplificato: SEO, UX, automazione marketing e produzione di contenuti sono oggi terreni fertili dove il modello di linguaggio fiorisce, trasformando routine complesse in esperienze immediate.

Non si tratta solo di efficienza. Si tratta di qualità dell’interazione, intelligenza distributiva, personalizzazione scalabile. In un’epoca in cui la differenza non la fa più solo il prodotto, ma il modo in cui viene comunicato, raccontato, posizionato… il large language model è la leva definitiva per emergere. E chi ha già imparato a sfruttarlo non torna indietro.

Cosa rende un LLM così potente: intelligenza contestuale e flessibilità

La forza di un large language model non risiede soltanto nel numero impressionante di parametri o nella mole di dati con cui è stato addestrato. Il suo vero potere nasce dalla capacità di comprensione semantica e dalla flessibilità contestuale. È qui che la sua superiorità rispetto ad altri modelli diventa evidente e misurabile.

Un LLM non si limita a generare risposte: legge tra le righe. Riconosce ambiguità, ironia, variazioni stilistiche. Capisce non solo cosa viene detto, ma come e perché viene detto. Questa sensibilità linguistica è frutto della sua architettura neurale avanzata, che permette al modello di generalizzare da esempi concreti per produrre contenuti coerenti, pertinenti, e spesso sorprendenti.

Grazie alla generalizzazione semantica, l’LLM non è vincolato a uno specifico dominio. Può adattarsi a settori diversi – dalla medicina alla finanza, dalla moda al diritto – senza bisogno di riscrivere il suo codice o riformularne la logica. Questa flessibilità lo rende uno strumento trasversale e universale, adatto a team creativi, analisti, sviluppatori, formatori, content strategist.

Ma c’è di più: un large language model è anche reattivo in tempo reale. È in grado di adattare la sua produzione linguistica sulla base di interazioni dinamiche. Cambia tono, registro, profondità in funzione dell’utente. In un sistema che apprende e si aggiorna costantemente, ogni input è un’occasione per perfezionarsi, per diventare più preciso, più empatico, più utile.

Questa combinazione – intelligenza semantica profonda, flessibilità cross-domain, reattività immediata – è ciò che rende un LLM uno strumento che potenzia la mente umana. Non la sostituisce. La estende. E in questa estensione c’è tutto il vantaggio competitivo che oggi le imprese stanno imparando a sfruttare con lucidità.

SEO, UX, produttività: come i modelli di linguaggio migliorano l’esperienza digitale

L’impatto degli LLM sull’esperienza digitale non si limita alla generazione di testi corretti. È un cambio di paradigma nell’intero ecosistema online. La loro capacità di ottimizzare contenuti, migliorare l’interfaccia utente e automatizzare la produzione rende questi modelli alleati strategici nel potenziamento della produttività e del posizionamento digitale.

Sul fronte SEO, un modello di linguaggio è in grado di comprendere l’intento di ricerca, riconoscere le entità semantiche, strutturare testi in modo che siano non solo leggibili, ma anche perfettamente allineati con gli algoritmi dei motori di ricerca. Non si tratta più di keyword stuffing, ma di generare contenuti realmente utili, informativi, pertinenti e ben formattati, che soddisfano i bisogni dell’utente e le regole della SERP.

Dal lato UX, l’LLM diventa parte dell’interfaccia. Con chatbot conversazionali, FAQ dinamiche, microcopy personalizzati e interazioni contestuali, l’esperienza utente diventa fluida, intuitiva, umana. Il visitatore di un sito non ha più bisogno di cercare: può semplicemente chiedere. E il sistema risponde, con precisione e tono adeguato.

In ambito produttività, il contributo è tangibile. Creazione automatica di bozze, revisione linguistica, adattamento di testi per diversi target, localizzazione multilingua. Il tempo risparmiato diventa spazio mentale liberato per attività a più alto valore aggiunto. È il passaggio da un lavoro operativo a un lavoro strategico, guidato da intelligenza aumentata.

L’LLM non è uno strumento passivo. È una mente sintetica che lavora al fianco di chi crea, comunica e progetta. Migliora il contenuto, amplifica l’intento, anticipa i bisogni. Per questo sta diventando il fulcro invisibile dell’interazione digitale moderna: silenzioso, ma determinante.

Quando sbagliano gli LLM? Bias, allucinazioni e limiti tecnologici

Un large language model può generare testo impeccabile, risposte articolate, contenuti coerenti. Ma non è infallibile. Anzi, la sua potenza può trarre in inganno, portando a una pericolosa sovrastima delle sue capacità cognitive. Dietro l’eleganza formale delle frasi si celano vulnerabilità strutturali che, se ignorate, possono minare la fiducia, l’affidabilità e persino l’etica delle applicazioni basate su modelli di linguaggio. Comprendere i limiti di un LLM è fondamentale tanto quanto comprenderne le potenzialità.

Il primo nodo critico è la qualità dei dati su cui il modello viene addestrato. Ogni parola generata da un modello di linguaggio è frutto di miliardi di connessioni statistiche con contenuti preesistenti. Ma quei contenuti — articoli, forum, social media, enciclopedie digitali — non sono neutrali. Portano con sé errori, pregiudizi, polarizzazioni, distorsioni culturali. E il modello, per quanto sofisticato, non distingue il vero dal falso, il giusto dallo sbagliato. Riconosce solo pattern frequenti.

Un altro limite, intrinseco, è l’assenza di consapevolezza semantica. Un LLM non conosce, prevede. Non ha accesso a una “verità oggettiva”, ma solo a ciò che ha già visto. Questo significa che può replicare fake news, rafforzare stereotipi, escludere minoranze, o amplificare tendenze tossiche. Non per intenzione, ma per struttura.

Infine, esiste il rischio che l’interazione costante con un output fluente e convincente porti l’utente a fidarsi troppo, senza validare, senza verificare. Questo è il punto più delicato: quando un LLM sbaglia, non sbaglia come un umano. Sbaglia con sicurezza, e se non ne siamo consapevoli, non ce ne accorgiamo nemmeno. Ed è qui che risiede la vera sfida: progettare modelli sempre più equi, trasparenti, verificabili.

Bias nei modelli di linguaggio: il riflesso dei dati su cui imparano

Ogni large language model è uno specchio statistico del linguaggio umano. Ma quando lo specchio riflette bias strutturali, pregiudizi culturali, distorsioni cognitive, il rischio non è solo tecnico: è profondamente sociale. Un modello di linguaggio addestrato su contenuti contaminati non può che incorporare quella stessa contaminazione, riproducendola — spesso in modo invisibile — nei suoi output.

Il concetto di bias in un LLM non riguarda la malizia o l’intenzione. Non c’è volontà. C’è dipendenza dai dati. Se nei dataset prevalgono rappresentazioni sessiste, razziste, escludenti o banalmente false, il modello le assorbe come “norma”. La sua intelligenza è riflessiva, non critica. I bias non sono errori di calcolo, ma eredità di una realtà digitale imperfetta.

Queste distorsioni possono manifestarsi in modo sottile: un consiglio medico non aggiornato, una traduzione sessualmente stereotipata, un’esclusione sistemica di nomi femminili in contesti professionali. In altri casi, l’effetto è più grave: discriminazione nei processi automatizzati di selezione, confusione nel trattamento di tematiche sensibili, errata categorizzazione di contenuti legali o sanitari.

Per mitigare questi effetti, le ricerche in fair AI stanno cercando soluzioni strutturali. Dalla pulizia dei dataset alla creazione di algoritmi correttivi, fino alla costruzione di interfacce trasparenti in grado di segnalare all’utente i livelli di incertezza o la possibile presenza di bias. Tuttavia, anche i modelli più raffinati non possono garantire neutralità assoluta. Perché il linguaggio stesso — la materia prima degli LLM — è umano. E l’umano non è neutro.

La presenza di bias, quindi, non è un’anomalia. È una proprietà emergente. Ma proprio per questo va riconosciuta, misurata, affrontata. Perché un modello di linguaggio che pretende oggettività senza consapevolezza, rischia di diventare uno strumento che amplifica l’ingiustizia invece che ridurla.

Hallucination AI: quando un LLM inventa fatti e contenuti

Una delle problematiche più insidiose legate all’uso degli LLM è il fenomeno delle allucinazioni. Non parliamo di errori visibili, evidenti, ma di risposte che sembrano vere, coerenti, ben formattate… eppure totalmente inventate. È il punto in cui la fluidità linguistica inganna la logica. Dove il linguaggio diventa confabulazione credibile.

Quando un LLM produce un’affermazione errata, non lo fa per mancanza di informazione, ma per eccesso di coerenza. Il suo obiettivo non è la verità, ma la plausibilità. Il sistema predice la parola successiva in base a pattern statistici, non a fonti verificate. Per questo può affermare che un evento è accaduto, citare articoli inesistenti, attribuire scoperte scientifiche a nomi sbagliati. E lo fa senza esitazione, con una verosimiglianza pericolosamente alta.

Il rischio maggiore è che, agli occhi dell’utente medio, queste risposte appaiano affidabili. Perché usano un tono assertivo, citano numeri, riprendono la forma del discorso esperto. È qui che entra in gioco il problema della veridicità apparente: l’utente non ha strumenti immediati per distinguere una verità da una simulazione linguistica della verità.

Per contenere questo fenomeno, i ricercatori stanno implementando meccanismi di verifica automatica, citazione delle fonti, autovalutazione di affidabilità. Ma nessuna misura è ancora definitiva. Le allucinazioni rappresentano una sfida aperta, perché toccano il nucleo della logica predittiva stessa del modello.

Un LLM che confabula non è un modello mal funzionante. È un modello che funziona troppo bene, nel senso che genera esattamente ciò che dovrebbe: frasi fluenti, contestuali, credibili. Solo che talvolta, quelle frasi sono false. E finché il confine tra realismo e verità resterà così sottile, la responsabilità ultima non potrà che ricadere sull’essere umano che interroga il sistema, e sulla sua capacità critica di analizzare ciò che riceve.

Il futuro dei Large Language Models tra innovazione e consapevolezza

I large language models non hanno ancora espresso il loro massimo potenziale. L’impressione, oggi, è quella di trovarsi davanti a una fase intermedia, dove le capacità attuali — già straordinarie — non sono che un preludio a sviluppi ben più radicali, destinati a trasformare la natura stessa della tecnologia, dell’informazione e della comunicazione. La traiettoria evolutiva non punta solo a migliorare ciò che già esiste, ma a superare la soglia della specializzazione per avvicinarsi progressivamente a una intelligenza generale artificiale (AGI).

Questa prospettiva apre due scenari complementari. Da un lato, l’innovazione tecnica: modelli sempre più potenti, precisi, adattivi. Dall’altro, una crescente consapevolezza etica: la necessità di governare questi strumenti con criteri trasparenti, verificabili, inclusivi. Il futuro dei large language models non sarà scritto solo nei data center, ma nelle scelte che faremo su come usarli, formarli, limitarli. Ed è proprio in questo equilibrio tra espansione e responsabilità che si giocherà la partita centrale dell’AI nei prossimi anni.

Verso l’AGI: come gli LLM evolveranno nei prossimi anni

L’obiettivo finale della ricerca sugli LLM non è solo renderli più “bravi a scrivere”. È portarli oltre la specializzazione, verso una forma di intelligenza capace di generalizzare, imparare continuamente, adattarsi a compiti mai visti prima: in altre parole, verso l’AGI. L’intelligenza generale artificiale non sarà semplicemente una versione più grande di un large language model, ma un’entità cognitiva in grado di ragionare in modo trasversale, di applicare conoscenze acquisite in un dominio a problemi di natura completamente diversa.

Il percorso evolutivo di un large language model verso l’AGI può essere visualizzato chiaramente in questa timeline progressiva.

Per arrivarci, gli LLM dovranno sviluppare capacità di generalizzazione profonda, superando la logica predittiva a breve termine. Oggi, un LLM è eccezionale nel completare testi, nel rispondere a domande, nel sintetizzare informazioni. Ma ogni competenza è ancora il risultato di pattern estratti da dati passati. L’AGI, invece, richiederà un modello capace di apprendere in tempo reale, di aggiornare la propria struttura conoscitiva senza bisogno di essere riaddestrato su interi corpus testuali.

Un passaggio cruciale sarà l’integrazione del lifelong learning, ovvero la capacità del modello di apprendere in modo continuo, contestualmente, durante l’interazione con l’ambiente e con gli utenti. Questo non implica solo architetture più complesse, ma anche una revisione profonda dei protocolli di sicurezza, delle metriche di validazione e delle modalità di controllo umano. Una macchina che impara sempre è una macchina potenzialmente imprevedibile. Ma anche, per la prima volta, realmente intelligente.

Il large language model del futuro non sarà solo più grande, ma più cosciente del contesto, più resiliente agli errori, più vicino a una forma autentica di intelligenza computazionale. E in questo processo, il confine tra supporto e collaborazione si assottiglierà, aprendo a un nuovo rapporto tra umanità e macchina.

LLM personalizzati: modelli su misura per ogni esigenza

Parallelamente all’evoluzione verso l’AGI, si sta affermando un’altra tendenza chiave nel mondo dei modelli di linguaggio: la personalizzazione estrema. Le aziende, le organizzazioni e persino i singoli professionisti iniziano a chiedere LLM non più generici, ma progettati su misura, ottimizzati per linguaggi settoriali, obiettivi specifici, target definiti. E la tecnologia sta rispondendo, con un’accelerazione che non ha precedenti.

Un LLM personalizzato non nasce da zero. Si parte da un modello di base, già potente e generalista, e lo si sottopone a un processo di fine-tuning mirato. Questo significa addestrarlo ulteriormente su dataset specifici: manuali tecnici, casi aziendali, documentazione interna, tone of voice del brand. Il risultato è un’intelligenza linguistica che parla la lingua dell’azienda, rispetta la sua cultura, replica le sue priorità comunicative.

Questo approccio è già realtà in molti settori. Nel customer service, ad esempio, un LLM personalizzato può gestire ticket complessi mantenendo l’identità del marchio. In ambito sanitario, può rispondere a pazienti utilizzando un linguaggio conforme alle normative mediche. Nell’editoria, può generare contenuti coerenti con lo stile redazionale di una testata. L’impatto sulla produttività e sulla coerenza del brand è tangibile.

Ma c’è un altro vantaggio strategico: la privacy e il controllo dei dati. Un modello addestrato su contenuti interni può restare all’interno dell’infrastruttura aziendale, evitando di esporre informazioni sensibili a piattaforme esterne. Questo aspetto è cruciale in settori regolamentati, dove la gestione della conoscenza non può prescindere dalla sicurezza.

Il futuro dei modelli di linguaggio sarà sempre più frammentato e personalizzato, con micro-LLM progettati per rispondere a bisogni precisi, in ambienti chiusi e controllati. Non un’intelligenza per tutti, ma una per ognuno. E in questo scenario, l’AI diventerà davvero un’estensione naturale di ogni organizzazione, non un fornitore, ma un partner.

LLM vs SLM: quale modello scegliere e quando conviene

Nell’universo dell’intelligenza artificiale applicata al linguaggio, non esiste una soluzione “migliore in assoluto”. Esiste la scelta giusta in base al contesto. Contrapporre un large language model (LLM) a uno small language model (SLM) non significa definire un vincitore, ma capire quale modello di linguaggio risponde meglio a un bisogno specifico. È una questione di struttura, prestazioni, risorse, e soprattutto di obiettivi.

I LLM affascinano per la loro capacità di generare testo con fluidità umana, affrontare compiti complessi, adattarsi a dialoghi articolati. Ma richiedono risorse computazionali elevate, infrastrutture dedicate, tempi di risposta talvolta superiori. Gli SLM, invece, sono più agili, snelli, rapidi. Non hanno la stessa profondità semantica, ma sono estremamente efficienti su compiti circoscritti, dove la velocità conta più della sofisticazione.

L’avvento dei modelli di linguaggio personalizzabili ha reso il confronto ancora più rilevante. In contesti aziendali, dove serve scalare le interazioni o gestire grandi volumi di input simultanei, un LLM può fare la differenza. Ma in applicazioni embedded, mobile o in ambienti con risorse limitate, un SLM può garantire prestazioni eccellenti con un impatto minimo su memoria e potenza di calcolo.

La vera sfida è dunque saper valutare il rapporto tra capacità linguistica e sostenibilità operativa. Un LLM eccelle nella generazione creativa, nella comprensione contestuale, nell’elaborazione semantica complessa. Ma uno SLM brilla dove conta la velocità di risposta, il basso consumo energetico, l’integrazione fluida in sistemi edge.

La decisione non può essere ideologica. Va presa con consapevolezza. Conoscere le differenze tra i due significa saper progettare soluzioni intelligenti, efficienti e orientate all’uso reale.

Per aiutarti a scegliere il modello ideale, ecco una tabella comparativa chiara e visiva tra large language model e small language model.

Differenze strutturali e prestazionali tra Large e Small Language Models

Un large language model può contenere centinaia di miliardi di parametri. Un small language model, spesso, ne contiene qualche milione. Questo dato basta a sintetizzare la prima, fondamentale differenza: la scala computazionale. Ma la vera questione non è quanto è grande un modello. È come quella grandezza incide su prestazioni, precisione e utilizzo reale.

Un LLM, grazie alla sua vastità strutturale, riesce a comprendere meglio contesti ambigui, generare risposte articolate, memorizzare relazioni semantiche a lungo raggio. Questo lo rende ideale per attività di content generation, traduzioni complesse, analisi semantica profonda, assistenza conversazionale evoluta. Tuttavia, questa potenza ha un costo: maggior latenza, consumo energetico elevato, necessità di GPU avanzate.

Al contrario, uno small language model è progettato per eseguire compiti mirati e ricorrenti con minima richiesta di risorse. Questo li rende perfetti per applicazioni integrate nei dispositivi — come comandi vocali offline, suggerimenti contestuali, completamento di testo locale — dove la priorità non è l’intelligenza universale, ma l’immediatezza d’azione. In questo senso, un modello di linguaggio di piccole dimensioni può diventare un alleato indispensabile.

Altro elemento distintivo è la velocità di inferenza. Meno parametri significa risposte più rapide, tempi di caricamento ridotti, aggiornamenti più semplici. Questo si traduce in un’esperienza utente più fluida, soprattutto in ambiti mobili o in presenza di connessioni lente. L’LLM resta superiore in versatilità e qualità del contenuto, ma lo SLM si impone per praticità, autonomia, sostenibilità tecnica.

In sintesi: scalabilità vs efficienza. Scegliere tra un LLM e uno SLM non è un compromesso. È un allineamento alle esigenze specifiche di un progetto, un prodotto, un utente.

Scenari d’uso: quando un SLM batte un LLM

In un’epoca dominata da cloud e connettività pervasiva, può sembrare che un large language model sia sempre la scelta più sensata. Ma non è così. Esistono scenari dove un LLM è sovradimensionato, inefficiente, persino inadeguato. E sono proprio queste situazioni a sancire la rivincita degli SLM: piccoli, veloci, integrabili, perfetti per l’intelligenza distribuita.

Primo scenario: dispositivi mobili. Un’applicazione che offre suggerimenti linguistici, assistenza offline o riconoscimento vocale non può affidarsi a un LLM. Sarebbe troppo pesante da gestire, troppo lento nella risposta. Uno small language model localizzato, invece, può garantire interazione immediata, riservatezza dei dati, e una UX reattiva.

Secondo caso: embedded AI in sistemi IoT. Un SLM può vivere in un assistente domestico, in un impianto industriale, in un dispositivo medico. In questi ambienti, l’obiettivo non è scrivere articoli, ma capire e rispondere a comandi specifici con efficienza assoluta. Qui, l’edge computing incontra l’intelligenza artificiale, e solo modelli leggeri sono sostenibili.

Terzo ambito: progetti a basso budget o ad alta scalabilità. Un LLM richiede infrastrutture costose, hosting dedicati, manutenzione continua. Uno SLM può essere distribuito su migliaia di device senza costi proibitivi, offrendo una rete di microintelligenze cooperative, ognuna tarata sul proprio compito.

Infine, in contesti in cui la privacy è un vincolo — aziende, enti governativi, sanità — poter contare su modelli locali, che non trasmettono dati all’esterno, è spesso più importante della complessità del linguaggio. Uno SLM, qui, non è una seconda scelta: è l’unica opzione accettabile.

Il futuro dell’IA non sarà dominato dai soli giganti computazionali. Sarà una rete intelligente fatta di scelte architetturali precise, dove ogni modello — grande o piccolo — trova il suo spazio. E quando servono velocità, leggerezza, autonomia e controllo, è lo small language model che vince. Con discrezione, ma con efficacia assoluta.

LLM in azione: casi d’uso nei settori strategici

Oltre le demo, oltre le risposte spettacolari nei chatbot, i large language models stanno rivoluzionando silenziosamente interi settori strategici dell’economia globale. Sanità, finanza, formazione: non c’è ambito che non sia stato toccato da questa ondata trasformativa. E il cambiamento non riguarda soltanto la tecnologia, ma il modo stesso in cui si genera valore, si prendono decisioni, si gestisce la complessità.

Un LLM non è più un’innovazione sperimentale: è una risorsa concreta, già integrata nei flussi operativi di organizzazioni pubbliche e private. A differenza di altri strumenti, il modello di linguaggio è trasversale: si adatta al contesto, comprende lo specifico dominio, evolve nel tempo. È questa adattabilità semantica e contestuale che lo rende perfetto per settori dove l’interpretazione del linguaggio e la precisione delle informazioni sono vitali.

In un mondo dominato da informazioni caotiche e frammentate, l’LLM si impone come filtro intelligente e generatore di soluzioni pratiche. Non sostituisce l’esperto, ma lo potenzia. E laddove ogni secondo risparmiato può valere milioni, ogni errore evitato può salvare una reputazione (o una vita), l’introduzione di un large language model segna un punto di non ritorno.

Per comprendere come un large language model si adatti ai principali settori strategici, esplora questa infografica ad albero che sintetizza i suoi ambiti d’impiego e i vantaggi concreti.

Sanità, finanza, education: come i modelli di linguaggio stanno trasformando i settori chiave

Nel settore sanitario, l’utilizzo di un large language model ha già dimostrato di poter accelerare diagnosi, personalizzare trattamenti, ottimizzare la documentazione clinica. Grazie alla capacità di analizzare milioni di cartelle in pochi secondi, un LLM può generare diagnosi predittive evidenziando pattern invisibili all’occhio umano. Ma non si ferma qui: supporta il medico nella stesura delle note, riassume anamnesi, suggerisce protocolli in base alle linee guida scientifiche. Il risultato? Più tempo per il paziente, meno burocrazia.

In ambito finanziario, gli LLM giocano un ruolo decisivo nell’identificazione delle frodi, nell’ottimizzazione dei servizi clienti e nella generazione automatizzata di report. Le transazioni sospette vengono intercettate da modelli che riconoscono segnali linguistici nei messaggi, nei reclami, nelle descrizioni transazionali. Al contempo, l’automazione della reportistica consente agli analisti di concentrarsi su attività strategiche, riducendo tempi e margini d’errore. Reattività e affidabilità diventano asset competitivi.

Nel settore educational, gli LLM stanno reinventando l’apprendimento. Non più sistemi statici, ma veri e propri tutor intelligenti capaci di adattare spiegazioni, esercizi e feedback in funzione dello stile cognitivo dello studente. Il modello analizza le risposte, comprende dove l’utente inciampa, riformula le spiegazioni con un linguaggio più accessibile. È come avere un insegnante personale disponibile 24 ore su 24, per ogni livello scolastico e ogni disciplina.

La forza dei modelli di linguaggio non è solo nella potenza computazionale, ma nella capacità di adattarsi a settori regolamentati e sensibili, dove l’errore non è tollerabile e la qualità del linguaggio è una responsabilità concreta. Ecco perché stanno diventando standard invisibili, presenti ovunque, silenziosi ma decisivi.

Studi di caso: aziende che hanno vinto grazie agli LLM

I large language models non sono più un investimento futuribile: sono una leva strategica già ampiamente sfruttata da aziende che hanno compreso il vantaggio competitivo dell’AI linguistica. I casi di successo si moltiplicano in ogni settore, e la correlazione è chiara: integrare un LLM equivale a migliorare il ROI, aumentare la scalabilità, velocizzare i processi e ridurre i costi operativi.

Una compagnia assicurativa europea ha introdotto un LLM per automatizzare la gestione delle richieste di risarcimento. Il risultato? Riduzione del 47% nei tempi di risposta, aumento del 21% nella soddisfazione del cliente, e soprattutto una riduzione drastica degli errori formali nei documenti. Il tutto con un modello fine-tuned sul proprio storico linguistico interno.

Una banca statunitense ha implementato un large language model nel proprio help desk digitale. L’LLM gestisce oltre il 70% delle richieste in autonomia, con escalation solo per i casi più complessi. L’interazione è fluida, contestualizzata, coerente con il tone of voice aziendale. Risultato: meno carico sul call center e un incremento netto nella fidelizzazione dei clienti digitali.

Anche nel settore edtech, una piattaforma di formazione online ha utilizzato un LLM per creare percorsi di apprendimento personalizzati. Il modello analizza le risposte degli studenti, individua lacune, genera contenuti mirati e riformulazioni. Il tempo medio per raggiungere gli obiettivi didattici si è ridotto del 35%, mentre il tasso di completamento dei corsi è cresciuto di oltre il 50%.

Tutti questi casi hanno un tratto comune: l’automazione intelligente. Non si tratta solo di “fare di più con meno”, ma di potenziare la qualità delle interazioni, moltiplicare la precisione, rendere il linguaggio una risorsa attiva di business. Ecco perché le aziende che scelgono oggi gli LLM non stanno semplicemente aggiornando il software: stanno ridisegnando il proprio modello operativo, con una prospettiva radicalmente più efficiente e scalabile.

Sicurezza dei LLM: minacce, attacchi e contromisure

Dietro l’efficienza apparente di un large language model, esistono vulnerabilità sistemiche che, se ignorate, possono compromettere non solo l’affidabilità del modello, ma anche la sicurezza delle informazioni, l’integrità dei dati e la reputazione dei sistemi che lo adottano. L’LLM non è solo uno strumento linguistico: è una superficie d’attacco dinamica, che può essere sfruttata da soggetti malevoli con tecniche sempre più sofisticate.

La questione sicurezza non riguarda solo chi sviluppa il modello, ma soprattutto chi lo integra in ambienti produttivi o customer-facing. La complessità dei sistemi basati su modelli di linguaggio li rende difficili da controllare a priori: la generazione del testo avviene su base probabilistica, e proprio questa aleatorietà apre la porta a manipolazioni inaspettate. L’assenza di una vera “memoria semantica” e la mancanza di un sistema di giudizio nativo rendono gli LLM potenzialmente vulnerabili a contenuti dannosi, prompt malevoli, o estrazione di dati sensibili.

Il problema non è se un LLM sarà attaccato. È quando, come e quanto sarà pronto a difendersi. Ed è per questo che la sicurezza deve diventare una componente strutturale nella progettazione, implementazione e gestione degli LLM. Serve un cambio di paradigma: dalla fiducia cieca alla validazione continua.

Le 10 vulnerabilità più critiche secondo OWASP

L’OWASP Foundation, punto di riferimento per la sicurezza nel mondo software, ha individuato le 10 vulnerabilità più pericolose nei large language models, una lista che oggi rappresenta lo standard globale per comprendere i rischi reali nell’adozione di questi sistemi. Comprendere questi punti deboli non è un’opzione: è un prerequisito per ogni implementazione sicura.

1. Prompt injection: attacchi che manipolano l’input per ottenere un comportamento imprevisto, inducendo il modello a produrre contenuti dannosi, sbilanciati o illegali.

2. Data poisoning: corruzione intenzionale dei dati di training o fine-tuning, con lo scopo di introdurre bias, errori o comportamenti fuorvianti nel modello.

3. Model denial of service: uso di richieste particolarmente complesse per sovraccaricare le risorse computazionali del modello, rallentandone o bloccandone l’operatività.

4. Inadequate sandboxing: mancanza di ambienti isolati per l’esecuzione del modello, che espone l’infrastruttura ad accessi imprevisti o compromissioni.

5. Unauthorized code execution: esecuzione di comandi o codice attraverso input linguistici, con il rischio di compromettere l’intero sistema backend.

6. Sensitive information disclosure: capacità del modello di “ricordare” e rigenerare frammenti sensibili visti durante il training, come password o dati personali.

7. Overreliance: fiducia eccessiva nei contenuti generati dal modello, spesso assunti come veri senza validazione esterna, con conseguenze legali o operative.

8. Insecure plugin interaction: integrazione non protetta con API o plugin esterni che possono fungere da vettori d’attacco o di fuga dati.

9. Output leakage: generazione non intenzionale di informazioni confidenziali attraverso l’output, in risposta a prompt mirati.

10. Auditability e monitoring insufficiente: assenza di strumenti per tracciare, loggare e rivedere le risposte del modello, rendendo difficile l’individuazione di abusi.

Ogni punto rappresenta una potenziale crepa. Ed è su queste crepe che si concentrano oggi gli sforzi dei team di AI safety e cybersecurity.

Per una panoramica immediata e visiva dei rischi di un large language model, ecco l’elenco delle vulnerabilità più critiche secondo OWASP AI.

Difendere i modelli di linguaggio: best practice per la sicurezza AI

Proteggere un modello di linguaggio non significa solo blindare il codice o criptare i dati. Significa costruire un ecosistema difensivo proattivo, capace di anticipare gli attacchi, isolare i comportamenti anomali, e mitigare i rischi in tempo reale. In un sistema così adattivo come un LLM, la sicurezza non può essere statica: deve essere continua, dinamica, intelligente.

Una prima strategia è l’implementazione di sandboxing rigido. Separare l’ambiente in cui il modello genera output da quello in cui le informazioni sensibili vengono gestite consente di evitare l’interferenza diretta tra livelli critici del sistema. Questo isolamento previene l’esecuzione di codice non autorizzato e limita la portata di eventuali exploit.

Parallelamente, diventa fondamentale la validazione dell’output. Ogni risposta generata dovrebbe passare attraverso filtri semantici, modelli secondari o logiche euristiche che ne verifichino la pertinenza, la sicurezza e l’aderenza alle policy. Questo vale soprattutto in contesti legali, medici o finanziari, dove l’errore non è tollerabile.

Il fine-tuning responsabile è un altro elemento chiave. Non basta adattare il modello: è necessario farlo su dataset controllati, aggiornati, privi di contenuti tossici o sensibili. Inoltre, ogni versione personalizzata deve essere auditabile, tracciabile, sottoposta a stress test regolari.

Infine, non può mancare il monitoraggio in tempo reale: sistemi che registrano ogni prompt, ogni risposta, ogni anomalia. Questo consente non solo di rispondere agli attacchi, ma anche di apprendere da essi, migliorando la resilienza del modello nel tempo.

Un large language model sicuro non nasce dal caso. È il frutto di una progettazione consapevole, di un’architettura difensiva multilivello, e di una cultura organizzativa che riconosce l’intelligenza artificiale non solo come opportunità, ma come responsabilità. Ed è solo affrontando il rischio alla radice che possiamo garantirci un futuro dove l’AI sia davvero affidabile, utile e sotto controllo.

L’impatto ambientale degli LLM: un prezzo invisibile?

Dietro ogni interazione fluida con un large language model, dietro ogni risposta coerente, ogni contenuto generato, si cela un costo nascosto. Non si tratta di un valore economico, ma di una spesa energetica reale, che si traduce in emissioni, consumo di risorse, impronta ecologica. Il fascino dei modelli di linguaggio non può più prescindere da una domanda scomoda: quanto costa davvero, all’ambiente, questa rivoluzione?

Ogni fase della vita di un LLM — dal pre-training iniziale su supercomputer fino all’inferenza in tempo reale — comporta operazioni massicce sui processori grafici (GPU). E sebbene questi modelli siano virtuali, il loro funzionamento dipende da infrastrutture fisiche che richiedono enormi quantità di energia elettrica. Centri dati alimentati giorno e notte, sistemi di raffreddamento, hardware specializzato: un ecosistema energivoro in continua espansione.

Il problema non è solo nella scala. È nella tendenza a moltiplicare i modelli, ad addestrarne di sempre più grandi, senza considerare che ogni miliardo di parametri in più implica incrementi esponenziali in termini di calcolo e, quindi, di emissioni di CO₂. Ed è proprio questa variabile, spesso ignorata, che impone oggi una riflessione urgente: come conciliare l’innovazione con la responsabilità ambientale?

L’adozione incontrollata di LLM ad alta intensità computazionale rischia di contraddire ogni sforzo globale verso la sostenibilità. Un’AI che consuma più di quanto restituisce in efficienza rischia di diventare parte del problema, non della soluzione. Ecco perché parlare di AI significa, oggi, parlare anche di impatto climatico.

Questa illustrazione evidenzia l’impatto reale di un large language model sull’ambiente in termini di energia consumata e CO₂ emessa.

Costo energetico e carbon footprint dei Large Language Models

L’addestramento di un large language model come GPT-3 o PaLM può richiedere centinaia di megawattora. Si stima che il pre-training di un singolo modello di fascia alta generi emissioni paragonabili a quelle di un’auto a benzina che percorre oltre 600.000 chilometri. Questi numeri non sono retorica: sono il risultato di benchmark misurati su consumi reali delle GPU, sulle ore macchina impiegate, sulle configurazioni di calcolo distribuito nei data center.

Ogni fase di training sfrutta migliaia di processori grafici che lavorano in parallelo, spesso per settimane o mesi. Il GPU energy cost dipende sia dall’efficienza del chip che dal tipo di task eseguito. I modelli di linguaggio, in particolare, sono tra i più energivori: richiedono operazioni complesse di moltiplicazione matriciale, backpropagation e ottimizzazione iterativa.

Ma il problema non si ferma al training. Anche l’inferenza — cioè la generazione effettiva dei testi — comporta un carico computazionale continuo. Ogni volta che un utente fa una domanda, il modello deve attivarsi, generare una sequenza, calcolare le probabilità di ogni token, mantenere il contesto. Su larga scala, con milioni di utenti attivi, questo si traduce in una spesa energetica giornaliera consistente.

A pesare non è solo la potenza richiesta, ma anche la localizzazione geografica dei data center. Se alimentati da fonti fossili, l’impatto ambientale cresce. Se inseriti in reti a energia rinnovabile, si attenua, ma non scompare. Serve dunque una governance più trasparente, che monitori il ciclo di vita computazionale del modello, che misuri — e pubblicamente — la sua impronta ecologica.

Un modello di linguaggio non può più essere giudicato solo sulla base della sua accuratezza linguistica. Deve essere valutato anche in termini di efficienza energetica, footprint di carbonio e impatto globale. Solo così l’AI potrà essere non solo intelligente, ma anche etica e sostenibile.

Verso una AI green: come rendere sostenibili i modelli di linguaggio

L’evoluzione dei LLM non deve necessariamente passare per una crescita smisurata dei parametri. Può — e deve — seguire la strada dell’ottimizzazione intelligente, riducendo il peso computazionale senza sacrificare le prestazioni. È qui che entrano in gioco tecniche avanzate come la distillazione del modello, il pruning e l’adozione di architetture più leggere e modulari.

La distillazione consiste nel trasferire la conoscenza da un modello grande (teacher) a uno più piccolo (student), che riesce a replicarne le performance in modo più efficiente. Questo approccio consente di ridurre consumo energetico, latenza e footprint ambientale, pur mantenendo una capacità linguistica comparabile. Alcune aziende sono già riuscite a implementare versioni distillate di LLM per mobile, edge device e chatbot offline.

Un’altra tecnica chiave è il pruning, ovvero l’eliminazione dei nodi e delle connessioni meno rilevanti all’interno della rete neurale. Questa “potatura algoritmica” riduce significativamente il numero di operazioni necessarie, alleggerendo il modello senza comprometterne la qualità. È un metodo che richiede una fase di ottimizzazione fine, ma che può tagliare fino al 90% dei costi computazionali.

Oltre all’architettura, conta l’infrastruttura. Scelte come la migrazione su cloud sostenibili, l’utilizzo di server alimentati da fonti rinnovabili e l’ottimizzazione dei data center sono leve decisive. Alcuni provider stanno già sviluppando LLM-as-a-service green, che certificano la loro impronta di carbonio e ne garantiscono la compensazione attraverso progetti ambientali.

Anche l’adozione di modelli adattivi e modulari — attivati solo su richiesta, ridimensionati in tempo reale, gestiti in ambienti containerizzati — rappresenta una direzione promettente. Non serve che ogni LLM sia sempre attivo: basta che sia sempre pronto, quando serve.

Il futuro dell’AI sostenibile passa da qui: dalla progettazione consapevole, dalla misurazione trasparente, dalla volontà collettiva di non barattare innovazione con impronta ecologica. Un LLM può essere green. Ma solo se lo vogliamo davvero.

Large Language Model: sintesi, consapevolezza e visione per il futuro

Il large language model non è un fenomeno passeggero né un’utopia tecnologica in attesa di conferme. È una realtà concreta, già operativa, che sta trasformando il modo in cui comunichiamo, apprendiamo, lavoriamo e interagiamo con i sistemi informativi. Il suo impatto è sistemico. La sua capacità di adattamento lo rende uno strumento trasversale. La sua evoluzione lo proietta verso scenari in cui intelligenza artificiale, linguaggio e valore umano si fonderanno in nuove forme di conoscenza ibrida.

Non si tratta più di “capire cos’è” un modello di linguaggio, ma di prenderne atto: è già parte integrante dei nostri flussi produttivi, della nostra ricerca, della nostra cultura digitale. Abbiamo imparato a sfruttarne l’efficienza, a valorizzarne la creatività, a stupirci della sua naturalezza. Ora è il momento di andare oltre l’entusiasmo e costruire una consapevolezza matura. Il vero salto qualitativo sarà misurato non dalla sua precisione, ma dalla nostra capacità di governarne le implicazioni.

Un LLM può generare contenuti coerenti, scrivere codice, suggerire strategie, supportare decisioni. Ma non pensa. Non conosce. Simula. E in questa simulazione risiede sia la sua potenza, sia il suo limite. Attribuirgli qualità umane significa confondere l’effetto con l’intenzionalità, esponendoci a errori sistematici. La consapevolezza, quindi, non è solo tecnica: è culturale. È ciò che ci permette di distinguere l’output brillante dalla verità. L’automazione dall’autorità.

Guardando avanti, il futuro dei large language models sarà scritto sulla base di scelte etiche, progettuali e ambientali. Innovazione continua non significa crescita incontrollata, ma intelligenza scalabile, sostenibile e verificabile. Ogni nuovo parametro dovrà portare non solo più performance, ma maggiore inclusività, più responsabilità, più trasparenza.

Il tempo delle sperimentazioni isolate è finito. Siamo nell’epoca della convergenza tra intelligenza sintetica e contesto umano. E in questa convergenza, il modello di linguaggio non sarà più solo un supporto: sarà un’estensione del nostro pensiero, della nostra creatività, della nostra capacità di agire nel mondo digitale con competenza e coscienza.

Il large language model non ci sostituirà. Ma ci accompagnerà. E la qualità di questo accompagnamento dipenderà da quanto sapremo educarlo, contenerlo e renderlo parte di una visione collettiva che unisca progresso e consapevolezza. Perché non basta generare parole. Serve dare loro un senso. E farlo, oggi, è ancora — e fortunatamente — una responsabilità umana.

Domande Frequenti sui Large Language Models (LLM)

❓ Cos’è un Large Language Model (LLM)?

Un Large Language Model è un tipo di modello di intelligenza artificiale basato su reti neurali profonde, progettato per comprendere e generare linguaggio naturale. Utilizza architetture come i trasformatori per analizzare grandi quantità di testo e apprendere le strutture linguistiche.

❓ Come funziona un LLM?

Gli LLM funzionano attraverso un processo di pre-training su vasti dataset di testo, seguito da un fine-tuning su compiti specifici. Utilizzano meccanismi di attenzione per comprendere il contesto e generare risposte coerenti.

❓ Quali sono le applicazioni pratiche dei Large Language Model?

Gli LLM trovano applicazione in vari settori, tra cui la generazione di contenuti, la traduzione automatica, l’assistenza clienti, l’analisi del sentiment e la scrittura di codice. Ad esempio, possono essere utilizzati per automatizzare risposte in chatbot o per generare descrizioni di prodotti.

❓ Quali sono i vantaggi e le sfide nell’uso degli LLM?

I vantaggi includono la capacità di automatizzare compiti linguistici complessi e migliorare l’efficienza operativa. Le sfide comprendono il rischio di bias nei dati di addestramento, l’elevato consumo energetico e la possibilità di generare informazioni inesatte o “allucinazioni”.

❓ Come vengono addestrati i Large Language Model

Gli LLM vengono addestrati su grandi corpus di testo utilizzando tecniche di apprendimento non supervisionato. Successivamente, possono essere affinati su compiti specifici attraverso l’apprendimento supervisionato o il reinforcement learning.

❓ Cosa significa “fine-tuning” in un Large Language Model?

Il fine-tuning è il processo di adattamento di un LLM pre-addestrato a un compito specifico, utilizzando un dataset più piccolo e mirato. Questo permette al modello di specializzarsi in determinate attività, migliorando la sua performance in contesti specifici.

❓ Quali sono i rischi associati all’uso degli LLM?

I rischi includono la generazione di contenuti inaccurati, la perpetuazione di bias presenti nei dati di addestramento e problemi di privacy. È fondamentale implementare misure di sicurezza e monitoraggio per mitigare questi rischi.

❓ I Large Language Model possono comprendere il significato del testo?

Gli LLM non comprendono il significato nel senso umano, ma sono in grado di modellare e generare testo basandosi su pattern statistici appresi durante l’addestramento. La loro “comprensione” è una simulazione basata su correlazioni nei dati.

❓ Qual è l’impatto ambientale degli LLM?

L’addestramento e l’esecuzione degli LLM richiedono significative risorse computazionali, contribuendo a un elevato consumo energetico e a emissioni di CO₂. Sono in corso ricerche per rendere questi modelli più efficienti e sostenibili.

❓ Come evolveranno gli LLM in futuro?

Si prevede che gli LLM diventeranno più efficienti, con una maggiore capacità di generalizzazione e una migliore comprensione contestuale. L’integrazione con altre tecnologie e l’adozione di pratiche di sviluppo responsabili guideranno la loro evoluzione.