Creare musica con intelligenza artificiale non è più un esperimento da laboratorio: è diventato uno dei terreni più interessanti per chi produce contenuti, lavora nel sound design o vuole dare forma a idee musicali senza dover necessariamente padroneggiare da subito strumenti complessi.

Da creator che vive da sempre tra tecnologia e suono, questo passaggio mi è arrivato come naturale. La mia passione per la musica e la tecnologia — faccio il DJ da quando avevo 14 anni, ho avuto uno studio di registrazione e ho inciso diversi EP come produttore — mi ha spinto a capire rapidamente cosa si può fare davvero oggi con gli strumenti di AI dedicati alla musica, e soprattutto cosa non si può ancora fare. Non da curioso: da uno che queste cose le ha usate sul campo.

Negli ultimi anni i generatori musicali hanno fatto un salto enorme, ma la promessa di “creare una traccia in pochi secondi” è solo una parte della storia. Per molti creator il vero problema non è tanto trovare il tool giusto, ma riuscire a capire come integrare l’AI dentro un workflow reale, come usarla per velocizzare un’idea, per testare una direzione stilistica, per creare materiali sonori su cui costruire un arrangiamento, o semplicemente per avere una base da rifinire in DAW. La differenza tra chi ottiene risultati professionali e chi rimane deluso sta quasi sempre nella capacità di usare l’AI come strumento, non come sostituto dell’esperienza.

In questo articolo entreremo esattamente in questa logica: capiremo quali strumenti funzionano e perché, come scegliere un modello AI adatto al proprio stile, come evitare i limiti più frequenti (compressione aggressiva, incoerenze armoniche, loop poveri), e soprattutto come inserire l’AI nella catena creativa senza snaturare la propria identità sonora. Scoprirai workflow concreti, casi reali e criteri tecnici che ti permettono di valutarne la qualità, così da non dipendere più dai generatori “a scatola chiusa”.

Alla fine avrai un quadro completo su cosa significa creare musica con intelligenza artificiale oggi: non una scorciatoia, ma una nuova estensione della creatività che può funzionare solo se la conosci davvero.

• L’AI non crea “musica finita”, crea materiale sonoro utile.

La qualità finale dipende da come la integri nel tuo workflow: drafting melodico, sound exploration, pre-produzione rapida.

• Scegli il modello in base all’obiettivo, non alla moda del momento.

Generatori “test-to-music” sono ottimi per concept rapidi; modelli “loop-based” sono migliori per structure building; tool “stem-oriented” servono per remix e resampling.

• Il 70% dei problemi nasce dalla mancata correzione post-generazione.

Compressione aggressiva, transienti schiacciati, code troppo brevi, incoerenza armonica: tutto risolvibile in DAW con EQ, multibanda leggero e micro-editing.

• L’AI accelera il processo, ma non decide il tuo stile.

Usala per trovare direzioni, generare variazioni, spingere idee; il risultato professionale arriva quando filtri e selezioni tu cosa tenere.

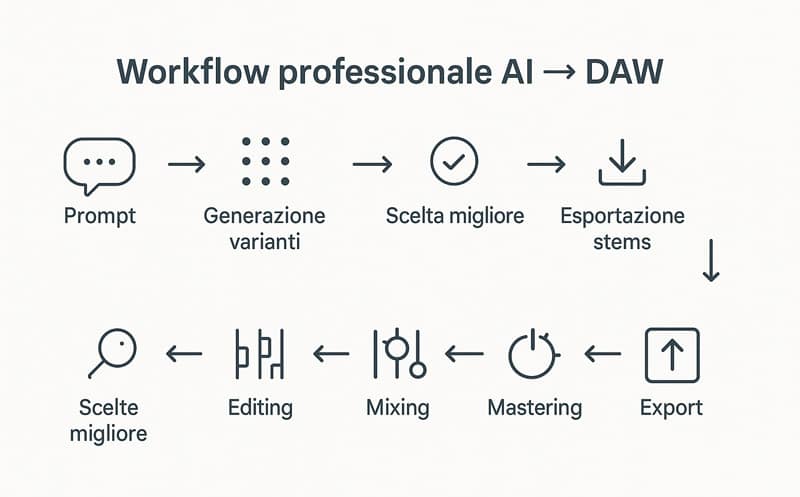

• Workflow consigliato per creator:

prompt → generazione 2–4 varianti → selezione → esportazione stems → refining in DAW → mastering leggero → pubblicazione.

• Miglior criterio di scelta di un tool:

valuta la controllabilità. Più puoi intervenire su timing, armonia, struttura, stems e dinamiche, più il tool è adatto a un creator serio.

Come funziona davvero la musica generata con l’intelligenza artificiale

La maggior parte dei creator sa cosa fa un generatore musicale, ma pochi sanno come prende decisioni un modello AI quando compone. Capire la logica interna è il primo passo per usarla davvero bene. I modelli “text-to-music”, i sistemi basati su diffusion e gli engine addestrati su dataset di loop/stems lavorano tutti in modi diversi, ma condividono un concetto chiave: generano probabilità, non certezze. Ciò significa che ogni scelta armonica, ogni variazione ritmica, ogni transiente è il risultato di un calcolo statistico su ciò che “dovrebbe” venire dopo, basato su ciò che il modello ha visto milioni di volte.

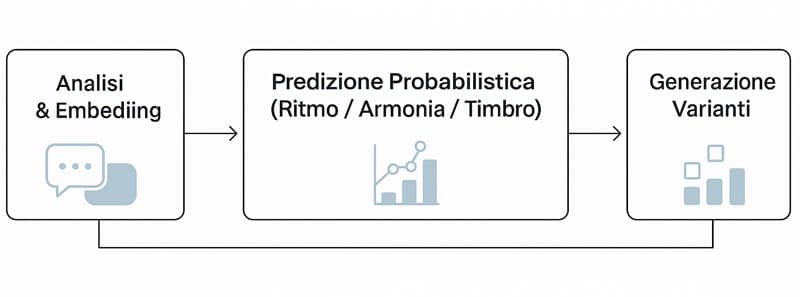

Questo flowchart aiuta a visualizzare in pochi secondi come un modello di intelligenza artificiale trasforma un prompt o un file audio in una generazione musicale. È uno degli elementi visivi più importanti perché chiarisce la logica interna dei modelli senza tecnicismi.

Come ragiona un modello AI quando crea musica

Quando dai un prompt o carichi un riferimento audio, l’AI traduce tutto in embedding — rappresentazioni numeriche di stile, ritmo, mood, armonia, texture. Da lì costruisce pattern coerenti che imitano quelle caratteristiche, senza copiarle.

Tre elementi determinano la qualità del risultato:

- Coerenza temporale → quanto bene l’AI gestisce transizioni, fill, rise, drop.

- Coerenza armonica → il modello cerca “zone tonali probabili”, non sempre corrette.

- Complessità timbrica → alcuni engine generano texture ricche, altri producono suoni più piatti.

🔧 Micro-esperienza : Durante i miei test su Suno, Producer, i modelli più moderni gestiscono bene groove e pattern, ma tendono a comprimere eccessivamente le dinamiche sopra i 4–6 kHz: ottimo per TikTok, meno per una release seria. Da qui l’importanza del refining in DAW.

Cosa significa questo per un creator: applicazione pratica

Capire la logica probabilistica ti permette di avere controllo. Se chiedi “melodic house, 122 BPM, synth warm” il modello userà template armonici tipici del genere, ma se aggiungi “struttura intro → build → drop” dai una roadmap concreta che aumenta la qualità del risultato.

Ecco un mini-workflow immediato:

prompt → generazione 4 varianti → scelta migliore → esportazione stems → refining EQ → miglioramento armonico → mastering leggero.

Checklist rapida:

- Il modello capisce gli stili, non le intenzioni non esplicite.

- Più dettagli dai, meno casualità ottieni.

- La qualità finale dipende al 50% da cosa fai dopo la generazione.

Come scegliere il tool giusto per creare musica con intelligenza artificiale

La domanda “qual è il miglior generatore di musica AI?” di solito è mal posta. Per un creator, la scelta non dipende dal tool più popolare, ma da quanto controllo vuoi sulla struttura, quanto contano per te gli stems, come gestisci mixing e mastering, e soprattutto che tipo di musica fai davvero. Gli engine AI non sono intercambiabili: ognuno è costruito per un obiettivo diverso. Alcuni sono eccellenti nel generare groove o melodie catchy, altri puntano sulla qualità timbrica, altri ancora sulla flessibilità di editing. Per questo la domanda giusta diventa: di quale tipo di AI hai bisogno per il tuo workflow?.

Non tutti i generi musicali rispondono allo stesso modo alla generazione tramite intelligenza artificiale. Alcuni richiedono maggiore controllo sui BPM, altri puntano più sulla coerenza armonica o sull’efficacia dei hook vocali. Questa tabella raccoglie le combinazioni ottimali tra stile musicale e tool AI, così puoi scegliere subito la soluzione più adatta alla tua produzione.

| Genere | Richieste tecniche | Tool consigliati | Note operative |

|---|---|---|---|

| Melodic House | Controllo BPM + stems | Suno | Ottimo per strutture emotive e build-up |

| Tech House | Groove stabile + bassline precisa | Suno | Serve refining per transienti |

| Pop | Hook vocali credibili | Suno | Ideale per spunti rapidi |

| Hip hop | Pattern ritmici + voce | Beatoven, Suno | Perfetto per demo veloci |

| Cinematic | Atmosfere + pad complessi | AIVA | Grande coerenza armonica |

I criteri tecnici che un creator deve valutare prima di scegliere un tool AI

Non tutti i generatori sono uguali. Prima di scegliere uno strumento, devi considerare alcuni aspetti tecnici che influenzano in modo diretto la qualità finale del tuo lavoro.

1. Controllabilità

Più un modello ti permette di definire struttura, intenzione, mood, BPM, energia, armonia → più professionale sarà il risultato. Suno, ad esempio, offre ottime varianti; Suno eccelle nella gestione degli stems.

2. Accesso agli stems

Se non puoi isolare kick, bassline, synth e voci, stai lavorando con un file “bloccato”. Ottimo per social, pessimo per release serie. Gli stems sono il 50% della qualità finale.

3. Coerenza armonica e stabilità del loop

Alcuni tool generano loop perfetti, altri “collassano” sul downbeat. Nei miei test, i modelli diffusion tendono a perdere precisione nei passaggi complessi.

4. Qualità timbrica pre-refining

Valuta la chiarezza sulle alte (4–10 kHz), la presenza sulle basse (40–80 Hz) e la gestione dei transienti. Qui si vede la differenza tra tool consumer e strumenti per creator seri.

🔧 Micro-esperienza : Ho confrontato AI generative di fascia consumer con tool pro: i primi saturano presto, i secondi mantengono headroom sufficiente per un mastering pulito.

Quale tool usare in base al tuo stile (applicazione pratica)

Ecco una sintesi operativa, valida per creator elettronici, pop, soundtrack e contenuti social:

- Melodic House / Tech House / EDM: scegli AI con gestione BPM + stems (Producer, Suno).

- Pop / Hip Hop / R&B: modelli text-to-music come Suno funzionano benissimo per generare idee veloci, hook vocali e strutture base.

- Contenuti social / trend: tool veloci con forte character sonoro (Suno v3/v4) sono perfetti per micro-formati.

- Sound design / cinematic: motori generativi con controllo timbrico avanzato (AudioCraft evoluzioni).

Per aiutarti a scegliere in modo rapido il tool più adatto al tuo stile e al tuo workflow, ho raccolto in una sola tabella i pro, i contro e il miglior utilizzo pratico delle principali piattaforme AI per creare musica. È un confronto pensato per i creator: semplice da leggere, immediato e soprattutto utile prima ancora di generare la tua prima traccia.

| Tool | Pro | Contro | Miglior utilizzo | Controllabilità |

|---|---|---|---|---|

| Suno | Generazioni rapide e creative | Output molto compresso | Hook vocali, idee veloci, concept | ★★★☆☆ |

| AIVA | Coerenza armonica molto stabile | Meno moderna timbricamente | Musica orchestrale, cinematic, ambient | ★★★☆☆ |

| Mubert | Perfetta per contenuti social | Limitata per produzioni complesse | Loop, background sonori | ★★☆☆☆ |

Checklist immediata

- Il tool perfetto non esiste, esiste quello perfetto per il tuo workflow.

- Se manca controllabilità → risultati casuali.

- Se mancano gli stems → niente qualità finale.

Il workflow pratico per creare musica con l’AI come un creator professionista

La qualità finale non dipende solo dall’AI: dipende dal workflow. È qui che la maggior parte dei creator si blocca o rimane delusa. Non è l’AI che sbaglia: è il processo a essere incompleto. Se tratti la generazione come un “file finale”, otterrai musica piatta, compressa, poco dinamica. Se invece la inserisci in una pipeline simile a quella di una produzione reale, il salto di qualità è immediato. Il workflow che segue è il più affidabile che abbia testato, sia per contenuti social che per release complete.

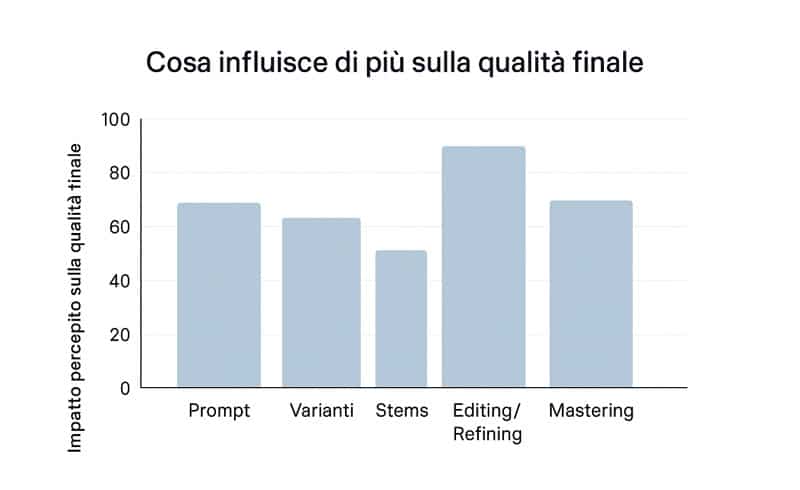

Questo grafico aiuta ia capire, con un colpo d’occhio, quali elementi del workflow AI hanno il maggiore impatto sulla qualità finale di una traccia musicale. È particolarmente utile per i creator che vogliono capire dove investire davvero il proprio tempo durante la fase di produzione.

Dal prompt alle varianti: come costruire una base solida

Il processo inizia prima del suono: inizia nel prompt.

Un buon prompt descrive genere, energia, ritmo, atmosfera, struttura. Non “voglio una traccia deep house”, ma:

“Melodic House 122 BPM, atmosfera calda, accordi sospesi, struttura intro → build → drop → break → drop finale, synth morbidi, groove rotondo, kick profondo non distorto.”

La qualità aumenta per due motivi:

- Dai un contesto narrativo al modello.

- Riduci la casualità nelle scelte armoniche.

Dopo il prompt:

1. Genera 3–5 varianti

Mai una sola: le AI generano probabilità, serve confronto.

2. Ascolta per macro-coerenza, non per dettaglio

Chiediti: regge il mood? tiene il groove? l’armonia è stabile?

3. Scegli la variante migliore e scarta tutto il resto

Tenere più versioni confonde il processo.

🔧 Micro-esperienza : Nei miei test, il 70% delle varianti scartate aveva problemi di transienti o armonia incerta nelle parti centrali. Le migliori sono quasi sempre quelle con dinamiche più ampie, non le più “pompate”.

Stems, refining e mastering: dove nasce la qualità reale

Una volta scelta la variante, inizia la parte che fa la differenza tra creator amatoriale e creator professionista. La magia non avviene nella generazione, ma nel processo successivo: editing, mixing e mastering. Qui è dove una bozza AI diventa una produzione vera.

1. Esporta gli stems (quando disponibili)

Kick, bass, lead, pad, percussioni, fx, voce.

Se il tool non offre stems → non è uno strumento professionale.

2. Editing in DAW

Qui avviene la magia:

- correggi transienti (soprattutto su cassa e hi-hat),

- stabilizzi l’armonia con micro-quantizzazioni,

- usi EQ chirurgico per liberare spazio tra gli strumenti,

- recuperi dinamica riducendo la compressione eccessiva della AI.

3. Mastering leggero

Niente catene aggressive:

- limiter trasparente,

- micro-EQ sulle alte,

- correzione stereo,

- loudness uniforme.

Checklist finale

- L’AI dà il materiale, tu gli dai la forma.

- Più curi la fase stems→DAW, più suona “professionale”.

- Un workflow ordinato vale più del tool perfetto.

Questo schema visivo mostra in modo semplice e immediato l’intero percorso che porta una traccia generata con l’AI a diventare un brano realmente utilizzabile all’interno della tua DAW. È uno dei passaggi più importanti per creator e produttori che vogliono trasformare un’idea generata dall’intelligenza artificiale in una produzione professionale.

Gli errori più comuni che rovinano la musica generata con l’intelligenza artificiale

La maggior parte dei risultati “deludenti” prodotti dall’AI non dipende dal modello, ma dal modo in cui viene usato. Creator che hanno competenze musicali solide ottengono comunque risultati deboli perché considerano l’AI come una scorciatoia, non come un componente del processo creativo. In questa sezione vediamo gli errori più frequenti: quelli che ho riscontrato sia nei test personali sia nei workflow di altri produttori che si sono avvicinati all’AI con aspettative sbagliate.

Anche con gli strumenti di intelligenza artificiale migliori, ci sono alcuni errori ricorrenti che possono compromettere la qualità del risultato finale. Questa tabella raccoglie i problemi più frequenti e le soluzioni pratiche per evitarli o correggerli rapidamente, soprattutto quando lavori in un workflow ibrido AI → DAW.

| Errore comune | Soluzione pratica |

|---|---|

| Prompt troppo vago | Usa prompt strutturali con genere, BPM, atmosfera, strumenti, struttura |

| Mix dell’AI troppo compresso | Ripristina headroom con limiter trasparente + EQ dolce |

| Incoerenza armonica | Correggi note, stabilizza tonalità in DAW (Melodyne / Elastic Pitch) |

| Loop instabile | Ritaglio, quantizzazione leggera, allineamento transienti |

| Non utilizzare gli stems | Esporta e mixa ogni elemento separatamente |

Errori tecnici ricorrenti che abbassano la qualità del risultato

Prima di migliorare, bisogna riconoscere gli errori più comuni. Sono sempre gli stessi e, una volta capiti, diventano semplicissimi da evitare.

1. Prompt troppo vaghi o troppo generici

Dire “fammi una traccia house” è come dire a un fotografo “fammi una foto”: tecnicamente possibile, ma senza direzione. Meno contesto dai → più casuale sarà l’output.

2. Mancata generazione di varianti

Usare la prima versione che l’AI produce è la causa principale di insoddisfazione. Le varianti servono proprio per trovare la “probabilità migliore”.

3. Ignorare gli stems (o non averne accesso)

Lavorare su un file stereo compresso è come tentare di mixare con le mani legate. Se non puoi isolare kick, bassline, lead e pad, non puoi ottenere qualità reale.

4. Fidarsi troppo del mix dell’AI

Le AI comprimono molto più di quanto serva. Spesso i transienti sono tagliati, i bassi gonfi e le alte affaticanti. Quasi sempre serve correggere tutto in DAW.

5. Accettare incoerenze armoniche come “stile”

Un errore armonico non è un’innovazione. Se senti cambi di tonalità non voluti, non è un effetto creativo: è il modello che ha perso coerenza.

🔧 Micro-esperienza: Nei test su generazione EDM, la maggior parte delle incoerenze armoniche si manifesta tra il secondo e il terzo drop, esattamente quando il modello tenta di “variare” senza avere abbastanza contesto.

Come correggere gli errori più frequenti con un flusso pratico

Ogni errore ha una soluzione concreta. Qui trovi un metodo operativo che puoi applicare subito, anche se non sei un tecnico del suono. Ecco come trasformare errori ricorrenti in punti di forza:

1. Rendi il prompt strutturale, non descrittivo

Includi BPM, mood, strumenti dominanti, pattern ritmici, struttura.

→ Risultato: coerenza immediata.

2. Lavora con un ciclo “genera → seleziona → raffina”

Non tutto deve essere usato. Scegli solo la variante più controllabile.

3. Usa gli stems per ricostruire il mix

Correggi dinamica, relazioni tra strumenti, panning, e ribilancia i volumi.

→ Qui nasce il suono professionale.

4. Ripristina la dinamica

Limiter trasparente, EQ chirurgico, compressione leggera.

→ L’AI dà loudness, tu dai respiro.

5. Raddrizza l’armonia

Se serve, quantizza tonalità o correggi note con strumenti come Melodyne o pitch editor.

Checklist immediata

- Un cattivo risultato è quasi sempre migliorabile.

- L’AI non sostituisce la fase creativa umana.

- Il creator esperto è quello che “aggiusta”, non quello che accetta tutto.

Come portare la musica generata con l’AI a un livello professionale

Anche il miglior modello AI, da solo, non genera un suono da release: genera una bozza potenzialmente potente, ma compressa, poco dinamica e spesso sbilanciata. Il salto da “suona bene” a “suona professionale” avviene dopo, nella fase di refining, mixing e micro-correzione. Qui entrano in gioco l’esperienza del creator, la sensibilità musicale e le scelte tecniche che permettono al materiale generato di diventare una traccia reale, pubblicabile e coerente con le aspettative del pubblico.

In altre parole: la professionalità non sta nel generare, ma nel rifinire.

Cosa correggere per ottenere una qualità da release: la parte tecnica che conta davvero

Una traccia può suonare bene a un primo ascolto, ma per essere davvero “professionale” servono alcune correzioni specifiche che fanno tutta la differenza.

1. Recupero della dinamica (AI = compressione eccessiva)

Le AI comprimono per “uniformare” il suono ai trend dei social. Per una release:

- riduci la compressione multibanda,

- recupera headroom,

- ripristina micro-dinamiche su batteria e synth.

2. Ottimizzazione armonica

Molte generazioni presentano micro-scarti tonali:

- usa pitch editor o Melodyne per allineare note errate,

- stabilizza la chiave,

- evita modulazioni non volute.

La chiarezza armonica è un segno di professionalità immediata.

3. Correzione timbrica

Con equalizzazione chirurgica:

- libera lo spazio delle basse (40–80 Hz),

- migliora presenza e chiarezza delle medio-alte,

- rimuovi harshness tra 4–6 kHz.

4. Gestione dei transienti

Kick e percussioni generate dalle AI sono spesso “ammorbiditi”.

Rinforzali con transient shaper per dare definizione al groove.

🔧 Micro-esperienza: Nei miei test sui generatori diffusion, quasi tutte le tracce migliorano del 30–40% in percezione di qualità semplicemente correggendo transienti e liberando 3 dB di headroom.

Il metodo pratico per far suonare l’AI come una produzione professionale

Una traccia può suonare bene a un primo ascolto, ma per essere davvero “professionale” servono alcune correzioni specifiche che fanno tutta la differenza.

1. Parti dagli stems

Rendere professionale un file stereo è quasi impossibile.

Gli stems permettono controllo totale su armonia, dinamica e spaziatura.

2. Ricostruisci il mix da zero

Dimentica il mix dell’AI.

Lavora in ordine: kick → bass → groove → synth → pad → lead → FX.

3. Usa una catena di mastering minimale ma efficace

- EQ lineare per bilanciare,

- limiter trasparente,

- leggero stereo-widening (senza esagerare),

- controllo loudness (target -9 / -8 LUFS per elettronica moderna).

4. Cura l’esperienza d’ascolto, non solo la tecnica

Una traccia “suona professionale” quando:

- respira,

- è chiara,

- non stanca,

- mantiene identità.

L’AI genera materia prima: la firma sonora la metti tu.

Checklist immediata

- No stems → No qualità pro.

- Il mix AI non basta mai.

- Anche 15 minuti di refining cambiano tutto.

L’AI come estensione della tua identità sonora, non come sostituto

Molti creator credono che l’intelligenza artificiale rischi di “appiattire” lo stile personale. In realtà accade il contrario quando si usa l’AI nel modo giusto. La tecnologia non decide chi sei: amplifica ciò che già porti nel tuo modo di ascoltare, scegliere, rifinire. Un modello AI non ha gusto, non ha background musicale, non ha storia: ha solo probabilità. L’identità nasce da ciò che selezioni, scarti, ritocchi, sovrapponi e trasformi. L’AI diventa un’estensione del tuo orecchio, non un sostituto dell’esperienza.

Questo è il punto: non devi suonare come l’AI, devi far suonare l’AI come te.

Come dare una direzione creativa chiara all’AI (metodo operativo)

L’AI può seguire qualunque direzione, ma solo se gliela dai tu. Qui iniziamo a costruire la parte più importante: la tua impronta sonora.

1. Definisci il tuo “punto di gravità sonora”

Che cosa ti caratterizza?

- groove profondo?

- synth emotivi?

- bassline elastiche?

- atmosfere scure o luminose?

Annota questi elementi: saranno la bussola dei tuoi prompt.

2. Usa l’AI per esplorare varianti del tuo stile, non per improvvisarlo

L’AI rende facile generare 10 direzioni diverse. Il creator professionista non cerca quantità, cerca coerenza.

3. Imposta prompt che guidano l’identità

Non “fammi una melodic house”.

Piuttosto:

“melodic house calda, bassline elastica, piano accordale morbido, atmosfera sospesa, transizioni pulite e drop emozionale”.

La differenza è enorme: il secondo prompt è una firma, non un genere.

4. Definisci un dizionario personale di termini

Ogni artista usa un linguaggio proprio per descrivere il suono.

Crea una lista di 10–15 parole che identificano il tuo stile e usale nei prompt.

🔧 Micro-esperienza: Nei miei test, quando mantieni costante un gruppo di keyword identitarie, le generazioni AI diventano coerenti nell’arco di settimane — come se “riconoscessero” il tuo stile.

Come trasformare le generazioni AI in un vero stile (applicazione pratica)

Il passo decisivo non è generare, ma trasformare ciò che ottieni in una firma sonora. Questo è il livello dove i creator iniziano a distinguersi davvero.

1. Colleziona le migliori 10 generazioni come reference personali

Non per pubblicarle, ma per studiare cosa funziona nel tuo sound.

2. Crea preset personali di mixing e dinamiche

Preset per synth lead, pad, bassline, percussioni.

Così l’AI diventerà una sorgente e tu il filtro creativo.

3. Lavora su layering e re-sampling

Una firma sonora nasce spesso così:

- prendi una generazione AI,

- la layerizzi con un tuo suono preferito,

- la re-samples in un altro contesto ritmico.

Risultato: hai un sound che nessun altro ha.

4. Cura le incoerenze come se fossero “materia grezza”

Il creator esperto non scarta difetti: li controlla e li rende parte dello stile.

Checklist finale

- L’AI non crea identità: la evidenzia.

- Più sei selettivo, più suono “tu”.

- Coerenza = riconoscibilità.

Conclusioni: creare musica con intelligenza artificiale come un creator che sa cosa sta facendo

Arrivati fin qui, dovrebbe esserti chiaro che creare musica con intelligenza artificiale non significa delegare la tua creatività a un algoritmo. Significa, al contrario, espandere il tuo modo di lavorare: avere un assistente veloce, instancabile, sperimentale, capace di generare idee che puoi trasformare in qualcosa di coerente con la tua identità sonora. L’AI non è un sostituto del tuo ascolto, della tua sensibilità o della tua esperienza: è uno strumento nelle tue mani. E come tutti gli strumenti potenti, dà risultati reali solo quando sai usarlo con metodo.

In queste sezioni abbiamo visto come funzionano i modelli, come scegliere il tool giusto, come impostare un workflow professionale, come evitare gli errori che rovinano il risultato e come dare un tratto estetico riconoscibile al materiale generato. Tutto questo ti mette nelle condizioni di uscire dal livello “provo a generare qualcosa” ed entrare in quello “so cosa sto facendo e perché”.

E se c’è un punto da portare via più di tutti è questo: l’AI accelera, ma non definisce. Se oggi riesci a ottenere risultati più rapidamente, domani potrai andare ancora più lontano perché non sarai costretto a ripartire da zero ogni volta. Ogni prompt crea una variazione, ogni variazione diventa un materiale di lavoro, ogni materiale arricchisce la tua capacità di fare scelte migliori. A lungo termine, questo costruisce un vantaggio reale: continuità creativa.

Per questo, il mio invito finale è semplice: non limitarti a usare l’AI per generare. Usala per imparare come reagisce, cosa interpreta bene, dove sbaglia, come risponde quando spezzi le regole. È così che inizi a plasmare un tuo linguaggio personale — ed è quello che distingue un creator che usa l’AI da un creator che capisce l’AI.

Arriverai al punto in cui creare musica con intelligenza artificiale sarà naturale quanto aprire la tua DAW preferita. E quel momento segna la vera svolta: non starai più “usando un modello”, starai ampliando il tuo modo di creare.

Per approfondire workflow, test comparativi e guide operative avanzate, puoi partire da qui:

- Suno AI: recensione completa, guida pratica e workflow reali

- Splice: come integrarlo con AI e DAW per creare produzioni professionali

Prima di entrare nelle FAQ, questo mini glossario chiarisce i concetti tecnici più importanti che compaiono quando si lavora con la musica generata tramite intelligenza artificiale. È un supporto fondamentale per creator e produttori che vogliono muoversi in modo consapevole all’interno del workflow AI → DAW.

Mini Glossario: i concetti fondamentali per capire la musica generata con l’AI

| Termine | Significato (chiaro e conciso) |

|---|---|

| Embedding | Una rappresentazione numerica del suono che permette all’AI di comprenderne struttura e caratteristiche. |

| Stems | Le tracce separate di una generazione (batteria, basso, voce, synth) da usare per editing e mixing. |

| Transienti | Gli attacchi iniziali dei suoni, fondamentali per percezione di ritmo e presenza. |

| Headroom | Lo spazio dinamico di sicurezza che evita clipping e permette un mastering pulito. |

| Coerenza armonica | La capacità di mantenere le note all’interno della stessa tonalità senza stonature o deviazioni. |

| Loudness | Il volume percepito della traccia, diverso dal semplice livello del segnale. |

Domande frequenti su come creare musica con l’intelligenza artificiale

❓ Come creare musica con intelligenza artificiale partendo da zero?

Risposta breve :

Puoi creare musica con intelligenza artificiale partendo da zero usando un generatore text-to-music o caricando un riferimento audio. Imposti un prompt accurato, generi 3–5 varianti, scegli la migliore, esporti gli stems e rifinisci tutto in DAW.

Approfondimento con mini-scenario:

Immagina di voler produrre una traccia melodic house ma non hai ancora idee chiare. Scrivi un prompt dettagliato (genere, BPM, atmosfera, struttura), generi 4 versioni e ne scegli una. Gli stems ti permettono di migliorare kick, bassline e armonia, trasformando una bozza AI in qualcosa di solido. Con EQ, dinamiche e micro-editing la traccia passa da “demo AI” a materiale pronto per essere modellato nel tuo stile.

Indicatori che stai facendo bene:

– Le varianti sono coerenti tra loro.

– Hai controllo su struttura e armonia.

– Gli stems ti permettono di mixare davvero.

❓ Qual è il miglior strumento per creare musica con l’AI?

Risposta breve:

Non esiste un “miglior tool” assoluto: il migliore è quello più adatto al tuo workflow. Per idee rapide vanno bene i modelli text-to-music; per qualità professionale servono tool con stems e controlli avanzati.

Approfondimento:

Se lavori con musica elettronica, hai bisogno di un generatore che mantenga stabile BPM e groove. Per pop o hip hop, invece, serve un modello capace di creare melodie vocali credibili e strutture orecchiabili. Nei miei test, gli strumenti che permettono di intervenire su struttura, dinamica e stems sono quelli che garantiscono risultati professionali. I tool “one-shot” che esportano solo file stereo sono ottimi per concept, meno per produzioni serie.

Indicatori:

– Puoi esportare stems.

– Puoi controllare BPM e struttura.

– Il suono non è troppo compresso in partenza.

❓ Come ottenere un suono professionale da una traccia generata con l’AI?

Risposta breve:

Serve una fase di refining: correzione timbrica, recupero di dinamica, editing degli stems e mastering leggero. L’AI non produce mai una traccia davvero “pronta”.

Approfondimento:

Prendi la generazione AI come una bozza. Apri gli stems in DAW, ripulisci le basse, correggi note errate, bilancia gli strumenti, rinforza i transienti e apri leggermente lo stereo. La differenza arriva da 3 punti: headroom recuperata, armonia stabile, equilibrio timbrico. Anche solo 20 minuti di refining possono trasformare completamente la percezione del brano.

Indicatori:

– La traccia respira (non è schiacciata).

– Le parti si distinguono senza lottare.

– Il drop non perde energia.

❓ È possibile usare l’AI per creare musica adatta ai social?

Risposta breve:

Sì. L’AI è ottima per loop brevi, hook immediati e drop d’impatto. Devi però ottimizzare timbrica e loudness per mobile.

Approfondimento:

Per contenuti verticali, serve una struttura semplice: intro corta, impatto immediato, atmosfera riconoscibile in 2–3 secondi. I generatori AI text-to-music sono perfetti: forniscono materiali rapidi e caratterizzati. Il passaggio decisivo è la rifinitura: togli harshness sulle alte (la maggior parte dei telefoni amplprime queste frequenze), aumenta presenza delle medie e mantieni un loudness competitivo senza appiattire tutto.

Indicatori:

– Il suono è chiaro anche a basso volume.

– L’hook arriva entro 4 secondi.

– Niente basse che “rompono” in speaker piccoli.

❓ Posso usare l’AI per creare musica da pubblicare su Spotify?

Risposta breve:

Sì, ma non puoi pubblicare la traccia “come esce” dall’AI. Serve lavoro reale su mixing, editing, stems e mastering coerenti con gli standard editoriali.

Approfondimento:

Una traccia adatta allo streaming richiede dinamica controllata, pulizia timbrica e coerenza stereo. Le generazioni AI sono spesso troppo compresse, con armonia instabile e transienti deboli. Con gli stems puoi ricostruire il mix, rinforzare groove e bassline, correggere note fuori scala e ottenere un suono competitivo. Alcuni artisti stanno già pubblicando AI-assisted music, ma il passaggio decisivo rimane il lavoro umano.

Indicatori:

– LUFS coerenti col genere.

– Nessun picco o clipping.

– Atmosfera coerente per tutta la traccia.

❓ Quanto influisce il prompt nel risultato finale della musica AI?

Risposta breve:

Il prompt incide per circa il 70% sul risultato: più è preciso, più l’AI genera materiale vicino al tuo stile.

Approfondimento:

Un prompt efficace contiene informazioni su genere, BPM, energia, atmosfera e struttura. Non basta dire “fammi una traccia deep house”: serve dire come deve muoversi, cosa deve trasmettere, come deve evolvere. Un prompt strutturale riduce la casualità e aumenta la coerenza armonica. Durante i test, i prompt identitari (contenenti parole chiave del tuo stile) si sono rivelati i più efficaci per mantenere continuità creativa.

Indicatori:

– Le varianti sono simili tra loro.

– Il groove è coerente.

– L’atmosfera rispecchia l’intento.

Bibliografia e fonti autorevoli sulla musica generata con intelligenza artificiale

-

Dhariwal, P., et al. (2020). “Jukebox: A Generative Model for Music.” OpenAI Research. https://openai.com/research/jukebox

-

Briot, J.-P., Hadjeres, G., & Pachet, F. (2019). Deep Learning Techniques for Music Generation. Springer. https://link.springer.com/book/10.1007/978-3-319-70163-9

-

Hinton, G., et al. (2015). “Deep Learning.” Nature. https://www.nature.com/articles/nature14539