Inizia tutto con una frase. Una riga digitata, apparentemente semplice, ma che nasconde in sé un potenziale creativo senza precedenti. È qui che entra in gioco Dalle AI, un sistema di intelligenza artificiale per la generazione di immagini che ha completamente riscritto le regole della rappresentazione visiva. Non stiamo parlando di un semplice tool grafico: stiamo parlando di una tecnologia capace di trasformare istruzioni testuali in opere visive dettagliate, coerenti, sorprendenti.

Ciò che rende Dalle AI davvero rivoluzionario non è solo il risultato, ma il processo mentale simulato. Il sistema riceve una descrizione in linguaggio naturale, la interpreta attraverso una rete neurale addestrata su miliardi di immagini e testi, e produce una rappresentazione grafica coerente con la richiesta. In pochi secondi, un’idea si fa visione. Non serve conoscere software di grafica, non servono abilità artistiche: serve solo la capacità di descrivere ciò che si immagina. E qui, davvero, la parola prende forma.

Il cuore di questa rivoluzione si chiama DALL-E, il modello sviluppato da OpenAI che ha posto le fondamenta del sistema. Dalla sua evoluzione sono nate versioni sempre più raffinate, capaci di cogliere le sfumature semantiche e tradurle in visuali ad alta definizione. È in questo passaggio, da linguaggio a immagine, che si innesta il concetto stesso di generatore di immagini IA, dove l’intelligenza artificiale per immagini si fonde con la creatività umana per abbattere ogni limite tradizionale.

Non si tratta più di scegliere tra fotografia o illustrazione, tra stock o rendering. Si tratta di generare su richiesta, con un livello di controllo stilistico, concettuale e narrativo che fino a pochi anni fa sarebbe stato impensabile. Ogni dettaglio – dall’atmosfera allo stile pittorico, dalla composizione alla palette colori – può essere deciso in fase di input.

In questo nuovo scenario, l’immaginazione non è più subordinata agli strumenti. È il contrario: gli strumenti si piegano all’immaginazione. Questo cambia tutto. Cambia come si crea, come si comunica, come si progetta. Cambia il modo stesso in cui pensiamo il visivo. Per questo oggi non si parla più solo di “generazione immagini”, ma di una vera e propria espansione del pensiero creativo.

E mentre il mondo scopre ogni giorno nuovi modi per usare questa tecnologia, una cosa è certa: Dalle AI non è solo un software. È una nuova grammatica visiva.

Con l’avvento di GPT-4o, OpenAI ha compiuto un ulteriore passo avanti, integrando la generazione di immagini, testo e audio in un’unica piattaforma multimodale. Questa evoluzione non solo amplia le capacità creative di DALL·E, ma ridefinisce anche l’interazione tra l’utente e l’intelligenza artificiale, rendendo il processo di creazione ancora più fluido e intuitivo.

Cos’è Dalle AI e perché tutti ne parlano

Se ne parla ovunque. Dai gruppi creativi ai forum tech, passando per gli ambienti di marketing, education, persino moda. Il motivo? Dalle AI ha varcato la soglia dell’innovazione per diventare strumento culturale, creativo, sociale. Non è più una curiosità tecnologica: è una rivoluzione visiva in tempo reale.

A differenza dei software di editing tradizionali, qui non c’è nulla da disegnare, modificare, impaginare. Basta scrivere. Un’idea, una frase, un concetto: in pochi secondi, il sistema genera un’immagine coerente, originale, spesso sorprendente, capace di rappresentare ciò che prima si doveva solo immaginare. Ed è proprio questo che ha innescato la conversazione globale: la democratizzazione della creazione visiva.

Per la prima volta, chiunque può produrre contenuti visivi di alta qualità senza possedere competenze artistiche. Questo ha attirato attenzione da ogni settore: chi lavora nel design lo usa per ideare, chi fa marketing per testare creatività, chi insegna per stimolare l’immaginazione visiva degli studenti. Il vero centro dell’impatto non è tecnico, ma semantico: Dalle AI rappresenta la fusione tra pensiero, parola e immagine.

In un’epoca in cui la velocità della comunicazione è tutto, il potere di tradurre un prompt testuale in una scena visiva precisa e stilisticamente controllata è un cambio di paradigma. Ed è qui che l’idea stessa di AI art prende corpo: un nuovo genere espressivo dove il linguaggio guida la creazione visiva e l’arte diventa collaborativa, codificabile, istantanea.

Ecco perché oggi “generatore immagini IA” non è più un’etichetta tecnica, ma un concetto carico di significato, che ridefinisce la relazione tra umano e immaginazione. Non si tratta solo di cosa produce Dalle AI, ma di come ci fa pensare in modo visivo.

Per comprendere la potenza visiva di Dalle AI, ecco un’illustrazione che ne rappresenta simbolicamente l’essenza: un mondo dove le parole si fanno immagine.

Origine del progetto: da DALL·E al salto creativo dell’IA visiva

Tutto ha avuto inizio con un esperimento firmato OpenAI, lo stesso laboratorio dietro a GPT e ChatGPT. L’obiettivo? Creare un sistema capace di trasformare frasi in immagini con coerenza semantica e ricchezza visiva. Così nasce DALL·E, il modello pionieristico che ha dato il nome al movimento.

La prima versione ha sorpreso per la sua capacità di associare concetti distanti: un polpo con cappello da cowboy? Nessun problema. Ma è con DALL·E 2 che il salto qualitativo si è fatto evidente: più risoluzione, maggiore controllo, una comprensione semantica decisamente più raffinata.

Oggi, il progetto è diventato sinonimo di evoluzione dell’intelligenza artificiale generativa. L’approccio non è semplicemente quello di replicare il reale, ma di ricombinarlo attraverso un filtro creativo. Questo è il punto di rottura: non stiamo più “assistendo” a immagini, le stiamo “progettando” con un’intelligenza addestrata a intuire lo stile, l’intento, il contesto.

OpenAI, con questo modello, ha fatto molto più che introdurre una novità tecnica. Ha inaugurato un nuovo modo di pensare l’immagine digitale, ridefinendo il rapporto tra parola e rappresentazione. Il sistema non si limita a eseguire: interpreta, astrae, crea.

Ed è in questa trasformazione che si radica la forza di Dalle AI: non è solo uno strumento, ma un’estensione della nostra immaginazione, capace di amplificare la creatività umana con una precisione prima impossibile. Una vera rivoluzione culturale, non solo tecnologica.

Come funziona Dalle AI: prompt testuale, rete neurale e magia visiva

Scrivi. Descrivi. Poi attendi. In pochi secondi, l’immagine appare. Ma dietro quell’apparente semplicità si nasconde un meccanismo complesso, alimentato da una rete neurale di ultima generazione e un sistema di prompting creativo studiato per decifrare l’intenzione umana.

Il cuore operativo di Dalle AI è una rete neurale addestrata su milioni di coppie immagine-testo. Questo le consente di “comprendere” il linguaggio naturale, estrarne il significato profondo, quindi tradurlo in uno schema visivo coerente. Ma non si ferma lì: il sistema analizza anche lo stile implicito, le emozioni, la composizione visiva suggerita.

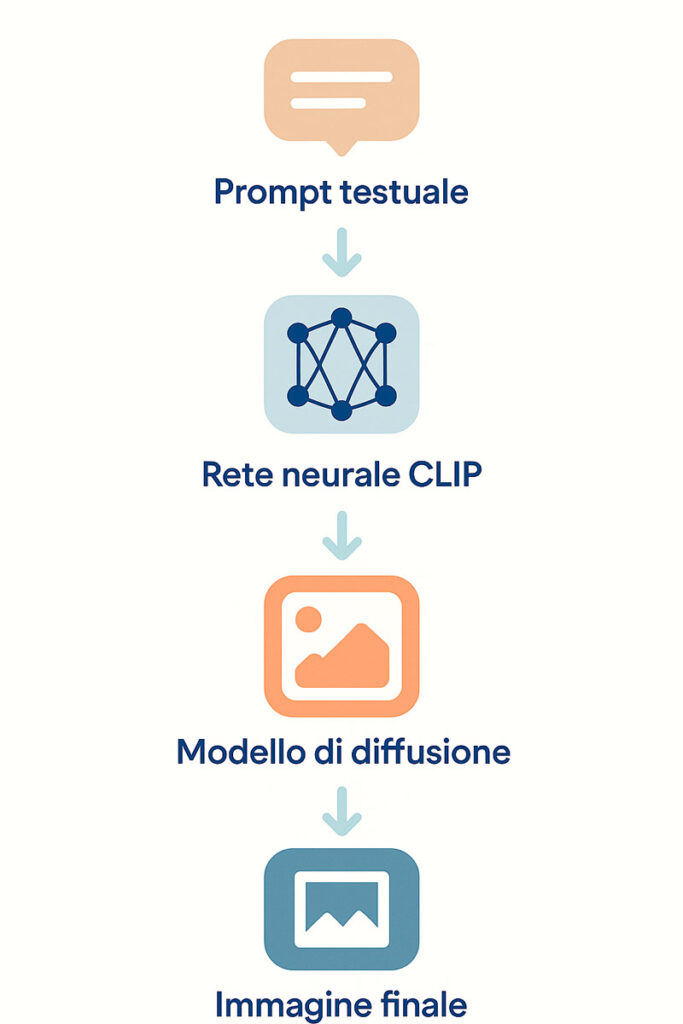

La generazione vera e propria avviene tramite un modello di diffusione, che progressivamente costruisce l’immagine partendo da rumore casuale fino a ottenere una resa visiva precisa. Questo processo è ciò che dà vita alla “magia” visiva, un flusso costante di raffinamento basato su criteri di accuratezza semantica e aderenza al prompt.

Chi scrive il prompt, quindi, non è un semplice utente. È co-creatore. Più dettagliata e immaginifica è la descrizione, più l’output sarà sorprendente. Ecco perché parlare di creazione immagini AI è riduttivo: qui si tratta di collaborazione attiva tra mente umana e intelligenza artificiale.

Dalle AI non interpreta solo ciò che dici. Interpreta come lo dici, cosa intendi evocare, che tipo di scena vuoi generare, quale atmosfera desideri. È questo che la rende unica. E per chi impara a usare davvero le sue logiche, il confine tra pensiero e immagine si dissolve.

Per visualizzare chiaramente come Dalle AI trasforma una frase in immagine, ecco un’infografica che ne sintetizza il flusso operativo in quattro passaggi.

Dietro le quinte di Dalle AI: l’intelligenza che vede e crea

Guardare un’immagine generata da Dalle AI è facile. Comprendere cosa succede dietro quella generazione, invece, è tutt’altro. Perché ciò che rende questo sistema così potente non è soltanto il risultato finale, ma l’infrastruttura cognitiva su cui si regge: un ecosistema neurale in grado di interpretare, correlare e visualizzare concetti astratti come nessun altro strumento.

Al centro di tutto c’è un cambio di paradigma radicale: l’intelligenza artificiale non si limita più a rispondere a comandi, ma costruisce attivamente immagini a partire da un testo, operando come un artista invisibile. Questo è il punto in cui le comuni logiche computazionali vengono superate da un approccio semantico e generativo: l’AI comprende, sintetizza e visualizza. E per farlo, sfrutta un insieme di tecnologie che non lavorano in parallelo, ma in piena simbiosi.

Dalle AI, oggi, non è un singolo strumento, ma un’intera classe di AI image tools coordinati per interpretare il linguaggio e convertirlo in visione. Non stiamo parlando di filtri o template grafici, ma di un sistema di generazione immagini IA che funziona come un cervello visivo artificiale, dove il prompt diventa stimolo creativo e il risultato una rappresentazione cognitiva.

La sua unicità non sta solo nel tipo di immagini che produce, ma nella capacità di farlo in modo coerente, flessibile e sorprendentemente umano. Dietro ogni render non c’è un algoritmo isolato, ma una rete interconnessa di comprensione linguistica, inferenza semantica e sintesi visiva.

È proprio questo incastro perfetto a rendere Dalle AI qualcosa di più di una semplice intelligenza: è uno sguardo artificiale capace di creare.

Il ruolo di CLIP e del modello di diffusione in Dall-E

Alla base del funzionamento di Dall-E c’è un’architettura che ha rivoluzionato la relazione tra linguaggio e immagine: si chiama CLIP (Contrastive Language–Image Pre-training) ed è la chiave di volta del processo creativo automatico. CLIP è il modulo incaricato di comprendere il significato di una descrizione testuale e di allinearlo semanticamente a concetti visivi appresi durante l’addestramento.

Non si tratta di una semplice associazione parola-immagine, ma di una vera e propria interpretazione multidimensionale del linguaggio, in grado di cogliere contesto, tono, intenzione. CLIP “pensa visivamente”, convertendo ogni parola in una mappa concettuale che servirà poi al generatore per costruire la scena.

Questa scena viene poi realizzata da un modello di diffusione, una delle tecnologie più avanzate nel panorama delle tecnologie OpenAI. Il modello inizia con un’immagine completamente “rumorosa”, cioè casuale, e la raffina progressivamente in base alle coordinate semantiche fornite da CLIP. Il risultato finale è un’immagine dettagliata, coerente con il prompt e visivamente affascinante, spesso indistinguibile da una fotografia o un’illustrazione manuale.

Il dialogo tra CLIP e il modello di diffusione è ciò che consente a Dall-E di funzionare non come una macchina generatrice di immagini casuali, ma come una rete neurale che simula un atto creativo, ragionando sul contenuto testuale e costruendone un’espressione visiva adatta.

In questa dinamica c’è tutto il senso del salto generazionale introdotto da Dalle AI: non si tratta più di addestrare macchine a vedere, ma a immaginare.

Algoritmi, addestramento e qualità: cosa rende unica ogni immagine generata

Ogni immagine generata da Dalle AI non nasce da un processo statico. È frutto di milioni di connessioni neurali, attivate da un addestramento massivo su uno dei più vasti training set mai elaborati per un sistema visivo. Si parla di miliardi di immagini associate a descrizioni linguistiche, provenienti da fonti disparate: fotografia, arte digitale, fumetto, design industriale. Tutto ciò che può avere una forma visiva è stato utilizzato per addestrare il modello.

Questo training consente alla rete di riconoscere non solo cosa rappresentare, ma come farlo. Ogni tratto, ogni stile, ogni palette cromatica è frutto di un’elaborazione profondamente contestuale, resa possibile dall’integrazione di modelli deep learning che operano su più livelli interpretativi.

Il sistema analizza l’input e lo confronta con il suo archivio interno, isolando pattern semantici, relazioni visive e sfumature descrittive. A quel punto, la fase generativa entra in azione, attivando modelli generativi che trasformano le relazioni testuali in una sequenza di scelte visive: composizione, prospettiva, texture, atmosfera.

La vera forza sta nella coerenza finale. Anche prompt ambigui o complessi vengono risolti da Dalle AI con una sorprendente capacità di sintesi: l’intelligenza artificiale non si limita a rappresentare, ma interpreta. Ed è questa interpretazione che rende ogni immagine non solo pertinente, ma anche esteticamente valida.

È come se l’algoritmo sapesse esattamente cosa vuoi dire, prima ancora che tu lo sappia chiaramente.

Cosa puoi fare con Dalle AI: oltre la semplice generazione di immagini

Pensare a Dalle AI come a un generatore d’immagini sarebbe riduttivo. La sua vera natura è quella di un assistente creativo evoluto, capace non solo di generare, ma anche di modificare, rifinire, adattare contenuti visivi in base alle intenzioni dell’utente. Non siamo più nel campo dell’automazione, ma in quello della co-creazione dinamica, dove l’intervento umano e la risposta artificiale si fondono in tempo reale.

La generazione immagini AI non è più una linea d’arrivo, ma un punto di partenza. Ciò che accade dopo la prima immagine è altrettanto importante: la possibilità di estendere, correggere, variare, ottimizzare ogni dettaglio apre scenari applicativi prima impensabili. In ambiti come pubblicità, moda, architettura concettuale o storytelling visivo, Dalle AI diventa uno strumento di regia immaginifica.

Il vantaggio non sta solo nella rapidità o nella qualità estetica, ma nella libertà di iterazione illimitata: non c’è un “limite massimo” di creatività. Puoi continuare a esplorare versioni, alternative, combinazioni, fino a quando l’immagine che hai in testa prende forma esattamente come la immaginavi.

Questo approccio trasforma AI creativity in un processo non più passivo, ma attivo, espandibile, stratificato. Non è solo cosa fai con Dalle AI. È quante volte puoi farlo in modo diverso, più preciso, più tuo.

Outpainting, inpainting e variazioni: le funzioni avanzate di Dall-E

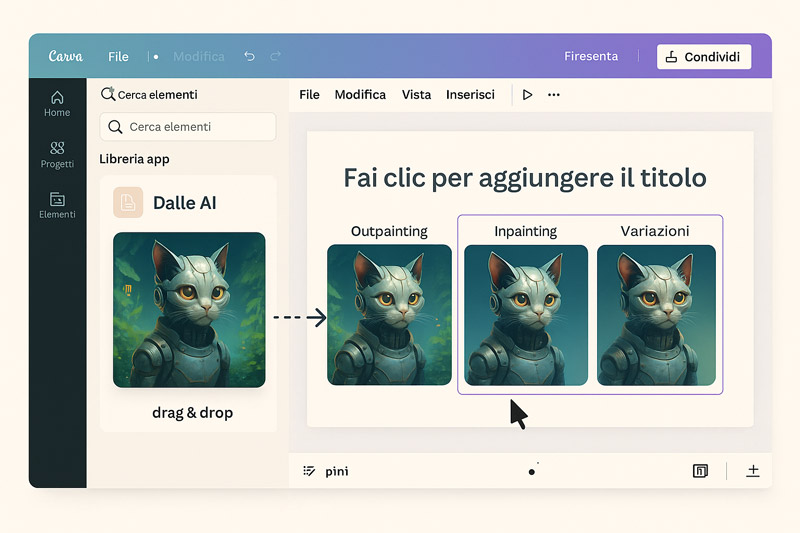

Dietro ogni immagine generata c’è la possibilità di andare oltre il primo risultato. È qui che entrano in gioco le funzionalità avanzate di Dall-E, strumenti pensati non per sostituire la creatività umana, ma per amplificarla. Tra queste, le più potenti sono outpainting, inpainting e le image variations.

Con l’outpainting, è possibile estendere un’immagine oltre i suoi confini originari. Un semplice ritratto può diventare una scena, un dettaglio isolato può aprirsi in un’intera narrazione visiva. Questo strumento si rivela essenziale in ambiti editoriali, illustrativi, pubblicitari, dove l’ampliamento del contesto è fondamentale per costruire una storia attorno a un singolo elemento.

L’inpainting, invece, consente di modificare o sostituire specifiche aree di un’immagine, mantenendone stile, illuminazione e coerenza estetica. È come poter riscrivere una parte di un quadro senza compromettere l’intera composizione. È utile per inserire elementi mancanti, correggere un’espressione, aggiungere o rimuovere oggetti, modificare sfondi.

Infine, le image variations permettono di generare più versioni dello stesso concetto, ciascuna con leggere variazioni di stile, composizione o dettagli. Questa funzione è essenziale in fase di ideazione visiva, dove l’obiettivo è esplorare possibilità prima di scegliere la direzione finale.

Con queste funzioni, Dall-E non è più un generatore d’immagini “una tantum”, ma una piattaforma modulare per l’evoluzione continua del visivo.

Per vedere in azione le tre principali funzioni avanzate di Dalle AI, ecco un esempio visivo chiaro e diretto che mostra il prima e dopo.

Editing visivo e creatività su misura: come personalizzare le immagini

Ottenere un’immagine generica è facile. Ma personalizzare ogni aspetto visivo per farlo aderire esattamente al proprio progetto richiede un altro livello di consapevolezza. È qui che entra in gioco la logica dei custom prompt, una delle armi più potenti messe a disposizione da Dalle AI.

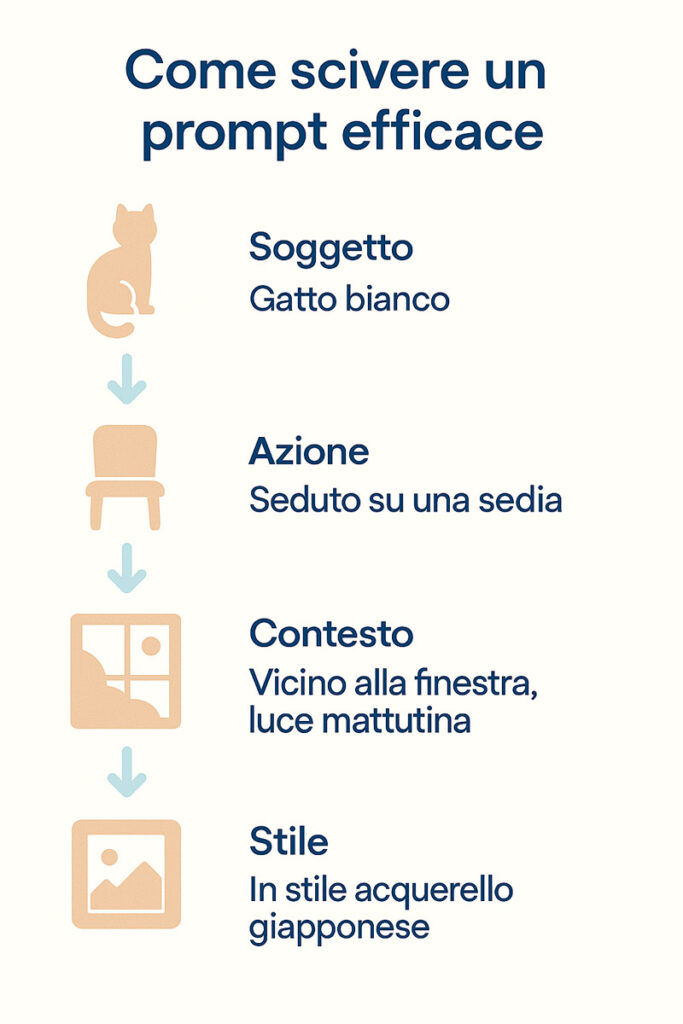

Scrivere un prompt efficace non significa solo descrivere un soggetto. Significa guidare la composizione, suggerire il punto di vista, evocare lo stile, definire l’atmosfera, indicare dettagli precisi su texture, palette cromatica, inquadratura, sfondo, ambientazione. Ogni parola è un comando. Ogni aggettivo, un filtro creativo.

L’editing IA non è un processo statico, ma iterativo: una volta ottenuto il risultato base, l’utente può intervenire in modo chirurgico per modificarne componenti specifiche. Si può ridefinire una posa, cambiare il tempo atmosferico, aggiungere un elemento simbolico o far scomparire ciò che non serve. Il tutto senza mai perdere coerenza stilistica.

A livello di composizione visiva, Dalle AI offre un controllo che va oltre la generazione: si può strutturare un’intera narrazione visiva in più fasi, mantenendo uno stile grafico uniforme e coerente lungo tutta la sequenza. Questa coerenza narrativa è ciò che rende l’immagine non solo bella, ma credibile, comunicativa, utile.

Quando ogni dettaglio è personalizzabile, ogni risultato è unico. E quando ogni risultato è unico, la creatività diventa proprietà esclusiva dell’utente.

Come si usa Dalle AI: accesso, strumenti e piattaforme disponibili

Non basta sapere cos’è Dalle AI per apprezzarne la portata. Bisogna vederla all’opera, provarla, esplorarla nei diversi contesti in cui è disponibile. Perché l’efficacia di uno strumento non è data solo dal risultato, ma dalla facilità con cui quel risultato può essere ottenuto, ripetuto, migliorato. E qui entra in gioco la vera forza di accessibilità della piattaforma.

Oggi, usare Dalle AI non richiede installazioni, configurazioni tecniche o conoscenze di programmazione. Basta accedere online, descrivere ciò che si vuole generare e lasciare che l’intelligenza artificiale faccia il resto. È un paradigma di usabilità che la rende uno dei più potenti e immediati AI user tools disponibili.

A seconda del livello d’esperienza, delle esigenze o del contesto, Dalle AI può essere usata in più modi, da quello conversazionale all’integrazione via API. È integrata in piattaforme note, disponibile in modalità standalone, pronta a interagire con l’utente in tempo reale. Questa flessibilità ha un solo obiettivo: portare la potenza della generazione immagini IA ovunque serva, nel modo più fluido possibile.

È proprio questa accessibilità distribuita a rappresentare uno dei maggiori vantaggi competitivi: non esiste più una barriera tecnica tra l’idea e l’immagine. Esiste solo una tastiera, una frase ben scritta, e una risposta visiva immediata.

Dalle AI in ChatGPT: generazione assistita e flusso conversazionale

Uno dei modi più intuitivi e potenti per utilizzare Dall-E è all’interno di ChatGPT, il modello conversazionale che ne integra le funzionalità visive. Qui la generazione non è più un processo separato, ma una parte fluida del dialogo tra utente e intelligenza artificiale, dove si può affinare, correggere, esplorare senza mai uscire dal contesto conversazionale.

Questa integrazione IA consente di guidare la creazione visiva con un linguaggio naturale, senza tecnicismi. Si può chiedere un’immagine in un certo stile, modificare un dettaglio, ottenere variazioni o adattamenti, tutto in tempo reale, con una fluidità che trasforma l’esperienza in qualcosa di profondamente immersivo.

ChatGPT agisce come regista invisibile: interpreta il prompt, ne identifica le aree chiave e lo traduce per il generatore visivo. Il risultato non è una semplice immagine, ma una risposta contestuale e coerente all’interazione in corso. E il vantaggio è evidente: l’utente può correggere, affinare, personalizzare ogni passo, fino a ottenere esattamente ciò che vuole, con un livello di controllo totale.

Inoltre, la generazione guidata consente di superare il classico limite del prompt statico: ogni richiesta può essere riformulata, ogni immagine può avere un seguito. È la narrazione visiva a episodi, con l’IA come partner creativo sempre attivo.

Plugin, API e strumenti di terze parti per professionisti e creativi

Per chi lavora nel design, nello sviluppo o nella produzione di contenuti visivi su larga scala, Dalle AI offre molto più di un’interfaccia utente. Offre integrazioni concrete tramite plugin e API generative, pensate per essere incluse all’interno di ambienti di lavoro già esistenti.

Le API consentono di incorporare la generazione immagini AI in qualsiasi flusso: siti web, app mobile, tool di progettazione grafica, sistemi editoriali, e-commerce. Il vantaggio? Automatizzare, personalizzare, scalare la produzione di visual senza uscire dal proprio ambiente operativo.

Attraverso plugin creativi, Dalle AI può connettersi a strumenti come Figma, Canva, Adobe Express o CMS visuali, offrendo un livello di integrazione design AI capace di rivoluzionare i processi creativi tradizionali. Nessuna necessità di esportare e reimportare: la generazione avviene direttamente dove serve.

Queste estensioni trasformano Dalle AI da tecnologia stand-alone a piattaforma modulare, pronta a inserirsi in ogni workflow professionale. E per chi crea contenuti in serie, la possibilità di richiamare automaticamente stili, template, palette o soggetti diventa una leva produttiva e strategica di primo livello.

Non è più solo questione di immagini belle. È questione di integrare la creatività artificiale nel cuore della produzione moderna, con strumenti agili, adattabili, sempre connessi.

L’universo di DALL·E non si è fermato alla versione 3. Oggi, la generazione di immagini tramite intelligenza artificiale sta vivendo una nuova era con l’arrivo di GPT-4o e della sua componente evoluta, GPT Image 1.

DALL·E oggi: cosa cambia con l’integrazione in GPT-4o

Nel panorama sempre più fluido e avanzato dell’intelligenza artificiale, parlare oggi di dall-e non significa più riferirsi a un semplice modello di generazione di immagini. Significa confrontarsi con una trasformazione strutturale, che ha condotto la tecnologia di OpenAI oltre la logica dei numeri progressivi. Dopo DALL·E 2 e DALL·E 3, non è arrivato un DALL·E 4. Al suo posto, è emerso un paradigma completamente nuovo: GPT-4o, un modello multimodale nativo capace di comprendere e generare testo, immagini e audio in un unico flusso cognitivo. Questo segna il passaggio da un’intelligenza artificiale specialistica a una mente generativa integrata, dove la produzione visiva non è più un’estensione esterna, ma una componente naturale della conversazione.

Il cuore di questo cambiamento non è solo tecnico, ma semantico. Cercare oggi DALL·E significa in realtà volersi confrontare con GPT-4o, perché è proprio quest’ultimo a incorporare e superare le funzionalità dei precedenti modelli DALL·E. La generazione visiva è diventata fluida, contestuale, legata alla comprensione del linguaggio e del tono. Non si tratta più di generare un’immagine in risposta a un prompt, ma di costruire una narrazione visiva intelligente, in cui ogni pixel è il risultato di un’intenzione elaborata. È un’evoluzione che interessa non solo i ricercatori, ma anche creativi, brand strategist, web designer, content creator, e chiunque usi l’IA per dare forma concreta a idee astratte.

Ecco perché parlare oggi di “evoluzione di DALL·E” senza nominare GPT-4o sarebbe un errore concettuale. La continuità tecnologica si è fusa con una discontinuità semantica: la generazione d’immagini è passata da funzione isolata a linguaggio integrato. Ed è proprio questo salto che analizzeremo nelle prossime sezioni, per comprendere cosa rende GPT-4o il vero erede, e superamento, del mondo DALL·E.

GPT-4o: il nuovo cuore dell’AI generativa secondo OpenAI

GPT-4o non è una versione successiva. È una trasformazione epistemologica. Nato per sostituire componenti come DALL·E 3, Whisper e GPT-4, questo modello riunifica percezione e produzione in un’unica architettura cognitiva, dove parlare, vedere e scrivere sono azioni che si fondono in tempo reale. Ciò che rende GPT-4o straordinario non è solo la sua capacità di generare immagini, ma il fatto che lo faccia capendo. Capisce il tono del testo, coglie le ambiguità, interpreta i desideri impliciti. Ogni immagine è il riflesso coerente di una comprensione profonda, non più una mera traduzione testuale.

Rispetto a dall-e 3, il nuovo sistema garantisce maggiore fedeltà semantica, precisione visiva superiore, e una capacità narrativa mai vista prima. La generazione non è più istantanea ma intenzionale: GPT-4o non risponde, ma partecipa. Questo consente ai professionisti del visual design, dell’illustrazione e del marketing di ottenere risultati allineati ai valori di marca, alla voice of tone e all’esperienza utente. La tecnologia non agisce più come uno strumento tecnico, ma come un assistente creativo reale.

Inoltre, GPT-4o è nativamente integrato in ChatGPT: non è più necessario invocare DALL·E come modulo esterno o accedere a un’interfaccia separata. La generazione d’immagini è ora una proprietà emergente della conversazione. Questo significa fluidità operativa, ma anche un nuovo modo di pensare il dialogo visivo: ciò che prima era input → output è ora scambio dinamico, circolare, continuo. È qui che la creatività viene davvero liberata.

Perché non esiste un DALL·E 4: chiarimenti e transizione tecnica

Chi oggi cerca su Google “DALL·E 4” non troverà mai un modello ufficiale rilasciato da OpenAI con questo nome. Non perché non ci sia stata un’evoluzione, ma perché il salto compiuto è stato così radicale da rendere obsoleta la logica incrementale che aveva accompagnato i primi modelli. Non siamo di fronte al classico aggiornamento da versione 3 a versione 4: siamo dentro una nuova generazione concettuale, in cui le funzionalità di DALL·E 3 non sono state superate, ma riassorbite, trasformate e ridefinite nel nuovo ecosistema GPT-4o.

La mancata esistenza di un “DALL·E 4” non è un vuoto, ma una scelta precisa di architettura e branding. OpenAI ha interrotto la progressione nominale perché la generazione di immagini non è più un prodotto a sé stante. Con GPT-4o, ciò che prima era un modulo secondario è ora una funzione nativa, autonoma, fluida. Non si accede più a un tool isolato: si interagisce con un sistema che ascolta, comprende, visualizza. E in questa fusione, il nome stesso di “DALL·E” viene superato in favore di un modello unitario e onnicomprensivo.

Questo è un passaggio che molti utenti non hanno ancora interiorizzato. Continuano a cercare “DALL·E 4” aspettandosi una nuova UI, un’interfaccia rinnovata, un livello superiore rispetto al precedente. Ma ciò che troveranno, invece, è molto di più: una tecnologia che ha smesso di essere uno strumento e ha cominciato a comportarsi come un interlocutore visivo. GPT-4o non ha bisogno di un’etichetta “DALL·E 4” perché ha già incorporato tutto ciò che quel nome rappresentava, e lo ha espanso su scala semantica.

Questa transizione tecnica e concettuale va compresa per essere utilizzata. Designer, marketer, autori visivi e imprenditori digitali devono ripensare il proprio flusso di lavoro: non più costruito attorno a tool separati, ma centrato su un modello integrato capace di accompagnare l’intero processo creativo, dalla concezione del messaggio alla sua visualizzazione.

GPT Image 1: la nuova frontiera della generazione visiva

Parlare oggi di dall-e significa inevitabilmente confrontarsi con una transizione: da uno strumento a una funzione, da un modulo separato a un ecosistema integrato. Questo salto prende forma concreta in GPT Image 1, la componente visiva nativa del modello GPT-4o, progettata per produrre immagini con un livello di dettaglio e coerenza mai raggiunto prima. Non si tratta di un aggiornamento incrementale, ma di un cambio di paradigma che impone di rivedere come interpretiamo la generazione visiva via AI.

La generazione immagini AI non è più un processo algoritmico isolato, ma una risposta sensibile e adattiva al contesto del prompt, alla semantica del testo e all’intenzione dell’utente. È qui che GPT Image 1 stabilisce un nuovo standard. Integra pienamente le capacità di DALL·E 3, superandole con una comprensione più profonda delle relazioni tra linguaggio e visione. La sua introduzione ridefinisce anche l’esperienza d’uso in ChatGPT, dove ora l’interazione visiva avviene all’interno della stessa sessione conversazionale, senza interruzioni, passaggi tecnici o strumenti separati. Un cambio che tocca non solo il codice, ma anche il modo in cui pensiamo la creatività visuale assistita dall’intelligenza artificiale.

Questo rende GPT Image 1 il punto di riferimento attuale per chiunque utilizzi la generazione d’immagini in ottica professionale. Ed è per questo che ogni utente che ancora cerca dall-e dovrebbe conoscerne il funzionamento, l’accesso e le implicazioni pratiche, come vedremo nelle sezioni seguenti.

Cos’è GPT Image 1: erede diretto di DALL·E 3

GPT Image 1 è l’evoluzione architetturale e funzionale di DALL·E 3, ma con un cambiamento fondamentale: non vive più come modulo indipendente, bensì come funzione interna a GPT-4o. Non viene richiamato come strumento esterno: è semplicemente lì, disponibile quando necessario, parte integrante del modello conversazionale. E questo dettaglio tecnico è, in realtà, una rivoluzione semantica. Ogni immagine generata non è più una risposta grafica isolata, ma un frammento visivo coerente con il flusso dialogico.

Le migliorie tangibili rispetto a DALL·E 3 sono numerose: maggiore precisione nei contorni e nei dettagli, composizioni più equilibrate, fedeltà al prompt superiore e – soprattutto – capacità di generare testo leggibile all’interno delle immagini, uno dei limiti storici dei modelli precedenti. Queste caratteristiche rendono GPT Image 1 perfettamente utilizzabile in contesti dove l’estetica non è fine a sé stessa, ma serve uno scopo: presentazioni commerciali, interfacce, banner dinamici, visual copywriting, branded content.

L’accesso è immediato: basta un abbonamento a ChatGPT Plus per usarlo direttamente dall’interfaccia conversazionale, oppure si può integrare nel proprio flusso di lavoro attraverso l’API ufficiale di OpenAI. Non serve altro. Nessuna configurazione avanzata. Nessun tool separato. Solo prompt e visione.

DALL·E nell’era GPT-4o: cosa cambia per l’utente finale

L’integrazione di GPT Image 1 all’interno di GPT-4o cambia radicalmente l’esperienza utente per chi era abituato a lavorare con dall-e come componente separata. Non si tratta più di “generare un’immagine”, ma di crearla nel flusso della conversazione, in tempo reale, con una coerenza contestuale che prima non era possibile. Ogni immagine prodotta è la continuazione logica del dialogo, della richiesta, dell’idea.

Questa nuova esperienza è più rapida, più coerente e più immersiva. Non esistono più tempi morti, moduli da aprire o finestre da alternare. Il prompt è fluido, la generazione è continua, la correzione è immediata. L’interazione avviene in un ambiente unico, in cui testo, voce e immagine sono modalità espressive interscambiabili, gestite dallo stesso motore cognitivo.

Per le aziende, i content creator e i professionisti del marketing visivo, questo significa riduzione del time-to-market, ottimizzazione della pipeline creativa, maggiore controllo sui messaggi visivi. Non si lavora più con un tool, ma con un partner cognitivo in grado di restituire forme concrete a istruzioni astratte, in meno di un secondo. Il risultato non è solo un file .png: è un’estensione intelligente dell’idea originale, pronta a entrare in una campagna, in un pitch, in un’interfaccia.

Quanto costa usare Dalle AI: piani, crediti e alternative

La domanda non è solo quanto sia potente Dalle AI, ma quanto sia accessibile a chi vuole farne uso continuativo e professionale. La potenza senza accessibilità è sterile; ed è proprio qui che si gioca una delle partite più importanti per chi produce contenuti visivi con frequenza: costi, piani e opzioni di utilizzo.

Utilizzare Dalle AI non è gratis in modo illimitato, ma è sicuramente più flessibile di quanto si pensi. L’accesso iniziale, per esempio, spesso prevede un credito gratuito che permette all’utente di sperimentare le principali funzionalità senza impegno economico. Ma per sbloccare il vero potenziale del sistema, specie in ambito professionale, si rende necessario passare a modelli a pagamento, che variano in base al volume di generazioni, alla qualità richiesta e alle risoluzioni desiderate.

È in questa logica che OpenAI ha sviluppato diversi piani, ciascuno calibrato per rispondere a esigenze specifiche: dal creator occasionale al designer professionista, dal marketer al team creativo. Tutto è costruito attorno all’idea che la generazione immagini AI non debba mai fermarsi per un limite economico, ma possa adattarsi in modo scalabile.

E in un contesto dove velocità, qualità e continuità sono tutto, avere una chiara panoramica dei costi diventa uno strumento strategico tanto quanto l’output generato.

Crediti, abbonamenti e accesso Plus: panoramica dei costi

Il modello economico adottato da Dall-E si fonda su un sistema a crediti. Ogni immagine generata consuma una frazione di questi crediti, il cui valore varia a seconda del tipo di generazione: standard o avanzata, risoluzione base o alta, modalità statica o variation-based. Più è sofisticata la richiesta, maggiore è l’impatto in termini di consumo.

Attualmente, l’utente può acquistare pacchetti di crediti una tantum oppure attivare formule in abbonamento. Il piano più diffuso è il ChatGPT Plus, che oltre ad abilitare l’uso di GPT-4, sblocca anche la generazione visuale potenziata con Dall-E 3. Questo consente non solo un accesso prioritario al modello, ma anche una generazione più rapida e precisa.

Il credit pricing è strutturato in modo da rendere sostenibile anche l’uso intensivo. Ad esempio, 115 crediti possono coprire centinaia di immagini, soprattutto se si utilizzano risoluzioni base. Per chi lavora su progetti editoriali o contenuti web, questa architettura consente una produzione di massa a costi frazionati.

Le opzioni Plus, quindi, non rappresentano solo un miglioramento delle prestazioni tecniche, ma un vantaggio competitivo concreto, perché permettono di creare, testare e pubblicare più contenuti, più velocemente, con maggiore controllo sulla qualità finale. In un mercato dove l’efficacia visiva è tutto, questa flessibilità non ha prezzo, ma ha valore strategico.

Differenze tra versioni (DALL·E 2 e DALL·E 3): prestazioni a confronto

Quando si parla di Dall-E, è fondamentale distinguere tra le sue principali versioni operative: DALL·E 2 e DALL·E 3. La differenza non è solo numerica, ma profondamente qualitativa: due strumenti apparentemente simili, ma separati da un’evoluzione architetturale sostanziale.

DALL·E 2 ha rappresentato un passo cruciale nel rendere la generazione visiva accessibile, puntando su coerenza, estetica e risoluzione accettabile. È stato il primo modello in grado di tradurre prompt complessi in immagini utilizzabili a livello grafico. Tuttavia, mostrava ancora limiti nell’interpretazione semantica profonda, soprattutto quando il testo implicava relazioni astratte o concettuali.

Con DALL·E 3, tutto cambia. L’intelligenza semantica è più evoluta, la capacità di cogliere le sfumature di linguaggio è drammaticamente superiore, e il controllo stilistico è quasi maniacale. L’integrazione in ChatGPT non è solo un optional: è ciò che permette al modello di ricevere prompt più raffinati, interagire con l’utente, generare versioni iterate e coerenti su richiesta.

Nel confronto versioni, DALL·E 3 si distingue per:

- Maggiore precisione visiva

- Adesione più fedele al prompt

- Capacità narrativa nella sequenza di immagini

- Controllo stilistico potenziato

Per chi deve scegliere oggi, la scelta è evidente: DALL·E 3 è la risposta più evoluta alle esigenze creative moderne, mentre DALL·E 2 resta un’alternativa accessibile, ma con margini inferiori.

Per capire davvero l’evoluzione di Dalle AI, ecco un confronto diretto tra DALL·E 2 e DALL·E 3, due modelli che segnano una svolta nella generazione visiva.

| Caratteristica | DALL·E 2 | DALL·E 3 |

|---|---|---|

| Precisione visiva | Buona, ma con limiti nei dettagli complessi | Altissima, con una resa visiva più coerente e raffinata |

| Comprensione semantica | Interpreta prompt standard, ma fatica con relazioni astratte | Eccellente capacità di cogliere sfumature linguistiche e concetti impliciti |

| Flessibilità narrativa | Limitata: ogni immagine è indipendente | Elevata: può generare sequenze coerenti e visivamente collegate |

| Controllo sullo stile | Discreto, ma non sempre prevedibile | Maniacale: l’utente può orientare tono, luce, composizione con alta precisione |

| Accessibilità e usabilità | Facile da usare, indicato per entry-level | Integrato in ChatGPT, con interazione conversazionale evoluta |

| Ideale per | Bozze rapide, test visivi di base, uso generale | Progetti creativi professionali, branding, illustrazione avanzata |

| Limiti principali | Meno adatto a prompt articolati, minore controllo sul risultato | Richiede più consapevolezza nel prompting, consumo maggiore di risorse |

| Output estetico | Apprezzabile ma più generico | Molto più ricco, cinematografico, controllato |

| Stato evolutivo | Generazione precedente, punto di partenza | Ultima generazione, standard attuale dell’AI visiva |

Le applicazioni reali di Dalle AI nei settori creativi e professionali

Nel panorama attuale, dove la velocità nella produzione dei contenuti visivi si è trasformata in una leva competitiva, Dalle AI si impone come uno strumento imprescindibile. Non più semplice curiosità tecnica, ma alleato operativo nei contesti più eterogenei: dalla creatività pura al design strategico, dalla comunicazione aziendale alla didattica immersiva.

Il valore reale di questa tecnologia emerge nel momento in cui la generazione visiva non è più fine a sé stessa, ma integrata nei flussi decisionali, progettuali e comunicativi. In settori dove l’output visuale determina percezione, identità, posizionamento, la capacità di produrre immagini di qualità in tempo reale consente di risparmiare tempo, testare più soluzioni, e creare una narrazione più fluida.

La AI art real use non è più confinata a mostre o esperimenti digitali: viene adottata da agenzie creative, startup, editori, team di UX design, educatori. In ogni ambito, ciò che conta è la possibilità di creare visivamente senza passaggi intermedi, con una curva di apprendimento quasi inesistente.

Ed è proprio qui che la differenza si fa tangibile: Dalle AI permette a qualsiasi professionista, anche senza competenze artistiche, di comunicare attraverso immagini che raccontano una visione, un’identità, una strategia.

Marketing, design e branding: immagini AI al servizio della comunicazione

Nel mondo del marketing visivo, Dall-E ha acceso una miccia creativa difficile da ignorare. Ogni campagna ha bisogno di visual originali, coerenti con il tone of voice, capaci di attrarre in pochi secondi. E oggi, con la pressione del tempo e la saturazione dei contenuti, riuscire a produrre immagini mirate non è più un vantaggio: è una necessità.

Grazie a Dalle AI, i professionisti del visual content marketing possono generare bozze, layout, visual teaser in pochi minuti, testare più varianti di un’idea e ottenere feedback immediati. Questo approccio iterativo accelera il processo creativo, riduce i costi di produzione e garantisce una reattività prima impensabile.

Nel branding, l’uso dell’intelligenza artificiale va ancora oltre. Le aziende che vogliono distinguersi oggi non possono più affidarsi a contenuti generici. Devono costruire un’identità visuale coerente e riconoscibile. Con Dall-E, è possibile impostare uno stile grafico proprietario, adattare le immagini a diverse campagne, creare moodboard visive in tempo reale e persino costruire universi narrativi per i social media.

La creazione visiva brand non è più legata ai tempi della produzione manuale, ma alla capacità di esprimere idee visive su scala. E chi padroneggia Dalle AI non solo ottiene immagini, ma costruisce strategie visive con una velocità e una varietà mai viste prima.

Arte digitale e contenuti educativi: nuovi orizzonti per illustratori e formatori

L’arte, come sempre, anticipa i tempi. E oggi, Dalle AI si inserisce nel flusso creativo di numerosi artisti digitali come estensione del pensiero visivo. Non sostituisce la mano, ma aggiunge uno strato generativo che permette di esplorare possibilità alternative, nuove sintassi visive, ibridazioni stilistiche.

Per illustratori, concept artist, disegnatori narrativi, l’intelligenza artificiale diventa una tela dinamica, un acceleratore di bozzetti, un laboratorio visivo per lo studio della luce, della composizione, della simbologia. E ciò che nasce da un prompt può essere rifinito a mano, portato in stampa, esposto, animato.

Ma l’applicazione forse più sorprendente è quella nel mondo della didattica. Oggi, educatori e formatori stanno iniziando a usare Dalle AI come strumento di mediazione visiva, per spiegare concetti astratti, creare esempi su misura, stimolare la comprensione attraverso la visualizzazione. Che si tratti di biologia, storia dell’arte o storytelling narrativo, la possibilità di generare immagini in tempo reale aumenta l’efficacia dell’insegnamento e coinvolge attivamente gli studenti.

Questo tipo di illustrazione automatizzata non è più percepita come fredda o impersonale, ma come un ponte tra linguaggio e immaginazione. Un supporto alla trasmissione del sapere, capace di abbattere barriere linguistiche, culturali e cognitive.

Quanto è sicura Dalle AI? Filtri, copyright e uso responsabile

La potenza di un’innovazione non si misura solo nella sua capacità di creare, ma anche nella responsabilità con cui questa potenza viene gestita. E nel caso di Dalle AI, la domanda più rilevante dopo “cosa può fare” è senza dubbio “fino a che punto può spingersi?”. La generazione automatica di immagini pone infatti interrogativi etici e normativi che non possono essere elusi.

In un mondo in cui la produzione visiva è immediata e su larga scala, la sicurezza AI non è un optional: è la base su cui si costruisce la fiducia nell’intero ecosistema. OpenAI ha compreso da subito questo aspetto, implementando livelli multipli di controllo sui contenuti generati, con un focus chiaro su prevenzione, moderazione e trasparenza.

Dalle AI non genera tutto ciò che le viene richiesto, ed è un bene. Esistono barriere, algoritmi di filtro, black list semantiche, sistemi di rilevamento e blocco. Tutto ciò per garantire che la creatività artificiale non venga distorta per scopi offensivi, violenti, discriminatori o ingannevoli. Perché se la tecnologia evolve, l’etica non può rimanere indietro.

Ecco perché oggi non si parla solo di AI generativa, ma di uso responsabile e controllo dei contenuti vietati, in un equilibrio delicato tra libertà espressiva e tutela collettiva.

Protezione contro contenuti nocivi: il filtro etico di Dall-E

Alla base del sistema di sicurezza c’è il filtro AI implementato da Dall-E, una rete di modelli e regole in grado di bloccare la generazione di contenuti potenzialmente dannosi. Questo filtro non agisce come una censura cieca, ma come una barriera semantica intelligente, capace di identificare prompt ambigui, insidiosi o pericolosi prima ancora che l’immagine venga generata.

Il sistema è in grado di distinguere tra richiesta artistica e contenuto sensibile, tra ironia e incitamento, tra erotismo concettuale e pornografia esplicita. E se il confine è sottile, il filtro etico agisce sempre per precauzione. Meglio un’immagine non generata che un danno diffuso.

Questo approccio non è solo tecnico, ma anche ideologico: OpenAI ha stabilito una responsabilità attiva nell’orientare l’uso delle sue tecnologie, riconoscendo il potere dei propri strumenti e anticipandone i possibili abusi.

L’obiettivo è duplice: proteggere gli utenti e preservare la dignità dell’output generato, mantenendo la credibilità della piattaforma. La etica generativa non è una funzione da attivare o disattivare, ma una componente strutturale dell’intero modello.

E in un’epoca in cui le immagini possono diventare virali in pochi minuti, il valore di un filtro ben progettato è pari, se non superiore, alla qualità dell’output visivo stesso.

Chi possiede le immagini? Diritti d’autore e implicazioni legali

Una delle questioni più discusse, e meno comprese, riguarda la titolarità delle immagini generate da intelligenza artificiale. Se Dalle AI crea un’immagine in base a un prompt fornito da un utente, chi ne detiene i diritti? È un’opera dell’utente, dell’algoritmo o di chi lo ha sviluppato?

Secondo l’attuale policy di OpenAI, le immagini generate tramite Dall-E appartengono all’utente che ha fornito il prompt, a patto che l’uso sia conforme alle linee guida del servizio. Questo significa che l’immagine può essere utilizzata liberamente per scopi personali, professionali, editoriali e commerciali, salvo violazione delle norme sui contenuti vietati.

Tuttavia, sul piano giuridico, il tema è ancora in evoluzione. I sistemi legislativi dei diversi Paesi non hanno ancora armonizzato una normativa univoca per la proprietà delle immagini AI, ed è possibile che nel tempo vengano introdotti regolamenti specifici sulla tracciabilità, l’attribuzione e la responsabilità dei contenuti generati.

Il concetto di copyright generativo apre scenari inediti: se l’AI rielabora dati da milioni di fonti, può un’immagine generata essere del tutto originale? E se no, può essere protetta? Alcune piattaforme iniziano a inserire watermark invisibili o identificatori che segnalano la natura “non umana” del contenuto.

Nel frattempo, l’uso consapevole è l’unica garanzia reale di tutela. Sapere cosa si può fare, cosa è vietato, e come dichiararlo. Perché nell’era dell’immaginazione automatica, la responsabilità resta sempre nelle mani di chi chiede, non solo di chi genera.

Come scrivere prompt efficaci con DALL-E per ottenere immagini di alta qualità

In un contesto dove le immagini si generano con una frase, la differenza tra un risultato mediocre e uno straordinario è tutta nella qualità del prompt. Con Dalle AI, la scrittura non è più solo un atto linguistico, ma un gesto visivo: ogni parola, ogni aggettivo, ogni relazione semantica genera forma, colore, stile. Non è un’esagerazione dire che chi sa scrivere un prompt, oggi, sa anche dipingere con le parole.

A differenza di altri tool, Dalle AI non si limita a interpretare parole chiave: elabora l’intero contesto, coglie le relazioni tra gli elementi, rispetta le proporzioni semantiche. Per questo la scrittura dei prompt richiede precisione, strategia, consapevolezza sintattica e visiva. Non si tratta solo di chiedere un’immagine, ma di saperla descrivere nella sua essenza profonda.

La qualità dell’output dipende direttamente dalla padronanza delle tecniche avanzate, che trasformano un’idea in un’immagine credibile, dettagliata, coerente. Più il linguaggio è mirato, più il sistema restituisce qualcosa che non solo funziona, ma emoziona. Perché nell’intelligenza artificiale, come nell’arte, la potenza visiva nasce sempre dalla chiarezza dell’intento.

Struttura e linguaggio dei prompt: best practices

Scrivere per Dall-E significa pensare in modo visivo. Ogni prompt efficace è composto da strati semantici che il modello interpreta per costruire un’immagine il più fedele possibile all’intento iniziale. Non è solo una questione di lessico, ma di architettura linguistica, in cui soggetto, azione, contesto e stile devono essere ben distinti e ordinati.

La costruzione ideale di un prompt parte sempre da un soggetto chiaro e ben definito. Non basta dire “un animale”, bisogna dire che animale, in quale posa, con quale espressione. Poi si passa all’azione: cosa sta facendo, dove si trova, con chi. Segue il contesto: ambiente, luce, prospettiva, stagione. Infine lo stile: realistico, surrealista, isometrico, minimalista. Ogni livello rafforza la costruzione semantica complessiva.

L’uso di keyword visive aiuta a restringere il campo e orientare l’output in direzioni precise. Parole come “dramatic lighting”, “ultra-detailed”, “cinematic composition”, “top-down view”, o “digital painting” fungono da catalizzatori di stile. Non sono decorazioni testuali: sono comandi impliciti.

L’ordine con cui si distribuiscono le informazioni è cruciale. Un prompt caotico genera immagini caotiche. Un prompt sequenziale, con logica narrativa, produce visual coerenti e rifiniti. È una scrittura che non si legge: si vede.

Per creare immagini di alta qualità con Dalle AI, è essenziale scrivere prompt strutturati. Ecco una guida visiva ai 4 livelli fondamentali.

Esempi pratici: dai prompt semplici a quelli complessi

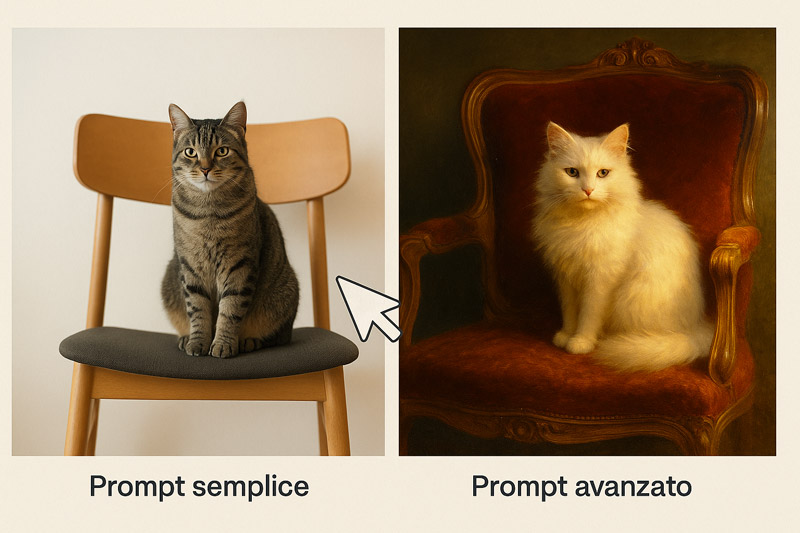

Per comprendere appieno la differenza tra un prompt base e uno avanzato, occorre analizzare come cambia la qualità visiva al variare della descrizione. Prendiamo un esempio semplice: “A cat on a chair”. Il risultato sarà generico, spesso privo di stile o contesto. Ora espandiamolo: “A fluffy white cat sitting on a vintage red velvet armchair, in front of a window with soft morning light, in the style of a 19th century oil painting”. Il salto qualitativo è immediato.

Il primo prompt fornisce un soggetto e una posizione. Il secondo offre un universo narrativo: colore, texture, illuminazione, epoca, stile artistico. E tutto questo viene tradotto in immagine con precisione maniacale da Dalle AI.

Anche nei prompt più complessi, l’efficacia dipende dalla capacità di mantenere una struttura logica, evitando ambiguità. Un prompt troppo lungo ma disorganizzato può generare confusione. L’obiettivo non è dire tutto, ma dire tutto ciò che serve, nel modo giusto.

Per ottenere il massimo, è utile imparare a gestire contrasti visivi, indicare atmosfere specifiche (“foggy night”, “golden hour”), giocare con le proporzioni (“giant bird next to a tiny house”), e usare riferimenti artistici noti (“in the style of Picasso”, “cyberpunk anime aesthetic”).

Non si tratta solo di ottenere belle immagini. Si tratta di allenare la mente a descrivere visivamente il pensiero, fino a farlo diventare immagine.

Per capire quanto incide la qualità di un prompt su Dalle AI, osserva questo confronto visivo tra una descrizione generica e una avanzata.

DALL·E vs. Midjourney vs. Stable Diffusion: quale scegliere?

In un mercato dove la generazione di immagini tramite AI è diventata una competenza strategica, scegliere lo strumento giusto può fare la differenza tra un’idea visuale banale e una narrazione visiva d’impatto. Oggi i tre grandi protagonisti di questa rivoluzione sono Dalle AI (tramite DALL·E), Midjourney e Stable Diffusion. Ognuno con le sue caratteristiche, il suo modello tecnico, il suo pubblico.

Non esiste una risposta assoluta. Esiste l’equilibrio tra esigenza e risultato, tra controllo e stile, tra immediatezza e potenzialità di personalizzazione. È qui che si gioca la vera scelta.

Chi cerca precisione descrittiva e facilità d’uso può trovare in Dalle AI un alleato perfetto. Chi desidera una spinta estetica audace e artistica potrebbe prediligere Midjourney. Chi invece cerca un ambiente aperto, personalizzabile e sperimentale trova terreno fertile con Stable Diffusion.

In tutti e tre i casi, siamo davanti a strumenti potentissimi, ma con finalità e filosofie operative diverse. E comprenderle è il primo passo per fare la scelta giusta.

Per comprendere come Dalle AI si differenzi realmente da altri strumenti generativi, osserva questo confronto visivo tra i tre modelli AI più popolari.

Analisi comparativa delle funzionalità e dei risultati

Dall-E si distingue per la sua capacità di interpretazione semantica. È pensato per utenti che desiderano generare immagini a partire da prompt descrittivi anche complessi, con una coerenza che si riflette nella fedeltà visiva. Il modello è addestrato per rispondere al linguaggio naturale in modo accurato, ed è integrato in ChatGPT per offrire un’interfaccia conversazionale estremamente fluida. I risultati sono generalmente precisi, sobri, funzionali a contesti editoriali, educativi e commerciali.

Midjourney, al contrario, parte da una visione più artistica e stilizzata. Le sue immagini colpiscono per forza visiva, atmosfera e texture. Il modello opera su server Discord, con un’interazione che avviene per comando testuale in ambienti pubblici o privati. Lo stile è fortemente riconoscibile, spesso surreale, cinematografico, espressionista. Per questo è apprezzato da creativi, illustratori, concept artist e designer visionari.

Stable Diffusion si pone come il più flessibile tra i tre. È open-source, installabile in locale, personalizzabile attraverso modelli addestrati, plugin e interfacce alternative. La curva di apprendimento è più ripida, ma il potenziale creativo è pressoché illimitato. Si presta a workflow professionali e sperimentazioni avanzate, offrendo il massimo controllo su stile, contenuti e pipeline visiva.

Il confronto tool non è solo tecnico, ma concettuale: precisione vs. stile, semplicità vs. potenza, accessibilità vs. profondità.

Pro e contro di ciascuno strumento in base alle esigenze

Per chi ha bisogno di risultati veloci, chiari, contestualizzati in un dialogo naturale, Dalle AI rappresenta la scelta più intuitiva. La sua forza sta nell’affidabilità del risultato, nella chiarezza del rapporto testo-immagine, nella possibilità di generare su misura senza perder tempo in regolazioni. Tuttavia, ha limiti stilistici: meno libertà creativa, meno originalità visiva, output più “contenuti”.

Midjourney, invece, punta tutto sul colpo d’occhio. Le immagini sono forti, visivamente magnetiche, quasi sempre suggestive. È perfetto per chi cerca impatto artistico, ma può risultare frustrante per chi ha bisogno di controllo preciso o output tecnici. Inoltre, richiede un prompt ben calibrato, e non sempre le variazioni sono coerenti. Qui, l’emozione batte la precisione.

Con Stable Diffusion, il discorso si amplia. È lo strumento ideale per sviluppatori, creativi avanzati e tecnici. Offre un controllo estremo sul modello, consente personalizzazioni profonde, addestramenti su dataset proprietari e flussi di lavoro professionali. I vantaggi sono immensi, ma i limiti evidenti: richiede competenza, risorse hardware e tempo. Non è per chi cerca un click-and-go, ma per chi vuole costruire la propria AI art machine.

In sintesi:

- Dalle AI per l’accessibilità e la precisione

- Midjourney per lo stile e l’impatto visivo

- Stable Diffusion per il controllo totale e la sperimentazione avanzata

La scelta dipende non da quale sia il “migliore”, ma da chi sei e cosa vuoi davvero ottenere.

Come integrare Dalle AI con Canva, PowerPoint e altri strumenti

Il valore di Dalle AI non si esaurisce nella generazione di immagini. Diventa esponenziale quando le sue creazioni entrano direttamente nei flussi operativi quotidiani, nei software più usati da designer, marketer, creativi, formatori. L’integrazione, in questo caso, non è una semplice importazione file: è un’estensione della creatività nel cuore degli strumenti di lavoro.

Oggi è possibile utilizzare le immagini create con Dalle AI in Canva, PowerPoint, Notion, Adobe Express e persino WordPress, senza frizioni o conversioni complicate. Questo consente di passare dalla generazione all’applicazione in pochi secondi, evitando blocchi di continuità nel processo creativo.

Questa fluidità è ciò che rende Dalle AI uno strumento non solo potente, ma efficiente, trasformandolo da “generatore” a “motore centrale di produzione grafica”. In particolare, nei tool grafici di uso quotidiano, la possibilità di inserire immagini uniche e su misura migliora la qualità visiva complessiva e riduce la dipendenza da stock generici e ripetitivi.

Ed è proprio questa capacità di integrarsi nativamente in ambienti preesistenti che consente a Dalle AI di diventare una vera estensione del design thinking.

Guida passo-passo all’integrazione con Canva

Dall-E non è integrato direttamente all’interno di Canva, ma grazie alla versatilità della piattaforma, l’uso combinato è immediato ed estremamente efficace. Una volta generata un’immagine con Dalle AI, è sufficiente scaricarla in formato PNG o JPEG e trascinarla nella libreria media di Canva. Da qui, può essere utilizzata come sfondo, elemento illustrativo, icona visiva o componente narrativa.

La forza di questa integrazione sta nella complementarità tra generazione e personalizzazione. Canva offre layout, font, animazioni, effetti e template; Dalle AI fornisce l’elemento visivo unico che mancava. Il risultato è un flusso creativo continuo in cui l’utente può ideare, visualizzare, perfezionare e pubblicare senza dover cambiare ambiente operativo.

Il processo funziona anche in modalità inversa: si può partire da un layout di Canva e chiedere a Dalle AI di generare immagini che si armonizzino con colori, stile e tono del progetto, creando un’unità visiva impossibile da ottenere con le librerie standard.

Nelle attività più complesse – come brand kit, pitch deck, contenuti social – il flusso creativo guidato dall’IA permette di generare varianti, esplorare alternative, testare combinazioni. E con un semplice drag & drop, ogni idea si trasforma in design reale.

Questa sinergia rappresenta un’evoluzione concreta: non si tratta di scegliere tra Dall-E e Canva, ma di fonderli in un unico sistema espressivo.

Per comprendere concretamente come Dalle AI può essere integrata nei tool di design, ecco un mockup che mostra l’inserimento diretto in Canva.

Utilizzo di Dalle AI in presentazioni e progetti professionali

Quando si tratta di presentazioni, la qualità delle immagini gioca un ruolo decisivo nella percezione e nell’impatto emotivo del messaggio. Qui, l’inserimento delle immagini generate con Dalle AI in strumenti come PowerPoint o Google Slides rappresenta una svolta: ogni slide può avere un’identità visiva originale, costruita su misura per il messaggio da trasmettere.

Il flusso è semplice e diretto: si crea il prompt in ChatGPT o sulla piattaforma dedicata, si scarica l’immagine e la si inserisce nella slide desiderata. L’effetto visivo è immediato. Ma il vero vantaggio è l’efficienza creativa: non si perde tempo a cercare immagini stock, a modificarle, a renderle coerenti. Si genera direttamente ciò che serve, come serve.

In contesti corporate, questo si traduce in presentazioni più professionali, persuasive e coerenti con l’identità del brand. Si possono costruire scenari, metafore visive, infografiche creative partendo da concetti astratti, visualizzandoli con un’estetica controllata.

Anche in progetti educativi, editoriali o UX, l’utilizzo di immagini personalizzate generate da IA consente una narrazione visiva più ricca, adattabile a ogni pubblico e contesto. E con la possibilità di produrre variazioni in tempo reale, ogni elemento può essere declinato per target, canale e obiettivo, senza compromessi qualitativi.

In breve, l’integrazione di Dalle AI nei progetti professionali non è solo una comodità: è una strategia per elevare il valore percepito dei propri contenuti visivi.

Come ottenere immagini con caratteristiche precise usando Dalle AI

Quando si lavora con Dalle AI, la vera differenza non è tra chi scrive un prompt e chi non lo fa, ma tra chi sa pilotare il risultato e chi si affida al caso. Perché generare immagini a partire da una descrizione è facile, ma generare immagini coerenti, mirate e stilisticamente controllate è tutt’altra questione.

In questo scenario, l’efficacia dipende dalla capacità di ottimizzare il prompt, affinando ogni parola come se fosse una pennellata. La precisione nella definizione di stile, composizione, colori, atmosfera o riferimenti culturali determina un output mirato, funzionale al contesto d’uso: dal branding all’editoria, dalla formazione al design visuale.

Chi padroneggia l’arte del prompting evoluto è in grado di tradurre la propria visione in un’immagine esatta, senza compromessi. Non si tratta di magia, ma di metodo: ogni caratteristica che desideri nell’immagine va anticipata nel prompt, esattamente come farebbe un art director con il suo team.

Con Dalle AI, l’output non è mai casuale. È esattamente quello che chiedi — se sai come chiedere.

Definire stile, composizione e palette di colori nei prompt

Uno degli errori più comuni è dare per scontato che basti inserire un soggetto per ottenere un’immagine efficace. In realtà, la chiave sta nel costruire prompt descrittivi che includano anche le dimensioni visive del risultato: lo stile, la composizione e la palette cromatica.

Con Dall-E, questi tre elementi agiscono come direttori d’orchestra. Lo stile visivo — che può spaziare dal realismo fotografico all’illustrazione digitale, dallo steampunk al minimalismo giapponese — orienta l’intera estetica. È sufficiente inserire espressioni come “in the style of ukiyo-e” o “flat vector illustration” per cambiare radicalmente l’impatto.

La composizione si definisce specificando l’inquadratura, la disposizione degli elementi, il punto di vista. Termini come “top-down view”, “centered portrait”, o “wide angle perspective” influenzano l’assetto spaziale e la gerarchia visiva.

Infine, la palette colori può essere indirizzata con indicazioni dirette (“pastel tones”, “neon palette”, “earthy warm colors”) oppure implicitamente, attraverso suggestioni semantiche (“sunset mood”, “cyberpunk atmosphere”).

La combinazione di questi tre livelli produce un’immagine non solo bella, ma coerente con il tuo obiettivo. E in ogni contesto professionale — che si tratti di design, marketing o creatività editoriale — questa coerenza è ciò che distingue un buon lavoro da un risultato memorabile.

Utilizzo di riferimenti culturali e artistici per guidare la generazione

Per ottenere immagini dal forte impatto simbolico o estetico, l’inserimento di citazioni visive all’interno del prompt è uno strumento potente e spesso sottovalutato. Con Dalle AI, puoi evocare stili, epoche, artisti, movimenti, culture visive intere semplicemente nominandoli nel testo.

Chiedere un ritratto “in stile Picasso” o una scena “inspired by Studio Ghibli” attiva un processo generativo basato sulla somiglianza stilistica, sull’astrazione formale, sulla palette iconografica associata a quel riferimento. Questo tipo di ispirazione iconografica non solo funziona, ma educa il modello a muoversi dentro coordinate visive specifiche.

Anche i riferimenti culturali — storici, mitologici, cinematografici, geografici — aggiungono profondità narrativa e coerenza simbolica. Una scena ambientata in “medieval Tuscany”, per esempio, avrà un’estetica radicalmente diversa rispetto a una ambientata in “Tokyo during the Meiji period”.

Inserire queste coordinate all’interno del prompt consente di ridurre l’ambiguità dell’output, ottenendo immagini che parlano una lingua visiva chiara, immediatamente riconoscibile e adatta a un target preciso.

In contesti professionali, questo significa controllo totale sull’identità visiva, su coerenza di campagna, su aderenza a uno storytelling. E in un mondo visivo sovraffollato, la capacità di evocare l’archetipo giusto, al momento giusto, è ciò che fa la differenza.

Dalle AI come alleato creativo: perché sta cambiando il modo in cui vediamo le parole

Non è solo uno strumento, non è solo un generatore. Dalle AI sta ridefinendo il modo stesso in cui concetti, emozioni, visioni e narrazioni prendono forma. In un mondo sempre più dominato dalla comunicazione visuale, la possibilità di tradurre parole in immagini precise, coerenti, evocative rappresenta una svolta culturale prima ancora che tecnologica.

Oggi, chiunque può esprimere un’idea in forma visiva senza mediazioni, senza dover passare per fasi tecniche complesse, senza doversi scontrare con i limiti dell’esecuzione grafica tradizionale. Basta un prompt, e l’immaginazione diventa immagine. E questo non è solo un processo efficiente: è un cambio di paradigma nel rapporto tra pensiero e rappresentazione.

Nel cuore di questa trasformazione c’è DALL·E, l’anima generativa che alimenta Dalle AI e che continua ad evolversi per comprendere sempre meglio il linguaggio umano. La sua capacità di cogliere contesto, stile, atmosfera, ritmo e colore da una semplice frase lo rende un partner creativo a tutti gli effetti, non un esecutore. È questa intelligenza interpretativa che ha reso possibile una rivoluzione visiva AI capace di attraversare settori, generazioni e discipline.

Non stiamo assistendo alla sostituzione dell’artista, del designer o del copywriter. Stiamo entrando in una fase nuova, dove l’artista pensa con le parole, il designer visualizza con i prompt, il narratore costruisce mondi partendo da una sintassi ben orchestrata. La generazione creativa diventa co-creazione, e questo cambia radicalmente il flusso del processo produttivo.

Dalle AI ha abbattuto le barriere tra testo e immagine, tra idea e forma, tra intuizione e output. Ma ciò che conta davvero è come ha riscritto il concetto stesso di possibilità visiva. Ha ampliato il dizionario della creatività, ha reso accessibile ciò che prima era esclusivo, ha permesso a chiunque di vedere – letteralmente – ciò che pensa.

E ora che le parole sono diventate la nuova tavolozza, il futuro della comunicazione passa da qui: da una frase, da un’idea, da un prompt. Da Dalle AI, che non si limita a generare immagini, ma ridefinisce il modo in cui vediamo il pensiero stesso.

Con l’introduzione di GPT-4o, OpenAI ha compiuto un ulteriore passo avanti nell’evoluzione dell’IA generativa. Questo modello multimodale integra la generazione di testo, immagini e audio in un’unica piattaforma, offrendo una comprensione contestuale avanzata e una resa visiva migliorata. GPT Image 1, componente di GPT-4o dedicata alla generazione di immagini, supera le capacità di DALL·E 3, permettendo una maggiore precisione nella resa del testo e una migliore interpretazione delle istruzioni fornite.

Queste innovazioni rappresentano un cambiamento significativo nel panorama dell’IA generativa, offrendo nuove opportunità per creativi, designer e professionisti del settore.

Domande frequenti su Dalle AI: guida completa per utenti e creativi

❓ Cos’è Dalle AI e come funziona?

Dalle AI è un sistema di intelligenza artificiale sviluppato da OpenAI che genera immagini realistiche a partire da descrizioni testuali. Utilizza modelli avanzati come CLIP e tecniche di diffusione per interpretare e visualizzare i prompt forniti dagli utenti.

❓ Dalle AI è gratuito o a pagamento?

Dalle AI offre un piano gratuito con un numero limitato di crediti mensili. Per un utilizzo più intensivo o professionale, sono disponibili piani a pagamento che offrono maggiori funzionalità e priorità nell’elaborazione delle immagini.

❓ Come posso scrivere prompt efficaci per Dalle AI?

Per ottenere risultati ottimali, è consigliabile essere specifici e dettagliati nei prompt, includendo elementi come stile artistico, composizione, colori e riferimenti culturali. Evitare ambiguità e utilizzare un linguaggio chiaro aiuta l’IA a generare immagini più accurate

❓ Quali sono le differenze tra DALL·E 2 e DALL·E 3?

DALL·E 3 rappresenta un’evoluzione rispetto a DALL·E 2, offrendo una comprensione più profonda dei prompt, una maggiore coerenza nei dettagli e la capacità di generare immagini con risoluzioni più elevate e proporzioni variabili.

❓ Posso utilizzare le immagini generate per scopi commerciali?

Sì, le immagini create con Dalle AI possono essere utilizzate per scopi commerciali, inclusi marketing, branding e vendita, a condizione di rispettare le linee guida e le politiche di utilizzo stabilite da OpenAI.

❓ È possibile integrare Dalle AI con altri strumenti come Canva o PowerPoint?

Sebbene Dalle AI non offra integrazioni dirette con strumenti come Canva o PowerPoint, è possibile esportare le immagini generate e importarle manualmente in questi programmi per utilizzarle in presentazioni, progetti grafici e altri contenuti.

❓ Come garantisce Dalle AI la sicurezza e l’etica nella generazione delle immagini?

Dalle AI implementa filtri e controlli per prevenire la creazione di contenuti inappropriati o dannosi. OpenAI monitora attivamente l’uso del sistema per garantire che le immagini generate rispettino standard etici e legali.

❓ Cos’è GPT-4o e in che modo ha sostituito DALL·E 3?

GPT-4o è il modello multimodale di OpenAI che integra testo, immagini e audio in un’unica piattaforma. Ha sostituito DALL·E 3 offrendo una generazione di immagini più precisa e contestualmente coerente, grazie alla sua capacità di comprendere meglio le istruzioni fornite. Con GPT-4o, la creazione di immagini avviene direttamente all’interno di ChatGPT, senza la necessità di strumenti separati.

❓ Esiste un modello chiamato DALL·E 4?

Attualmente, OpenAI non ha rilasciato un modello denominato DALL·E 4. Le funzionalità avanzate di generazione di immagini precedentemente associate a DALL·E sono ora integrate in GPT-4o, attraverso la componente GPT Image 1. Questa evoluzione rappresenta un cambiamento significativo nella tecnologia di generazione di immagini AI.

❓ Come si usa oggi la generazione immagini AI con ChatGPT?

Per utilizzare la generazione di immagini AI in ChatGPT, è sufficiente inserire una descrizione testuale (prompt) nella chat. GPT-4o elaborerà il testo e genererà un’immagine corrispondente direttamente nella conversazione. Questa funzionalità è disponibile per gli utenti con abbonamento a ChatGPT Plus e consente una creazione visiva fluida e integrata.

Scopri Dalle AI, il generatore di immagini che trasforma le tue parole in creazioni visive uniche. Nessuna esperienza grafica richiesta: basta un prompt per dare vita alla tua immaginazione.

PROVA DALL·E ORA