Immagina di avere una montagna di dati a tua disposizione e un sistema capace di estrarre informazioni preziose da essi. Questo è il cuore pulsante del supervised learning, una delle tecniche più utilizzate nell’ambito del machine learning. Ma cos’è esattamente il supervised learning e come funziona?

In parole semplici, il supervised learning è un approccio di apprendimento automatico in cui un algoritmo viene addestrato utilizzando un dataset etichettato. Ciò significa che ogni esempio di dati nel set di addestramento include sia l’input che l’output desiderato, consentendo al modello di apprendere a prevedere il risultato corretto per nuovi dati. Questa tecnica è particolarmente potente in ambiti come la classificazione, la regressione e il riconoscimento delle immagini, dove l’obiettivo è creare un modello capace di generalizzare le informazioni apprese durante la fase di training.

Un classico esempio di supervised learning è il riconoscimento facciale. Supponiamo di voler creare un sistema in grado di distinguere tra volti maschili e femminili. Il dataset di addestramento includerà immagini etichettate come ‘maschio’ o ‘femmina’. Durante il training, l’algoritmo imparerà a riconoscere i pattern distintivi che caratterizzano ciascuna categoria. In fase di test, il modello sarà in grado di effettuare previsioni accurate su nuove immagini non presenti nel dataset di addestramento.

Ma come funziona concretamente il supervised learning? L’algoritmo analizza gli input, elabora una funzione di mappatura tra input e output e continua a migliorare le sue previsioni attraverso iterazioni successive. L’accuratezza del modello dipende fortemente dalla qualità dei dati di addestramento e dalla capacità dell’algoritmo di evitare il fenomeno dell’overfitting, ovvero l’errore di apprendere troppo i dettagli del dataset di training senza generalizzare le informazioni.

In sintesi, il supervised learning rappresenta il primo passo per comprendere l’ampio universo del machine learning. Dalla classificazione delle email come ‘spam’ o ‘non spam’ alla previsione dei prezzi di mercato, questa tecnica offre un’ampia gamma di applicazioni concrete, rendendola essenziale per chiunque voglia avventurarsi nel mondo dell’apprendimento automatico.

Cos’è il Supervised Learning e Come Funziona?

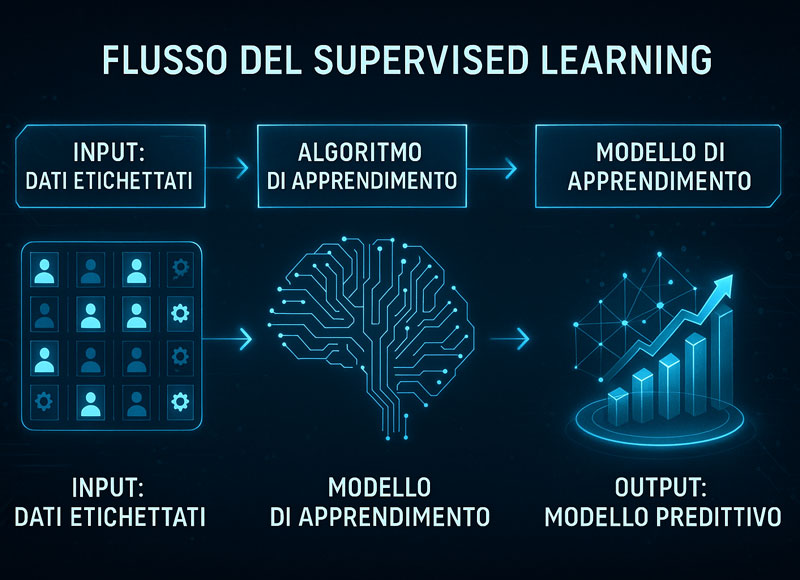

Il supervised learning rappresenta uno dei pilastri fondamentali del machine learning, utilizzato per insegnare agli algoritmi a prevedere output specifici a partire da input etichettati. In altre parole, si tratta di un metodo in cui il sistema impara tramite esempi predefiniti, dove ogni dato di input ha un corrispondente output atteso. Il processo è simile all’educazione umana: l’algoritmo riceve un insieme di dati di addestramento composto da coppie input-output, impara a riconoscere i pattern sottostanti e successivamente li applica per prevedere risultati su nuovi dati.

Un esempio concreto di apprendimento supervisionato è il riconoscimento delle immagini. Immagina di voler creare un modello capace di distinguere tra gatti e cani. Il dataset di addestramento includerà migliaia di immagini, ciascuna etichettata come ‘gatto’ o ‘cane’. Durante la fase di training, l’algoritmo identifica le caratteristiche distintive di ogni classe, come forma degli occhi, struttura delle orecchie e tipologia del pelo. Al termine del training, il modello sarà in grado di generalizzare le informazioni apprese per classificare correttamente nuove immagini.

Il supervised learning può essere suddiviso in due categorie principali:

- Classificazione, dove l’output è una categoria (ad esempio, spam o non spam).

- Regressione, dove l’output è un valore numerico (ad esempio, il prezzo di un immobile in base alla superficie e alla posizione).

L’efficacia del supervised learning dipende da due fattori critici: la qualità dei dati di addestramento e la capacità dell’algoritmo di evitare l’overfitting. Un dataset troppo ridotto o scarsamente etichettato rischia di compromettere le prestazioni del modello, mentre un algoritmo troppo complesso potrebbe imparare dettagli specifici anziché pattern generalizzabili.

Per comprendere visivamente il processo del supervised learning, osserva questa infografica che ne illustra il flusso step-by-step, dal dato etichettato al modello predittivo.

Definizione di Supervised Learning: Esempi e Applicazioni Pratiche

Il supervised learning si basa su un principio semplice ma potente: addestrare un modello su un dataset etichettato affinché possa effettuare previsioni su dati futuri. Ogni dato di input è associato a un output atteso, consentendo al modello di apprendere la relazione tra input e output.

Un esempio pratico riguarda l’analisi delle transazioni bancarie per individuare operazioni fraudolente. In questo contesto, un algoritmo di apprendimento supervisionato viene addestrato utilizzando un dataset di transazioni precedenti, ciascuna etichettata come ‘lecita’ o ‘fraudolenta’. Il modello impara a riconoscere pattern specifici associati a transazioni fraudolente, come importi elevati in località insolite o orari atipici.

Nel contesto del riconoscimento vocale, il supervised learning viene utilizzato per addestrare i sistemi di sintesi vocale. Immagina un algoritmo che deve distinguere tra diverse frasi pronunciate da persone con accenti differenti. Il dataset includerà file audio etichettati, permettendo al modello di apprendere i pattern fonetici associati a ciascun accento.

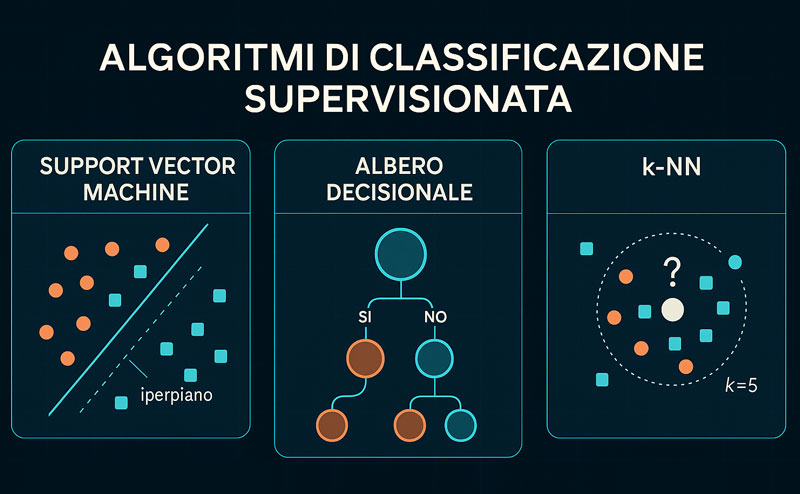

Gli algoritmi di apprendimento supervisionato più utilizzati includono:

- Support Vector Machines (SVM) per classificazione complessa in spazi ad alta dimensionalità.

- Decision Trees, che suddividono i dati in base a caratteristiche specifiche, creando una struttura ad albero.

- K-Nearest Neighbors (KNN), che calcola la distanza tra i dati per classificare nuovi input in base ai vicini più prossimi.

Ogni algoritmo ha punti di forza e debolezze specifiche, ma tutti condividono il medesimo obiettivo: apprendere dai dati etichettati per migliorare la capacità predittiva.

Come Funzionano gli Algoritmi di Supervised Learning? Tecniche e Strategie Avanzate

Il cuore del supervised learning risiede negli algoritmi di machine learning, che trasformano dati grezzi in previsioni basate su pattern riconosciuti durante la fase di addestramento. Esistono numerosi algoritmi, ciascuno adatto a specifici tipi di dati e obiettivi predittivi.

Un esempio avanzato di algoritmo è la Support Vector Machine (SVM), che utilizza iperpiani per separare i dati in classi distinte. Immagina un dataset di immagini di veicoli etichettate come ‘auto’ o ‘moto’. La SVM individua il confine ottimale tra le due classi, riducendo al minimo gli errori di classificazione.

Nel contesto del self supervised learning, l’algoritmo non riceve etichette esplicite ma impara a identificare i pattern utilizzando informazioni strutturate presenti nei dati stessi. Un esempio è la generazione di didascalie per immagini, in cui il modello apprende a descrivere le immagini basandosi su descrizioni testuali precedentemente associate ad altre immagini simili.

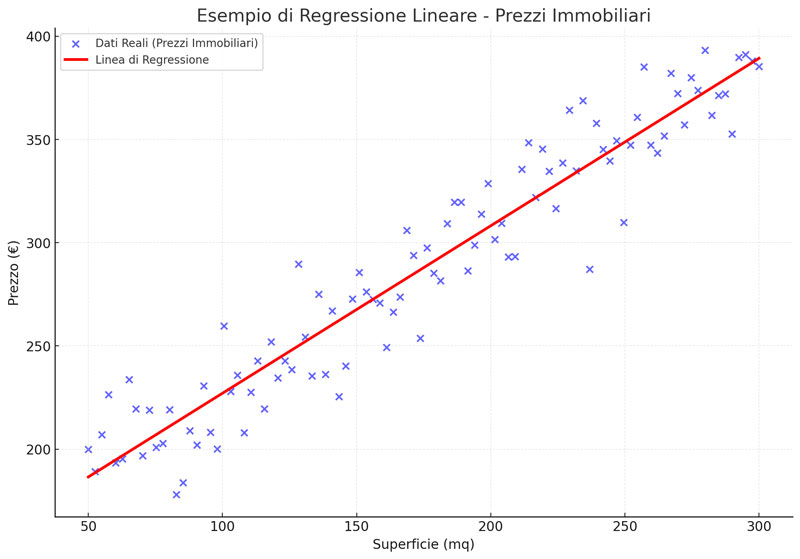

La regressione lineare, invece, è utilizzata per prevedere variabili numeriche. Un caso pratico potrebbe essere la previsione del prezzo degli immobili in base alla superficie e alla posizione geografica. L’algoritmo analizza le correlazioni tra le variabili e costruisce un modello predittivo basato sulla funzione lineare.

Infine, il K-Nearest Neighbors (KNN) classifica i dati in base alla distanza dagli esempi di addestramento più vicini. Ad esempio, per classificare un nuovo cliente come ‘a rischio’ o ‘non a rischio’ di default finanziario, il modello KNN confronta le caratteristiche del nuovo cliente con quelle di clienti precedenti, assegnando la classe in base alla maggioranza dei vicini più vicini.

L’elemento distintivo del supervised learning è la presenza di dati etichettati, che consentono all’algoritmo di apprendere in modo strutturato e di correggere costantemente gli errori. Tuttavia, la sfida principale è evitare l’overfitting, ossia il rischio che il modello si adatti troppo strettamente ai dati di training, perdendo la capacità di generalizzare su nuovi dati.

Algoritmi di Supervised Learning: Dai Classici ai Moderni

Il supervised learning si fonda su una vasta gamma di algoritmi di apprendimento, ognuno con caratteristiche specifiche che lo rendono adatto a compiti differenti. Questi algoritmi rappresentano l’elemento cardine per la costruzione di modelli predittivi capaci di analizzare dati etichettati e trarre conclusioni attendibili.

Gli algoritmi di apprendimento supervisionato si dividono principalmente in due categorie: classificazione e regressione. La classificazione riguarda l’assegnazione di etichette discrete (es. spam o non spam), mentre la regressione si focalizza sulla previsione di valori continui (es. prezzo di un immobile).

Un’ulteriore evoluzione nel contesto del supervised learning è rappresentata dal self supervised learning, una tecnica avanzata in cui l’algoritmo impara a generare le proprie etichette partendo da informazioni latenti all’interno dei dati stessi. Questa metodologia ha trovato applicazione in settori come il riconoscimento vocale e la computer vision, dove le etichette tradizionali possono risultare scarse o inesistenti.

Tra i principali algoritmi di apprendimento supervisionato emergono tecniche consolidate come Support Vector Machines (SVM), Decision Trees e K-Nearest Neighbors (KNN), ma anche approcci più recenti e complessi, quali le reti neurali profonde e i modelli di apprendimento auto-supervisionato. L’elemento comune tra tutti questi algoritmi è la necessità di un dataset di training etichettato, che costituisce il punto di partenza per ogni processo di apprendimento supervisionato.

Algoritmi di Classificazione Supervisionata: SVM, Decision Trees, KNN

Gli algoritmi di classificazione supervisionata sono progettati per risolvere problemi in cui l’output consiste in una categoria discreta o etichetta. Tra le tecniche più diffuse spiccano le Support Vector Machines (SVM), che sfruttano iperpiani per separare le classi in spazi multidimensionali, ottimizzando al contempo il margine di separazione.

Un caso pratico di utilizzo delle SVM riguarda il riconoscimento delle frodi finanziarie. Immagina un dataset contenente transazioni bancarie etichettate come ‘lecite’ o ‘fraudolente’. L’algoritmo SVM costruisce un iperpiano che separa i due gruppi, identificando pattern specifici associati a comportamenti fraudolenti.

Un approccio differente è offerto dai Decision Trees, che segmentano i dati in base a caratteristiche specifiche, creando un albero decisionale in cui ogni nodo rappresenta una condizione logica. Ad esempio, per prevedere il rischio di default di un cliente, un albero decisionale potrebbe analizzare parametri come reddito, storico dei pagamenti e età, suddividendo i dati in base a soglie predeterminate.

Infine, il K-Nearest Neighbors (KNN) si basa su un concetto semplice ma efficace: classificare un dato in base ai k esempi più vicini nel dataset di training. Nel contesto del riconoscimento di immagini, il KNN confronta le caratteristiche di una nuova immagine con quelle di immagini già etichettate, assegnando la classe in base alla maggioranza dei vicini più prossimi.

Per comprendere meglio come funzionano gli algoritmi di classificazione supervisionata, osserva questa infografica che visualizza i concetti chiave di SVM, Alberi Decisionali e k-NN.

Questi algoritmi di machine learning offrono vantaggi e svantaggi distinti. Le SVM eccellono in spazi ad alta dimensionalità ma richiedono un elevato costo computazionale. I Decision Trees sono facilmente interpretabili ma suscettibili all’overfitting, mentre il KNN è semplice da implementare ma inefficiente in presenza di dataset di grandi dimensioni.

Regressione e Supervised Learning: Applicazioni e Casi Pratici

Nel contesto del supervised learning, la regressione rappresenta uno strumento chiave per la previsione di valori continui. A differenza della classificazione, che assegna etichette discrete, la regressione si focalizza sull’identificazione di pattern numerici all’interno dei dati.

Uno degli algoritmi di regressione più utilizzati è la regressione lineare, che modella la relazione tra variabili indipendenti e dipendenti tramite una funzione lineare. Un esempio concreto è la previsione del prezzo di immobili in base a fattori come superficie, posizione e anno di costruzione. In questo scenario, l’algoritmo calcola il coefficiente di correlazione tra le variabili, generando una linea di tendenza che consente di effettuare previsioni basate su nuovi input.

Per comprendere meglio l’uso della regressione lineare nel supervised learning, osserva il seguente grafico che mostra la relazione tra superficie e prezzo degli immobili.

Un approccio più complesso è rappresentato dalla regressione logistica, utilizzata per problemi di classificazione binaria. Ad esempio, per prevedere se un cliente effettuerà o meno un acquisto online, la regressione logistica analizza variabili come il tempo trascorso sul sito, il numero di prodotti visualizzati e la presenza di coupon promozionali.

Nel contesto dell’apprendimento supervisionato e non supervisionato, la regressione trova applicazione anche nei modelli ibridi, dove le previsioni numeriche possono essere utilizzate per generare etichette che alimentano ulteriori fasi di classificazione. Un caso pratico è la previsione del tasso di abbandono di un servizio di streaming. L’algoritmo analizza il comportamento degli utenti (es. numero di ore di visione settimanali, numero di episodi completati) per calcolare un punteggio di probabilità di abbandono. Successivamente, il sistema può utilizzare questo punteggio per segmentare gli utenti in cluster (alto rischio, medio rischio, basso rischio), avvicinandosi così al paradigma dell’apprendimento non supervisionato.

L’elemento cruciale nella regressione supervisionata è la qualità dei dati di input. Un dataset scarsamente strutturato o contenente outlier significativi può compromettere la capacità del modello di effettuare previsioni accurate. Per ridurre il rischio di overfitting, è fondamentale implementare tecniche di cross-validation e regularizzazione, garantendo così che il modello possa generalizzare efficacemente anche su nuovi dati non etichettati.

Supervised Learning vs Unsupervised Learning: Quali Differenze?

Il supervised learning e l’unsupervised learning rappresentano due approcci fondamentali nell’apprendimento automatico, ciascuno con caratteristiche distintive che ne determinano l’applicabilità in contesti specifici.

Per comprendere meglio le differenze tra supervised learning, unsupervised learning e self-supervised learning, consulta la tabella comparativa che evidenzia vantaggi, svantaggi e applicazioni pratiche.

| Caratteristica | Supervised Learning | Unsupervised Learning | Self-Supervised Learning |

|---|---|---|---|

| Dati di Input | Dati etichettati | Dati non etichettati | Dati non etichettati con etichette generate automaticamente |

| Obiettivo | Predire output specifici basati su input etichettati | Identificare pattern nascosti nei dati | Estrarre pattern latenti dai dati per creare etichette |

| Applicazioni Tipiche | Classificazione, regressione, rilevazione di frodi | Clustering, riduzione dimensionale, analisi di similarità | Riconoscimento vocale, completamento di frasi, computer vision |

| Vantaggi | Alta accuratezza, interpretabilità, predittività | Nessuna necessità di dati etichettati, esplorazione dei dati | Riduce i costi di etichettatura, aumenta il volume dei dati di training |

| Svantaggi | Richiede molti dati etichettati, rischio di overfitting | Output meno preciso, difficile interpretazione dei cluster | Maggiori risorse computazionali, rischio di generare etichette non accurate |

| Modelli Comuni | SVM, Decision Trees, KNN, Regressione Lineare | K-means, PCA, Apriori, DBSCAN | BERT, GPT, SimCLR |

| Scalabilità | Scalabilità limitata dai dati etichettati | Alta scalabilità, ma output meno accurato | Scalabile ma richiede elevata capacità computazionale |

La differenza principale tra i due risiede nella natura dei dati di input: nel supervised learning, ogni esempio di training è associato a un’etichetta di output predeterminata, mentre nell’unsupervised learning i dati non sono etichettati, costringendo l’algoritmo a individuare pattern nascosti senza supervisione esterna.

Nel supervised learning, l’obiettivo è costruire un modello predittivo in grado di generalizzare dai dati di training e applicare le conoscenze acquisite per effettuare previsioni su nuovi input. Immagina un sistema di riconoscimento vocale che distingue tra comandi vocali predefiniti. Il dataset di training conterrà registrazioni audio etichettate con il comando corrispondente, consentendo al modello di apprendere le caratteristiche acustiche di ciascun comando.

L’unsupervised learning, al contrario, si concentra sulla rilevazione di pattern intrinseci all’interno dei dati non etichettati. Un esempio pratico è il clustering, in cui l’algoritmo identifica gruppi di dati con caratteristiche simili senza conoscere in anticipo il numero di cluster. Un caso applicativo riguarda l’analisi del comportamento degli utenti di un sito e-commerce. L’algoritmo potrebbe raggruppare gli utenti in segmenti distinti (es. acquirenti abituali, visitatori casuali) basandosi solo su parametri come frequenza di visita, importo medio degli acquisti e categorie di prodotti visualizzati.

Il supervised learning eccelle in contesti dove le etichette sono disponibili e accuratamente definite, mentre l’unsupervised learning trova applicazione in scenari esplorativi, dove l’obiettivo è estrarre conoscenza latente dai dati grezzi.

Caratteristiche dell’Apprendimento Supervisionato: Vantaggi e Svantaggi

L’apprendimento supervisionato rappresenta uno degli approcci più utilizzati nel machine learning, grazie alla sua capacità di generare modelli predittivi altamente accurati. Tuttavia, questa metodologia presenta vantaggi significativi ma anche limiti che non possono essere ignorati.

Tra i vantaggi del supervised learning, spicca la capacità di ottenere previsioni estremamente accurate, soprattutto quando il dataset di training è ampio e ben etichettato. Ad esempio, un algoritmo di riconoscimento facciale addestrato su migliaia di immagini etichettate sarà in grado di identificare volti nuovi con un’elevata percentuale di successo.

Inoltre, l’apprendimento supervisionato consente di monitorare il processo di addestramento, permettendo agli sviluppatori di valutare le prestazioni del modello in tempo reale. Ciò facilita l’implementazione di tecniche di fine-tuning, come la regolarizzazione e il dropout, per migliorare la capacità predittiva del modello senza incorrere nel rischio di overfitting.

Tuttavia, l’apprendimento supervisionato presenta anche alcuni svantaggi rilevanti. Il primo limite riguarda la dipendenza dai dati etichettati, che devono essere numerosi, accurati e rappresentativi dell’intero spazio dei dati. La raccolta e la preparazione di dataset di qualità richiede tempo e risorse significative, rappresentando un costo considerevole in fase di sviluppo.

Un altro svantaggio è il rischio di overfitting, ossia la tendenza del modello a imparare troppo i dettagli del dataset di training, compromettendo la capacità di generalizzare su dati nuovi. Un esempio concreto riguarda un sistema di raccomandazione di prodotti basato su cronologia di acquisto. Se il dataset di training contiene prevalentemente prodotti elettronici, il modello potrebbe fallire nel raccomandare articoli di altre categorie (es. abbigliamento, libri).

In sintesi, l’apprendimento supervisionato offre prestazioni elevate in contesti strutturati e con dati ben etichettati, ma richiede un approccio bilanciato per evitare il sovraccarico di informazioni e garantire la generalizzabilità del modello.

Quando Utilizzare Supervised o Unsupervised Learning? Esempi e Casi Studio

La scelta tra apprendimento supervisionato e non supervisionato dipende da vari fattori, tra cui la disponibilità di dati etichettati, l’obiettivo del progetto e la complessità dei pattern da identificare.

Il supervised learning si rivela particolarmente efficace in contesti dove le etichette sono ben definite e rappresentano un output specifico da prevedere. Un esempio classico è il rilevamento di frodi finanziarie. Un algoritmo di classificazione addestrato su un dataset di transazioni bancarie etichettate come ‘lecite’ o ‘fraudolente’ sarà in grado di identificare attività sospette con un elevato grado di accuratezza.

Un altro caso studio significativo riguarda l’analisi predittiva dei guasti industriali. Immagina un impianto di produzione dotato di sensori che monitorano la temperatura, la pressione e le vibrazioni di un macchinario. Utilizzando un dataset di training contenente registrazioni di guasti precedenti, il modello supervisionato può apprendere i segnali precursori di un malfunzionamento imminente e inviare un allarme in tempo reale.

D’altro canto, l’unsupervised learning è ideale per contesti esplorativi, dove le etichette non sono disponibili o dove l’obiettivo principale è individuare strutture nascoste nei dati. Un esempio pratico è il clustering di clienti per strategie di marketing. Un’azienda e-commerce può utilizzare algoritmi di clustering per segmentare la propria base clienti in gruppi distinti (es. acquirenti abituali, utenti occasionali, nuovi clienti) basandosi su parametri come frequenza d’acquisto, spesa media e categorie di prodotti acquistati.

Infine, un contesto ibrido in cui il supervised learning e l’unsupervised learning si integrano perfettamente è il self supervised learning, dove l’algoritmo genera autonomamente le etichette basandosi su pattern latenti nei dati. Un esempio pratico è la traduzione automatica di testi. Inizialmente, l’algoritmo analizza frasi in lingua originale senza etichette esplicite, identificando pattern grammaticali e sintattici ricorrenti. Successivamente, utilizza tali pattern per generare traduzioni in altre lingue, migliorando progressivamente la propria accuratezza senza supervisione esterna.

In conclusione, la scelta tra supervised e unsupervised learning non è assoluta ma dipende dal contesto applicativo, dalla disponibilità di dati etichettati e dall’obiettivo del modello. Comprendere le differenze tra i due approcci consente di sfruttare al meglio le potenzialità di ciascun paradigma, massimizzando l’efficacia del processo di apprendimento automatico.

Self Supervised Learning: La Nuova Frontiera del Machine Learning

Il self supervised learning rappresenta un approccio innovativo che sta rapidamente guadagnando terreno nel panorama del machine learning. A differenza del supervised learning, dove ogni dato di input è associato a un’etichetta esplicita, il self supervised learning sfrutta i dati non etichettati per generare autonomamente le etichette, apprendendo dai pattern latenti presenti all’interno dei dati stessi.

Questo metodo si basa su un principio fondamentale: i dati contengono già le informazioni necessarie per apprendere le relazioni tra input e output, anche in assenza di etichette esplicite. Un esempio pratico è la predizione di parole mancanti in una frase. Immagina una rete neurale che analizza la frase: “Il gatto salta sul _____”. L’algoritmo impara a prevedere la parola mancante analizzando le correlazioni tra le parole presenti nel contesto.

Nel contesto dei modelli di apprendimento, il self supervised learning è particolarmente utile nei settori in cui la raccolta di dati etichettati è costosa o complessa. Ad esempio, nei sistemi di riconoscimento vocale, l’algoritmo può apprendere a distinguere tra differenti tonalità vocali analizzando grandi quantità di registrazioni audio senza etichette, individuando pattern ricorrenti che poi vengono utilizzati per generare etichette sintetiche.

Questa metodologia ha applicazioni avanzate anche nella computer vision. Un modello può essere addestrato a prevedere il contenuto di porzioni mancanti di un’immagine, imparando a riconoscere le caratteristiche distintive di oggetti, volti o paesaggi. Questo processo non solo riduce la dipendenza dai dati etichettati, ma consente anche di creare dataset di training più ricchi e diversificati, migliorando la capacità del modello di generalizzare su nuovi input.

Il self supervised learning si posiziona dunque come un ponte tra l’apprendimento supervisionato e non supervisionato, sfruttando la struttura intrinseca dei dati per generare etichettature autonome e ottimizzare il processo di training in assenza di dati etichettati tradizionali.

Cosa si Intende per Self Supervised Learning? Definizione e Applicazioni

Il self supervised learning può essere definito come un approccio di apprendimento automatico in cui l’algoritmo genera autonomamente le etichette per il training, utilizzando pattern latenti presenti nei dati non etichettati. In altre parole, il modello impara a prevedere determinate informazioni a partire da altre, creando un processo di auto-apprendimento supervisionato.

Un esempio concreto riguarda la previsione delle parole mancanti in un testo. Immagina un algoritmo addestrato a prevedere parole omesse in frasi come: “Il cane corre nel _____”. L’algoritmo analizza il contesto della frase e utilizza i pattern ricorrenti per generare etichette basate sulle parole precedenti e successive. Questo processo, pur non richiedendo etichette esplicite, consente all’algoritmo di apprendere relazioni semantiche tra le parole, rafforzando la sua capacità predittiva.

Nel campo della computer vision, il self supervised learning viene utilizzato per il completamento di immagini. Un modello può essere addestrato a prevedere il contenuto di una parte mancante di un’immagine, utilizzando i pixel circostanti come contesto. Questo processo è particolarmente utile nella creazione di dataset sintetici, in cui le immagini vengono manipolate per generare nuovi esempi di training, arricchendo il set di dati disponibili senza la necessità di etichette manuali.

Un altro esempio di self supervised learning è rappresentato dai modelli di apprendimento basati su sequenze temporali, come quelli utilizzati per il riconoscimento vocale. Un algoritmo può essere addestrato a prevedere la sequenza successiva di parole in una registrazione audio, basandosi esclusivamente sul contesto delle parole precedenti. Questo approccio riduce la dipendenza dai dati etichettati e consente di costruire modelli robusti anche in presenza di dati non strutturati.

In sintesi, il self supervised learning non solo amplia il campo di applicazione degli algoritmi di apprendimento, ma offre anche un metodo efficace per sfruttare dati non etichettati, trasformandoli in informazioni preziose per il training dei modelli.

Self Supervised vs Supervised Learning: Differenze, Pro e Contro

Il self supervised learning e il supervised learning rappresentano due approcci distinti, ma complementari, nell’ambito del machine learning. La differenza principale risiede nella natura dei dati utilizzati: mentre nel supervised learning ogni dato di input è associato a un’etichetta predefinita, nel self supervised learning l’algoritmo genera autonomamente le etichette, sfruttando i pattern latenti presenti nei dati stessi.

Un esempio pratico di apprendimento supervisionato è il riconoscimento di immagini etichettate. Immagina un modello addestrato a distinguere tra gatti e cani utilizzando un dataset di immagini in cui ogni immagine è associata a una specifica etichetta (‘gatto’ o ‘cane’). In fase di training, l’algoritmo impara a riconoscere le caratteristiche distintive di ciascuna classe (forma delle orecchie, struttura del muso) e applica queste conoscenze per classificare nuove immagini.

Al contrario, nel self supervised learning, il processo di training non prevede etichette esplicite. Un esempio comune è il completamento di sequenze testuali. L’algoritmo analizza il contesto di una frase parziale e prevede le parole mancanti basandosi sui pattern semantici identificati durante la fase di training. Questo approccio consente di costruire modelli più flessibili e meno dipendenti da dataset etichettati, ma richiede una capacità computazionale superiore per identificare pattern complessi nei dati grezzi.

Tra i vantaggi del self supervised learning, spicca la riduzione del costo di etichettatura, poiché l’algoritmo genera autonomamente le etichette a partire dai dati grezzi. Questo approccio è particolarmente utile in contesti in cui i dati etichettati sono scarsi o difficili da ottenere, come il riconoscimento vocale in lingue poco documentate o il monitoraggio di sensori industriali in ambienti remoti.

Tuttavia, il self supervised learning presenta anche alcuni svantaggi. L’assenza di etichette esplicite può rendere il training meno accurato, poiché l’algoritmo potrebbe generare etichette errate o non rappresentative del contesto reale. Inoltre, il processo di apprendimento basato su pattern latenti richiede una capacità computazionale elevata, rendendo il self supervised learning meno adatto a contesti con risorse hardware limitate.

In sintesi, la scelta tra supervised learning e self supervised learning dipende dalla disponibilità dei dati etichettati e dalla complessità dei pattern da apprendere. Mentre il supervised learning offre previsioni più accurate in contesti ben strutturati, il self supervised learning consente di sfruttare dati grezzi per generare etichette autonome, aprendo la strada a nuove applicazioni nel machine learning.

Vantaggi, Svantaggi e Sfide del Supervised Learning

Il supervised learning è una delle metodologie più utilizzate nell’ambito del machine learning grazie alla sua capacità di produrre modelli altamente accurati e interpretabili. Tuttavia, come ogni approccio, presenta vantaggi, svantaggi e sfide che devono essere attentamente valutati per ottimizzare il processo di apprendimento automatico.

Uno dei principali vantaggi del supervised learning risiede nella sua capacità di generare modelli predittivi basati su dati etichettati, garantendo un alto livello di accuratezza nelle previsioni. Questa caratteristica è particolarmente utile in settori come il riconoscimento delle immagini, la classificazione di testi e la previsione di vendite, dove le etichette fornite durante la fase di training consentono all’algoritmo di apprendere pattern specifici e generalizzarli su nuovi dati.

Tuttavia, il supervised learning non è esente da sfide. La sua dipendenza dai dati etichettati rappresenta un limite significativo, soprattutto in contesti in cui la raccolta di etichette accurate è complessa o dispendiosa. Inoltre, la scalabilità del modello può essere compromessa da dataset di grandi dimensioni, poiché un algoritmo supervisionato richiede un elevato volume di dati etichettati per garantire previsioni accurate.

Infine, il problema dell’overfitting rappresenta una delle sfide principali nel supervised learning. Se il modello impara troppo i dettagli del dataset di training, rischia di perdere la capacità di generalizzare su nuovi dati, riducendo l’efficacia delle previsioni. Questo fenomeno può essere mitigato attraverso tecniche di regularizzazione, cross-validation e data augmentation, che consentono di aumentare la varietà dei dati di training senza sovraccaricare il modello.

Vantaggi del Supervised Learning: Accuratezza, Predittività e Interpretabilità

l supervised learning è ampiamente riconosciuto per la sua capacità di generare modelli predittivi altamente accurati, soprattutto quando il dataset di training è ricco di dati etichettati e rappresentativi del problema da risolvere. La presenza di etichette esplicite consente al modello di apprendere pattern specifici, migliorando significativamente la qualità delle previsioni rispetto agli approcci non supervisionati.

Uno degli aspetti chiave del supervised learning è l’accuratezza delle previsioni. In contesti come il riconoscimento facciale, il modello può essere addestrato su migliaia di immagini etichettate, imparando a riconoscere le caratteristiche distintive di ogni volto. Questo approccio riduce il margine di errore e consente di ottenere previsioni precise anche su nuovi input non presenti nel dataset di training.

Un altro vantaggio rilevante è la predittività del modello, che consente di effettuare previsioni basate su pattern appresi durante la fase di training. Un esempio pratico è la previsione dei prezzi immobiliari in base a variabili come superficie, posizione e stato dell’immobile. Utilizzando un dataset di transazioni passate, il modello supervisionato è in grado di calcolare il valore di mercato di una nuova proprietà con un’alta percentuale di accuratezza.

Infine, la interpretabilità del modello rappresenta un ulteriore punto di forza del supervised learning. Algoritmi come i Decision Trees e le Support Vector Machines (SVM) producono modelli che non solo forniscono previsioni accurate, ma consentono anche di visualizzare i passaggi logici che hanno portato a tali previsioni. Questa trasparenza è fondamentale in contesti in cui è richiesta la giustificazione delle decisioni prese dal modello, come nel settore finanziario o sanitario.

In sintesi, i vantaggi del supervised learning includono elevata accuratezza, capacità predittiva e interpretabilità dei modelli, rendendolo una scelta ideale per applicazioni in cui i dati etichettati sono facilmente disponibili e le previsioni devono essere precise e giustificabili.

Limiti e Sfide: Overfitting, Data Dependency e Scalabilità

Nonostante i suoi numerosi vantaggi, il supervised learning presenta anche alcune criticità strutturali che possono compromettere le prestazioni del modello se non adeguatamente gestite.

Uno dei problemi più comuni è l’overfitting, ossia la tendenza del modello a imparare troppo accuratamente i dettagli del dataset di training, compromettendo la sua capacità di generalizzare su nuovi dati. Un esempio pratico riguarda un sistema di classificazione di email addestrato su un dataset contenente solo messaggi promozionali. Se il modello impara a riconoscere pattern troppo specifici, potrebbe etichettare come spam anche email legittime che condividono caratteristiche superficiali con i messaggi promozionali.

Per mitigare il rischio di overfitting, è possibile implementare tecniche di regularizzazione, come L1 e L2, che riducono il peso delle feature meno rilevanti, impedendo al modello di adattarsi eccessivamente ai dati di training. Un’altra strategia è la cross-validation, che suddivide il dataset in blocchi e utilizza ciascun blocco sia per il training che per la validazione, garantendo una valutazione più robusta delle prestazioni del modello.

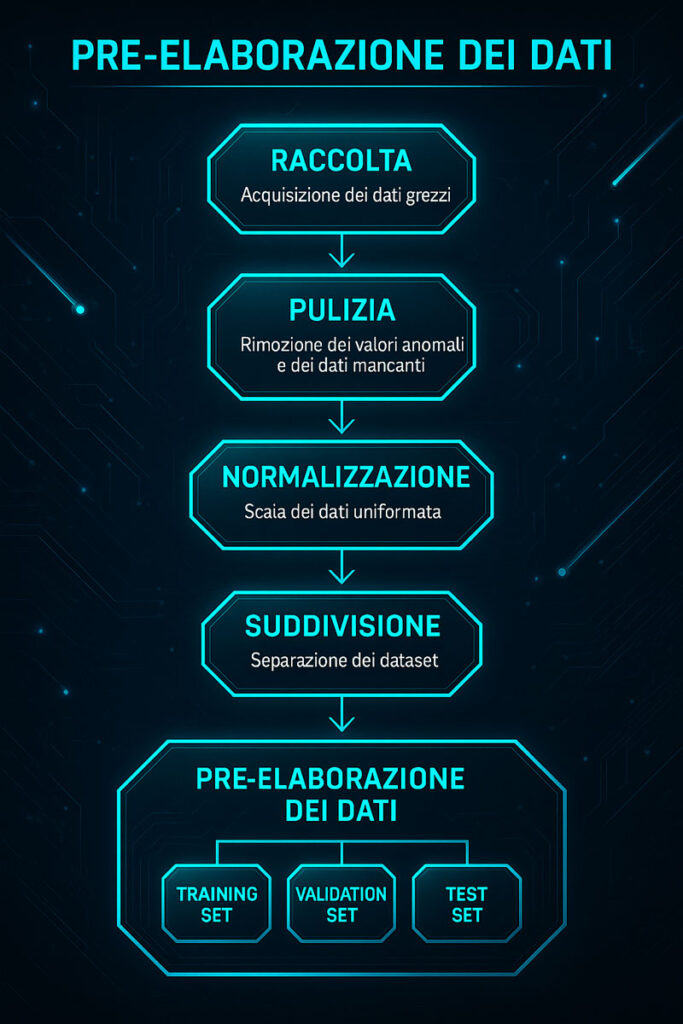

La pre-elaborazione dei dati è un passaggio fondamentale per prevenire l’overfitting e migliorare l’accuratezza del modello. Il diagramma seguente illustra il flusso completo del processo.

Un altro limite significativo è la dipendenza dai dati etichettati, che rappresenta una sfida critica in contesti in cui i dati disponibili non sono sufficientemente numerosi o accurati. Immagina di voler addestrare un modello di riconoscimento vocale in una lingua poco documentata. La scarsità di dati etichettati rende difficile costruire un dataset di training rappresentativo, riducendo la capacità predittiva del modello.

Infine, la scalabilità del modello può diventare un ostacolo quando il dataset di training raggiunge dimensioni elevate. Algoritmi come le Support Vector Machines (SVM), pur essendo altamente efficaci in spazi multidimensionali, richiedono un elevato costo computazionale per elaborare grandi volumi di dati. In questi casi, è possibile implementare strategie di data reduction, come Principal Component Analysis (PCA), che riducono la dimensionalità dei dati senza compromettere la qualità delle informazioni apprese dal modello.

In conclusione, il supervised learning offre elevate prestazioni predittive ma richiede un bilanciamento accurato tra accuratezza e capacità di generalizzazione. La gestione di problemi come overfitting, data dependency e scalabilità rappresenta una sfida continua, ma le tecniche avanzate di regularizzazione, cross-validation e data reduction consentono di ottimizzare le prestazioni del modello, garantendo un apprendimento efficace anche in presenza di dataset complessi o scarsamente etichettati.

Per comprendere come il supervised learning può essere applicato nel marketing per ridurre il churn rate, osserva il seguente caso studio che mostra il processo step-by-step.

Conclusione: Il Futuro del Supervised Learning nel Machine Learning

Il supervised learning si è affermato come una delle tecniche più solide e affidabili nel panorama del machine learning, ma il suo futuro sarà inevitabilmente influenzato dall’evoluzione dei modelli di apprendimento automatico e dall’integrazione di approcci più avanzati, come il self supervised learning.

In un contesto in cui la disponibilità di dati etichettati rappresenta ancora un ostacolo significativo, il self supervised learning si pone come una soluzione strategica, capace di colmare il divario tra l’apprendimento supervisionato e non supervisionato. Questo approccio, che sfrutta i pattern latenti nei dati grezzi per generare etichette sintetiche, consente di ampliare la capacità di training dei modelli anche in assenza di dati etichettati, riducendo i costi di etichettatura manuale e migliorando la generalizzabilità dei modelli.

Tuttavia, il supervised learning mantiene un ruolo cruciale in contesti in cui l’accuratezza delle previsioni è essenziale e i dati etichettati sono disponibili in quantità sufficienti. Un esempio concreto è il settore sanitario, dove modelli supervisionati vengono utilizzati per diagnosi automatizzate basate su immagini mediche, come le radiografie o le scansioni MRI. In questi contesti, la capacità predittiva del supervised learning resta insostituibile, soprattutto quando le etichette sono state verificate da esperti del settore.

Ma il futuro del supervised learning non può essere considerato statico. Gli algoritmi di apprendimento stanno evolvendo verso un’integrazione sempre più sofisticata di approcci ibridi, in cui le tecniche supervisionate vengono combinate con metodi di self supervised learning e unsupervised learning per migliorare ulteriormente le prestazioni dei modelli. Immagina un sistema di riconoscimento facciale che utilizza un dataset etichettato per apprendere le caratteristiche distintive dei volti e, contemporaneamente, sfrutta un self supervised learning per generare etichette aggiuntive basate su pattern ricorrenti rilevati nei dati non etichettati.

Questa strategia consente di creare modelli più robusti, in grado di adattarsi a scenari dinamici e di gestire dati in continuo cambiamento, riducendo il rischio di overfitting e migliorando la capacità del modello di generalizzare su nuovi input.

In definitiva, il supervised learning continuerà a svolgere un ruolo centrale nel machine learning, ma il suo futuro dipenderà dalla capacità degli sviluppatori di integrare tecniche di apprendimento avanzate, sfruttando al contempo i dati etichettati e quelli non etichettati per creare modelli più flessibili, predittivi e interpretabili.

Supervised Learning: Le 7 Domande Frequenti che Devi Conoscere

❓ Cos’è il supervised learning e come funziona?

Il supervised learning utilizza dati etichettati per addestrare i modelli a prevedere output specifici. L’algoritmo impara le relazioni tra input e output, applicando queste conoscenze a nuovi dati. Un esempio è il riconoscimento facciale, in cui le immagini etichettate consentono di classificare volti in base a caratteristiche specifiche.

❓ Quali sono i principali algoritmi utilizzati nel supervised learning?

I principali algoritmi nel supervised learning includono regressione lineare, SVM, Decision Trees e reti neurali. Ogni algoritmo è ottimizzato per compiti specifici. Le SVM sono ideali per classificazioni complesse, mentre la regressione lineare è indicata per previsioni numeriche.

❓ Quando è meglio utilizzare il supervised learning rispetto ad altri modelli di apprendimento?

Il supervised learning è perfetto per compiti in cui i dati etichettati sono abbondanti e le previsioni devono essere accurate. È utilizzato per la classificazione di email spam, la rilevazione di frodi e le previsioni di vendita. In assenza di etichette, si opta per il self supervised learning o l’unsupervised learning.

❓ Quali sono i vantaggi e gli svantaggi del supervised learning?

Il supervised learning offre alta accuratezza nelle previsioni e modelli interpretabili. Tuttavia, richiede grandi dataset etichettati e può soffrire di overfitting se il modello si adatta troppo ai dati di training, compromettendo le previsioni su nuovi input.

❓ Come si differenzia il self supervised learning dal supervised learning?

Nel supervised learning, le etichette sono fornite dagli esperti, mentre nel self supervised learning vengono generate automaticamente dai pattern nei dati. Questo approccio riduce i costi di etichettatura e sfrutta dati grezzi per il training.

❓ Quali sono le sfide comuni nell’implementazione del supervised learning?

Le sfide principali nel supervised learning includono la gestione dell’overfitting, la raccolta di dati etichettati di qualità e la scalabilità dei modelli. Tecniche come la regularizzazione e il data augmentation aiutano a mitigare questi problemi.

❓ Come preparare e pre-elaborare i dati per il supervised learning?

La pre-elaborazione dei dati nel supervised learning include pulizia, normalizzazione e suddivisione in set di training e test. L’obiettivo è garantire coerenza nei dati, ridurre outlier e ottimizzare la capacità predittiva del modello.

Esplora le migliori risorse per Supervised Learning. Approfondisci tecniche avanzate, strumenti e strategie per creare modelli predittivi accurati.

SCOPRI ORA LE RISORSE