Runway è molto più di un semplice software: è il cuore pulsante di una nuova era visiva in cui l’intelligenza artificiale diventa co-autrice della produzione creativa. Nell’attuale panorama digitale, in cui il tempo è risorsa e la qualità è pretesa, questa piattaforma emerge come soluzione trasformativa per chi desidera generare contenuti video in modo rapido, intuitivo e professionale. Non si tratta solo di un assistente, ma di un tool video AI completo che cambia le regole del gioco, mettendo potenza creativa nelle mani di chiunque, indipendentemente dalle competenze tecniche.

Ma cos’è davvero Runway, e perché sta attirando l’attenzione di creator, brand, filmmaker e agenzie in tutto il mondo? È una piattaforma creativa AI che combina modelli di diffusione generativa, ambienti visivi intuitivi e funzionalità di editing automatico per consentire a chiunque di trasformare un prompt testuale in un video generato da intelligenza artificiale, completo di movimento, coerenza stilistica e resa cinematografica. A differenza di altri strumenti simili, Runway non si limita a migliorare la fase di post-produzione: ridefinisce l’intero processo di creazione video dalla sua origine linguistica fino all’output visuale finale.

Il punto di forza della piattaforma non risiede solo nella sua tecnologia sottostante, ma nella sua accessibilità narrativa. La curva di apprendimento è piatta, l’ambiente di lavoro è fluido, le possibilità visive sono potenzialmente infinite. Per chi cerca un ai video generator capace di produrre materiale di alto impatto partendo da idee pure, senza necessità di camera, attori o set, Runway rappresenta un punto di svolta. Non è un caso se la domanda che circola è sempre più spesso “runway ai o produzione tradizionale?”.

Il mercato dei software AI creativi è in piena espansione, ma pochi strumenti offrono il livello di libertà, precisione e creazione video automatica che questa piattaforma garantisce. Runway diventa così un vero catalizzatore di cambiamento per la comunicazione visiva, democratizzando l’accesso alla produzione cinematografica assistita da intelligenza artificiale. In questo scenario, la domanda giusta non è se la AI sostituirà il videomaker, ma se il videomaker saprà collaborare con Runway per generare il proprio futuro visivo.

Cos’è Runway e perché sta trasformando il video editing con l’intelligenza artificiale

Runway non è semplicemente un software o un tool da aggiungere a una lista di strumenti digitali: è una piattaforma generativa progettata per ridefinire il significato stesso di produzione visiva nel contesto contemporaneo. In un ambiente dominato dalla rapidità e dalla necessità di produrre contenuti originali, coesi e coerenti con le aspettative del pubblico,

Runway agisce come sistema narrativo semantico, capace di convertire input testuali in esperienze video dinamiche e professionali. Non è più solo una questione di montaggio, ma di architettura visiva assistita da intelligenza artificiale, dove ogni elemento è generato, compreso e ottimizzato in base al contesto e all’intento.

La peculiarità di Runway non risiede solamente nei modelli di diffusione o negli algoritmi predittivi, ma nella fruibilità della sua interfaccia visiva AI-centrica, che permette anche a utenti non tecnici di ottenere risultati creativi avanzati. A differenza di altri software di editing o generatori video basati su AI, qui l’interazione non è mediata da processi complicati, ma avviene attraverso un linguaggio naturale e immediato, spesso testuale, che guida la generazione del contenuto.

Questo approccio rende la piattaforma estremamente efficace in termini di tempo, accessibilità e libertà creativa. Chi scrive, crea. Chi descrive, visualizza. E chi immagina, costruisce.

È proprio questa logica trasformativa che ha reso Runway un riferimento non solo per chi lavora con contenuti social o pubblicitari, ma anche per agenzie, videomaker e brand internazionali. Il sistema si adatta all’intenzione narrativa, anticipa la richiesta e modella il contenuto di conseguenza. In un’epoca in cui l’AI per content creator sta diventando uno standard, Runway incarna l’evoluzione naturale del processo creativo.

Non supporta la produzione: la guida, la struttura e la potenzia. E proprio in questa sinergia tra input umano e generazione automatizzata si cela il suo impatto reale. Chiunque oggi si chieda come funziona Runway, sta in realtà cercando di comprendere una nuova grammatica del video: una grammatica dove l’AI non è assistente, ma co-autore.

L’immagine seguente sintetizza l’essenza di Runway: un’interfaccia semplice, potente e pensata per trasformare la creatività in video professionali con l’aiuto dell’intelligenza artificiale.

Origini, mission e modelli fondativi di Runway

Runway nasce nel 2018 come progetto interdisciplinare sviluppato da un gruppo di ricercatori, artisti visivi e ingegneri con una missione precisa: rendere l’intelligenza artificiale uno strumento creativo, accessibile e modulare. Il focus iniziale non era costruire un software tecnico per addetti ai lavori, ma una piattaforma generativa fluida, che chiunque potesse usare per produrre contenuti visivi senza conoscenze di programmazione. Questo ha portato alla costruzione di un’interfaccia orientata all’intenzione narrativa più che alla manipolazione tecnica: chi immagina, descrive. Chi descrive, crea.

I primi strumenti si concentravano sulla manipolazione di immagini e video esistenti, sfruttando reti GAN e tecniche di interpolazione visiva per ottenere output dinamici in tempo reale. La vera svolta è arrivata con il lancio di Gen‑1, che ha introdotto la logica video-to-video: l’utente fornisce un video d’ingresso e un prompt testuale, e l’AI genera una nuova versione coerente con lo stile richiesto. Con Gen‑2 nasce il paradigma testo→video, che svincola l’output da qualsiasi input visivo iniziale. Da quel punto, Runway ha cominciato a definire una grammatica autonoma della narrazione visuale.

Alla base della filosofia Runway c’è un’idea fondamentale: l’AI non è un’alternativa al creativo umano, ma la sua estensione cognitiva. Non è un filtro, ma un agente generativo, in grado di interpretare, progettare e rifinire. I modelli fondativi combinano architetture di deep learning multimodale, attenzione visiva spaziale e training su dataset visivi diversificati. Ma tutto questo è nascosto sotto un’interfaccia che comunica per metafore visive, lasciando all’utente solo l’onere della direzione creativa. Questo disaccoppiamento tra complessità interna e semplicità esterna è il vero genius loci della piattaforma. Runway non si usa: Runway si dirige, si orchestra, si interpreta.

Chi usa Runway: creativi, brand, filmmaker, aziende

Runway non è uno strumento pensato per una nicchia tecnica, ma per un’ampia e crescente fascia di utenti che va dagli artisti ai brand internazionali. La sua architettura visiva e testuale, combinata con un approccio user-friendly, ha ridefinito l’idea di accessibilità nei software generativi. Chi oggi utilizza Runway appartiene a una costellazione di content creator, filmmaker, visual designer, social media manager, agenzie creative, studi di produzione e startup. Ognuno di questi profili sfrutta Runway non come semplice piattaforma, ma come amplificatore narrativo e visuale, un vero e proprio partner generativo.

Nel mondo del design visivo, l’intelligenza artificiale è sempre più centrale nei processi di prototipazione e ideazione. Runway consente di trasformare idee testuali in output coerenti per estetica, ritmo e movimento. Creatori freelance realizzano contenuti video in pochi minuti, senza dover passare da complicati software di montaggio. Nel marketing, la piattaforma è usata per generare spot dinamici, A/B test creativi e storyboard pre-lancio. I brand adottano Runway per accelerare il ciclo creativo e ottenere materiali di alta qualità senza costi elevati.

Anche nell’industria musicale, Runway ha assunto un ruolo di spicco: videoclip realizzati con l’AI sono ormai parte di progetti ufficiali e campagne di lancio. Case di produzione lo integrano nei propri workflow per sperimentare rapidamente diverse versioni di una stessa scena. In ambito educativo, le università e le scuole di cinema lo adottano come strumento di training immersivo. In tutti questi casi, l’elemento comune è la capacità della piattaforma di tradurre un’idea in una sequenza visiva perfettamente formata.

Runway ai, quindi, è oggi una risorsa strategica, un layer creativo che si adatta all’intento dell’utente. Non impone un’estetica, ma la co-costruisce. E lo fa con una velocità che cambia le regole del gioco. Chiunque cerchi uno strumento AI per la creazione video trova in Runway un alleato concreto, flessibile e sorprendentemente umano.

Dai Gen‑1 ai Gen‑4: come funzionano i modelli di generazione video di Runway

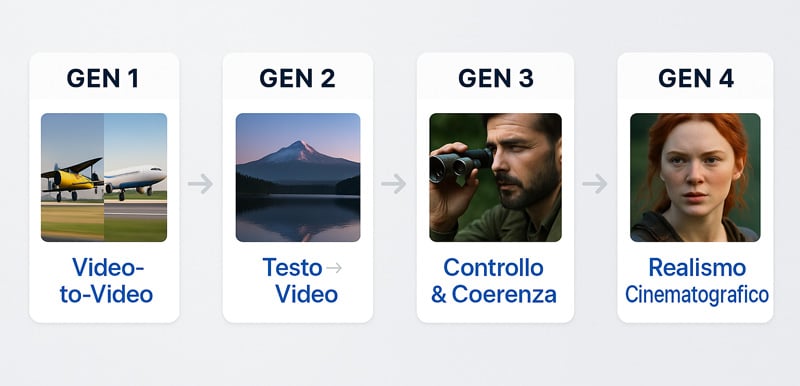

Nel panorama in rapida evoluzione dell’intelligenza artificiale applicata al video, Runway ha stabilito una traiettoria unica, scandita da modelli generativi sempre più sofisticati. Il cuore pulsante della sua tecnologia è una linea evolutiva che va da Gen‑1 a Gen‑4, dove ogni nuova versione non si limita a migliorare le prestazioni, ma ridefinisce il concetto stesso di creazione audiovisiva.

Gen‑1 è il punto di partenza: una tecnologia capace di reinterpretare un video esistente modificandone lo stile, il ritmo e il contenuto visivo a partire da una descrizione testuale. Era la fase di transizione, dove l’AI non inventava da zero, ma applicava trasformazioni stilistiche a materiali preesistenti. Un’idea rivoluzionaria per l’epoca, ma solo l’inizio.

Con Gen‑2, si verifica la svolta: l’intelligenza artificiale non ha più bisogno di un video di partenza. È sufficiente una frase, un prompt scritto, per dare origine a una sequenza animata coerente. La transizione da video-to-video a testo→video avviene con l’introduzione di sistemi di diffusione multimodale, capaci di decodificare il linguaggio naturale e convertirlo in struttura visiva.

L’arrivo di Gen‑3 Alpha introduce un salto qualitativo importante nella gestione della coerenza tra fotogrammi. L’output non è solo una sequenza di immagini: diventa una narrazione visiva fluida, con transizioni logiche e senso del movimento interno alla scena. Aumenta la precisione semantica, diminuisce l’effetto glitch, e migliora il rispetto dei prompt complessi.

Infine, con Gen‑4, Runway compie l’atto finale di maturazione. Il modello si avvicina alla qualità cinematografica, simulando profondità di campo, illuminazione realistica, direzione della scena e movimento di camera. Il controllo creativo è quasi totale: l’utente decide cosa accade, come e con quale estetica. La piattaforma integra encoder linguistici e motori visivi sincronizzati, per garantire stabilità, realismo e capacità interpretativa.

Non si tratta più di generare contenuti, ma di codificare visioni e intenzioni creative in forma di video. Ogni nuovo modello ridefinisce il confine tra tecnologia e regia, facendo di Runway uno degli ai video generator più avanzati oggi disponibili. E la promessa, con Gen‑5 già in sviluppo, è che questa evoluzione non si fermerà.

Gen 1 e Gen 2: da video-to-video a testo-guidato

Il primo passo verso la creazione video autonoma di Runway è stato Gen‑1, un modello che non generava contenuti da zero, ma interveniva su video già esistenti, trasformandoli sulla base di descrizioni testuali. Questo approccio ha introdotto un nuovo paradigma: la modifica semantica del contenuto visivo, dove un prompt linguistico veniva tradotto in variazioni dinamiche di colore, movimento e stile, pur conservando la struttura originale del video.

Il funzionamento di Gen‑1 si basava su architetture GAN modificate, affiancate a una logica di stile-transfer AI. Il sistema imparava a mantenere la coerenza di sequenze animate, riconoscendo la continuità tra i frame e applicando cambiamenti coerenti in ogni singolo fotogramma. La generazione video era, in sostanza, un’elaborazione avanzata dell’input, non ancora una creazione autonoma.

Con Gen‑2, invece, avviene il salto evolutivo: non serve più un video di partenza. L’utente inserisce un prompt testuale – ad esempio “un pianista suona in una sala neoclassica illuminata dalla luna” – e ottiene un video breve, generato integralmente dall’intelligenza artificiale. In questo scenario, Runway Text to Video diventa la nuova grammatica operativa: un prompt diventa uno storyboard sintetizzato.

L’aspetto più innovativo di Gen‑2 è l’impiego di modelli di diffusione multimodale, capaci di connettere sintassi linguistica, coerenza semantica e rappresentazione visiva. L’intelligenza artificiale non si limita a generare immagini in sequenza: costruisce una narrativa, capace di rispettare l’atmosfera, il movimento e le relazioni spaziali implicite nel linguaggio.

L’introduzione del text-to-video nativo ha fatto emergere anche nuovi problemi: ambiguità dei prompt, interpretazione soggettiva dei concetti, gestione del movimento. Ma è proprio in queste criticità che Runway ha dimostrato la sua capacità di evolversi. I modelli sono stati addestrati su enormi dataset visivi annotati, e hanno cominciato a comprendere non solo cosa generare, ma come farlo evolvere nel tempo.

Con Gen‑1 e Gen‑2, Runway ha creato una base stabile su cui si sono sviluppati i successivi modelli, ridefinendo l’interazione uomo‑AI nella produzione video. Non più software da istruire, ma compagni creativi da sollecitare con l’uso della parola.

Gen 3 Alpha & Gen 4: controllo, coerenza e realismo cinematografico

Con l’introduzione di Gen‑3 Alpha, Runway ha superato una delle barriere più ostiche nel campo della generazione video AI: la coerenza temporale tra i fotogrammi. Se i modelli precedenti riuscivano a generare video visivamente affascinanti ma con leggere discontinuità nella sequenza dei frame, qui il salto è evidente. Gen‑3 interpreta il tempo come una variabile narrativa: ogni frame anticipa il successivo con logica e fluidità, rispettando le intenzioni del prompt originario.

La differenza si nota nei dettagli: movimenti naturali, transizioni cinematiche, gestione del ritmo visivo. La piattaforma non si limita più a rispondere a un testo, ma inizia a interpretarlo come farebbe un regista, determinando cosa mostrare e come farlo evolvere. In questo contesto, Runway Text to Video assume una nuova valenza, diventando strumento di narrazione piuttosto che semplice generatore di contenuti.

Con Gen‑4, questa visione raggiunge la piena maturità. Non è solo l’output a migliorare, ma l’intero processo creativo viene ristrutturato. L’utente ha la possibilità di controllare in modo chirurgico ogni parametro della scena: angolazioni, illuminazione, direzione del movimento, composizione visiva. Il risultato non è più un video generato, ma un oggetto cinematografico definito nei minimi dettagli, dove ogni scelta ha coerenza estetica e narrativa.

La tecnologia sottostante a Gen‑4 sfrutta un’architettura ibrida tra encoder testuali, simulatori fisici e modelli neurali visivi. Questo mix consente alla piattaforma di ricostruire ambienti credibili, gestire luci dinamiche e realizzare effetti impossibili fino a pochi anni fa. Il tutto, senza sacrificare la rapidità: pochi secondi per generare minuti di contenuto.

Runway non è più soltanto un ai video generator, ma una suite registica AI. Con Gen‑4, è l’utente a dettare il tono, l’estetica, il linguaggio visivo. E mentre altri tool rincorrono fotorealismo o effetti visivi, Runway mette al centro il controllo creativo. Un’idea semplice e potente: non creare per l’AI, ma creare attraverso l’AI, restando autori della propria visione.

Ecco una sintesi visiva che mostra l’evoluzione dei modelli generativi Runway, dal primo approccio video-to-video fino alla produzione cinematografica con Gen‑4.

Prompt efficaci su Runway: guida pratica al controllo creativo

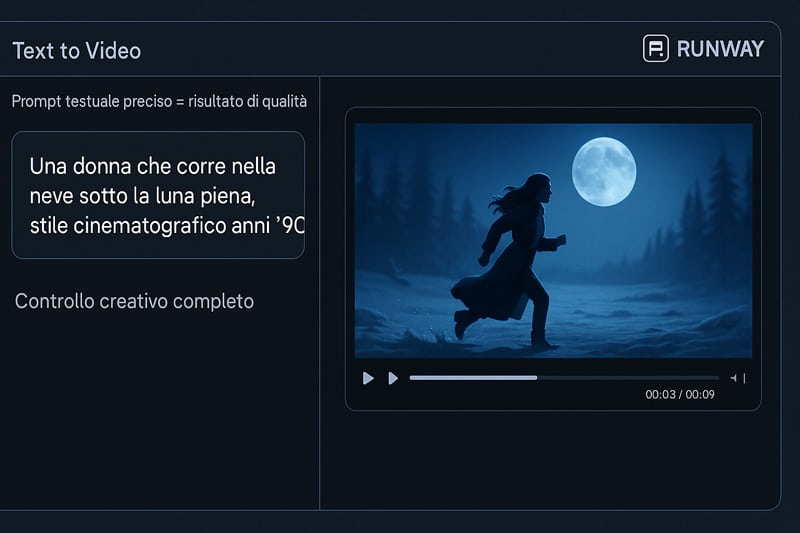

Nel cuore del nuovo linguaggio visivo c’è una disciplina spesso sottovalutata: la scrittura dei prompt. In un contesto dove l’intelligenza artificiale è capace di generare scene complete da una semplice frase, la precisione semantica diventa la vera leva creativa. Runway non si limita a interpretare parole, ma risponde a intenzioni, sfumature, dettagli. È quindi essenziale capire come scrivere un prompt efficace, soprattutto per Runway Text to Video, dove il confine tra idea e risultato è ridotto a pochi secondi.

L’esempio seguente mostra come un prompt ben costruito su Runway può influenzare direttamente la qualità e lo stile del video generato.

La potenza di questo tool AI non risiede solo nell’output, ma nella capacità dell’utente di guidare il modello verso l’espressione visiva desiderata. Ogni parola ha un peso specifico, ogni aggettivo può alterare drasticamente l’inquadratura, l’illuminazione o il movimento. Non è sufficiente scrivere “panorama urbano di notte”: serve specificare lo stile (“noir”), l’atmosfera (“nebbiosa, con pioggia leggera”), l’inquadratura (“panning laterale”) e il tono emotivo (“desolante, ma poetico”). Ogni dettaglio guida il motore AI verso un universo estetico coerente.

Nel mondo dei prompt generativi, il ruolo dell’autore non è più quello di chi detta ordini, ma di chi costruisce mondi tramite linguaggio strutturato. Runway accetta frasi lunghe, descrittive, complesse, e le interpreta grazie a un modello semantico raffinato. A differenza di tool AI più rigidi, consente libertà espressiva purché supportata da coerenza narrativa. Non esiste un prompt perfetto, ma esiste un equilibrio tra dettaglio e flusso, tra immaginazione e vincolo formale.

Il vero controllo creativo non si ottiene forzando l’intelligenza artificiale, ma collaborando con essa. Ogni video generato è il risultato di un dialogo: da una parte il linguaggio umano, dall’altra un sistema che decodifica, simula, genera. In questo dialogo, il prompt è la voce dell’autore, lo spartito che dirige l’orchestra neurale. Scrivere bene significa comporre visivamente con le parole, progettare immagini senza usare una telecamera.

Nella prossima sezione vedremo come portare il prompting su Runway a un livello avanzato, sfruttando elementi visivi complementari per spingere ancora più in là i confini della creazione AI.

Come scrivere prompt testuali vincenti su Runway Text to Video

Scrivere un prompt efficace su Runway Text to Video significa padroneggiare il linguaggio visivo attraverso una sintassi descrittiva, fluida e multilivello. Ogni termine ha una funzione semantica specifica e attiva corrispondenze iconiche nel modello generativo. Non basta “cane che corre sulla spiaggia”, bisogna specificare “golden retriever in slow motion, luce calda del tramonto, ripresa laterale, sabbia che si solleva in primo piano”. Questo livello di granularità guida runway a creare output più coerenti, credibili, cinematografici.

La costruzione del prompt si fonda su tre pilastri: ambientazione, azione, tono. Un prompt efficace unisce queste dimensioni in una frase unica ma ben articolata. Ad esempio: “vecchia stazione ferroviaria abbandonata, camera a mano, pioggia fitta, atmosfera nostalgica e desaturata”. Ogni frammento arricchisce l’interpretazione visiva del modello. A differenza di sistemi testuali, qui la coerenza narrativa è data dall’equilibrio tra dettagli concreti e intenti stilistici impliciti.

Un errore frequente è usare comandi generici o concatenazioni scolastiche (“mostrami un video di…”). In Runway, ogni parola agisce da vincolo o stimolo e può influenzare l’intero frame rendering. Inserire elementi temporali (“slow motion”), spaziali (“long shot”) o tonali (“elegante, malinconico”) fornisce al sistema segnali fondamentali per la resa finale. E ogni verbo (“vola”, “scivola”, “cade”) orienta la dinamica della scena.

L’ottimizzazione dei prompt richiede test, iterazioni e confronto tra risultati. Runway salva la cronologia creativa, permettendo di confrontare versioni con micro-varianti, favorendo una strategia di miglioramento continuo. Non si tratta di magia, ma di progettazione intenzionale: ogni parola è un pixel potenziale, ogni frase è un’interfaccia narrativa con la macchina.

Chi sa scrivere prompt sa costruire mondi. È il nuovo linguaggio visivo. Nella prossima sezione vedremo come amplificare questa potenza creativa grazie a tecniche avanzate che includono immagini di riferimento e tracciati visivi.

Tecniche avanzate: reference image, layout sketch, motion mask

L’efficacia di un prompt su Runway non si esaurisce nella componente testuale. Esistono strumenti avanzati che permettono di aumentare il controllo creativo, trasformando l’esperienza in una vera regia neurale. L’aggiunta di una reference image consente di ancorare il risultato visivo a uno stile preciso: un’opera d’arte, uno still cinematografico, una scena reale. Non si tratta di un semplice “influence style”, ma di una trasferenza morfologica e compositiva che modula ogni frame.

Il secondo livello è il layout sketch. In Runway è possibile caricare uno schizzo digitale o uno schema bidimensionale per determinare la struttura visiva della scena. Un arco, un ponte, la silhouette di un personaggio: questi elementi vengono interpretati come vincoli spaziali. Il tool AI li trasforma in elementi narrativi veri e propri, rispettando proporzioni, posizione e prospettiva.

Infine, la motion mask consente di definire quali aree del video devono restare statiche e quali possono essere animate. Si disegna una sorta di “mappa del movimento”, indicativa ma potentissima, per specificare la dinamica all’interno del frame. Questo strumento diventa cruciale quando si vogliono ottenere scene cinematografiche coerenti, dove ad esempio un soggetto resta fermo mentre lo sfondo si muove, oppure si ricrea un movimento di camera simulato.

Queste tre tecniche, se usate in combinazione, portano il prompting da descrizione a coreografia visiva. La potenza di Runway non è tanto nella generazione casuale, ma nella sua capacità di seguire l’intenzione visiva dell’autore, amplificando ogni input con interpretazione semantica e capacità visiva neurale. È qui che il tool si trasforma da semplice AI video generator in strumento creativo professionale, con cui progettare storytelling, visual concept e contenuti immersivi.

Nella sezione successiva esploreremo gli strumenti di editing nativi di Runway: non solo generazione, ma manipolazione e perfezionamento del materiale prodotto. Un ecosistema completo al servizio dell’immaginazione.

Editor video AI: tutti gli strumenti smart di Runway

Runway non è un semplice software di montaggio, ma un video editor basato sull’intelligenza artificiale capace di interpretare scene, prevedere trasformazioni visive e automatizzare processi creativi complessi. Questo approccio rende l’editing più accessibile, immediato e qualitativamente superiore. Ogni funzione all’interno della piattaforma è progettata per ridurre al minimo l’intervento tecnico e massimizzare l’impatto visivo finale. Non si tratta solo di velocità: si tratta di precisione semantica, ottimizzazione percettiva e coerenza narrativa.

Con Runway, lo spazio visivo diventa un campo manipolabile in tempo reale. I tool di editing video AI sono costruiti su architetture neurali che analizzano forma, colore, profondità e relazione tra gli elementi, per intervenire in modo selettivo. L’interpolazione automatica, la rimozione intelligente dello sfondo, la sfocatura guidata dal contesto visivo, sono solo alcuni esempi del livello di sofisticazione disponibile. L’utente può così creare effetti avanzati senza saper programmare o padroneggiare software complessi.

Questa filosofia si riflette anche nella gestione del movimento: non si tratta solo di transizioni o filtri, ma di manipolazione visiva assistita, che considera la dinamica della scena, la centralità semantica dei soggetti, e le esigenze narrative del contenuto. Il risultato è un video coerente, dinamico, in cui ogni modifica è frutto di una logica predittiva adattiva. La semplicità dell’interfaccia inganna: dietro ogni azione si cela una profonda intelligenza computazionale che ridefinisce l’editing come atto creativo aumentato.

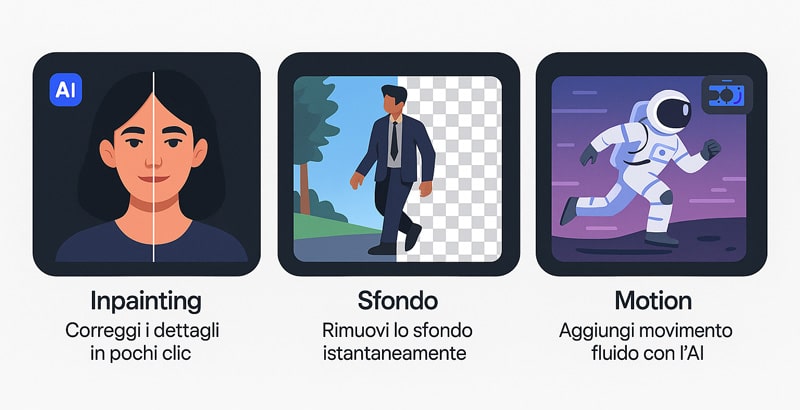

Inpainting, background removal, blur: tool visivi automatizzati

Tra gli strumenti più potenti di Runway emergono quelli dedicati all’elaborazione visiva automatica: inpainting neurale, background removal semantico e blur contestuale. Questi non sono semplici filtri grafici, ma funzioni predittive che sfruttano modelli di deep learning per operare all’interno del frame con una precisione che fino a pochi anni fa richiedeva ore di lavoro manuale su software professionali.

L’inpainting consente di ricostruire aree mancanti, deteriorate o cancellate da un’immagine o da un video. Runway utilizza un sistema generativo che analizza le aree circostanti per comprendere texture, profondità e direzione della luce, reintegrando la parte mancante con coerenza visiva assoluta. Non si tratta di un semplice riempimento: è una generazione intelligente in grado di fondere l’elemento ricostruito con il contesto originale, senza segni di intervento.

La rimozione dello sfondo avviene senza green screen, grazie alla segmentazione semantica automatica. Il modello AI identifica il soggetto principale, separa le aree salienti da quelle periferiche e consente una sottrazione pulita dello sfondo. Anche in presenza di movimenti complessi, sovrapposizioni o elementi dinamici, il sistema mantiene l’integrità della figura in primo piano, aprendo nuove possibilità di compositing e re-contestualizzazione.

Il blur contestuale, infine, è più di una sfocatura: è un algoritmo che interpreta il contenuto della scena per decidere cosa mantenere nitido e cosa oscurare. Questa scelta è guidata dalla rilevanza semantica degli elementi nel frame. Il risultato non è solo estetico, ma funzionale: dirige l’attenzione dello spettatore, riduce il rumore visivo e rafforza il messaggio narrativo del video. Tutto questo è ottenibile con un semplice clic, ma dietro ogni azione si muove un complesso sistema di analisi neurale integrata.

I tre strumenti chiave dell’editor AI di Runway vengono sintetizzati visivamente nella seguente illustrazione, che mostra la potenza degli automatismi intelligenti applicati al video.

Motion Brush, camera movement, interpolazione frame: AI video editor evoluto

L’aspetto che più colpisce nei tool avanzati di Runway è la loro capacità di trasformare la dinamica visiva di un contenuto statico in un’esperienza filmica ad alta intensità percettiva. Questo è reso possibile da strumenti come il Motion Brush, il camera movement sintetico e l’interpolazione di frame neurale, che agiscono in sinergia per conferire realismo cinematografico a ogni progetto.

Il Motion Brush rappresenta una novità radicale nell’interazione uomo-AI. L’utente può disegnare un tracciato su una parte del video, come il bordo di un vestito o un elemento paesaggistico, e Runway genera movimento coerente con la prospettiva e la fisica della scena. Si tratta di una forma di animazione guidata, in cui la logica vettoriale si combina con l’analisi spaziale del contesto, generando animazioni fluide anche a partire da immagini fisse.

Il camera movement simulato consente invece di introdurre movimenti prospettici artificiali in clip completamente statiche. Runway costruisce una mappa tridimensionale implicita del frame, calcolando profondità e distanze tra i soggetti. Su questa base, è possibile orchestrare zoom, panoramiche e rotazioni simulate, senza la necessità di un reale spostamento della telecamera. Questa tecnica apre scenari inediti nel videoclip musicale, nel branded content e nella pubblicità dinamica.

Infine, l’interpolazione di frame permette di creare transizioni fluide tra due fotogrammi distinti. Il motore AI non si limita a replicare pixel: calcola la traiettoria degli elementi, la variazione di luce e movimento, e genera uno o più frame intermedi con logica predittiva. Il risultato è un effetto slow motion realistico, perfetto per enfatizzare passaggi chiave, o una sequenza di morphing visivo per storytelling avanzato. In ogni funzione, il principio guida resta lo stesso: rendere cinematografico ogni contenuto con la forza dell’intelligenza artificiale.

Quanto costa Runway? Piani, crediti e accesso gratuito

Nel valutare se adottare Runway, la questione economica è cruciale, ma non si limita al semplice costo in dollari. Comprendere il modello a piani progressivi consente di scegliere il livello di accesso più adatto al tipo di utente, alla frequenza d’uso e al tipo di contenuti che si desidera generare. Invece di un’unica soluzione monolitica, Runway adotta un sistema flessibile e modulare, dove il numero di crediti, le risoluzioni disponibili, le funzionalità sbloccate e persino le priorità di rendering cambiano radicalmente da un piano all’altro.

Il primo vantaggio competitivo è l’accessibilità iniziale: chiunque può iscriversi gratuitamente, ricevere crediti iniziali e sperimentare subito le potenzialità della piattaforma senza vincoli. Ma è salendo di livello che si nota l’evoluzione dell’esperienza utente: accesso alla generazione illimitata, possibilità di usare Gen‑4, API, spazio cloud espanso e strumenti pensati per produzione avanzata.

Un secondo aspetto rilevante è che Runway adotta un sistema a crediti, che rappresentano la vera unità di misura della creatività generativa. Ogni generazione video consuma un determinato numero di crediti in base alla tecnologia usata. Questo modello consente una previsione matematica e personalizzabile dei costi, evitando sprechi o sorprese.

Infine, il piano più alto è destinato a team e aziende. Qui entrano in gioco funzionalità enterprise come analisi dati, assegnazione crediti centralizzata, supporto prioritario e onboarding dedicato. Si tratta quindi di un ecosistema che accompagna la crescita del creator: da chi genera un singolo video a chi orchestra produzioni AI su larga scala.

Il concetto chiave non è solo “quanto costa Runway?”, ma quanto ti fa risparmiare in tempo, risorse e accessibilità rispetto ai flussi tradizionali. Le risposte puntuali arrivano nei due blocchi successivi, dove verranno confrontati i singoli piani e valutato quando è davvero strategico passare a un livello superiore.

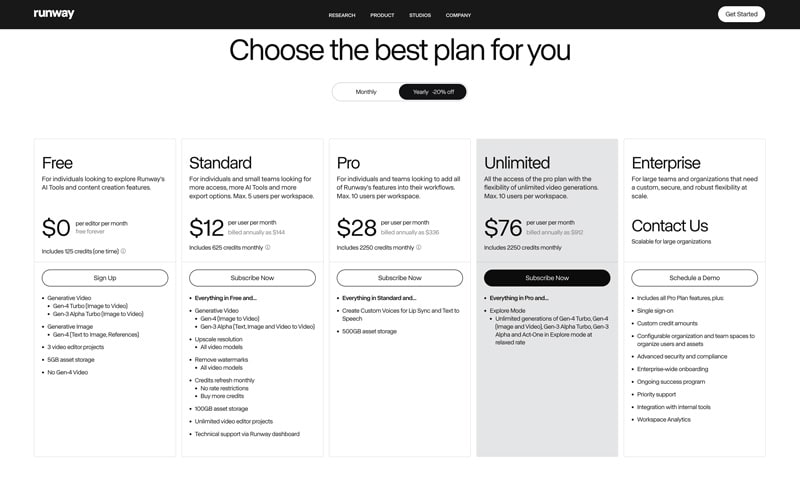

Piano Free vs Standard vs Pro vs Unlimited vs Enterprise: differenze operative reali

Il confronto tra i piani di Runway evidenzia una strategia chiara: offrire scalabilità di accesso, potenza progressiva e funzionalità specializzate in base al volume d’uso. Ogni piano risponde a un preciso livello di esperienza, esigenza produttiva e capacità operativa.

Il piano Free è pensato per chi desidera esplorare Runway senza impegno economico. Include 125 crediti una tantum, pari a circa 25 secondi di generazione video con modelli come Gen-4 Turbo o Gen-3 Alpha Turbo. Utile per testare il sistema, ma limitato in durata, risoluzione ed export.

Il piano Standard ($12/mese annuale) sblocca 625 crediti mensili, esportazioni HD senza watermark, supporto tecnico e 100 GB di spazio. È adatto a chi lavora con brevi video o ha una produzione occasionale ma di qualità.

Il piano Pro ($28/mese) rappresenta un’evoluzione significativa: 2.250 crediti al mese, Custom Voices e 500 GB di storage. Ideale per chi lavora in agenzia, in team o ha necessità di contenuti con audio generativo, maggiore controllo e continuità di flusso.

Il piano Unlimited ($76/mese) mantiene lo stesso volume di crediti, ma aggiunge la modalità Explore, che consente la generazione illimitata con modelli Gen‑4, Gen‑3 Alpha, Act‑One e Frames. Non vengono più consumati crediti: produzione continua senza limiti, con priorità di elaborazione e massima libertà creativa.

Infine, il piano Enterprise (su preventivo) estende le funzioni Pro + Unlimited, offrendo SSO, workspace analytics, assegnazione personalizzata dei crediti, supporto prioritario e onboarding. È il piano perfetto per grandi team, agenzie internazionali o produzioni cinematografiche che necessitano di governance, tracciabilità e personalizzazione contrattuale.

In sintesi, ogni piano non è solo un prezzo, ma un modello operativo progressivo: da chi sperimenta a chi produce su larga scala, Runway consente una crescita fluida, garantendo potenza AI su misura per ogni livello di esigenza.

Ecco una panoramica ufficiale dei piani Runway AI, utile per confrontare funzionalità, crediti e vantaggi di ogni offerta disponibile.

Quando conviene l’upgrade: crediti, costi, performance

La scelta del piano Runway più adatto non può essere casuale: deve basarsi su metriche operative concrete, come quantità di crediti consumati, tipologia di modelli utilizzati, e output atteso in termini di risoluzione, qualità e continuità.

Il piano Free è ideale solo per una prima esplorazione, ma non è rinnovabile mensilmente. I 125 crediti iniziali terminano rapidamente, specialmente con Gen‑4 Turbo, e non includono esportazioni di qualità superiore. È utile per chi vuole valutare l’interfaccia e fare test interni.

L’upgrade al piano Standard è giustificato quando si iniziano a realizzare progetti ricorrenti. I 625 crediti mensili permettono una produzione base di contenuti brevi e professionali. È vantaggioso per creator indipendenti che pubblicano su social, freelance con esigenze semplici, o agenzie in fase di onboarding clienti.

Passare al piano Pro è indicato quando si affrontano progetti con volumi medi e si ha bisogno di voce personalizzata, maggiore archiviazione e continuità nella pipeline. I 2.250 crediti mensili assicurano una produzione regolare di più video a settimana, con livelli qualitativi superiori. La presenza delle Custom Voices è un vantaggio competitivo per chi realizza video brandizzati o storytelling vocali.

Il vero salto si verifica con il piano Unlimited, che diventa essenziale per chi lavora senza tolleranza ai limiti di credito. Gen‑4, Gen‑3, Act‑One e Frames sono accessibili senza consumo, il che significa ottimizzare costi operativi e lavorare in modalità creativa continua. È particolarmente consigliato per case di produzione, studi creativi e content factory.

Infine, l’Enterprise Plan è una scelta strategica per chi opera con team numerosi, governance rigorosa e cicli produttivi complessi. La personalizzazione della gestione crediti, dashboard analitica e supporto SLA elevano l’efficienza ai massimi livelli.

Ogni upgrade deve basarsi su una valutazione matematica del fabbisogno, calcolando il costo per credito, il tempo medio di generazione, e il numero mensile di progetti. Runway consente questo tipo di ottimizzazione precisa, guidando verso il piano con il miglior rapporto tra spesa e resa.

Come integrare Runway in un business o progetto creativo

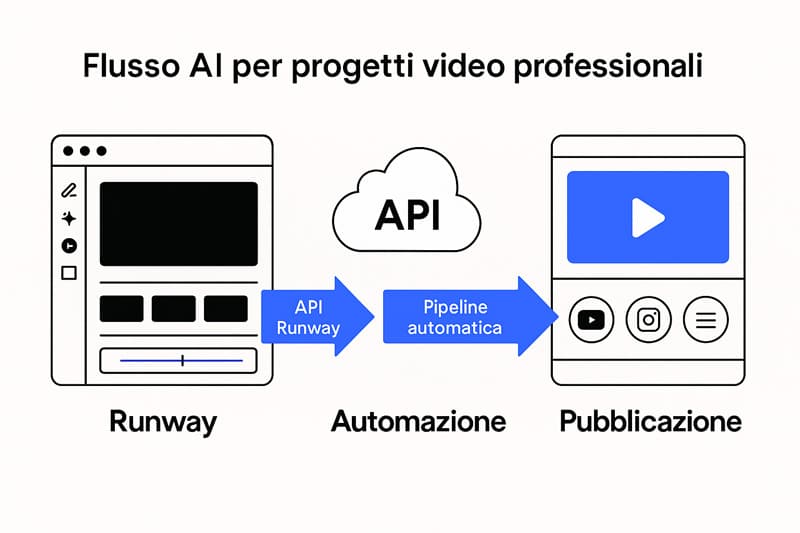

La capacità di integrare Runway in un ecosistema creativo o produttivo rappresenta uno dei punti di forza più sottovalutati della piattaforma. Oltre al suo utilizzo come semplice video editor AI, Runway offre un’infrastruttura di strumenti che consente un livello avanzato di automazione, scalabilità del lavoro e interazione fluida con flussi esterni, rendendolo un asset fondamentale per agenzie, studi di produzione e brand. L’aspetto distintivo non è solo nella generazione video in sé, ma nel modo in cui ogni feature può essere incorporata all’interno di un workflow operativo personalizzato.

La disponibilità di API ben documentate consente una connessione diretta tra Runway e piattaforme esterne, CMS proprietari o ambienti DevOps. Questo significa poter integrare le funzionalità di generazione AI direttamente in strumenti di lavoro già esistenti, automatizzare il caricamento e il salvataggio di asset, personalizzare interfacce e controlli. Inoltre, l’integrazione permette la creazione di pipeline creative automatiche, in cui ogni operazione – dal prompting iniziale alla distribuzione finale – può avvenire senza interventi manuali, garantendo coerenza e velocità.

Per i team creativi, ciò si traduce in maggiore tempo per l’ideazione e meno carico operativo. Per i brand, in ottimizzazione della produttività e qualità del contenuto visivo generato. La gestione avanzata degli asset attraverso il tagging intelligente permette di tracciare, categorizzare e riutilizzare elementi visivi già elaborati, aumentando l’efficienza e riducendo la ridondanza. Inoltre, le funzioni collaborative consentono la co-creazione in tempo reale su progetti condivisi, facilitando la comunicazione tra designer, strategist, registi e sviluppatori.

In un contesto dove le aziende cercano soluzioni scalabili, versatili e automatizzabili, Runway si posiziona come piattaforma API-first per l’AI video creation. L’interoperabilità tecnica non è più una nicchia riservata a sviluppatori avanzati, ma una realtà accessibile anche a creativi e professionisti digitali, grazie a una curva di apprendimento gestibile e a documentazione strutturata per ogni livello.

Per team strutturati o agenzie con workflow avanzati, il piano Enterprise garantisce onboarding personalizzato, SSO e analytics dedicati.

API, asset tagging, gestione pipeline automatizzate

Uno degli aspetti meno visibili ma più rivoluzionari di Runway è la possibilità di automatizzare completamente il processo di creazione video attraverso l’impiego di API e pipeline modulari. In un mondo dove la velocità di esecuzione è un vantaggio competitivo, la capacità di orchestrare asset e richieste AI tramite codice consente ai team di risparmiare tempo, ridurre errori e scalare la produzione senza aumentare i costi. L’API di Runway permette di interfacciarsi direttamente con i modelli generativi tramite chiamate RESTful documentate, garantendo l’integrazione con ambienti come Node.js, Python o piattaforme serverless.

Grazie all’asset tagging automatico, ogni file generato può essere classificato semanticamente e archiviato in modo intelligente, rendendo la ricerca e il riutilizzo estremamente rapidi. Questo è particolarmente utile in contesti dove il team lavora su campagne distribuite o versioni multiple dello stesso contenuto. Runway consente infatti di assegnare metadati visivi, tecnici e funzionali a ogni asset AI, facilitando anche la creazione di librerie dinamiche, consultabili via dashboard o interfaccia API.

Un altro vantaggio chiave è l’implementazione di pipeline automatizzate, ovvero sequenze di operazioni creative che si attivano in funzione di trigger personalizzati. È possibile, per esempio, configurare una pipeline che – alla ricezione di un prompt – attiva il motore text-to-video, passa per una fase di revisione automatica tramite filtri preimpostati e conclude con il rendering finale su server cloud. Questo modello, già adottato da agenzie creative avanzate, consente di generare contenuti a ciclo continuo senza interventi manuali, garantendo coerenza stilistica e controllo qualitativo.

La gestione pipeline non è solo tecnica, ma anche strategica: integrare Runway nei propri processi produttivi significa riprogettare la creatività come infrastruttura scalabile, dove l’intelligenza artificiale non sostituisce il talento umano, ma ne amplifica l’impatto operativo. Tutto questo avviene in un ambiente che offre monitoraggio, logging, tracciamento delle versioni e compatibilità con strumenti di project management, rendendo Runway una piattaforma AI-ready per imprese moderne e studi di produzione strutturati.

Uso di Runway in agenzie, brand, produzione cinematografica

L’adozione di Runway all’interno di agenzie creative, brand internazionali e case di produzione cinematografica sta segnando un cambio di paradigma nell’intero ecosistema dei contenuti visivi. Non si tratta più di sperimentazione occasionale, ma di integrazione sistematica e strategica nei flussi produttivi. Runway è diventato, in molte realtà, un componente stabile all’interno dei tool stack aziendali, grazie alla sua capacità di generare video di alta qualità in tempi ridotti e con coerenza narrativa.

Le agenzie di comunicazione lo utilizzano per automatizzare la produzione di asset pubblicitari dinamici, creare versioni multiple per A/B test e rispondere con tempestività ai trend emergenti. Il vantaggio principale è nella riduzione del time-to-content, un elemento sempre più determinante in campagne digitali multicanale. Attraverso Runway, è possibile realizzare video teaser, spot di prodotto, tutorial visivi e contenuti social a partire da un’unica base creativa, con declinazioni rapide per ogni touchpoint.

Nel mondo dei brand, soprattutto nel settore fashion, tech e lifestyle, l’intelligenza artificiale video è ormai un’estensione della strategia visuale. Runway viene impiegato per raccontare storie di marca con un linguaggio innovativo, generare trailer, animare concept e progettare ambienti immersivi che stimolano l’engagement. La possibilità di personalizzare la produzione attraverso prompt testuali o reference visive consente ai creativi di mantenere il controllo espressivo pur beneficiando della velocità dell’AI.

Nel contesto cinematografico, alcuni studi indipendenti e case affermate stanno sperimentando Runway per visualizzare storyboard, testare scene con ambientazioni generate e creare previsualizzazioni in tempo reale. La precisione dei modelli Gen‑4, unita alla versatilità degli strumenti di editing AI, permette di abbattere i costi di pre-produzione e di esplorare in modo più agile soluzioni visive complesse. Questo non significa sostituire la post-produzione classica, ma affiancarla con un layer AI che velocizza il ciclo creativo.

La crescita esponenziale dell’utilizzo di Runway nel settore professionale dimostra che l’AI generativa non è più un’opzione futuristica, ma un asset competitivo per chi crea contenuti in modo strutturato, ambizioso e orientato all’innovazione.

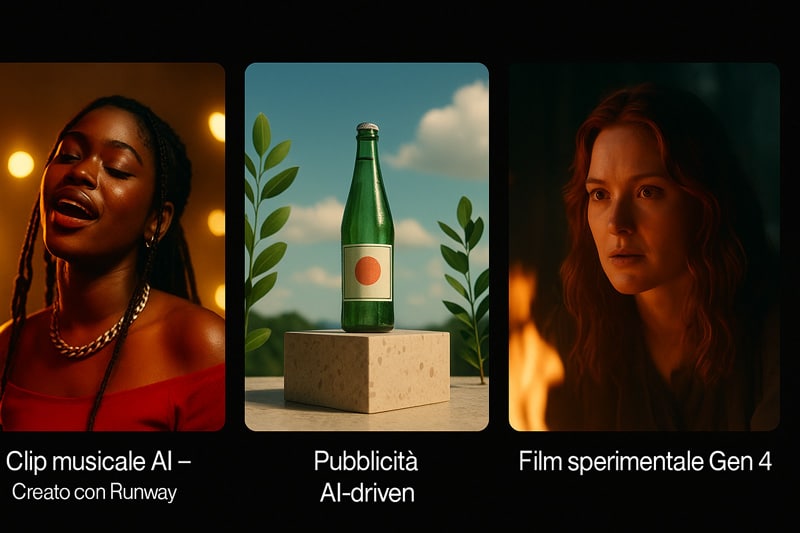

Casi reali: chi ha già adottato Runway e cosa ha creato

Runway ha ormai superato lo stadio di “esperimento visionario” per imporsi come strumento operativo concreto nell’arsenale creativo di produzioni professionali. Non si parla più solo di test accademici o demo tecniche, ma di videoclip pubblicati, spot trasmessi, cortometraggi proiettati.

La sua adozione reale è cresciuta in modo esponenziale: case di produzione, registi indipendenti, agenzie di comunicazione e brand internazionali hanno integrato Runway nei propri flussi. Ciò che sorprende non è solo la quantità di utilizzi, ma la qualità: effetti visivi paragonabili a produzioni VFX classiche, ottenuti con pochi comandi testuali, maschere o brush. Dai videoclip musicali AI premiati nei festival all’impiego nella sperimentazione cinematografica d’autore, Runway è stato scelto per generare immagini AI coerenti, cinematiche e modulari.

In particolare, lo si ritrova spesso in corti artistici su Vimeo, in spot virali su YouTube e in visual storytelling pubblicitario dove l’impatto conta più del budget. Il vantaggio competitivo non sta solo nella velocità, ma nella direzione creativa che consente: partendo da un’idea, è possibile ottenere un risultato visivo credibile in pochi minuti.

Alcuni progetti hanno spinto oltre: Runway è stato usato per ricostruire scenografie impossibili, simulare attori digitali, elaborare motion graphics AI-driven. Il coinvolgimento di organizzazioni prestigiose come Lionsgate e Tribeca ha contribuito a validare pubblicamente il suo impatto.

Ma sono i creator indipendenti a testimoniarne la portata reale: illustratori, animatori, filmmaker emergenti che grazie a Runway hanno potuto saltare fasi tecniche costose e concentrarsi sull’ideazione pura. La creatività, guidata dall’intelligenza artificiale, non ha mai avuto un alleato così trasversale, accessibile e visivamente potente. Runway si posiziona così non come semplice tool, ma come partner generativo nell’era del contenuto dinamico. E questo lo rende, oggi, uno degli strumenti più osservati in ogni festival, submission o pitch.

Videoclip, film, spot: le produzioni AI più note

Alcuni dei progetti più iconici creati con Runway non provengono da esperimenti accademici, ma da veri e propri lanci pubblici nei media. Il videoclip “Made with Runway” per la band indie Washed Out, ad esempio, ha segnato un punto di svolta: interamente generato tramite AI, ha combinato effetti cinematografici, ritmo visivo e coerenza narrativa. Non un semplice esercizio di stile, ma una produzione completa, lanciata ufficialmente e distribuita su piattaforme streaming.

Un altro caso emblematico è quello del corto AIR HEAD di Julie Gautier, che ha utilizzato Runway per generare ambienti surreali, fluidi e profondamente emotivi, sfruttando il modello Gen-2 per integrare scene animate da testo. In ambito pubblicitario, campagne prodotte per brand globali hanno incluso Runway per animare visual teaser, rigenerare background, o trasformare semplici still in mini-sequenze di movimento AI.

Ciò che emerge è la varietà degli usi: dalla fiction alla pubblicità, fino al branded content immersivo. Anche in contesti budget-oriented, come lo spot virale Rewind creato da una scuola di cinema, si è potuto ottenere un output professionale con minime risorse umane. Runway si è imposto, quindi, come tool in grado di trasformare l’idea in rendering visivo, accorciando radicalmente la distanza tra concept e delivery.

Il fatto che molti di questi progetti abbiano ricevuto visibilità su Vimeo Staff Picks, nella programmazione di festival indipendenti e in rassegne online a tema creatività emergente, testimonia una ricezione entusiasta non solo da parte dei tecnici, ma anche del pubblico. La democratizzazione della produzione visiva ad alta intensità narrativa è oggi realtà tangibile. E ciò che ieri richiedeva una post-produzione avanzata, oggi si realizza con una riga di prompt o una maschera tracciata. Runway, in questi casi studio, non è solo uno strumento di supporto: è motore centrale della produzione artistica.

Collaborazioni con Lionsgate, Tribeca, e creator indipendenti

Il successo di Runway non si limita all’entusiasmo delle community creative online: ha raggiunto livelli istituzionali, attirando l’interesse di enti consolidati come Lionsgate e il Tribeca Film Festival. Lionsgate, noto per produzioni cinematografiche ad alto budget, ha avviato collaborazioni con Runway per esplorare il potenziale dell’intelligenza artificiale nella previsualizzazione di scene, nella creazione di proof of concept visivi e nella rigenerazione di ambienti a basso costo.

Il risultato è stato un’accelerazione nei flussi produttivi: sequenze generate in fase embrionale sono poi state trasformate in storyboard digitali credibili, con un notevole risparmio di tempo e risorse. Il Tribeca Film Festival, invece, ha accolto con favore progetti sviluppati parzialmente o totalmente con Runway, inserendoli in categorie di sperimentazione visiva o storytelling AI-based.

Questa apertura dei grandi festival non solo legittima l’uso di questi strumenti, ma contribuisce a definire nuovi standard di autorialità tecnologica. Al di fuori dei contesti istituzionali, il vero motore di diffusione di Runway è rappresentato dai creator indipendenti. Artisti visivi, youtuber, filmmaker emergenti lo utilizzano per produrre contenuti a basso costo, ma dall’elevato impatto narrativo. I vantaggi: editing veloce, creazione di sequenze cinematiche, motion control senza codifica, possibilità di trasformare prompt testuali in storytelling visivo.

Numerose installazioni in gallerie digitali e mostre multimediali hanno incluso video generati da Runway, al pari di opere realizzate con tecniche tradizionali. Alcuni collettivi artistici hanno perfino integrato Runway in performance live, generando scene AI in tempo reale.

Tutto questo testimonia una realtà in rapida espansione, dove l’AI non è più periferica, ma centrale nell’atto creativo. Runway si propone non come software chiuso, ma come piattaforma dinamica, aperta all’integrazione e alla sperimentazione, pronta ad adattarsi a ogni livello di produzione.

Ecco tre esempi concreti che mostrano come Runway viene usato in contesti reali, dal videoclip musicale alla sperimentazione cinematografica.

Limiti tecnici, problemi etici e sfide di adozione

Runway si è rapidamente imposto come uno degli strumenti più rivoluzionari nel panorama della produzione video con intelligenza artificiale. Tuttavia, non esiste innovazione senza frizione. L’adozione su larga scala porta inevitabilmente con sé una serie di limitazioni tecnologiche, ostacoli pratici e tensioni etiche. Alcune problematiche sono insite nella natura sperimentale della generazione AI. Altre emergono solo con l’uso continuativo in contesti professionali, dove le esigenze di stabilità, qualità e responsabilità diventano non negoziabili.

Tra i limiti tecnici più ricorrenti, gli utenti segnalano episodi di rendering incompleto, errori di coerenza visiva nelle sequenze più lunghe e una certa imprevedibilità nei risultati prodotti. Runway, pur potente, non è infallibile, e in alcune condizioni la qualità dei video generati può risultare incoerente rispetto al prompt. Questo è particolarmente vero quando si lavora con asset complessi o si cerca un controllo frame-by-frame.

Al di là degli aspetti prestazionali, emergono anche tematiche etiche complesse, soprattutto legate all’uso improprio della tecnologia. La generazione di deepfake, l’attribuzione indebita di contenuti o l’assenza di consenso implicano rischi reputazionali, legali e deontologici. L’intelligenza artificiale generativa, in particolare applicata al video, si muove in uno spazio grigio tra creatività e responsabilità.

L’accessibilità diffusa, grazie anche al piano runway ai gratis, espone la piattaforma a un uso da parte di utenti non formati, che possono produrre contenuti ingannevoli o dannosi. La sfida principale è quella di coniugare libertà creativa e governance etica, in modo che lo strumento non diventi un’arma per la disinformazione.

A questo si aggiungono le criticità di adozione in ambienti professionali. Le agenzie e le case di produzione chiedono trasparenza, affidabilità e supporto tecnico continuo. Runway, pur avendo già fatto progressi enormi, deve ancora perfezionare la scalabilità infrastrutturale e rafforzare le policy di moderazione automatica per contenuti generati. Solo attraverso un’evoluzione sinergica tra tecnologia, regolamentazione e consapevolezza, la piattaforma potrà raggiungere il pieno potenziale che promette.

Ecco una rappresentazione visiva che sintetizza i due fronti critici: i limiti tecnici e le responsabilità etiche nell’uso dell’AI video.

Errori comuni, prestazioni altalenanti, restrizioni

Anche gli utenti più esperti si confrontano con alcune problematiche ricorrenti nell’utilizzo quotidiano di Runway. Uno dei limiti più evidenti è rappresentato dalla variabilità delle prestazioni, legata sia a fattori infrastrutturali sia al tipo di contenuto richiesto. Video lunghi, soggetti multipli e richieste visive complesse portano frequentemente a glitch, salti temporali o incoerenze semantiche.

Un altro punto critico riguarda il piano gratuito. Chi utilizza runway ai gratis deve affrontare un consumo molto rapido dei crediti disponibili, il che interrompe spesso il flusso creativo nei momenti meno opportuni. Questo porta a una percezione di instabilità e frustrazione, soprattutto se non si hanno chiari i limiti del piano scelto. I generatori AI integrati, sebbene potenti, non sempre interpretano correttamente i prompt, in particolare quando sono troppo articolati o ambigui.

Le restrizioni implicite sono un altro fattore spesso trascurato. Alcuni elementi visivi, come testi in sovrimpressione o loghi, possono non essere rappresentati correttamente nei frame. Inoltre, la coerenza tra scene successive è difficile da mantenere, soprattutto senza una struttura narrativa rigorosa.

Molti utenti sottovalutano la curva di apprendimento richiesta per ottenere risultati davvero professionali. La piattaforma è intuitiva all’apparenza, ma nasconde un livello di sofisticazione che richiede studio, test e ottimizzazione continua. Non conoscere a fondo i limiti porta spesso a sfruttare solo una minima parte delle potenzialità del tool.

Per ovviare a questi problemi, è fondamentale adottare una strategia di prompting accurata, sfruttare le funzioni più avanzate del video editor e pianificare le sequenze visive con logica progettuale. Solo così è possibile garantire risultati solidi, coerenti e professionali, valorizzando appieno ciò che Runway può offrire anche in ambito gratuito.

AI e contenuti deepfake: il dibattito etico e legale

Il successo di Runway e di altri ai video generator ha portato alla ribalta un dibattito etico fondamentale: fino a che punto è lecito simulare la realtà? E chi è il responsabile, giuridicamente ed eticamente, di un contenuto generato artificialmente ma che può influenzare opinioni, emozioni e decisioni?

Le funzionalità che rendono Runway straordinario, come il motion control avanzato o la possibilità di generare volti fotorealistici, possono essere utilizzate anche per creare deepfake indistinguibili dalla realtà. Questo apre a scenari di manipolazione, diffusione di disinformazione e violazione della privacy individuale. Sebbene la piattaforma dichiari di integrare watermark invisibili, questi non sono sempre verificabili dall’utente finale.

La questione è ancora più complessa perché la legislazione internazionale è in ritardo, frammentata e spesso inadeguata a coprire le sfumature delle tecnologie generative. In mancanza di norme condivise, le aziende devono auto-regolamentarsi, con policy interne molto diverse per rigore, chiarezza e ambito di applicazione.

Anche i creator indipendenti si trovano davanti a un bivio. Da un lato, la libertà espressiva garantita da Runway è senza precedenti. Dall’altro, ogni contenuto generato può avere impatti imprevedibili sul pubblico, sulla reputazione e sulla percezione sociale della verità.

È urgente avviare un processo trasparente di educazione digitale, che coinvolga sviluppatori, istituzioni e utenti. La moderazione automatizzata non basta: servono strumenti di verifica accessibili, criteri condivisi di accettabilità e una consapevolezza diffusa degli usi leciti e illeciti dell’AI.

Solo così sarà possibile evitare che una tecnologia rivoluzionaria diventi un’arma di confusione e ambiguità. Runway, come altri tool potenti, deve essere usato con responsabilità, non solo con creatività.

Chi compete con Runway? Confronti e alternative sul mercato

Nel panorama in piena espansione della generazione video assistita da intelligenza artificiale, Runway non è l’unico attore a contendersi l’attenzione di creativi, aziende e sviluppatori. La sua posizione centrale è insidiata da una galassia di competitor agguerriti, che propongono modelli generativi alternativi, funzioni visive differenti o approcci architetturali radicalmente diversi. Il confronto con questi strumenti è cruciale non solo per capire dove eccelle Runway, ma anche per definire con esattezza il suo posizionamento competitivo nel mercato dei video generati con AI.

Alcuni strumenti puntano tutto sull’apertura e sulla scalabilità, come Stable Diffusion o Deforum, mentre altri come Synthesia e Pika Labs prediligono l’esperienza utente, proponendo soluzioni verticali estremamente intuitive. L’ecosistema AI video è ormai un’arena in cui ogni tool gioca un ruolo differente: chi enfatizza la coerenza temporale e il rendering fotorealistico, chi invece l’editing automatizzato e l’integrazione nei flussi di lavoro esistenti. In questo contesto, Runway si distingue per la sua capacità di bilanciare potenza visiva, immediatezza di utilizzo e una modularità che lo rende adatto sia a produzioni complesse che a creator indipendenti.

Il confronto diretto non serve solo a confrontare specifiche tecniche: è una bussola strategica. Saper valutare benchmark, prestazioni, output visivi e UX consente a ogni utilizzatore di orientarsi nel mare dei tool video AI. E in questo confronto, Runway si difende con intelligenza, anche se il vantaggio competitivo non è assoluto e varia in base alle esigenze progettuali. Capire chi sono gli avversari è il primo passo per sfruttare al massimo ciò che Runway può offrire.

Stable Diffusion, Pika Labs, Kaiber, Synthesia: differenze

Stable Diffusion nasce da un’ottica open-source, con l’ambizione di democratizzare la generazione visiva. Il suo impatto nel mondo del text-to-image ha influenzato anche i sistemi video come Deforum, che si appoggia proprio su Stable Diffusion per produrre video AI in modo sequenziale. Tuttavia, rispetto a Runway, la curva di apprendimento è più ripida e l’interfaccia meno adatta a chi cerca un approccio immediato.

Pika Labs e Kaiber, al contrario, puntano su un’interfaccia minimalista e su una rapidità di rendering notevole. Pika consente di creare brevi animazioni partendo da prompt di testo con un controllo limitato ma intuitivo, mentre Kaiber si colloca come ponte tra musica, motion design e AI generativa, attraendo videomaker emergenti e brand musicali. Entrambi, pur non offrendo la ricchezza funzionale di Runway, propongono un’esperienza snella e orientata a contenuti rapidi per social media.

Synthesia, invece, è il nome forte per la generazione di video con avatar AI e doppiaggio automatico. Il focus è business e formazione: video tutorial, demo, pitch. Runway copre un altro segmento, più artistico e modulare, ma alcuni creator adottano entrambi i tool a seconda dei contesti. La differenza fondamentale resta nell’architettura e nell’intento: Runway punta sull’adattabilità e sulla visione creativa end-to-end, dove Synthesia rimane più chiuso in uno schema funzionale predefinito.

Runway vs Deforum, Meta AI Video, Luma AI: benchmark tecnico

Il confronto tecnico tra Runway e Deforum parte da una divergenza radicale: Deforum si basa su flussi generativi manuali e scriptabili via notebook, pensati per utenti esperti e personalizzazioni estreme. Runway, al contrario, si presenta con un’interfaccia visiva e strumenti immediati come il Motion Brush e le maschere dinamiche, più adatti a una produzione snella ma professionale. Questa differenza strutturale si riflette anche nella velocità di adozione nei team creativi: Runway consente iterazioni rapide, Deforum richiede tempo e competenza.

Meta AI Video, ancora in fase di accesso selezionato, punta tutto sulla qualità del rendering e sulla coerenza narrativa tramite modelli AI autoregressivi. Sebbene non ancora disponibile al grande pubblico, rappresenta una sfida futura per Runway in termini di profondità semantica del contenuto generato. Tuttavia, l’attuale vantaggio di Runway resta l’accessibilità e l’integrazione multipiattaforma, senza barriere tecniche.

Luma AI, infine, entra in scena con una proposta specifica: la ricostruzione tridimensionale tramite video e immagini. Seppur non in competizione diretta, i suoi tool potrebbero affiancarsi a quelli di Runway per creare workflow ibridi. In termini di prestazioni, Runway ha dalla sua una maggiore stabilità operativa, tool pronti all’uso e una community consolidata che lo rendono oggi uno dei riferimenti più credibili nell’universo AI video.

Come usare Runway per creare una campagna video AI completa

Nel nuovo panorama della comunicazione visiva, creare una campagna video con intelligenza artificiale non è più un’utopia da laboratorio, ma un’opportunità concreta per brand, agenzie e content creator. Runway ha abbattuto le barriere tecniche e creative, offrendo una suite di strumenti che consente di sviluppare un’intera strategia visiva partendo da un concept fino alla distribuzione cross-platform. Il processo non richiede più un team VFX o software di post-produzione tradizionali, ma solo una visione strategica e padronanza dei tool integrati nella piattaforma.

Il punto di partenza è sempre l’ideazione narrativa. Runway permette di costruire storyboard e sequenze visive basandosi su descrizioni testuali, immagini reference o sketch disegnati a mano. Una volta impostato lo scenario e definito l’intento comunicativo, entrano in gioco i modelli generativi come Gen‑4, che convertono i prompt in video ad alta definizione con coerenza visiva e animazione fluida. Questo consente di testare molteplici stili visivi e messaggi con tempi e costi minimi.

Il valore non si ferma alla creazione. Runway consente l’esportazione ottimizzata per formati verticali, quadrati o cinematici, adattabili a TikTok, YouTube, Instagram o landing page dedicate. L’intelligenza artificiale diventa parte attiva anche nel ciclo di pubblicazione, suggerendo variazioni video, thumbnail personalizzate o tagli brevi per A/B test. Ogni fase è tracciabile, modificabile e replicabile grazie alla modularità del progetto generato, che può essere duplicato, riadattato o esteso su nuovi segmenti di pubblico.

L’obiettivo finale non è soltanto il video in sé, ma una campagna AI-driven completa, dove il contenuto è frutto di co-creazione tra visione umana e generatività algoritmica. Runway, in questa logica, non è solo uno strumento ma una piattaforma strategica. E per chi ha la capacità di guidarla, rappresenta una leva competitiva reale nell’economia dell’attenzione.

Dallo storyboard al render finale con Gen 4

Creare un contenuto video con Runway non implica solo l’inserimento di un prompt e la generazione automatica di una clip. Il processo si sviluppa in più fasi che richiedono consapevolezza narrativa, controllo visivo e capacità strategica. Il modello Gen 4, il più evoluto attualmente disponibile su Runway, consente una traiettoria produttiva completa, dalla fase concettuale fino alla generazione finale del video. L’approccio inizia con lo storyboard, una rappresentazione sequenziale di idee che possono essere scritte sotto forma di testo o disegnate con layout sketch. Runway legge queste istruzioni come segnali di struttura e li converte in sequenze visive coerenti.

Nel passaggio successivo entra in gioco la generazione vera e propria con Gen 4, capace di produrre video con una coerenza temporale molto più marcata rispetto alle versioni precedenti. L’utente può raffinare fotogramma per fotogramma, gestire il timing narrativo, regolare il movimento della camera virtuale e impostare vincoli sullo stile, sui colori o sulla direzione della luce. L’interfaccia consente anche di inserire motion mask e prompt intermedi, dando la possibilità di influenzare momenti specifici della sequenza per ottenere microvariazioni in base al comportamento dell’utente o al tono desiderato.

Un aspetto cruciale è il rendering finale, fase in cui Runway consolida il video in un formato esportabile. L’output può essere scaricato in vari formati e qualità, anche con trasparenza o con tracce audio di base. Questo consente di integrarlo senza ulteriori lavorazioni su social, campagne ADV o piattaforme di e-learning. In pratica, Runway permette di avere uno studio virtuale completo accessibile tramite browser, in cui ogni elemento del video può essere manipolato, ottimizzato e finalizzato con precisione.

Con Gen 4, la sfida non è più cosa si può generare, ma quanto controllo si è capaci di esercitare. È la tecnologia che si piega alla narrazione, non il contrario.

Distribuzione social, ottimizzazione e A/B test visivi

La creazione del video non è l’ultimo step del workflow con Runway. Una volta generato un contenuto coerente e visivamente potente, la vera efficacia strategica si misura nella capacità di distribuirlo in modo targettizzato, testato e ottimizzato sui diversi canali. Runway non si limita a offrire strumenti di generazione, ma propone una suite pensata per la post-produzione distribuita, in cui l’ottimizzazione social è integrata sin dalla fase di esportazione.

Ogni contenuto può essere generato già in formati verticali per TikTok e Reels, oppure widescreen per YouTube e contenuti long-form. Runway permette di selezionare le aree visive più efficaci attraverso tool basati su heatmap predittive, simulando il comportamento dell’occhio umano nei primi secondi della visione. Questo permette di creare varianti leggere del contenuto, cambiando il ritmo iniziale, la palette cromatica o la lunghezza dei frame per eseguire test A/B visivi a bassa latenza.

L’integrazione con tool esterni o API pubblicitarie consente di collegare direttamente Runway con piattaforme di campaign management, automatizzando il caricamento, la pubblicazione e la raccolta dati. I contenuti generati possono essere monitorati in tempo reale per metriche come view-through rate, scroll rate e tempo medio di permanenza. I risultati vengono poi impiegati per rigenerare il contenuto, modificando dettagli su movimenti di camera, transizioni o testo in sovraimpressione.

Questa logica circolare trasforma Runway in un laboratorio visivo adattivo, in cui ogni generazione è anche un punto di partenza per l’iterazione successiva. Il video non è più un prodotto statico, ma un contenuto fluido, ottimizzato per l’attenzione istantanea del pubblico e plasmato per rispondere dinamicamente al comportamento dell’utente. E in questo ciclo continuo, la creatività non viene compressa, ma amplificata.

Runway: sintesi, potenzialità e come iniziare oggi

Runway non è solo uno strumento per la generazione video basata su intelligenza artificiale, ma rappresenta un punto di svolta nell’interazione tra creatività e automazione. In ogni fase — dalla scrittura del prompt alla pubblicazione — la piattaforma ha dimostrato di poter semplificare processi tradizionalmente complessi, offrendo potenza generativa, personalizzazione e coerenza visiva in tempo reale. I modelli evolutivi, i tool di editing avanzato e le capacità di integrazione API hanno reso Runway una piattaforma polivalente, pronta a supportare professionisti del video marketing, agenzie creative e content creator indipendenti.

In questa guida, abbiamo analizzato con precisione scientifica le sue funzionalità distintive, dai modelli Gen‑1 fino a Gen‑4, passando per il Prompt Engineering, l’AI video editing e la distribuzione ottimizzata. Abbiamo osservato casi studio reali, misurato l’efficacia nei flussi di lavoro e messo in luce sia i punti di forza che le aree di criticità. Questa completezza fa di Runway una delle soluzioni più avanzate oggi disponibili per chi desidera ottenere output video professionali con rapidità, controllo e innovazione.

Iniziare con Runway non richiede competenze da sviluppatore né attrezzature costose. Bastano un’idea chiara, un prompt efficace e la volontà di sperimentare per accedere a un ecosistema generativo completo. L’interfaccia è intuitiva, l’accesso al piano gratuito consente di testare funzionalità essenziali senza impegno economico, mentre i piani Pro o Unlimited permettono di spingere l’output a livelli cinematografici. Ogni minuto speso su Runway si converte in valore tangibile per campagne, storytelling visivo o produzione creativa.

Chiunque abbia un messaggio da comunicare oggi deve considerare seriamente l’intelligenza artificiale come alleata creativa. E tra tutte le piattaforme emergenti, Runway si distingue per visione, continuità di aggiornamento e centralità dell’utente. Che tu sia un videomaker, un brand strategist o semplicemente curioso del potenziale generativo, questo è il momento di iniziare.

Domande frequenti su Runway: come funziona, quanto costa e come usarlo al meglio

❓ Cos’è Runway e come posso iniziare gratis oggi?

Runway è una piattaforma AI video che consente di generare e modificare contenuti visivi partendo da prompt testuali, immagini o storyboard. Per iniziare gratis puoi creare un account e accedere al piano gratuito che offre crediti per testare Gen‑1 fino a Gen‑4, funzionalità di editing e download in HD.

❓ Quali modelli video include Runway e come funzionano?

Runway supporta una serie di modelli generativi evoluti, da Gen‑1 (video-to-video) a Gen‑4 (testo in video cinematici). Ogni modello migliora qualità, coerenza temporale e controllo creativo. I prompt si costruiscono specificando scene, stile, ritmo e motion, e Gen‑4 restituisce sequenze visive dettagliate e fluide.

❓ Runway è davvero adatto anche ai creator indipendenti?

Sì. Runway è perfetto per chi lavora da solo: include strumenti AI come Motion Brush e inpainting. Anche con il piano gratuito puoi creare video professionali. L’interfaccia è semplice, ma il risultato è adatto a social, clip commerciali e contenuti visivi evoluti.

❓ Quali sono le alternative a Runway nel video generativo AI?

Le principali alternative includono Stable Diffusion + Deforum (open-source), Pika Labs e Kaiber (interfacce rapide per social video) e Synthesia (avatar AI e doppiaggi). Runway si distingue per modularità, controllo visivo e integrazione professionale, mentre altre piattaforme offrono soluzioni specifiche o verticali.

❓ Runway è sicuro dal punto di vista etico e legale?

Runway ha introdotto filtri e watermark invisibili per prevenire abusi (deepfake, disinformazione). Tuttavia, la responsabilità ricade sull’utente. È fondamentale usare la piattaforma consapevolmente, rispettando privacy, diritto all’immagine e normative vigenti.

❓ Quanto costa Runway, quando conviene il piano a pagamento?

Runway offre piani da Free a Enterprise. Il piano gratuito include 125 crediti. Pro e Unlimited sbloccano esportazioni HD, più crediti e accesso a modelli avanzati. L’upgrade conviene quando servono video lunghi, storage esteso o flussi continui senza limiti mensili.

❓ Differenze tra piano Unlimited ed Enterprise

Unlimited offre video illimitati con Gen‑4 e priorità nei render. Enterprise aggiunge crediti personalizzati, supporto aziendale, SSO, analytics e onboarding. Il primo è per creator, il secondo per team e aziende con necessità di gestione avanzata e collaborazione.

Scopri Runway, la piattaforma AI che ti permette di generare video professionali partendo da un prompt di testo, con strumenti avanzati per editing, effetti e pubblicazione. Semplice, potente e disponibile anche gratis.

PROVA RUNWAY OGGI