I bias e l’intelligenza artificiale non sono una possibilità teorica: sono una realtà concreta, integrata nei modelli che decidono chi ottiene un lavoro, quale malattia viene diagnosticata, o quale voce viene ascoltata. In ogni algoritmo, anche nel più sofisticato, esiste il rischio di replicare — o amplificare — pregiudizi che la società umana non ha ancora superato. Che cosa sono, allora, i bias nei sistemi AI? Sono distorsioni strutturali che emergono dai dati di addestramento, si consolidano negli algoritmi e si traducono in risultati che influenzano milioni di persone. Non si tratta di errori accidentali: sono schemi sistemici radicati nei dati e nei processi.

Capire il significato di bias significa andare oltre la superficie della parola. È osservare come, dietro un’apparente neutralità statistica, si annidino dinamiche di esclusione. Un modello può sembrare preciso, ma lo è per chi? E con quali conseguenze? È facile fidarsi dei numeri quando sembrano oggettivi. Ma è proprio questa l’illusione: la matematica dell’AI non è neutra, perché dipende dai dati che le forniamo e dalle scelte che facciamo nel costruirla. Non possiamo più limitarci a valutare le prestazioni di un algoritmo in termini di accuratezza generale: dobbiamo interrogarci sulla sua equità.

Parlare di bias e intelligenza artificiale significa parlare di potere, di accesso, di rappresentazione. Un sistema può escludere, anche senza volerlo, proprio coloro che ha il compito di servire. Se non progettiamo con consapevolezza, rischiamo di costruire tecnologie che rafforzano diseguaglianze anziché ridurle. Serve un cambio di paradigma, che metta al centro la responsabilità: progettisti, sviluppatori, aziende e cittadini devono riconoscere il proprio ruolo in questa dinamica. Il bias non è un bug da correggere una volta sola, ma un processo continuo da monitorare, affrontare e disinnescare.

Solo un’intelligenza artificiale consapevole della propria fallibilità può aspirare a diventare giusta. E giusta non significa perfetta, ma capace di apprendere da ciò che esclude. In questo risiede la sfida più grande e la possibilità più rivoluzionaria: costruire un’AI che non solo calcoli, ma che ascolti, che non solo predica, ma che corregga, che non solo funzioni, ma riconosca chi non sta funzionando per tutti.

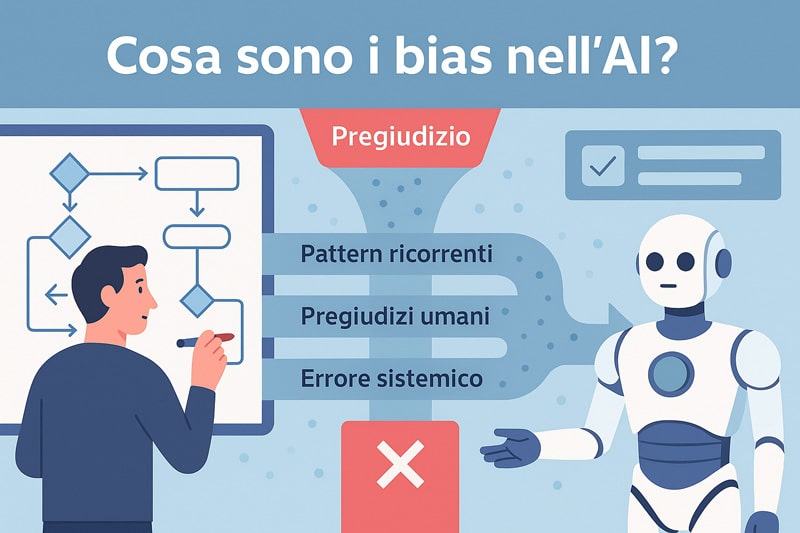

Cosa sono i bias e perché colpiscono l’intelligenza artificiale

Nel momento in cui affidiamo a un algoritmo la valutazione di un curriculum, la concessione di un prestito o la diagnosi di una malattia, entriamo in un territorio in cui l’apparente neutralità della macchina può nascondere schemi profondamente iniqui. I bias e l’intelligenza artificiale non sono incidenti isolati: sono effetti sistemici che nascono da dati incompleti, criteri non rappresentativi e modelli ottimizzati per l’efficienza, non per l’equità.

L’intelligenza artificiale, per quanto possa apparire neutrale e oggettiva, è profondamente influenzata dai dati su cui viene addestrata. Quando si parla di intelligenza artificiale, il termine bias diventa il segnale d’allarme di un processo non equo.

I bias non sono semplici errori casuali, ma schemi ricorrenti di distorsione che possono compromettere la qualità, l’equità e l’affidabilità dei risultati generati dai sistemi automatizzati.

Ecco una rappresentazione visiva che chiarisce come i bias si originano e si propagano nei sistemi di intelligenza artificiale.

Comprendere la natura di queste distorsioni significa riconoscere che non sono anomalie, ma riflessi delle dinamiche sociali e culturali che le hanno generate.

Il significato di bias va oltre la definizione tecnica. Parliamo di squilibri nella rappresentazione che si inseriscono nelle fondamenta stesse dei sistemi intelligenti. Un algoritmo addestrato su dati squilibrati riprodurrà inevitabilmente discriminazioni. Non per intenzione, ma per struttura. La distorsione diventa parte integrante del modello. E più il modello è raffinato, più rischia di rafforzare il pregiudizio.

Il problema è amplificato dal fatto che i bias nei modelli predittivi spesso non sono visibili né immediatamente misurabili. Agiscono come forze latenti, insinuandosi nelle decisioni senza che chi li subisce o chi li progetta ne abbia piena consapevolezza.

È per questo che giustizia algoritmica non è un ideale astratto, ma un’esigenza concreta. Se un sistema decide chi riceve un servizio e chi ne viene escluso, diventa un attore sociale a tutti gli effetti. La responsabilità della sua equità non è più rimandabile.

Parlare di bias e intelligenza artificiale è, quindi, parlare di potere: di chi definisce le regole, di chi addestra i modelli, di chi ne subisce gli esiti. Non è solo una questione di accuratezza predittiva, ma di rappresentazione umana.

Ogni dato omesso, ogni valore sovrarappresentato, ogni metrica sbilanciata può tradursi in decisioni ingiuste mascherate da efficienza computazionale. Serve un nuovo paradigma, dove l’intelligenza non sia solo artificiale ma anche consapevole della propria influenza sistemica.

Tipologie di bias nei dati, negli algoritmi e nei modelli AI

Il bias non è un concetto monolitico, ma un insieme articolato di distorsioni ricorrenti che emergono in più fasi del ciclo di vita di un sistema di intelligenza artificiale.

I bias nei dati rappresentano la radice più comune e pervasiva. Quando i dati utilizzati per addestrare un modello sono parziali, non aggiornati, o rappresentano in modo sproporzionato alcuni gruppi rispetto ad altri, il modello appreso sarà inevitabilmente distorto.

È qui che il bias di selezione entra in gioco: decide, in modo implicito, chi viene incluso nel modello e chi rimane escluso. Un dataset che contiene soprattutto volti chiari produrrà un algoritmo incapace di riconoscere accuratamente volti scuri, non perché lo “decide”, ma perché non ha mai “visto” abbastanza varietà.

Il bias di conferma è altrettanto insidioso: il modello tende a replicare schemi già presenti nei dati, rafforzando tendenze esistenti anziché metterle in discussione. Questo è particolarmente pericoloso in settori come la giustizia predittiva o il reclutamento automatico, dove le decisioni errate hanno un impatto umano diretto.

Un altro nodo cruciale è il bias di codifica, che si manifesta quando le etichette assegnate ai dati rispecchiano pregiudizi inconsapevoli o convenzioni culturali sbilanciate.

Nei modelli predittivi di machine learning, il rischio non è solo di trasmettere il bias, ma di amplificarlo attraverso il meccanismo stesso dell’ottimizzazione.

Il learning bias emerge quando si privilegia l’accuratezza media senza verificare la distribuzione dell’errore sui sottogruppi. Un sistema può ottenere un’alta performance globale mentre fallisce sistematicamente su minoranze.

Questa distorsione statistica travestita da successo computazionale è il vero volto del bias moderno: difficile da vedere, ma devastante nei suoi effetti.

Bias cognitivi vs bias automatizzati: come si influenzano

I pregiudizi algoritmici non sono generati autonomamente dalle macchine: sono, piuttosto, la codifica di scorciatoie cognitive umane che diventano permanenti quando vengono tradotte in codice.

Gli esseri umani semplificano la realtà attraverso euristiche, ovvero strategie mentali rapide ma imperfette. Quando queste euristiche vengono apprese, imitate o replicate da un modello, si trasformano in automatismi sistemici. Questo meccanismo produce quello che possiamo chiamare bias automatizzato, ovvero una distorsione non più casuale, ma strutturale.

L’automatismo percettivo è uno degli esempi più evidenti: un modello di riconoscimento facciale può essere più accurato su determinati fenotipi semplicemente perché i dati su cui è stato addestrato ne contenevano una maggiore quantità.

Ma il problema non finisce lì. La fiducia cieca nell’algoritmo, che molti utenti e persino sviluppatori mostrano, aggrava il quadro. Quando si assume che un output sia corretto solo perché generato da un sistema “intelligente”, si perde il senso critico.

Questo porta a una deresponsabilizzazione etica, in cui nessuno si assume la colpa di un errore perché tutto è delegato alla macchina.

In verità, ogni decisione automatizzata è il risultato di una catena di scelte umane: dai dati selezionati, agli obiettivi di ottimizzazione, ai compromessi accettati in fase di progettazione.

La distorsione cognitiva diventa quindi distorsione algoritmica, con un potenziale amplificato e una tracciabilità ridotta.

Se vogliamo davvero ridurre i bias, dobbiamo prima riconoscerne la radice antropologica: l’intelligenza artificiale non è altro che lo specchio delle nostre semplificazioni, amplificato dalla scala del calcolo.

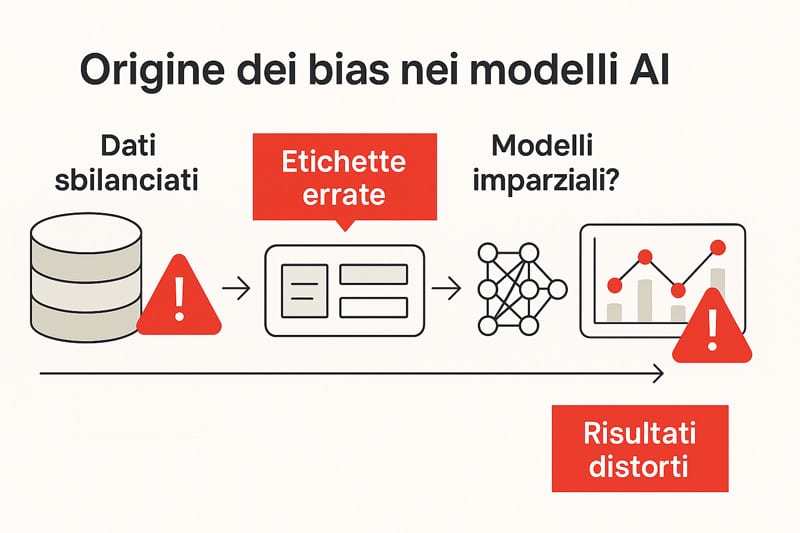

Le origini: come nascono i bias nell’addestramento dei modelli

L’idea che un algoritmo impari in modo neutrale è una delle illusioni più persistenti nell’ambito dell’intelligenza artificiale. Ogni sistema, per quanto sofisticato, dipende interamente dai dati che riceve in ingresso. Se questi dati sono incompleti, squilibrati o riflettono prospettive distorte, anche il modello risultante sarà inevitabilmente parziale. I bias e l’intelligenza artificiale non sono due mondi separati: sono legati da un filo continuo che attraversa tutte le fasi del ciclo di addestramento.

Il cuore del problema è nella pipeline del machine learning: un processo meccanico che trasforma osservazioni storiche in previsioni future. In teoria, dovrebbe solo apprendere correlazioni; in pratica, apprende anche le storture presenti nei dati originali. Il bias non si genera in un singolo momento: si accumula, si stratifica, si nasconde nei dettagli. Nella scelta dei dataset, nella selezione delle feature, nella definizione delle etichette, ogni passaggio offre un’opportunità al pregiudizio per infiltrarsi nel modello.

Persino i metodi di valutazione possono contribuire a mascherare le distorsioni. Se si misura solo l’accuratezza globale, si rischia di ignorare le prestazioni su gruppi specifici. Un modello che funziona bene in media può fallire sistematicamente per determinate categorie. E questa non è una debolezza marginale: è un limite strutturale che mina la validità stessa dell’intelligenza artificiale.

Quando si parla di bias in questo contesto, non ci si riferisce a un errore fortuito, ma a un difetto insito nell’architettura epistemica del sistema. L’addestramento automatico, per quanto potente, non ha coscienza del danno che può produrre. E se non siamo noi a riconoscere questi limiti, l’algoritmo continuerà a operare come se nulla fosse. Per questo motivo, parlare di bias e intelligenza artificiale significa affrontare un nodo tecnico, ma anche profondamente etico. Non è solo questione di codice: è questione di rappresentazione, di inclusione, di responsabilità scientifica.

L’infografica seguente evidenzia con chiarezza dove e come si formano i bias lungo la pipeline di addestramento AI.

Pipeline del bias: dati sbilanciati, labeling, modelli generativi

Nel cuore di ogni modello predittivo si trova una catena di trasformazioni nota come pipeline. È qui che si origina il bias: ogni errore nella raccolta, codifica o organizzazione dei dati diventa una regola appresa, replicata su vasta scala. Il bias nei modelli di intelligenza artificiale non è un evento posteriore: è il prodotto diretto di un processo addestrativo che non è mai davvero neutro.

Il training set rappresenta il primo snodo critico. Quando un dataset è costruito sulla base di realtà parziali — come storici sanitari sottorappresentati o dati biometrici sbilanciati — il modello tende a generalizzare su basi instabili. Questo genera errori strutturali che si traducono in discriminazioni algoritmiche persistenti.

Un altro punto vulnerabile è il data labeling. Assegnare etichette ai dati sembra un’operazione semplice, ma è spesso carica di ambiguità e giudizi soggettivi. Chi decide cosa è “corretto” in un’immagine? Quale criterio stabilisce se una frase è “offensiva”? Le risposte, se non standardizzate e pluraliste, introducono bias di codifica che si perpetuano nei modelli.

I modelli generativi, come quelli di sintesi testuale o visiva, amplificano queste distorsioni. Ricostruiscono il mondo a partire da una statistica del passato, non da una valutazione etica. Quando imparano che certe strutture narrative, volti, ruoli o concetti si ripetono, tendono a riprodurli — anche se ingiusti o errati. La pipeline del bias non è un malfunzionamento tecnico: è una conseguenza della logica inferenziale non filtrata da principi di equità.

Ecco perché intervenire su ogni fase della pipeline è cruciale. La distorsione non è un punto di arrivo, ma un effetto cumulativo. Il bias si costruisce lentamente, ma agisce in modo profondo e spesso invisibile. Non si corregge con una patch: richiede revisione sistemica e progettazione consapevole, a partire proprio dai dati.

Prompt engineering e LLM: i bias nei testi e nelle risposte

L’arrivo dei modelli di linguaggio di grandi dimensioni (LLM) ha portato una nuova forma di bias: quella testuale, fluida, difficilmente quantificabile. I pregiudizi nei modelli AI non si limitano più a dati numerici o classificazioni visive: ora emergono anche nelle parole, nei toni, nei contenuti generati. Ogni frase proposta da un sistema come GPT-4 è il risultato di miliardi di associazioni statistiche apprese da testi raccolti online — e quindi profondamente influenzati da stereotipi, squilibri culturali, visioni dominanti.

Il prompt engineering, ovvero la tecnica di costruire input per guidare il comportamento del modello, può mitigare o amplificare queste tendenze. Un prompt mal costruito genera risposte errate o distorte. Ma il problema reale è che anche un prompt neutro può attivare contenuti parziali se l’addestramento sottostante è già viziato.

Il fenomeno delle hallucination — risposte plausibili ma false — è spesso trattato come una questione tecnica. Ma quando un LLM “inventa” un riferimento, un fatto o un’affermazione, lo fa sulla base di pattern linguistici appresi. Se questi pattern contengono bias impliciti — ad esempio associazioni tra genere e professione, tra cultura e pericolo, tra nome e criminalità — il risultato è una discriminazione mascherata da coerenza.

L’intervento sui modelli linguistici richiede una nuova consapevolezza. Il bias testuale è meno visibile, ma più pervasivo: si manifesta in ciò che il modello dice, ma anche in ciò che evita di dire. Un errore visivo è misurabile. Un errore linguistico, spesso, passa inosservato.

Per questo motivo, gli errori nei modelli AI di tipo generativo devono essere trattati non come difetti casuali, ma come segnali strutturali. Riconoscerli significa rimettere in discussione il modo in cui progettiamo i dataset testuali, selezioniamo le fonti, definiamo le metriche. L’intelligenza artificiale del linguaggio non deve solo parlare: deve parlare in modo giusto, responsabile e inclusivo.

Chi subisce davvero il pregiudizio degli algoritmi

Ogni sistema di intelligenza artificiale non è solo uno strumento: è un filtro invisibile che decide chi ha accesso a un’opportunità e chi ne viene escluso. Quando parliamo di bias e intelligenza artificiale, la domanda fondamentale non è solo come si generano, ma chi colpiscono con maggiore forza. I modelli non operano nel vuoto: agiscono su dati che rappresentano la società, e la società è piena di diseguaglianze strutturali.

Chi appartiene a categorie minoritarie, chi ha una condizione non rappresentata nei dataset dominanti, chi esce dai parametri standardizzati di addestramento viene sistematicamente penalizzato. L’algoritmo non distingue la diversità: la considera rumore statistico. E ciò che considera rumore, lo ignora. È così che nasce la discriminazione algoritmica: non da un’intenzione malevola, ma da un’inerzia matematica che produce esiti profondamente iniqui.

L’immagine seguente rende visibile l’impatto concreto degli algoritmi sulle persone più vulnerabili.

I pregiudizi nei sistemi AI colpiscono con maggiore intensità le persone con disabilità, i gruppi etnici non rappresentati, chi ha accenti regionali, tratti somatici fuori standard, o esperienze sociali atipiche. Non si tratta di errori isolati. È una logica silenziosa che normalizza lo scarto, rendendolo parte integrante della decisione automatica. Le metriche di accuratezza non rilevano queste esclusioni: le assorbono.

La giustizia non è nella media, ma nella capacità del sistema di rispettare chi non rientra nelle medie. Ogni esclusione reiterata, ogni errore non segnalato, ogni conferma di uno stereotipo rafforzato rappresenta un fallimento etico prima che statistico. Quando un sistema ignora la complessità, non sbaglia: semplifica il reale fino a renderlo pericoloso.

Il vero problema non è il bias in sé, ma l’effetto che produce quando viene applicato su larga scala senza controllo umano. In quel momento, la discriminazione non è più l’eccezione: diventa la regola codificata. Chi la subisce spesso non ha neppure gli strumenti per accorgersene. E se nessuno si accorge dell’ingiustizia, l’algoritmo diventa un silenziatore sistemico. Serve quindi uno sguardo empatico e sistemico: perché chi subisce i bias non è una categoria astratta, ma una persona reale, spesso invisibile agli occhi del codice.

Bias visivi e biometrici: etnia, genere e disabilità

I sistemi di riconoscimento facciale e biometrico non sono progettati per essere equi. Sono progettati per essere performanti. Ma performance e imparzialità non coincidono. I modelli visivi imparano da ciò che vedono, e ciò che vedono è determinato dai dataset. Se questi ultimi sono composti in prevalenza da immagini di individui bianchi, maschi e normotipici, l’algoritmo diventa esperto nel riconoscere quei volti — e inadeguato di fronte a tutto il resto.

Il caso di Gender Shades, condotto dal MIT Media Lab, ha dimostrato in modo lampante che i tassi di errore crescono esponenzialmente quando il volto da analizzare è quello di una donna nera. Sistemi come Amazon Rekognition, utilizzati anche da enti governativi, hanno mostrato percentuali di riconoscimento sbilanciate e allarmanti. Questo non è un difetto tecnico: è un riflesso di una scelta progettuale che ha escluso porzioni significative della popolazione.

I bias nei modelli di intelligenza artificiale, in ambito visivo, colpiscono anche le persone con disabilità. Volti con tratti atipici, movimenti oculari non standard, caratteristiche somatiche fuori norma non vengono riconosciuti, oppure vengono classificati come “anomalie”. E se un volto viene considerato anomalo, allora è anche a rischio esclusione.

La discriminazione non si manifesta solo nell’errore, ma nel differente tasso di errore tra gruppi. Quando un modello commette errori sistematici su alcune etnie, alcuni generi o alcune disabilità, sta partecipando attivamente alla marginalizzazione. Il riconoscimento facciale diventa così un atto politico camuffato da operazione tecnica.

Un sistema visivo addestrato male non è solo meno preciso: è anche meno giusto. Il problema non è nel volto che si presenta, ma nello sguardo che lo interpreta. Finché questi modelli non verranno progettati con rappresentatività, trasparenza e validazione su minoranze, continueranno a produrre errori che non sono casuali, ma sistemici.

Pregiudizi vocali e linguistici nei modelli speech

Le parole che pronunciamo, il modo in cui le articoliamo, l’accento con cui le formuliamo: tutto può essere terreno fertile per il bias. I sistemi di riconoscimento vocale come Alexa, Siri o Google Assistant non rispondono a tutti nello stesso modo. Sono più efficaci con accenti standard, registrazioni in ambienti silenziosi e voci maschili adulte. Tutto ciò che devia da questo profilo viene interpretato peggio, o non viene interpretato affatto.

Il bias intelligenza artificiale, in ambito vocale, assume una forma subdola. Non discrimina apertamente: ignora selettivamente. Un utente con inflessione dialettale marcata può trovarsi a ripetere il comando tre volte, a correggere ciò che il sistema ha capito, a sentirsi escluso da un’interazione pensata per “altri”. Questo fenomeno ha un nome: accent bias. È il risultato di modelli addestrati su dati vocali poco diversificati, in cui la standardizzazione ha sostituito la pluralità.

Ma non è solo un problema di comprensione. È anche un problema di rappresentazione. I modelli NLP (Natural Language Processing) generano risposte, consigli, suggerimenti. Se le informazioni di addestramento sono squilibrate, anche le risposte lo saranno. Un modello può suggerire carriere diverse in base al genere dedotto dalla voce, oppure reagire in modo differente a input emotivi forniti con cadenze regionali.

L’intelligenza artificiale e giustizia sociale si incontrano proprio qui: nel momento in cui un sistema decide chi ascoltare meglio. Un errore vocale non è solo tecnico. È un messaggio implicito: la tua voce non è abbastanza. E in un mondo digitale basato sulla voce, non essere capiti significa non esistere.

Affinché i sistemi vocali siano davvero inclusivi, devono essere addestrati su pluralità fonetiche, devono riconoscere i limiti della loro architettura e devono essere progettati con attenzione alle minoranze. Un modello che ascolta tutti allo stesso modo non è solo più utile: è più giusto.

Soluzioni tecniche per una AI più giusta

La lotta ai bias e intelligenza artificiale non può fermarsi alla consapevolezza teorica. Serve un passo ulteriore, radicale: quello delle soluzioni concrete. In ambito tecnico-ingegneristico, questo significa sviluppare strumenti, procedure e algoritmi che non si limitino a osservare l’ingiustizia, ma che la correggano lungo tutto il ciclo di vita del modello. Il punto di partenza è semplice quanto rivoluzionario: non si può migliorare ciò che non si misura.

La misurazione della fairness o calcolo di equità è un nodo centrale. Un modello può sembrare efficace in termini di accuratezza complessiva, ma fallire gravemente su gruppi minoritari. È qui che entrano in gioco le fairness metrics, strumenti che permettono di valutare in modo matematico la distribuzione equa degli output. Metriche come la counterfactual fairness analizzano se un cambiamento ipotetico del gruppo di appartenenza modifica l’esito del modello, a parità di condizioni.

La costruzione di una AI più equa, però, non si limita alla valutazione. Richiede tecniche di riequilibrio attivo, sia in fase di pre-processing (ad esempio con il bilanciamento dei dati) che durante l’addestramento (inserendo vincoli di imparzialità nei loss function). Il debiasing automatico diventa una componente strutturale, non accessoria. Ma la giustizia non è completa senza la trasparenza.

L’altro grande asse di intervento è la explainable AI. La trasparenza algoritmica non è solo una questione di comunicazione: è una forma avanzata di accountability tecnica. Permette di comprendere perché un modello ha preso una decisione, identificando i fattori predominanti. Questo è essenziale non solo per i progettisti, ma anche per utenti, stakeholder e regolatori.

Quando le decisioni non sono più comprensibili, l’intelligenza artificiale diventa una scatola nera opaca, incapace di generare fiducia. Invertire questa dinamica è possibile. Strumenti come SHAP o LIME consentono una visualizzazione puntuale delle variabili influenti. In questo modo, si può non solo diagnosticare un bias, ma anche intervenire localmente sul dataset o sul modello.

Bias e intelligenza artificiale non sono un’accoppiata inevitabile. Sono una sfida progettuale. E ogni sfida tecnica, se affrontata con metodo, è anche un’opportunità di trasformazione. Una AI più giusta non nasce per caso: si costruisce, con attenzione chirurgica, lungo ogni riga di codice.

Fairness, riequilibrio e debiasing automatico

Affrontare il problema dei bias algoritmici significa riconoscere che l’inequità non è un’eccezione ma un possibile esito sistemico, radicato nelle scelte di progettazione e nei dati stessi. La fairness AI si configura come un insieme di tecniche finalizzate a rendere l’intelligenza artificiale più equa, misurabile e correggibile.

Uno dei punti di partenza è il riequilibrio dei dataset. Modelli addestrati su dati distorti tendono a replicare queste distorsioni. Intervenire con strategie di sample balancing, reweighting o sintesi controllata consente di attenuare il dominio delle classi maggioritarie. Ogni decisione statistica diventa una decisione politica, capace di ridefinire le priorità del sistema.

Il secondo livello è l’integrazione di vincoli di fairness direttamente nei modelli. Algoritmi fairness-aware possono essere progettati per massimizzare non solo la precisione, ma anche la parità tra gruppi. Questo comporta l’adozione di loss function che penalizzano la discriminazione, e l’implementazione di regularizer specifici che bilanciano i risultati.

Tool come AI Fairness 360, sviluppato da IBM, permettono di valutare, monitorare e correggere i bias lungo tutto il ciclo di sviluppo. Non si tratta di soluzioni universali, ma di strumenti adattivi, da calibrare in funzione del dominio e del target d’uso. Una tecnica efficace nel riconoscimento facciale potrebbe risultare inadatta nel recruiting automatizzato.

Il debiasing automatico, tuttavia, non può essere visto come una soluzione definitiva. Rappresenta una tappa necessaria, ma non sufficiente. Senza una consapevolezza critica nei team di sviluppo, anche l’algoritmo più bilanciato può fallire. Il rischio è quello della “fairness performativa”, una parvenza di equità che non modifica la struttura sottostante.

Rendere l’AI più giusta non significa eliminare il rischio, ma costruire sistemi resilienti, capaci di apprendere e correggersi in base al contesto. Ogni passo verso la fairness deve essere documentato, misurato, validato. Perché l’equità algoritmica non si ottiene con un comando, ma con un design orientato all’etica.

Explainable AI: come rendere trasparente un algoritmo

Quando un algoritmo prende una decisione, spesso ci si limita a verificarne la correttezza. Ma comprendere il “perché” è altrettanto cruciale. La explainable AI nasce dall’esigenza di rendere visibili i meccanismi decisionali nascosti dietro le reti neurali, i modelli ensemble, e tutte le architetture che operano come scatole nere.

Uno dei primi ostacoli è la complessità. Molti modelli moderni operano su milioni di parametri, rendendo la tracciabilità delle decisioni un’impresa ardua. È qui che entrano in gioco strumenti come SHAP (SHapley Additive exPlanations) e LIME (Local Interpretable Model-agnostic Explanations). Questi metodi non modificano l’algoritmo, ma costruiscono una “mappa” delle variabili che più hanno influenzato un output.

Questa mappa non è solo utile a scopi tecnici. È uno strumento fondamentale per garantire accountability. Quando una persona viene esclusa da un beneficio, ha il diritto di sapere perché. La spiegabilità diventa quindi una forma di giustizia informativa: trasformare l’opacità in dialogo.

Oltre alla spiegazione puntuale, esistono approcci strutturali, come l’approssimazione tramite alberi decisionali, che ricostruiscono versioni semplificate del modello per favorire la comprensione. Anche le saliency maps, utilizzate nel deep learning visivo, mostrano quali porzioni dell’immagine hanno maggiormente influenzato la classificazione.

Ma l’explainability non è solo una tecnica. È un principio progettuale. Significa costruire sistemi che, fin dall’inizio, siano trasparenti per natura. Non basta spiegare: occorre progettare per essere spiegabili. È il principio della transparency-by-design, che unisce ingegneria, etica e comunicazione.

In un’epoca in cui le decisioni automatizzate governano la nostra quotidianità, rendere esplicite le logiche sottostanti non è un’opzione: è un dovere. Perché ogni algoritmo opaco è un potenziale spazio di ingiustizia. E ogni spiegazione chiara è un atto di restituzione di potere.

Etica, governance e responsabilità negli algoritmi

Nel cuore della trasformazione digitale che stiamo vivendo, l’equilibrio tra bias e intelligenza artificiale rappresenta un bivio etico cruciale. Quando un algoritmo decide chi riceve un prestito, chi può accedere a una terapia, o quale contenuto mostrare a un bambino, non stiamo solo parlando di codice. Stiamo parlando di potere, e di responsabilità.

Governare l’intelligenza artificiale significa riconoscere che l’errore sistematico – il bias – non è sempre un incidente. Talvolta è una conseguenza diretta di scelte progettuali non neutre. Non è sufficiente correggere a valle ciò che è sbagliato a monte. Serve un approccio sistemico che imponga trasparenza fin dalla prima riga di codice.

Le principali autorità regolatorie – dal NIST agli organismi europei – hanno elaborato framework di auditing algoritmico per garantire che ogni sistema venga sottoposto a verifiche di equità, responsabilità e spiegabilità. I bias e intelligenza artificiale non devono più essere affrontati solo come problemi tecnici: vanno regolati come potenziali fattori di ingiustizia sociale.

Il concetto di accountability algoritmica richiede che ogni decisione automatizzata sia non solo tracciabile, ma anche spiegabile. La governance algoritmica non può fermarsi all’aderenza formale ai regolamenti: deve diventare una pratica quotidiana di vigilanza etica. Chi progetta, addestra o distribuisce un sistema AI deve sapere di avere tra le mani una responsabilità politica, oltre che informatica.

L’assenza di trasparenza, in questo contesto, diventa una forma di abuso. I sistemi black box privi di audit condivisi rappresentano una minaccia alla democrazia digitale. Un algoritmo opaco può replicare o amplificare disuguaglianze, soprattutto se distribuito su larga scala. Ecco perché la governance deve essere multilivello, collaborativa, aperta.

In conclusione, affrontare bias e intelligenza artificiale con serietà significa non solo monitorare gli effetti, ma riscrivere le regole del gioco. L’etica non è un’estensione opzionale del codice: è parte integrante del design. Solo una governance forte, accompagnata da una cultura diffusa della responsabilità, può trasformare la tecnologia da rischio in strumento di equità.

Questa immagine rappresenta il delicato equilibrio tra efficienza e responsabilità etica nei modelli di intelligenza artificiale.

Linee guida e policy: cosa impongono gli enti regolatori

Quando si parla di governance algoritmica, non si fa solo riferimento a principi astratti. Esistono normative precise, linee guida stringenti, e framework internazionali che definiscono standard operativi obbligatori. L’epoca in cui la tecnologia cresceva senza controllo normativo è finita: oggi l’AI è soggetta a regole, come qualsiasi altro sistema di impatto sociale.

Organismi come la Commissione Europea, l’UNESCO e l’OECD hanno costruito un impianto normativo condiviso, volto a regolamentare l’uso dei sistemi intelligenti in settori critici. L’AI Act, in fase di implementazione, prevede la classificazione dei sistemi in base al livello di rischio, imponendo audit obbligatori per quelli ad alto impatto.

Queste policy impongono trasparenza, documentazione, tracciabilità e obblighi di explainability. Ogni modello che impatta i diritti fondamentali deve essere tracciabile tramite audit trails e sottoposto a processi di convalida preventiva. La governance algoritmica non è più una scelta: è un dovere operativo e giuridico.

Anche il NIST americano ha introdotto linee guida dettagliate su sicurezza, imparzialità, accountability e spiegabilità. L’approccio è olistico: considera il ciclo completo di vita dell’AI, dalla raccolta dati alla dismissione del modello. Inoltre, le nuove norme ISO AI definiscono benchmark per l’implementazione corretta dei sistemi automatizzati.

L’adozione di questi standard è fondamentale per garantire che l’intelligenza artificiale sia non solo potente, ma anche giusta. Il vuoto normativo è il terreno fertile dei bias. La presenza di regole chiare, invece, costringe le organizzazioni a ripensare priorità, responsabilità e processi.

La sfida è ora quella dell’applicazione pratica. Le regole esistono, ma devono essere integrate nei flussi di sviluppo quotidiani. La governance algoritmica non si costruisce con dichiarazioni di principio, ma con strumenti concreti, audit indipendenti e monitoraggi continui.

Etica e AI: dilemmi morali e progettazione responsabile

L’etica dell’intelligenza artificiale è molto più di una riflessione teorica. È il tentativo di rispondere, con coerenza, a una domanda fondamentale: cosa è giusto automatizzare? Non tutto ciò che è tecnicamente possibile è anche moralmente accettabile. E non tutto ciò che è utile è anche equo.

In questo senso, il cuore della questione risiede nella progettazione. Un sistema costruito senza riflessione etica rischia di replicare in automatico pregiudizi sociali, stereotipi e disuguaglianze. L’approccio deontologico propone una visione rigorosa: i limiti devono essere fissati prima, non dopo. Serve un principio guida che orienti ogni decisione tecnica, ogni compromesso architetturale, verso un obiettivo superiore: la giustizia.

Il concetto di fairness-by-design nasce proprio da qui. Non si tratta solo di implementare vincoli etici in fase di test, ma di concepire sin dall’inizio un’intelligenza artificiale che rispetti la pluralità umana. La progettazione responsabile diventa allora una forma di cura, un atto politico oltre che professionale.

In parallelo, emergono dilemmi concreti: se un algoritmo decide chi viene assunto, può tenere conto del background sociale? Se un sistema suggerisce cure, può ignorare dati non rappresentativi di alcuni gruppi etnici? Questi dilemmi richiedono risposte sofisticate, multilivello, capaci di unire teoria morale, diritto e ingegneria.

La Algorithmic Justice League, fondata da Joy Buolamwini, ha mostrato con prove empiriche come molti sistemi falliscano proprio quando si confrontano con la diversità. Le iniziative di design etico stanno crescendo, ma sono ancora troppo marginali. Serve un cambio di paradigma: l’etica non deve più rincorrere l’AI. Deve anticiparla.

L’etica dell’intelligenza artificiale è il vero terreno di scontro dei prossimi anni. Non riguarda solo gli esperti di filosofia morale. Riguarda ogni sviluppatore, ogni azienda, ogni cittadino. Perché ogni algoritmo è una decisione che tocca delle vite. E ogni decisione, se non è giusta, non è mai veramente intelligente.

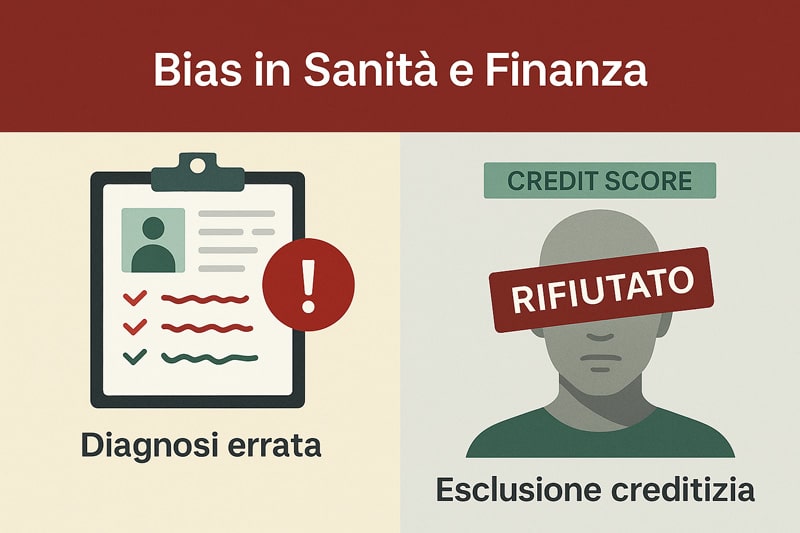

Bias nei modelli generativi per sanità e finanza

Nel cuore delle applicazioni dell’intelligenza artificiale, due settori risultano particolarmente esposti ai suoi limiti: la sanità e la finanza. In entrambi i casi, modelli predittivi e sistemi decisionali automatizzati hanno dimostrato grande potenziale, ma anche una spiccata tendenza a replicare ed amplificare bias e intelligenza artificiale.

Nel contesto sanitario, strumenti come gli algoritmi di triage o le piattaforme diagnostiche AI promettono efficienza e rapidità. Tuttavia, quando i dataset utilizzati non rappresentano fedelmente la diversità clinica e demografica dei pazienti, emergono errori sistematici. Un modello come l’Epic Sepsis Model, ad esempio, ha dimostrato limiti nel riconoscere sintomi in soggetti non caucasici o in gruppi minoritari.

Questo fenomeno, noto come bias di popolazione, mina la credibilità e l’equità delle diagnosi automatizzate, portando a distorsioni nel risk score e nella personalizzazione delle cure.

In ambito finanziario, i modelli di scoring creditizio alimentati da IA vengono spesso descritti come strumenti oggettivi. Ma l’illusione di imparzialità svanisce rapidamente quando si osserva la loro struttura. Le decisioni sull’accesso al credito o sulla validità di un investimento dipendono da dati storici che riflettono disuguaglianze economiche pregresse.

Questa immagine mette a confronto gli effetti concreti dei bias e intelligenza artificiale nei settori più sensibili: sanità e finanza.

Se un algoritmo ha “imparato” che determinati codici postali, redditi o gruppi sociali sono più soggetti a default, allora penalizzerà intere categorie senza alcuna responsabilità esplicita.

Bias e intelligenza artificiale si intrecciano qui con dinamiche socioeconomiche reali: ciò che appare come una valutazione numerica è spesso il risultato di bias impliciti codificati nei dati stessi. Il rischio è quello di costruire una tecnocrazia in cui l’apparente neutralità dell’algoritmo nasconde scelte discriminatorie sistemiche, senza possibilità di verifica o contestazione da parte degli utenti.

In questi settori delicati, l’errore non è solo statistico: può tradursi in malasanità o esclusione finanziaria.

Diagnosi alterate: bias nei modelli clinici AI

Nei contesti clinici, l’intelligenza artificiale promette diagnosi rapide, predittive e scalabili. Tuttavia, questa promessa rischia di infrangersi contro il muro dei dati sbilanciati. I bias nei modelli di intelligenza artificiale emergono in particolare quando le informazioni cliniche raccolte non rappresentano in modo equo tutte le fasce della popolazione.

Un esempio emblematico è l’algoritmo Epic Sepsis Model. Questo strumento è stato adottato da numerosi ospedali per anticipare condizioni settiche, ma studi indipendenti hanno mostrato che il modello tende a sottovalutare i sintomi nei pazienti di colore o in fasce d’età estreme.

La distorsione nei modelli diagnostici non è un’anomalia del codice, ma un riflesso diretto di ciò che manca nei dati: diversità nei profili clinici, accuratezza nell’annotazione, quantità sufficiente di esempi minoritari.

La problematica dell’underrepresentation è particolarmente acuta nei dataset ospedalieri, dove alcune categorie – ad esempio donne incinte, persone transgender o pazienti con malattie rare – risultano marginali o assenti.

Questo porta a un risk assessment inadeguato, con esiti clinici peggiori, cure ritardate o diagnosi errate. In molti casi, gli algoritmi producono falsi negativi, ossia mancate segnalazioni di rischio, proprio dove servirebbe maggiore attenzione.

I bias nei modelli di intelligenza artificiale non sono solo una questione tecnica. Sono il riflesso di una mancata progettazione centrata sulla diversità del paziente. L’adozione di protocolli FDA, audit clinici e test multicentrici su popolazioni eterogenee potrebbe ridurre queste lacune, ma serve un cambio di paradigma: dalla performance all’equità.

Scoring finanziario e disuguaglianze algoritmiche

Nel mondo del fintech, le decisioni prese dagli algoritmi non sono mai neutre. Gli errori nei modelli AI che determinano accessi al credito, tassi di interesse o livelli di rischio spesso si fondano su gap nei dati di training e strutture predittive che amplificano disuguaglianze sociali.

Quando una banca o una piattaforma fintech utilizza un algoritmo per stabilire la “creditworthiness” di un individuo, si affida a una miriade di segnali: storico creditizio, geolocalizzazione, frequenza di pagamento, spese online.

Ma se quei segnali derivano da popolazioni che hanno subito discriminazioni sistemiche, allora il modello perpetuerà quella storia. Il risultato? Esclusione finanziaria di soggetti senza colpa.

L’AI loan scoring applicato in ambiti come mutui, microcredito o carte prepagate, penalizza spesso chi non ha dati digitali “forti”: immigrati, lavoratori precari, donne imprenditrici. Le variabili usate come proxy per l’affidabilità non sono universali. Un codice postale può diventare un predittore di rischio solo perché storicamente associato a default.

Gli errori nei modelli AI in finanza non si limitano a previsioni errate: generano vere e proprie barriere sistemiche. E spesso, il cittadino non ha strumenti per sapere perché è stato rifiutato, né come correggere il punteggio. L’asimmetria informativa è totale.

Serve trasparenza nei modelli, auditing continuo, e una revisione dei criteri utilizzati. Senza questo, la predictive inequality rischia di trasformare l’algoritmo in una sentenza inappellabile. E l’intelligenza artificiale, invece che democratizzare l’accesso ai servizi, finisce per codificare e blindare il privilegio.

Quando l’AI discrimina senza accorgercene: bias ambientali e culturali

In un’epoca in cui i modelli predittivi guidano sempre più decisioni su scala globale, parlare di bias e intelligenza artificiale significa anche confrontarsi con forme di distorsione meno visibili ma altrettanto pervasive. Tra queste, i bias ambientali e culturali rappresentano un nodo critico e ancora poco esplorato nel dibattito pubblico e scientifico. A differenza dei pregiudizi diretti su genere o etnia, questi bias agiscono silenziosamente, influenzando l’intero spettro di valori, risorse e soggettività che l’AI è chiamata a elaborare.

I pregiudizi algoritmici ambientali si manifestano, ad esempio, quando gli algoritmi favoriscono modelli economici estrattivi senza tener conto della sostenibilità o dell’impatto ecologico. L’allocazione automatica delle risorse, nei contesti energetici o agricoli, può escludere habitat naturali o specie considerate non rilevanti dal punto di vista antropocentrico. Questo approccio riduttivo è noto come speciesist bias, una forma di discriminazione algoritmica nei confronti degli ecosistemi non umani.

Allo stesso modo, l’AI e giustizia sociale entrano in conflitto quando i modelli riflettono una visione del mondo limitata o culturale parziale. Le tecnologie costruite su set di dati eurocentrici, per esempio, tendono a trascurare sistemi di conoscenza locali, idiomi minori, visioni non occidentali della natura o dell’essere umano. Questa esclusione non è solo tecnica: è un atto di marginalizzazione che si traduce in colonialismo digitale.

Affrontare questi bias significa ridefinire il design dei modelli in chiave ecologica e interculturale, mettendo in discussione non solo cosa calcola un’AI, ma per chi e in funzione di quali valori elabora quelle informazioni. Le soluzioni non possono che essere sistemiche: coinvolgere ecologi, antropologi, attivisti culturali, oltre agli sviluppatori e data scientist. Solo così sarà possibile costruire un’intelligenza artificiale davvero equa, inclusiva e non miope.

L’immagine sottostante illustra i due volti meno visibili dei bias e intelligenza artificiale: il costo ambientale e la marginalizzazione culturale.

Speciesist bias e impatto ecologico dell’AI

Dietro ogni modello predittivo si nasconde un’infrastruttura materiale fatta di consumo energetico, server farm, estrazione dati e risorse computazionali intensive. In questo contesto, parlare di bias e intelligenza artificiale non è solo un discorso astratto o morale: è un problema profondamente fisico e ambientale. Il cosiddetto speciesist bias si inserisce qui come una lente critica che denuncia l’assenza di considerazione per le forme di vita non umane nelle logiche algoritmiche.

Le AI, soprattutto quelle su larga scala, vengono addestrate per ottimizzare obiettivi umani: massimizzare vendite, minimizzare costi, prevedere comportamenti. Ma in questa ottimizzazione non viene mai calcolato il prezzo ambientale effettivo: deforestazione, dispendio idrico per raffreddare data center, emissioni di CO₂ legate al training massivo di modelli. L’esempio più emblematico è il training di modelli generativi multimodali: un singolo addestramento può produrre la stessa quantità di CO₂ di centinaia di voli intercontinentali.

La mancanza di metriche ecologiche all’interno dei dataset e la data extraction non regolamentata portano a una profonda asimmetria tra ciò che viene rappresentato e ciò che viene effettivamente danneggiato. Ecosistemi interi, specie animali e comunità indigene risultano esclusi dal ciclo decisionale automatico. Ciò che non è nei dati, non entra nel modello, e ciò che non entra nel modello viene ignorato nelle decisioni finali.

Combattere questo tipo di pregiudizi algoritmici richiede un cambiamento di paradigma: abbandonare il mito dell’efficienza pura e introdurre criteri di sostenibilità computazionale nei processi di progettazione. Significa rivedere il ciclo di vita degli algoritmi includendo indicatori ambientali, footprint computazionale e criteri etici legati al pianeta e non solo all’umano.

Bias culturali e algoritmi non inclusivi

In molti casi, l’intelligenza artificiale costruisce e rinforza una sola narrazione: quella dominante. Quando i modelli linguistici vengono addestrati su dataset prevalentemente eurocentrici, tutto ciò che sta al di fuori di questa cornice viene ridotto, distorto o cancellato. Questo fenomeno prende il nome di erasure narrativa, una forma di marginalizzazione in cui lingue, dialetti, riferimenti culturali e epistemologie non occidentali vengono silenziati.

Il bias e intelligenza artificiale qui assume una dimensione culturale potente: i modelli non solo interpretano il mondo attraverso una griglia precostituita, ma la impongono. I sistemi di traduzione automatica, per esempio, tendono a normalizzare l’inglese come riferimento assoluto, introducendo errori semantici nei testi provenienti da lingue indigene o strutture linguistiche non latine. La conseguenza è una perdita di significato culturale e un impoverimento della diversità espressiva.

Questo algocentrismo ha effetti concreti sull’accesso all’informazione, sulla rappresentazione identitaria e persino sulla partecipazione politica. In alcune regioni del mondo, modelli AI incapaci di comprendere contesti culturali locali hanno ostacolato l’accesso a servizi pubblici, strumenti educativi o canali di assistenza sanitaria. L’AI, se non progettata in modo inclusivo, può diventare un nuovo strumento di colonizzazione.

Contrastare questi bias culturali significa rivedere le logiche di costruzione del corpus: aprire dataset a una pluralità di fonti, adottare standard linguistici interculturali, coinvolgere linguisti, filosofi, studiosi di culture orali e comunità locali nel processo di addestramento. Solo così sarà possibile costruire modelli veramente inclusivi, capaci di riconoscere, valorizzare e proteggere la diversità che l’intelligenza artificiale oggi tende ad appiattire.

Verso un’AI inclusiva: UXR e approcci interdisciplinari

Nel dibattito su bias e intelligenza artificiale, manca spesso una prospettiva realmente umana, fondata sull’esperienza diretta degli utenti. L’intelligenza artificiale, se progettata senza considerare i bisogni concreti delle persone, rischia di amplificare pregiudizi, generare frustrazione e produrre risultati non equi. Per questo motivo, un ruolo centrale è giocato dalla UX research (UXR), che permette di indagare in profondità il modo in cui gli individui interagiscono con i sistemi predittivi.

Il design dell’esperienza utente nei progetti di AI ha implicazioni dirette sulla riproduzione dei bias. La scelta delle persone coinvolte nei test, i contesti in cui vengono osservate, gli scenari simulati, tutto contribuisce a costruire un modello della realtà che può essere parziale, distorto o escludente. Comprendere cosa sono i bias, in questo senso, significa riconoscere le fasi critiche in cui si insinuano: nel prototipo, nei dati raccolti, nei feedback interpretati.

Nel contesto attuale, la spinta verso una AI realmente user-centric implica non solo una maggiore consapevolezza delle barriere cognitive, ma anche un lavoro attivo per superarle. Il bias ai non è solo un fenomeno statistico o tecnico: è l’espressione di un processo progettuale che ha ignorato l’inclusività. Da qui nasce l’esigenza di costruire team eterogenei, capaci di portare in fase di design prospettive molteplici.

Prototipare un’interfaccia inclusiva non è più un’opzione ma un requisito etico. L’integrazione di strumenti come il design thinking e l’approccio value-sensitive permette di ridurre preventivamente i rischi di esclusione e stereotipizzazione. Solo attraverso una ricerca orientata al vissuto reale, e non solo al dato astratto, possiamo aspirare a un futuro dove bias e intelligenza artificiale non siano sinonimi di disuguaglianza, ma di una sfida affrontata con rigore e responsabilità.

Verso un’AI inclusiva: UXR e approcci interdisciplinari

In un panorama dominato da logiche algoritmiche sempre più pervasive, bias e intelligenza artificiale emergono come nodo centrale della giustizia digitale. Ma il problema non si esaurisce nella scrittura di codice imparziale o nel raffinamento dei dataset. Il cuore della questione è l’esperienza umana: come interagiscono le persone con i modelli predittivi? Chi è incluso e chi resta ai margini? Qui entra in gioco la User Experience Research (UXR), che non è un accessorio del design ma una pratica fondamentale per garantire inclusività.

La ricerca UX consente di osservare comportamenti, raccogliere feedback qualitativi, interpretare frustrazioni e aspettative non espresse. Quando questi dati vengono ignorati o mal interpretati, l’intero processo di progettazione dell’AI si deforma. Bias e intelligenza artificiale, in questo scenario, non derivano solo dai dati numerici, ma anche da un design miope, modellato su gruppi limitati o normativi. La mancanza di rappresentazione è il primo gradino della discriminazione automatizzata.

Per realizzare sistemi realmente equi, serve un cambio di paradigma. L’intelligenza artificiale deve smettere di essere uno strumento per utenti teorici e diventare un ecosistema centrato sulle persone. Questo richiede team eterogenei, guidati da una prototipazione inclusiva, capace di evolversi sulla base dell’ascolto. Il dialogo tra sviluppatori, psicologi, ricercatori sociali e designer non è più un’opzione, ma un prerequisito progettuale.

L’inclusività non nasce da un algoritmo corretto, ma da un’intenzionalità distribuita lungo tutto il ciclo di vita del modello. Un’intenzionalità che parte dalla UX research, attraversa la progettazione iterativa, e culmina nella valutazione continua dell’impatto sociale. Perché costruire un’AI equa non significa solo correggere i dati: significa disegnare il futuro con occhi diversi.

L’immagine seguente mostra come un team eterogeneo possa contribuire concretamente alla progettazione di un’AI più inclusiva.

UX research e bias nel ciclo di sviluppo AI

La UX research è spesso vista come una fase esplorativa o, peggio, opzionale. Ma quando si parla di bias e intelligenza artificiale, è proprio nella UXR che si nascondono molte delle origini delle distorsioni. I test utente condotti su campioni non rappresentativi producono risultati che influenzano il comportamento predittivo dei modelli. Un’interfaccia che ignora le diversità culturali, cognitive o linguistiche può amplificare l’iniquità.

Pensiamo a un assistente vocale che fraintende costantemente chi ha un accento non standard. O a una dashboard pensata per utenti esperti, che penalizza i neofiti. Questi sono sintomi di bias introdotti durante le fasi di osservazione e validazione, quando l’insieme dei test è troppo ristretto o le metriche di successo sono definite secondo valori impliciti. La ricerca UX non può quindi limitarsi a registrare comportamenti: deve decostruire i presupposti del design.

Un elemento cruciale è l’empathy mapping, uno strumento che permette di visualizzare esperienze utente divergenti e di cogliere segnali deboli. L’integrazione sistematica dell’empatia nel ciclo di sviluppo diventa il primo passo verso una user-centric AI. Le soluzioni, infatti, non emergono dai numeri, ma dalla comprensione profonda del contesto.

Solo una ricerca UX trasversale, guidata dalla diversità e dall’ascolto autentico, può generare insight capaci di influenzare in modo costruttivo il ciclo di addestramento dei modelli. L’equità algoritmica inizia nei laboratori di testing, ben prima di arrivare in produzione.

Progettare con etica: collaborazione multidisciplinare

Affrontare bias e intelligenza artificiale significa rifiutare l’idea che un solo tipo di competenza possa bastare. Non esistono soluzioni tecniche a problemi etici. Per questo, i team che progettano modelli AI devono diventare ecosistemi multidisciplinari. Una rete collaborativa in cui psicologi, sviluppatori, eticisti, linguisti e sociologi condividano responsabilità e visione.

La collaborazione cross-funzionale consente di anticipare scenari critici, valutare impatti differenziali e costruire prototipi più consapevoli. Inserire etica nei modelli non è un gesto formale: è una pratica viva, che richiede competenze specifiche. Un esempio? Il metodo del value-sensitive design, in cui ogni elemento dell’interfaccia è calibrato sulla base di valori umani, esplicitamente dichiarati.

Ma serve anche diversità cognitiva: approcci e stili di pensiero differenti producono soluzioni più robuste. La cognitive diversity non è solo inclusione sociale, è un asset progettuale. Le soluzioni emergono dal confronto, non dall’uniformità. Questo porta a pratiche come gli ethical sprint, momenti progettuali dedicati all’analisi dei dilemmi morali legati al modello.

Non è più sufficiente “testare” l’etica di un algoritmo. Occorre progettarla. Questo significa strutturare processi che integrino l’etica nei flussi di lavoro: non come revisione finale, ma come matrice generativa. Quando si parla di bias AI, la vera innovazione è imparare a progettare con sensibilità, insieme. Solo così l’intelligenza artificiale può diventare veramente intelligente.

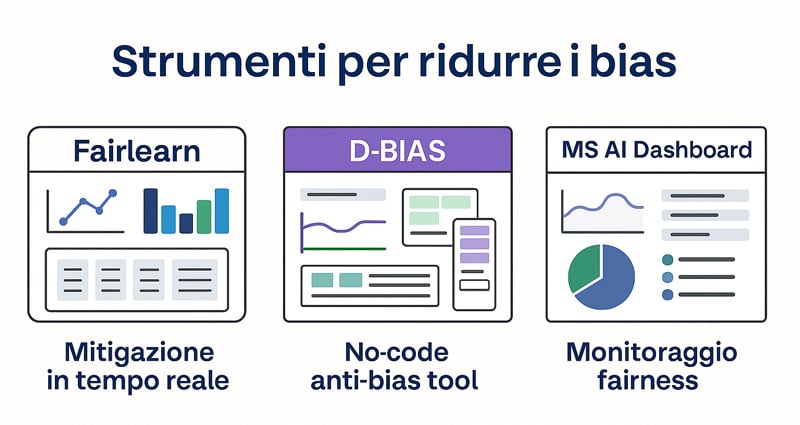

Strumenti operativi per monitorare e ridurre i bias

In un panorama dominato dall’automazione, monitorare i bias e l’intelligenza artificiale è diventata un’operazione non più opzionale, ma imprescindibile. Se da un lato gli algoritmi possono accelerare le decisioni, dall’altro possono rafforzare inconsapevolmente le disuguaglianze. Per questo motivo stanno emergendo strumenti operativi concreti che permettono di identificare, quantificare e ridurre i bias nei modelli AI attraverso pipeline ben definite.

Molti di questi strumenti si basano su moduli fairness integrabili nei workflow esistenti, capaci di eseguire audit su modelli già in produzione. È proprio qui che la densità semantica della Kp bias e intelligenza artificiale trova applicazione concreta: l’analisi non si limita a un controllo statistico, ma entra nel merito delle disuguaglianze algoritmiche tramite dashboard interpretative, librerie open-source e framework ad alta trasparenza. La questione non è più “se” un modello sia imparziale, ma quanto sia misurabile e correggibile.

Inoltre, la diffusione di strumenti visuali e framework no-code permette anche a chi non possiede competenze di programmazione di attivare verifiche anti-bias, contribuendo così a democratizzare l’accesso alla giustizia algoritmica. Tool come Fairlearn, D-BIAS e Explainability 360 di IBM rappresentano esempi concreti di questa evoluzione, facilitando l’integrazione tra sviluppo e responsabilità sociale.

Bias e intelligenza artificiale, quindi, non sono più entità astratte, ma diventano fenomeni diagnosticabili, quantificabili, affrontabili. E più l’ecosistema cresce, più cresce la necessità di strumenti robusti che non si limitino a descrivere un problema, ma suggeriscano soluzioni operative, anche in ambienti non tecnici. È questa la nuova frontiera dell’etica computazionale applicata.

L’illustrazione mostra tre strumenti reali progettati per analizzare, mitigare e rendere trasparente l’impatto dei bias nei modelli di intelligenza artificiale.

Toolkit, framework e librerie open-source anti-bias

L’emersione dei bias nei dati e nei modelli ha generato una risposta tangibile nella forma di toolkit e librerie open-source concepiti per mitigare questi fenomeni a monte. Il cuore della questione non è solo sapere cosa sono i bias dei dati, ma come agire operativamente per contenerli. In tal senso, il concetto di bias e intelligenza artificiale assume una connotazione ancora più concreta.

Tra le soluzioni più utilizzate spiccano strumenti come AI Fairness 360, che consente di eseguire audit completi lungo tutto il ciclo di vita di un modello. Questa libreria offre moduli per l’identificazione dei bias in fase di input, elaborazione e output, integrando metriche di fairness personalizzabili. Aequitas, d’altro canto, offre una visione statistica con indicatori mirati, mentre il What-If Tool di Google consente analisi visive del comportamento algoritmico, aprendo nuovi orizzonti alla spiegabilità.

Questi strumenti agiscono come dashboard intelligenti, fornendo insight predittivi sull’equità algoritmica e suggerendo tecniche di bilanciamento automatico. È importante notare come i framework open-source abbiano abbattuto barriere tecnologiche, aprendo la strada a una pratica ingegneristica etica e collaborativa.

Attraverso queste risorse, l’analisi dei bias nei modelli AI diventa un’azione ripetibile e validabile, traducendo concetti teorici in codice verificabile. Il punto non è più spiegare cos’è un bias, ma dimostrare che è stato rilevato, analizzato e corretto. Questo passaggio dalla teoria all’azione rappresenta il salto di qualità richiesto oggi.

Soluzioni no-code e flussi operativi per team non tecnici

Bias e intelligenza artificiale non sono problematiche riservate solo a sviluppatori o data scientist. Sempre più spesso, team di marketing, HR, educazione o amministrazione si trovano a interagire con modelli decisionali automatizzati, senza avere gli strumenti per valutare la loro equità. Ecco perché stanno emergendo soluzioni no-code che rendono accessibile il monitoraggio dei bias anche a chi non scrive codice.

Strumenti come Google Vertex Explainable AI e Microsoft Responsible AI Dashboard mettono a disposizione interfacce visuali che permettono di testare modelli, visualizzare distribuzioni di bias e confrontare output su gruppi diversi.

Questi sistemi introducono il concetto di ethics-by-design anche per utenti non tecnici, integrando nel processo decisionale funzioni di verifica di fairness in tempo reale. La Kp bias e intelligenza artificiale trova qui un terreno fertile per radicarsi nei contesti aziendali e organizzativi più eterogenei.

Non si tratta solo di correggere errori. Si tratta di anticipare le ingiustizie sistemiche, rendendo la trasparenza una funzione integrata. Le interfacce no-code, quindi, non semplificano soltanto: abilitano, responsabilizzano e aprono la strada a una nuova forma di inclusione algoritmica, nella quale il controllo è diffuso, condiviso e misurabile.

Roadmap per evitare i bias nei progetti AI

Riassumere un percorso operativo per prevenire bias e intelligenza artificiale significa trasformare una sfida teorica in un impegno strutturato e verificabile. Questo non è un semplice decalogo, ma una mappa attivabile, fatta di azioni, metriche e cultura.

La governance algoritmica deve diventare un processo attivo. Ogni progetto AI richiede un sistema di audit continuo, capace di intercettare scostamenti e anomalie in tempo reale. La revisione iterativa non va delegata a un momento finale, ma implementata ad ogni fase: dal design dei flussi UX alle fasi di addestramento, dalla validazione ai test operativi.

La etica dell’intelligenza artificiale non può restare un’etichetta: deve tradursi in responsabilità condivisa. Ogni team, da sviluppatori a designer, da project manager a stakeholder, dovrebbe partecipare alla definizione di criteri di ethical alignment. Questi criteri, trasparenti e firmati, diventano pietre miliari lungo il percorso di sviluppo.

La validazione culturale è l’elemento che garantisce che ogni applicazione digitale rispetti contesti, valori e bisogni locali. Nessun algoritmo dovrebbe essere rilasciato senza prima essere sottoposto a uno sguardo interculturale e interdisciplinare, da sociologi ad antropologi.

Ecco una sintesi operativa per mettere in moto la roadmap:

- Integrare audit e metriche di equità in ogni fase del progetto, non solo a chiusura

- Implementare revisioni periodiche dei modelli e dei dataset, anche con stakeholder esterni

- Costruire team compositi, formati da competenze tecniche e sociali

- Condurre validazioni sul campo, testando l’AI in contesti reali e culturalmente diversificati

Questa roadmap non è un percorso obbligato, ma una mappa attiva per chi vuole fare della lotta ai bias un cambiamento reale. Perché bias e intelligenza artificiale non sono destinati a restare insieme: possono essere separati, sconfitti, superati. Ma serve volontà, struttura, e un metodo rigoroso. Solo così la tecnologia potrà essere davvero giusta.

Domande frequenti sui bias nell’intelligenza artificiale

❓ Che cosa sono i bias nell’intelligenza artificiale e da dove nascono?

I bias nell’intelligenza artificiale sono distorsioni sistematiche che si manifestano nei risultati generati da un algoritmo. Derivano principalmente da dati sbilanciati, da errori nel processo di data labeling o da scelte errate nel design del modello. Quando l’input riflette pregiudizi umani o informazioni incomplete, anche l’output dell’AI ne sarà influenzato. Capire cosa sono i bias nei dati e riconoscere i pattern ricorrenti è il primo passo per mitigarli.

❓ Come è possibile misurare e mitigare i bias nei modelli AI?

La misurazione dei bias nei modelli AI si effettua tramite fairness metrics, auditing e test di accuratezza differenziale. Per ridurre l’impatto dei bias, esistono strumenti come AI Fairness 360, Fairlearn e dashboard no-code. Tecniche come il reweighting, il sample balancing o i filtri post-predizione rientrano tra le pratiche più efficaci per ottenere modelli più equi. È essenziale integrare queste strategie fin dalle prime fasi del progetto.

❓ Qual è l’impatto dei bias AI nel settore sanitario e finanziario?

Nei modelli clinici, i bias possono causare diagnosi errate o esclusioni ingiuste nei protocolli. Ad esempio, alcuni algoritmi ignorano dati provenienti da minoranze etniche, creando un problema di underrepresentation. Nel mondo finanziario, modelli di scoring predittivo possono penalizzare intere categorie demografiche, dando luogo a discriminazione creditizia. In entrambi i settori, i bias nei modelli AI hanno impatti diretti sulla vita delle persone.

❓ Cosa significa speciesist bias e perché è importante considerarlo?

Lo speciesist bias è una forma emergente di pregiudizio che discrimina tra esseri viventi, privilegiando l’umano e ignorando l’impatto sugli ecosistemi. Alcuni modelli AI generativi consumano grandi quantità di energia, contribuendo a fenomeni di inequità ambientale. Inoltre, l’addestramento su dataset antropocentrici può escludere la biodiversità come valore analitico. Considerare questo bias è un passo fondamentale per costruire un’intelligenza davvero sostenibile.

❓ In che modo la UX research aiuta a ridurre i bias nei progetti AI?

La UX research consente di identificare distorsioni percettive prima che entrino nel codice. L’utilizzo di strumenti come l’empathy mapping e la prototipazione inclusiva favorisce un design centrato sull’utente. Quando i test includono utenti reali con background diversificati, è più facile riconoscere e correggere i bias introdotti nei test utente. Questo approccio è cruciale nei progetti AI orientati all’impatto sociale.

❓ Quando serve un audit culturale nei progetti AI e come si conduce?

Un audit culturale è necessario quando un modello AI viene distribuito in contesti multietnici o internazionali. Serve a validare che il sistema non riproduca visioni eurocentriche o narrative dominanti. Il processo prevede una revisione di dataset, prompt e output, con il contributo di esperti socioculturali. L’obiettivo è assicurare che l’AI sia allineata eticamente e culturalmente responsabile.

❓ Quali strumenti no-code esistono per monitorare i bias anche in team non tecnici?

Oggi esistono diverse soluzioni no-code o low-code che permettono anche a team non tecnici di monitorare i bias nei modelli AI. Tra queste: D-BIAS Studio, Google Vertex Explainable AI e Microsoft Responsible AI Dashboard. Offrono interfacce visuali, moduli drag-and-drop e percorsi guidati per il monitoraggio attivo della fairness. Così l’etica diventa operativa, accessibile e replicabile.