Nel cuore pulsante di milioni di applicazioni web e sistemi distribuiti, esiste un motore silenzioso, inarrestabile, capace di accelerare ogni operazione e renderla quasi istantanea. Redis non è un semplice database: è una soluzione architetturale che ridefinisce le performance delle applicazioni moderne. Inizia tutto da un accesso alla memoria, diretto, strutturato e sorprendentemente veloce. Ed è proprio qui che si annida il segreto di una tecnologia che ha conquistato giganti come GitHub, Twitter, Pinterest, e intere infrastrutture cloud.

Visualizza un flusso di dati che attraversa la rete con la stessa fluidità con cui l’occhio umano percepisce un colore: nessuna attesa, nessun collo di bottiglia. Redis interviene esattamente lì dove ogni millisecondo conta, offrendo risposte in tempo reale, supportando caching, code di messaggi, sessioni utente, microservizi e perfino intelligenza artificiale. Capire come funziona Redis oggi non è solo un vantaggio per sviluppatori o DevOps: è un’esigenza per chiunque costruisca sistemi performanti e scalabili.

Questa guida nasce per mostrarti come usare Redis nel modo più efficiente, evitando le trappole comuni e sfruttando ogni sfumatura della sua architettura in-memory. Scoprirai come lavora il suo motore interno single-threaded, perché è in grado di battere in velocità qualsiasi sistema basato su dischi, e come modellare i dati attraverso strutture ottimizzate per l’accesso rapido. Nessuna teoria fine a sé stessa: ogni concetto è connesso a un’applicazione pratica, ogni riga è pensata per trasferire competenza reale.

Redis sarà trattato non come un software da installare, ma come uno strumento strategico da padroneggiare, utile per progetti di caching avanzato, gestione della memoria, persistenza e cloud integration. Dall’uso basilare alla progettazione di architetture fault-tolerant, ogni capitolo sarà un passo verso una comprensione profonda e concreta.

Ti accompagnerò in un percorso che unisce teoria e operatività, partendo da ciò che conta davvero: capire esattamente cosa fa Redis, come lo fa e soprattutto perché usarlo oggi è una delle scelte tecniche più intelligenti che puoi fare.

Cos’è Redis e perché è così veloce: architettura, dati in memoria e vantaggi reali

Capire cos’è Redis significa addentrarsi in una logica completamente diversa da quella a cui molti sono abituati quando pensano a un database. Non esiste un motore relazionale, né una base dati consultabile tramite query SQL tradizionali. Redis è un database NoSQL in-memory, progettato per archiviare e restituire informazioni in modo istantaneo, lavorando con una struttura key-value estremamente ottimizzata. La chiave rappresenta l’identificatore univoco, il valore è il dato associato. Ma dietro questa apparente semplicità, si cela un sistema straordinariamente efficiente, in grado di gestire dati complessi, relazioni dinamiche e operazioni simultanee con una precisione e una velocità che molti RDBMS non possono offrire nemmeno con indici ottimizzati.

Il segreto della sua velocità non risiede solo nella struttura, ma nella memorizzazione in RAM, che permette di ridurre i tempi di accesso a pochi microsecondi. Non c’è latenza legata al disco, non ci sono colli di bottiglia tipici delle architetture a scrittura fisica: tutto avviene in tempo reale. A differenza di altri database, Redis non deve cercare fisicamente dove si trova il dato, perché ce l’ha già pronto nella memoria volatile. Questa scelta progettuale consente una risposta pressoché immediata, rendendolo perfetto per applicazioni che richiedono performance elevate, come sistemi di caching, real-time analytics, messaggistica asincrona e gestione di sessioni.

Redis non è quindi semplicemente veloce: è costruito per esserlo. Il suo core è progettato per operare su un single-thread event loop, evitando la complessità e l’overhead della concorrenza tra thread. Tutte le operazioni sono serializzate, ma talmente rapide da non necessitare di parallelismo. Questo approccio riduce drasticamente gli errori legati a race condition e semplifica la gestione dello stato. Redis è, in sintesi, un real-time database che ha trasformato l’efficienza in una vera e propria architettura.

Struttura chiave-valore e funzionamento interno: Redis spiegato semplice

Il cuore pulsante di Redis è il suo modello key-value, ma limitarlo a una mappa semplice sarebbe un errore concettuale. Ogni valore può rappresentare una struttura dati evoluta, come liste, hash, set, set ordinati, bitmap, hyperloglog, stream, JSON e persino vettori per AI. Questo significa che, dietro una singola chiave, si nasconde una capacità di rappresentazione che va ben oltre il concetto classico di “dato semplice”. È possibile, ad esempio, associare a una chiave un array dinamico di eventi, un contatore distribuito o un oggetto JSON annidato. Questa flessibilità permette di modellare direttamente in memoria logiche che altrimenti richiederebbero livelli intermedi di trasformazione nei database tradizionali.

Il funzionamento interno di Redis è pensato per minimizzare ogni costo computazionale. Tutto avviene in memoria RAM, e ogni operazione, dalla lettura alla scrittura, è gestita tramite un loop a evento singolo, che processa le richieste in ordine, senza attese. Questo meccanismo single-threaded garantisce una prevedibilità nei tempi di risposta che è fondamentale in contesti critici come le applicazioni real-time. Redis non blocca mai il thread: se una richiesta è lenta, viene scartata o gestita tramite pattern applicativi che ne prevengono la saturazione. Inoltre, le operazioni sono atomiche, cioè non possono essere interrotte da altri comandi, e questo elimina alla radice una vasta classe di problemi di concorrenza.

Un’altra caratteristica poco compresa ma fondamentale è il modo in cui Redis gestisce lo spazio. Ogni tipo di dato ha un encoding specifico che si adatta alla quantità e alla complessità dei valori. Ad esempio, una lista con pochi elementi viene rappresentata con ziplist, mentre una più ampia passa a linkedlist. Questo adattamento automatico migliora l’efficienza, senza necessità di configurazione da parte dello sviluppatore. Redis è, in questo senso, intelligente per default: ottimizza, evolve e risponde in tempo reale alle esigenze dell’applicazione che lo utilizza.

La potenza in-memory di Redis diventa ancora più chiara se osservata visivamente: l’immagine seguente mostra come i dati viaggiano dalla RAM al cuore pulsante del database, garantendo performance immediate.

Redis caching: il segreto delle performance in tempo reale

Il caching è la dimensione in cui Redis ha costruito gran parte della sua reputazione, ma ridurlo a “un sistema di cache” sarebbe impreciso. Redis è la piattaforma di caching per eccellenza, non solo perché è veloce, ma perché è progettato per mantenere i dati più rilevanti vicini all’elaborazione.

Questo significa che può memorizzare risposte a interrogazioni frequenti, risultati di calcoli costosi o persino snapshot di oggetti temporanei, rendendo inutile la reiterazione di processi complessi. Ma la vera forza di Redis come cache è il suo controllo sul tempo di vita dei dati. Ogni chiave può avere un TTL (Time To Live) definito con precisione, e il motore stesso si occupa di eliminarla una volta scaduta, liberando memoria in modo automatico e senza interventi esterni.

La politica di espulsione dei dati, regolabile tramite diverse strategie come LRU (Least Recently Used) o LFU (Least Frequently Used), permette di adattare Redis a scenari diversi. In sistemi che gestiscono milioni di utenti, o applicazioni ad alta concorrenza, poter definire in modo predittivo quali dati mantenere e quali rimuovere è cruciale per garantire reattività.

Redis eccelle in questo, perché ogni operazione di cache non è un’aggiunta, ma una parte nativa del sistema. Inoltre, grazie alla sua architettura single-threaded, la latenza resta minima anche sotto carico, e questo lo rende perfetto per use-case mission-critical.

Le configurazioni avanzate di caching includono modalità write-through, cache-aside e write-behind, che consentono a Redis di integrarsi perfettamente con database persistenti. In questi casi, Redis diventa un ponte tra performance e durabilità, gestendo i dati “caldi” mentre delega la storicizzazione a sistemi più lenti ma più capienti. In ambienti distribuiti, Redis può operare in cluster o replicare i dati in nodi secondari, garantendo continuità anche in caso di fault.

In breve, il redis caching non è solo una tecnica, ma un ecosistema di strategie, policy e ottimizzazioni che trasformano l’architettura applicativa, rendendola più rapida, leggera e affidabile.

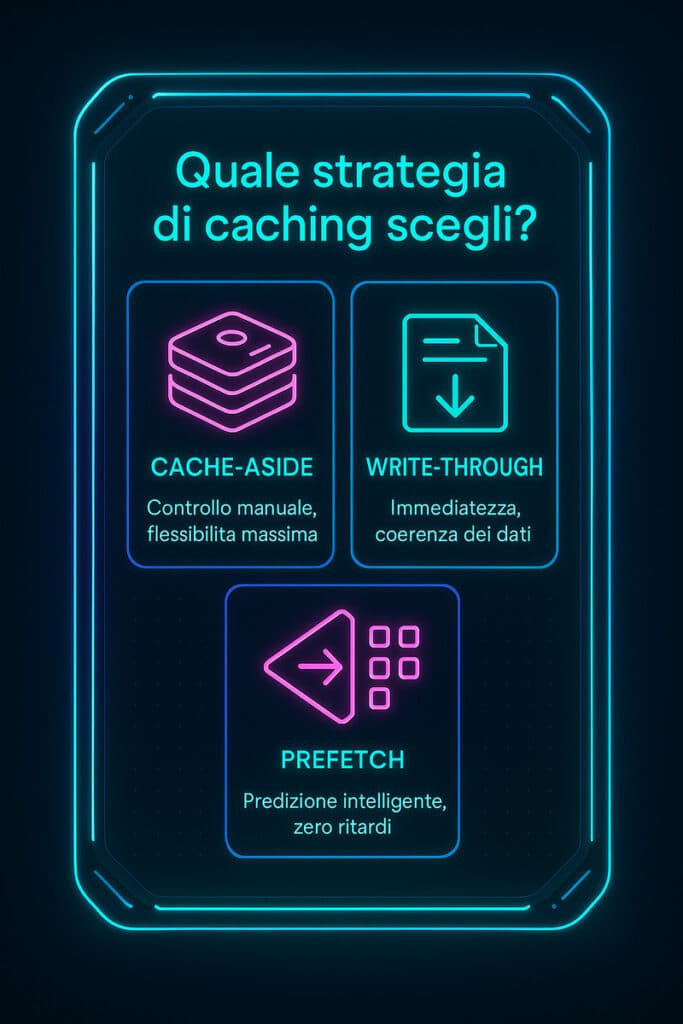

Per visualizzare in modo chiaro le differenze tra le principali strategie di caching supportate da Redis, consulta l’infografica seguente:

Strategie avanzate di caching con Redis: dal cache-aside al write-through

Comprendere le strategie avanzate di caching con Redis significa entrare nel vivo di come un sistema ad alta velocità può diventare non solo più veloce, ma anche più intelligente e prevedibile. Il caching, di per sé, è un concetto semplice: memorizzare temporaneamente dati per ridurre l’accesso a fonti più lente.

Tuttavia, con Redis, questo principio può essere declinato in una varietà di pattern architetturali capaci di adattarsi a qualsiasi scenario applicativo, dall’e-commerce alle API, dai microservizi fino ai sistemi in tempo reale. È qui che entrano in gioco modelli come cache-aside, write-through, write-behind e prefetching predittivo, ognuno con vantaggi, limiti e logiche operative differenti.

Redis caching si distingue perché non impone uno schema unico: offre invece gli strumenti per scegliere e modellare la logica più adatta alla propria infrastruttura. La scelta del pattern corretto non incide solo sulle performance, ma anche sulla coerenza dei dati, sull’uso della memoria e sulla resilienza del sistema.

Per questo non è sufficiente sapere cosa fa ogni strategia, ma quando applicarla, come combinarla e quali conseguenze genera a livello di latenza, throughput e footprint. Redis, grazie alla sua flessibilità architetturale e alla gestione nativa del TTL, consente di orchestrare queste strategie con precisione chirurgica, garantendo tempi di risposta millisecondici anche sotto carichi intensi.

Ogni modello di caching avanzato con Redis richiede una configurazione mentale e tecnica diversa. Non si tratta solo di implementare codice, ma di pensare caching come una strategia di progettazione. Redis non è passivo: è proattivo, osserva i pattern di accesso, reagisce agli eventi e può essere configurato per anticipare le esigenze applicative.

La vera differenza non la fa la velocità del singolo comando, ma la coerenza e l’ottimizzazione della strategia nel suo complesso. In questo capitolo, analizziamo in dettaglio i modelli più efficaci, i loro scenari d’uso e ciò che li rende imprescindibili in architetture moderne.

Cache-aside, write-through e prefetch: scenari, pro e contro

Il modello cache-aside è probabilmente il più noto e utilizzato. In questo schema, l’applicazione è responsabile della gestione della cache: prima tenta di leggere da Redis e, se il dato non è presente, lo recupera dal database di origine, aggiornando poi Redis manualmente. Questo pattern è semplice, efficiente e permette di avere un controllo totale sui flussi, ma espone il sistema a potenziali race condition in ambienti concorrenti. Inoltre, se non gestito correttamente, può generare latenze aggiuntive in caso di cache miss frequenti.

Diversamente, il write-through caching cambia l’approccio: ogni scrittura avviene prima in Redis e poi viene propagata al sistema di origine. Questo modello assicura che la cache sia sempre aggiornata, riducendo il rischio di incoerenza. Tuttavia, può introdurre overhead nei tempi di scrittura e, se l’origine non risponde correttamente, si rischia di propagare errori o dati parziali. Il vantaggio maggiore sta nella coerenza forte e nella semplificazione del codice lato lettura.

Il terzo approccio, meno diffuso ma estremamente potente in sistemi predittivi, è il prefetch caching. In questo caso, il sistema carica preventivamente in cache i dati che si presume saranno richiesti. Il prefetch si basa su logiche analitiche o pattern di accesso storici, e può ridurre drasticamente il tempo medio di risposta, soprattutto in applicazioni con traffico prevedibile o ciclico. Tuttavia, la sua efficacia dipende totalmente dalla bontà del modello predittivo. Quando il prefetch fallisce, si ha uno spreco di memoria e CPU.

La differenza tra queste strategie non è solo teorica, ma profonda e concreta. Ogni scenario applicativo — dalle API ad alta frequenza agli eventi asincroni, dagli user profile alle pagine prodotto — richiede di bilanciare performance, coerenza e complessità. Redis permette di orchestrare queste scelte con strumenti potenti, ma è compito dell’architetto saper leggere il contesto e rispondere con il pattern più adatto.

Implementare caching intelligente: modelli ibridi e ottimizzati

Nel mondo reale, le applicazioni raramente funzionano secondo uno schema unico. Ecco perché i modelli ibridi di caching stanno diventando la norma: combinazioni dinamiche tra cache-aside e write-through, integrazione con logiche TTL, fallback su sistemi secondari, gestione predittiva con prefetch condizionale. Redis si presta perfettamente a questa complessità, offrendo sia la struttura dati, sia il comportamento operativo per adattarsi a configurazioni complesse senza sacrificare prestazioni.

Un esempio concreto: in un sistema e-commerce ad alta concorrenza, potresti usare un pattern write-through per il carrello dell’utente — dove la coerenza è critica — e un pattern cache-aside per il catalogo dei prodotti, dove un dato leggermente obsoleto è accettabile ma la reattività è fondamentale. Redis ti permette di differenziare TTL, policy di espulsione, fallback verso il database primario e perfino regole su base chiave o tipo di contenuto.

Le ottimizzazioni non si fermano al pattern: Redis consente di definire politiche LFU, LRU, allkeys-random, o ancora di applicare script Lua per logiche di caching condizionale. Queste tecniche possono ridurre drasticamente l’uso di memoria, migliorare l’accuratezza del caching e rendere il sistema più stabile anche sotto carico. La combinazione tra logiche predittive e metriche di accesso real-time consente di evolvere da un caching statico a un caching adattivo, in grado di modificarsi nel tempo in funzione dell’uso.

Il caching intelligente non è un’opzione per sistemi ad alta intensità di dati: è una necessità. Redis ti dà gli strumenti, ma è la strategia — costruita su misura, testata e adattata — che fa la differenza tra un’app veloce e una che scala davvero. E in quel confine tra ottimizzazione e architettura si gioca la sfida delle prestazioni moderne.

Caching Client-Side con Redis: un boost intelligente alla performance

La gestione avanzata del caching non si esaurisce nella logica server-side. In scenari complessi, dove la latenza anche minima può compromettere l’esperienza utente, si apre la possibilità di sfruttare Redis come motore di caching client-side. Questa funzione, poco conosciuta e spesso sottoutilizzata, permette di memorizzare nella memoria del client le risposte ottenute da Redis, alleggerendo ulteriormente la rete e migliorando drasticamente la velocità percepita. Si tratta di un approccio che va oltre la cache centralizzata, perché permette a ogni client — come un microservizio, un’applicazione web o un worker asincrono — di gestire porzioni di dati in locale, riducendo la dipendenza da interrogazioni ripetute.

Questa strategia viene resa possibile da una modalità specifica nota come Redis server-assisted caching, introdotta per risolvere una delle sfide storiche del caching distribuito: mantenere la cache coerente anche quando è parzialmente decentralizzata. Redis, in questo contesto, non funge solo da archivio temporaneo, ma diventa anche orchestratore della coerenza, notificando i client registrati ogni volta che un dato cambia. Questo meccanismo riduce il rischio di inconsistenza tra le copie locali e quelle centrali, migliorando al tempo stesso performance e affidabilità.

Redis caching lato client diventa quindi una strategia intelligente nei contesti in cui i client hanno capacità di elaborazione autonoma e dove i pattern di accesso sono altamente ripetitivi. È qui che l’architettura Redis si distingue, offrendo strumenti nativi, senza bisogno di layer aggiuntivi. Con questa triade entriamo nel vivo di un approccio che cambia le regole del gioco e rende possibile uno scaling realmente intelligente.

Redis server-assisted caching: come funziona realmente

Il funzionamento del Redis server-assisted caching si basa su un concetto chiave: permettere ai client di memorizzare in locale dati recuperati da Redis, mantenendo però un legame diretto con il server che li ha generati. Questo è possibile grazie a un meccanismo di registrazione automatica delle chiavi lette, che attiva un sistema di invalidazione o aggiornamento controllato lato server. Redis traccia quali client hanno richiesto quali chiavi e, in caso di modifica, invia notifiche push per aggiornare o invalidare le copie locali. È un salto concettuale importante, perché trasforma Redis da semplice store passivo a gestore attivo della coerenza cache.

Questa funzionalità è progettata per operare in ambienti dove la riduzione della latenza è essenziale. L’accesso ai dati avviene prima localmente, e solo in caso di cache miss o invalidazione si ricorre al Redis server. Questo significa che, in condizioni ottimali, il client non ha bisogno di interrogare il server per ogni richiesta, riducendo traffico, carico e tempi di attesa. Inoltre, l’intero processo è gestito con overhead minimo: Redis utilizza dati binari altamente compressi per comunicare gli eventi di cambiamento, e i client supportati ricevono queste notifiche in modo asincrono.

Dal punto di vista implementativo, i client devono supportare la modalità CLIENT TRACKING, che consente al server di associare ID univoci e notificare le variazioni. Alcuni linguaggi, come Python e Node.js, hanno già librerie compatibili con questo modello. La cosa più importante, tuttavia, è il controllo che Redis offre su questi meccanismi. È possibile definire scope, TTL e policy di aggiornamento, garantendo così che la coerenza non venga mai sacrificata per la velocità, ma ottimizzata per entrambi.

Il caching client-side con assistenza del server è, oggi, uno dei modi più intelligenti per ridurre latenza senza compromettere la coerenza. Redis lo rende possibile nativamente, senza plugin, e con una granularità di controllo che pochi altri sistemi possono offrire.

Il seguente schema evidenzia come Redis gestisce la coerenza tra client e server nel caching distribuito con latenza ultra ridotta:

Il seguente schema evidenzia come Redis gestisce la coerenza tra client e server nel caching distribuito con latenza ultra ridotta:

Quando usare il caching client-side e perché migliora la scalabilità

Adottare il caching client-side in Redis non è sempre necessario, ma può fare la differenza nei contesti ad alta densità di accesso e con pattern di lettura ripetitiva. Applicazioni web che caricano dati simili per ogni utente, microservizi che accedono costantemente agli stessi riferimenti, sistemi real-time che elaborano dati pubblicati ciclicamente: in questi scenari, delegare parte del carico al client rappresenta una strategia ad alta efficienza. Redis, grazie al suo modello di caching near-application, permette di ridurre la distanza tra dato e logica di elaborazione, con effetti tangibili su throughput e consumo di banda.

Questo tipo di caching diventa particolarmente utile quando la rete è il collo di bottiglia. In applicazioni distribuite su cloud, dove le latenze tra nodi sono inevitabili, poter risolvere una richiesta interamente in locale senza transitare dalla rete è un vantaggio competitivo. La scalabilità si ottiene così non solo moltiplicando le risorse server, ma distribuendo l’intelligenza della cache su ogni nodo dell’ecosistema. Il risultato è una riduzione del numero di richieste verso il Redis server, che diventa più stabile, meno stressato, e quindi in grado di gestire più operazioni critiche in parallelo.

La scelta di usare caching client-side va però ponderata. Se i dati sono altamente volatili o critici, la cache locale rischia di fornire contenuti obsoleti. In questi casi, Redis offre strumenti per gestire invalidazioni precise, o per disabilitare del tutto la replica client-side su specifici dataset. Il vero potenziale emerge quando si unisce caching locale, notifiche server-assistite e TTL controllato. Così si crea un sistema in grado di adattarsi dinamicamente all’utilizzo, mantenendo coerenza senza compromettere la velocità.

Il caching client-side con Redis è quindi una strategia scalabile, flessibile e intelligente, che consente di migliorare drasticamente la reattività senza dover riscrivere l’intera architettura. È la risposta moderna a un’esigenza antica: portare i dati più vicini a chi li usa, nel modo più veloce possibile.

Novità e funzionalità avanzate: cosa rende Redis 8 e Enterprise così potenti

Il percorso evolutivo di Redis non si è mai limitato a un miglioramento incrementale delle performance. Con il rilascio della versione 8 e con le ultime iterazioni di Redis Enterprise, il salto qualitativo è stato netto: non solo maggiore velocità, ma un ripensamento architetturale profondo, orientato all’affidabilità, alla scalabilità e al controllo intelligente dei dati. Redis oggi non è più solo un database in-memory veloce: è una piattaforma che combina flessibilità di utilizzo, modularità e potenza computazionale. La vera trasformazione si manifesta nella capacità di Redis di offrire strumenti che non agiscono in superficie, ma entrano nel cuore delle operazioni più delicate: quelle che riguardano la latenza, la gestione delle risorse e la continuità di servizio.

Redis 8 introduce un set di funzionalità che riscrivono il concetto stesso di ottimizzazione, rendendo il motore interno non solo più performante, ma anche più intelligente. Il focus non è solo sulla velocità assoluta, ma sulla prevedibilità del comportamento sotto carico, sulla capacità di rispondere a picchi improvvisi e sull’agilità nel gestire migliaia di operazioni simultanee. Allo stesso tempo, Redis Enterprise completa il quadro aggiungendo caratteristiche fondamentali per ambienti mission-critical: gestione rack-aware, logging diagnostico avanzato, configurazioni multi-nodo e failover automatici. Insieme, queste due anime rappresentano la declinazione moderna di un motore che è passato da tool ad architettura.

Capire cosa rende Redis 8 e Enterprise così potenti significa quindi spostare lo sguardo dal semplice throughput alla qualità sistemica dell’intero stack, riconoscendo il ruolo strategico di un motore ottimizzato non solo per la velocità, ma per la sopravvivenza sotto stress.

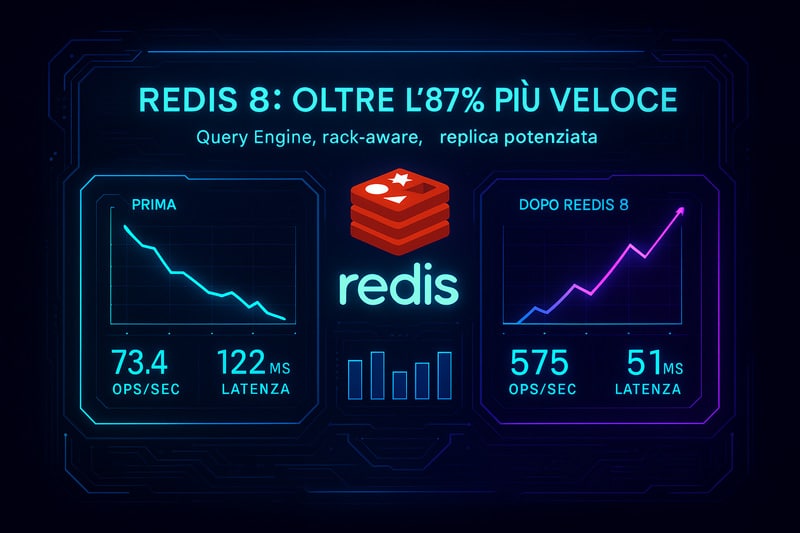

Redis 8 e il motore di query: oltre l’87% di miglioramento nelle operazioni

Il cuore dell’evoluzione tecnica in Redis 8 è rappresentato dal nuovo motore di query, una componente riscritta per ottimizzare l’esecuzione delle operazioni più comuni e al tempo stesso abilitare nuovi scenari d’uso. Non si tratta di un semplice refactoring, ma di un cambio radicale dell’algoritmo di gestione delle istruzioni, progettato per sfruttare al massimo le caratteristiche dell’elaborazione in-memory. I benchmark ufficiali dimostrano un incremento di oltre l’87% nelle operazioni critiche, con particolare impatto su comandi complessi e flussi di dati ad alta frequenza.

A rendere possibile questo salto è una combinazione tra ottimizzazioni al parsing interno, migliore gestione delle strutture dati e utilizzo selettivo della compressione. Il motore di Redis 8 non esegue più ogni comando in modo uniforme, ma è capace di auto-determinare il percorso più efficiente in base alla tipologia del dato e alla storia dell’interazione. Questo comportamento adattivo trasforma Redis in un layer più consapevole del carico, in grado di reagire dinamicamente e di mantenere latenza costante anche quando il numero di richieste si moltiplica.

Un altro punto di svolta è la gestione del throughput nel contesto multi-core. Sebbene Redis resti single-threaded per natura, Redis 8 introduce il supporto nativo alla parallelizzazione selettiva di operazioni non bloccanti, permettendo una migliore distribuzione del carico in ambienti containerizzati e orchestrati. Questo consente di ottenere prestazioni superiori senza modificare l’architettura logica delle applicazioni, ma sfruttando direttamente le ottimizzazioni presenti nel motore.

Il risultato è una piattaforma che non solo esegue comandi più rapidamente, ma li gestisce in modo più intelligente, anticipando i colli di bottiglia e ottimizzando la risposta. Redis 8 non è semplicemente più veloce: è più consapevole, reattivo, e costruito per scalare senza perdere controllo.

La seguente dashboard visuale mostra i vantaggi prestazionali concreti introdotti da Redis 8, con focus sul nuovo motore di query e l’efficienza sotto carico.

Redis Enterprise e architettura rack-aware: logging, replica e failover

Nel momento in cui Redis viene adottato in ambienti enterprise, entrano in gioco esigenze diverse rispetto a quelle tipiche dello sviluppo standalone: alta disponibilità, affidabilità predittiva, visibilità operativa. Redis Enterprise risponde a queste esigenze con una serie di funzionalità architetturali avanzate, pensate per garantire non solo prestazioni, ma resilienza e continuità anche in contesti distribuiti e fortemente dinamici.

Uno degli elementi distintivi più importanti è la consapevolezza rack-aware, una capacità che consente al sistema di conoscere la topologia fisica e logica dell’infrastruttura in cui opera. Redis Enterprise può quindi distribuire le repliche su nodi posizionati in rack diversi, evitando che una singola interruzione fisica possa compromettere il cluster. Questo approccio porta con sé un incremento tangibile della disponibilità, poiché anche in caso di guasto hardware o disservizio locale, il sistema può eseguire un failover istantaneo, mantenendo l’operatività senza soluzione di continuità.

Altro pilastro dell’architettura enterprise è il sistema di logging diagnostico potenziato, capace di raccogliere dati granulari sul comportamento del database, sull’uso della memoria, sui pattern di accesso e sui tempi di risposta per ogni singolo comando. Questi log non servono solo al monitoraggio, ma diventano una vera e propria fonte di analisi predittiva, utile per il tuning automatico e la prevenzione proattiva di problemi.

Infine, Redis Enterprise introduce un meccanismo di replica avanzato, in grado di sincronizzare dati in tempo reale su più istanze con una granularità che va oltre la semplice ridondanza. Le repliche possono essere configurate per operare in modalità attiva o passiva, su regioni geografiche differenti, garantendo così una vera business continuity, anche in scenari di failover multi-datacenter.

Con Redis Enterprise, non si parla più solo di performance, ma di infrastruttura intelligente, che capisce dove si trova, come si comporta e cosa serve per continuare a funzionare senza interruzioni. È questa visione ad aver portato Redis oltre il concetto di database veloce, facendolo evolvere in motore di resilienza distribuita.

Ottimizzare la memoria in Redis: best practice che fanno la differenza

Quando si parla di come funziona Redis, spesso si sottovaluta il ruolo strategico della gestione della memoria, che rappresenta invece uno dei pilastri tecnici più delicati. Redis non si limita a offrire prestazioni eccezionali per il semplice fatto di operare in RAM. Il vero vantaggio sta nella capacità di controllare con precisione cosa viene mantenuto in memoria, per quanto tempo e secondo quali criteri viene rimosso. In un ambiente dove ogni byte conta, soprattutto in scenari distribuiti o ad alta concorrenza, ogni scelta architetturale sul caching ha conseguenze dirette sull’efficienza complessiva del sistema.

La memoria, in Redis, non è uno spazio passivo: è un ambiente dinamico, gestito da politiche di espulsione e da logiche adattive che consentono di scalare senza incorrere in saturazione o degrado delle performance. Il comportamento di Redis in condizioni di memoria piena può essere completamente configurato, definendo se e quando espellere dati, su quali criteri, e con che priorità. È qui che entrano in gioco meccanismi come LRU, LFU, TTL e limitazioni configurabili tramite parametri come maxmemory. Senza una comprensione chiara di queste dinamiche, anche il sistema più veloce può diventare instabile, inefficiente o addirittura pericoloso dal punto di vista della consistenza dei dati.

Ottimizzare la memoria in Redis non significa solo ridurre l’uso di RAM. Significa aumentare la prevedibilità del comportamento del sistema, migliorare l’efficienza dei pattern di accesso e garantire una risposta stabile anche sotto pressione. In questa triade analizzeremo le politiche di espulsione e la scelta dei tipi di dato, due leve fondamentali per controllare a fondo ogni byte allocato.

LRU, LFU, TTL: le politiche di espulsione in Redis

La vera forza di Redis nel gestire carichi elevati e dataset volatili sta nella capacità di decidere con precisione quali dati mantenere in memoria e quali rimuovere, in modo dinamico. Quando lo spazio disponibile si avvicina al limite, Redis attiva le sue politiche di espulsione, configurabili tramite il parametro maxmemory-policy. Le tre principali sono LRU (Least Recently Used), LFU (Least Frequently Used) e la gestione tramite TTL (Time To Live).

Con LRU, Redis espelle gli elementi meno recentemente utilizzati. Questa è una strategia efficace in scenari dove i dati hanno un utilizzo ciclico o sono consultati a intervalli regolari. LFU, invece, si basa sulla frequenza di accesso: vengono rimossi i dati utilizzati meno frequentemente, anche se recenti. Questo approccio è particolarmente utile in sistemi dove certi dati sono molto popolari e altri marginali. Infine, TTL consente di definire una scadenza temporale per ogni chiave, dopo la quale Redis la elimina automaticamente. Questa strategia è fondamentale per gestire dati temporanei, come sessioni utente o token di autenticazione.

Le policy possono essere usate anche in combinazione, e Redis permette di scegliere tra modalità come volatile-lru, allkeys-lru, volatile-ttl, allkeys-random o noeviction, a seconda delle esigenze del sistema. L’efficacia dell’espulsione dipende dalla configurazione del parametro maxmemory, che definisce la soglia oltre la quale il sistema attiva la policy scelta. In ambienti mission-critical, la scelta sbagliata può portare a un comportamento imprevedibile: ad esempio, con noeviction, ogni nuova scrittura dopo il limite viene rifiutata, causando errori applicativi.

Conoscere e configurare correttamente queste strategie è ciò che separa un’implementazione improvvisata da un’architettura realmente ottimizzata. Redis non impone regole rigide, ma fornisce gli strumenti per gestire la memoria in modo reattivo, coerente e adattivo. Chi padroneggia queste leve ha il controllo completo delle prestazioni sotto carico.

La piramide che segue sintetizza visivamente le principali politiche di gestione della memoria utilizzate da Redis per mantenere performance costanti anche in condizioni critiche.

Tipi di dato e uso efficiente della memoria: hash, set, stringhe, JSON

Una delle caratteristiche meno visibili, ma più determinanti in termini di efficienza, è la capacità di Redis di ottimizzare automaticamente l’allocazione della memoria in base al tipo e alla struttura dei dati memorizzati. Redis non tratta ogni chiave come un semplice valore: ogni chiave può contenere strutture complesse come hash, set, liste, stringhe compresse o oggetti JSON. Ognuna di queste entità ha un encoding interno che varia dinamicamente, in funzione della quantità e della complessità dei dati contenuti.

Ad esempio, un hash con pochi campi viene gestito con un encoding compatto chiamato ziplist, che riduce l’overhead di memoria. Solo quando la struttura cresce oltre una certa soglia, Redis la converte automaticamente in hashtable, più flessibile ma anche più pesante. Analogamente, le liste iniziano come ziplist e si trasformano in quicklist in presenza di molti elementi. Questo comportamento adattivo permette di ottenere prestazioni elevate senza sacrificare la leggibilità del dato o la semplicità dell’accesso.

L’uso corretto dei tipi di dato non è solo una questione sintattica: incide direttamente sulla footprint della memoria. Utilizzare set per dati univoci, hash per oggetti strutturati o stringhe per chiavi semplici può ridurre sensibilmente l’uso di RAM e migliorare le performance di scansione e accesso. L’introduzione del supporto nativo a JSON e vettori ha inoltre aperto la strada a nuove modalità di rappresentazione compatta per dati semi-strutturati, come configurazioni, payload API o dataset per AI.

Saper scegliere il tipo di dato giusto è un atto progettuale, non un dettaglio. Redis fornisce un linguaggio potente per modellare la realtà in memoria, ma sta allo sviluppatore usarlo con precisione. Ottimizzare non significa fare compromessi: significa estrarre il massimo da ogni bit disponibile e costruire sistemi capaci di sostenere il carico reale senza degradare.

Persistenza dei dati in Redis: AOF, snapshotting e strategie ibride

Chi utilizza Redis in ambienti produttivi o critici sa che la velocità, da sola, non basta. In un sistema che opera interamente in memoria, la persistenza dei dati rappresenta un elemento fondamentale per garantire sicurezza, continuità e affidabilità. Redis è progettato per lavorare in tempo reale, ma dispone di meccanismi sofisticati per salvare le informazioni su disco, sia in modalità asincrona che sincrona, riducendo al minimo il rischio di perdita dati anche in caso di crash o riavvio forzato.

I due approcci principali offerti da Redis per la persistenza sono il RDB (Redis Database Snapshot) e l’AOF (Append Only File). Ognuno ha peculiarità, vantaggi e compromessi ben definiti. Il primo si basa su salvataggi periodici dell’intero contenuto del database, mentre il secondo registra ogni operazione di scrittura in ordine cronologico, rendendo possibile la ricostruzione dello stato esatto in qualsiasi momento. A questi due si aggiunge una terza via: la persistenza ibrida, che combina i benefici di entrambi, minimizzando il rischio e ottimizzando le performance.

Capire come funziona ciascun meccanismo, e in quali contesti è preferibile, non è un’opzione: è una responsabilità architetturale. La scelta sbagliata può comportare perdita irreversibile di dati, latenza imprevista o consumi anomali di disco. Redis non fornisce solo strumenti: offre logica operativa avanzata per orchestrare la durabilità dei dati con la stessa precisione con cui gestisce la RAM. In questa triade entriamo nel nucleo della persistenza, confrontando le opzioni disponibili e indicando le configurazioni realmente affidabili.

Differenze tra RDB e AOF: vantaggi, rischi e performance

La modalità RDB crea snapshot periodici dell’intero contenuto del database Redis e li salva su disco in formato binario. Questo approccio è estremamente efficiente in termini di uso delle risorse, poiché l’operazione viene eseguita da un processo figlio, senza bloccare l’elaborazione principale. Tuttavia, il principale limite risiede nella sua granularità: tra uno snapshot e l’altro possono passare secondi o minuti, e in caso di crash improvviso tutti i dati non ancora salvati andrebbero persi.

Dall’altra parte, l’AOF registra ogni comando di scrittura ricevuto da Redis in un file di log append-only. Questo significa che, al riavvio, il database può ricostruire il proprio stato eseguendo nuovamente tutte le istruzioni registrate. L’AOF garantisce quindi una persistenza quasi in tempo reale, e consente una maggiore precisione nella ricostruzione dello stato, ma al costo di un maggiore utilizzo di spazio su disco e una maggiore latenza in fase di ripristino.

La differenza concettuale tra i due approcci è profonda: RDB è orientato alla snapshot rapida, AOF alla durabilità continua. RDB è più adatto a sistemi in cui i dati possono essere ricostruiti facilmente in caso di perdita parziale, come cache o analisi temporanee. AOF, invece, è la scelta obbligata in contesti dove ogni modifica è critica e non può essere persa. Redis consente anche la compressione dell’AOF, per evitare che il file cresca indefinitamente, mantenendo alta l’efficienza anche nel lungo periodo.

Il compromesso fra velocità, affidabilità e footprint si risolve nella scelta tra eventualità e precisione, tra prestazioni immediate e conservazione dello storico. Ma Redis non obbliga a decidere: offre, come vedremo, una soluzione ibrida capace di conciliare entrambe le necessità in un’unica strategia coesa.

Il diagramma seguente chiarisce visivamente le differenze e le sinergie tra i due metodi di persistenza dati adottati da Redis: RDB e AOF.

Strategie ibride e backup sicuri: salvare dati senza perdere performance

L’approccio ibrido alla persistenza nasce dalla consapevolezza che nessuna delle due modalità – RDB o AOF – è perfetta da sola. Redis consente di attivare entrambe contemporaneamente, sfruttando i vantaggi di ciascuna per ottenere una strategia di backup solida, coerente e reattiva. In questo modello, i dati vengono salvati sia come snapshot periodici (RDB), sia come log incrementali in tempo reale (AOF). Al riavvio, Redis utilizza per default il file AOF, ma può essere configurato per valutare quale delle due fonti sia più aggiornata, garantendo sempre il ripristino più completo.

L’uso combinato riduce il rischio di perdita, aumenta la resilienza e permette di accelerare la fase di bootstrap del sistema. Durante il funzionamento, Redis può anche effettuare il cosiddetto AOF rewrite: una procedura che riscrive il file di log in modo più compatto, eliminando le ridondanze e mantenendo l’efficienza anche nei sistemi attivi da mesi o anni. Questo processo, eseguito in background, evita blocchi o rallentamenti, rendendo la gestione della persistenza totalmente trasparente e non invasiva.

La configurazione ibrida può inoltre essere accompagnata da strategie di backup esterne: script di dump automatici, sincronizzazione con S3, montaggio di volumi persistenti in ambienti containerizzati, o utilizzo di Redis Enterprise per il failover distribuito multi-zona. Il punto non è solo evitare la perdita dei dati, ma assicurarsi che il dato sia sempre recuperabile nel minor tempo possibile, anche in condizioni di carico estremo o in caso di interruzioni di alimentazione o rete.

La vera ottimizzazione, in Redis, non è solo nella velocità, ma nella capacità di mantenere affidabilità senza sacrificare le prestazioni. Le strategie ibride rappresentano l’espressione più matura di questa filosofia: un equilibrio scientifico tra scrittura efficiente, lettura istantanea e ripristino garantito.

Licenze e Fork: perché è nato Valkey e cosa cambia per gli sviluppatori

Per anni, Redis ha rappresentato uno degli esempi più solidi e apprezzati di software open source nel panorama infrastrutturale moderno. Le sue prestazioni, la semplicità d’uso e l’estrema adattabilità lo hanno reso uno standard de facto per il caching e la gestione di dati in tempo reale. Ma negli ultimi tempi, accanto al suo nome, è comparso con crescente frequenza un altro: Valkey. Dietro questa apparente biforcazione si cela un cambio profondo, che non riguarda soltanto il codice, ma la filosofia stessa con cui Redis è distribuito e mantenuto.

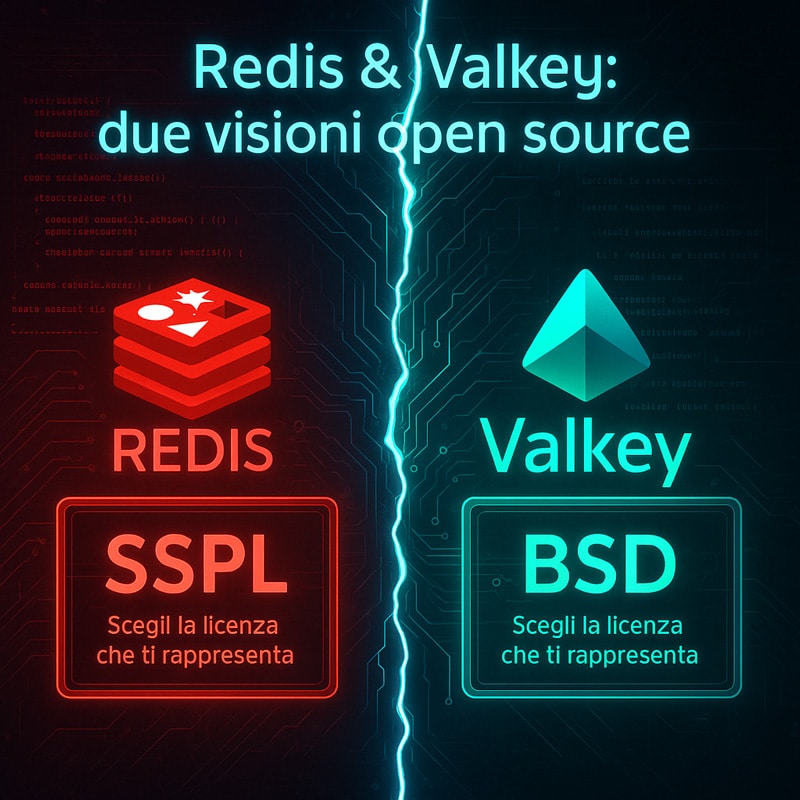

La transizione della licenza di Redis dal modello BSD a una combinazione che include SSPL, RSAL e AGPL ha generato un dibattito ampio e tuttora aperto nel mondo dello sviluppo. L’obiettivo dichiarato era quello di proteggere la sostenibilità commerciale del progetto, ma la conseguenza diretta è stata un allontanamento dal modello open source puro. Questa svolta ha portato parte della comunità a distaccarsi e a fondare Valkey, un fork ufficialmente sostenuto dalla Linux Foundation, che mantiene la licenza BSD originaria e si propone come alternativa completamente open.

Per chi sviluppa applicazioni, questi cambiamenti non sono neutri. La scelta della licenza incide sulla distribuzione, sull’adozione in contesti aziendali, sul supporto in ambienti cloud e sull’interoperabilità con altre tecnologie. Comprendere cosa significa utilizzare Redis oggi, rispetto a ieri, è cruciale per evitare complicazioni legali, violazioni involontarie di licenza o limitazioni future nell’evoluzione dei propri progetti. Le prossime sezioni entrano nel dettaglio di cosa è successo, perché è successo e soprattutto cosa comporta, tecnicamente e strategicamente, per chi usa Redis o Valkey in ambienti reali.

Da BSD a SSPL: la transizione di Redis e cosa significa per l’open source

La licenza BSD ha storicamente rappresentato uno dei pilastri dell’open source permissivo. Sotto questa formula, Redis era utilizzabile liberamente anche in contesti commerciali, compresi ambienti cloud e SaaS proprietari. Tuttavia, la crescente integrazione di Redis da parte di grandi provider cloud, spesso senza un ritorno economico verso lo sviluppo originale, ha spinto gli autori a una revisione del modello di licenza, motivata dalla necessità di tutelare il valore commerciale del progetto.

Con l’introduzione della RSAL (Redis Source Available License), Redis ha iniziato a limitare l’uso commerciale in alcune condizioni, mantenendo comunque accessibile il codice sorgente. Successivamente, per i moduli più avanzati e alcune distribuzioni, è stata adottata la controversa SSPL (Server Side Public License), una licenza che richiede la pubblicazione del codice dell’intera infrastruttura server-side in caso di utilizzo. In altri casi, è stata applicata la AGPL (Affero General Public License), nota per le sue clausole estensive di condivisione del codice anche in contesti cloud.

Questi cambiamenti hanno creato una frattura con la filosofia open source classica, in particolare con quella sostenuta dalla Free Software Foundation e da molti sviluppatori che vedono nella neutralità della licenza un valore irrinunciabile. Pur restando gratuito e accessibile per molti scenari, Redis ha perso lo status di “open source puro” secondo le definizioni ufficiali di OSI. Le ripercussioni vanno ben oltre la teoria: alcuni integratori e provider hanno dovuto rimuovere Redis dai propri stack per evitare problemi di compliance, altri hanno congelato gli aggiornamenti, generando frammentazione.

Il messaggio è chiaro: Redis non è più solo una tecnologia, ma un elemento strategico che porta con sé implicazioni legali e politiche. Ignorare la licenza oggi significa esporsi a rischi futuri. Ecco perché molti sviluppatori hanno iniziato a guardare a Valkey, che garantisce una continuità col passato, senza le nuove restrizioni.

La rappresentazione visiva seguente mostra con chiarezza la separazione tra Redis e Valkey, evidenziando il contrasto tra le due licenze e le loro implicazioni nel mondo open source.

Valkey: il fork open source che punta alla continuità

Il progetto Valkey nasce come risposta diretta alla transizione delle licenze di Redis. Sostenuto dalla Linux Foundation, questo fork si propone di preservare l’accesso libero, neutrale e pienamente open al codice Redis, garantendo agli sviluppatori un’alternativa che mantenga tutte le funzionalità essenziali, ma sotto una licenza BSD senza ambiguità. Il suo nome non è casuale: “Valkey” rappresenta la volontà di custodire la chiave del valore open source originario di Redis, contro il rischio di una deriva verso modelli chiusi o semi-commerciali.

Tecnicamente, Valkey è compatibile al 100% con Redis nelle sue funzionalità core. Supporta le stesse strutture di dati, gli stessi comandi, le stesse API client. Le modifiche iniziali si concentrano sull’allineamento del codice con una gestione aperta, trasparente e collaborativa. A differenza di Redis, però, Valkey non include i moduli commerciali sviluppati da Redis Inc., e il suo roadmap viene deciso dalla community, non da un’entità privata. Questo rende Valkey particolarmente adatto in contesti dove la neutralità del software è un requisito imprescindibile, come pubbliche amministrazioni, enti accademici, fondazioni no-profit o startup open-core.

L’obiettivo dichiarato di Valkey non è quello di competere in termini di marketing o monetizzazione, ma di offrire una piattaforma stabile, libera e sicura per chi vuole continuare a usare Redis come base dei propri sistemi senza restrizioni future. La sua adesione alla Linux Foundation garantisce continuità, trasparenza e affidabilità a lungo termine.

La comparsa di Valkey segna un punto di svolta importante. Per la prima volta, la community ha reagito attivamente a un cambio di licenza, scegliendo di difendere l’etica open source non solo con il dibattito, ma con il codice. Redis resta una tecnologia straordinaria, ma Valkey si candida a diventare il suo erede naturale nel mondo realmente libero del software.

Come usare Redis nel cloud: AWS ElastiCache, Google Memorystore, Azure

Quando si parla di Redis, non si può più limitarlo alla configurazione su server fisici o ambienti locali. Le moderne architetture distribuite si spingono verso il cloud, e Redis è pronto ad assecondare questa evoluzione con una versatilità nativa, una latency estremamente ridotta e una scalabilità orizzontale quasi immediata. Ma usare Redis nel cloud non significa semplicemente “spostarlo”: significa ripensarne la gestione, la sicurezza, l’alta disponibilità e l’automazione secondo le logiche di ciascuna piattaforma.

Amazon AWS, Google Cloud Platform e Microsoft Azure offrono Redis come servizio gestito, integrato nei propri ambienti IaaS e PaaS, pronto all’uso in pochi clic. Non è un dettaglio: questa modalità consente di eliminare tutta la complessità legata al provisioning, al monitoraggio, al failover e alla replica geografica. Ma ogni provider ha un modo diverso di esporre Redis, con caratteristiche specifiche in termini di costi, performance e configurazioni avanzate.

Questa sezione è dedicata a chi ha compreso cosa può fare Redis e ora vuole passare all’azione concreta, senza inciampare in errori di configurazione o in sottovalutazioni dei costi. Entreremo nel merito di ciascuna delle tre piattaforme principali, mostreremo come si implementa Redis nel cloud, quali vantaggi offre ciascun servizio, e soprattutto cosa considerare per evitare sorprese in ambienti di produzione reali.

Implementare Redis su AWS, Google Cloud e Azure: guida pratica

AWS ElastiCache for Redis è probabilmente l’opzione più utilizzata tra gli sviluppatori. Consente il deploy di istanze Redis in modalità cluster oppure standalone, con supporto completo per la replica multi-AZ, backup automatici, crittografia in transito e a riposo. Il provisioning avviene tramite console o CLI, con opzioni granulari su shard, read replica e parametri di sicurezza VPC. ElastiCache include anche metriche avanzate tramite CloudWatch, utili per monitorare il throughput, la latenza e la hit ratio della cache.

Su Google Cloud Platform, Redis è offerto tramite Memorystore, un servizio gestito che consente un deploy in pochi minuti, nativamente integrato con le VPC private e con il supporto per la replica e il failover automatico. Memorystore è progettato per la massima compatibilità con Redis open source, ma limita le estensioni rispetto ad AWS, soprattutto in scenari multi-cluster o di sharding avanzato. Tuttavia, offre una grande semplicità d’uso e costi contenuti per i workload standard.

Azure Cache for Redis si distingue per l’integrazione profonda con tutto l’ecosistema Microsoft. Supporta Redis in versione Enterprise e OSS, replica attiva in più regioni, supporto per clustering, monitoring via Azure Monitor e funzionalità come geo-replication, persistence e access control. La configurazione avviene da portale o da Azure CLI, con livelli di pricing differenti in base a memoria, throughput e SLA.

In ciascuna piattaforma, Redis si adatta ai pattern cloud-native, ma è fondamentale comprendere che le performance reali dipendono da una combinazione precisa di scelta delle istanze, rete sottostante, politiche di backup e configurazione TTL. I provider semplificano la gestione, ma la competenza nell’uso di Redis resta un vantaggio decisivo per evitare colli di bottiglia e sprechi economici.

L’infografica seguente sintetizza visivamente l’integrazione di Redis nei principali ambienti cloud, evidenziando connessioni e vantaggi infrastrutturali.

Costi, scalabilità e vantaggi delle soluzioni Redis gestite

Usare Redis nel cloud introduce una serie di vantaggi immediati, ma impone anche un cambio di mentalità nella gestione delle risorse. Il principale beneficio è la gestione completamente automatizzata: niente aggiornamenti manuali, niente script di failover, nessuna preoccupazione per la replica o l’alta disponibilità. Tutto viene orchestrato dalla piattaforma, con supporto per SLA elevati, elasticità in tempo reale e visibilità completa tramite metriche avanzate.

Ma ogni beneficio ha un costo. In ambienti gestiti, Redis non è più solo un software open source: è un servizio erogato con tariffe precise per memoria, throughput, operazioni al secondo e disponibilità. In AWS, ad esempio, il prezzo varia drasticamente tra un’istanza cache.t4g.micro da test e un cluster replicato con sharding attivo in tre zone. Lo stesso vale per Azure e Google Cloud, dove le scelte errate portano a sovra-provisioning o a rallentamenti non giustificabili in produzione.

La scalabilità, invece, è il vero punto di forza. Redis si espande orizzontalmente con estrema facilità grazie ai cluster configurabili, consentendo di gestire milioni di operazioni al secondo con latenze sotto il millisecondo. Il cloud rende questo processo elastico e automatizzato, evitando il rischio di overengineering e permettendo agli stack applicativi di crescere al ritmo dell’utente.

Inoltre, le soluzioni gestite introducono funzionalità di sicurezza avanzate, come autenticazione integrata, controllo degli accessi, audit log e crittografia trasparente. Redis nel cloud non è solo una cache più veloce: è un componente infrastrutturale strategico, pronto per ambienti enterprise e mission-critical.

Capire come usare Redis nel cloud significa scegliere consapevolmente tra semplicità e controllo, tra costo e performance, tra standardizzazione e ottimizzazione. E proprio in questa scelta si cela la vera differenza tra un’implementazione improvvisata e un’architettura cloud-native davvero scalabile e resiliente.

Redis non si limita al presente. La visualizzazione che segue anticipa il suo futuro come motore neurale per l’AI, le architetture distribuite e la UX real-time.

Conclusioni: perché Redis è ancora la scelta giusta e come può evolvere

In un mondo dove la latenza si misura in millisecondi e le decisioni si prendono in microsecondi, Redis continua a imporsi non solo come una tecnologia rilevante, ma come un acceleratore strategico per le architetture moderne. Il suo linguaggio è quello della velocità, della semplicità, della coerenza con i bisogni reali delle applicazioni: dalla gestione delle sessioni alle pipeline di machine learning, dalle API real-time ai sistemi di raccomandazione, Redis è già ovunque. Eppure, la sua traiettoria non è ancora completa.

C’è una ragione se, dopo anni di evoluzione, nessun altro sistema è riuscito a sostituire Redis nel cuore delle infrastrutture più reattive: non si tratta solo di prestazioni, ma di design concettuale. Redis lavora dove serve: in memoria. E lo fa con una tale versatilità da adattarsi alle sfide emergenti senza perdere coerenza. Che si tratti di caching, streaming, clustering o gestione di serie temporali, Redis si piega ma non si spezza. È flessibile, ma non compromette. È potente, ma rimane leggibile.

Il suo futuro parla il linguaggio delle intelligenze artificiali. Con il supporto nativo a strutture vettoriali, JSON e time series, Redis è già pronto a sostenere pipeline di machine learning e inference engine real-time. I moduli RedisAI e RedisGears non sono semplici add-on: sono il primo passo verso una piattaforma capace di ospitare l’intero ciclo di vita di un algoritmo intelligente, mantenendo la performance come valore centrale. Nessun database relazionale può reggere questo passo. Nessun sistema tradizionale può offrire la reazione istantanea che l’AI richiede.

La direzione è chiara: Redis evolve verso un ruolo neuronale nelle architetture distribuite. Non sarà più solo un intermediario rapido, ma un interprete attivo di dati. Sempre più vicino agli utenti, sempre più partecipe dell’esperienza utente. Non più un servizio nascosto nel backend, ma un cuore pulsante che dà forma alla reattività delle app. Microservizi, IoT, streaming sensoriale, automazione predittiva: in ognuno di questi contesti, Redis è già presente o sta arrivando. E ci arriva pronto.

Oggi, scegliere Redis significa investire in un’infrastruttura moderna, resiliente e scalabile. Ma domani, sarà una scelta che abilita l’intelligenza, la previsione, la risposta immediata. La UX non sarà più un tema di design, ma di architettura logica. Redis sarà il punto d’incontro tra dati, decisioni e persone.

E in un mondo che accelera ogni secondo, chi controlla la latenza controlla l’esperienza. Redis non è solo una tecnologia: è una dichiarazione di intenti. E tu, se lo hai compreso fino in fondo, non tornerai più indietro.

Domande frequenti su Redis: tutto quello che devi sapere prima di iniziare

❓Cos’è Redis e perché è considerato così veloce rispetto ad altri database?

Redis è un database in-memory open source che utilizza una struttura key-value estremamente leggera. La velocità deriva dal fatto che tutti i dati vengono mantenuti in RAM e non su disco, eliminando la latenza di I/O. Inoltre, Redis utilizza un motore single-threaded altamente ottimizzato che consente di gestire milioni di operazioni al secondo in tempo reale.

❓Qual è la differenza tra Redis caching e una cache tradizionale come Memcached?

A differenza di una cache classica, Redis caching supporta strutture dati avanzate (liste, set, hash, JSON, stream), persistenza opzionale dei dati e comandi atomici. Questo lo rende più adatto a scenari mission-critical dove performance e integrità dei dati sono fondamentali.

❓Come usare Redis nel cloud su AWS, Google Cloud e Azure?

Puoi utilizzare Redis come servizio gestito con soluzioni come AWS ElastiCache, Google Cloud Memorystore e Azure Cache for Redis. Questi servizi offrono provisioning semplificato, alta disponibilità, backup automatici e scalabilità elastica, eliminando la necessità di gestione manuale dell’infrastruttura.

❓Redis è ancora open source? Cosa cambia con Valkey?

Redis ha adottato una nuova licenza SSPL/RSAL, che ha portato alla creazione di Valkey, un fork open source supportato dalla Linux Foundation. Valkey conserva la licenza BSD e punta a mantenere il progetto completamente libero e comunitario, offrendo piena compatibilità con le versioni precedenti di Redis.

❓Qual è la migliore strategia di caching da implementare con Redis?

La scelta dipende dal caso d’uso. Le più comuni sono cache-aside (manuale), write-through (sincrona) e write-behind (asincrona). Redis supporta anche prefetch intelligente e gestione TTL per un caching predittivo e scalabile, specialmente in contesti a traffico elevato.

❓Redis può essere usato per applicazioni AI e machine learning?

Sì. Redis supporta moduli come RedisAI e RedisGears che permettono di integrare modelli di machine learning e intelligenza artificiale direttamente nel database. Questo consente inferenze in tempo reale e utilizzo di vettori, JSON e serie temporali per dati complessi.

❓Quali sono le migliori pratiche per ottimizzare la memoria in Redis?

Redis permette di gestire la memoria tramite politiche come LRU, LFU, TTL e parametri come maxmemory-policy. È consigliabile usare tipi di dato compatti come hash e set per ridurre l’overhead e monitorare costantemente con strumenti come RedisInsight.