Se hai mai sentito parlare di machine learning ma non hai mai capito davvero di cosa si tratta, sei nel posto giusto. In questa guida completa ti accompagnerò passo dopo passo alla scoperta di uno dei concetti più rivoluzionari e concreti dell’era digitale. E no, non serve essere un programmatore o un ingegnere per comprendere come funziona: il machine learning riguarda tutti noi, ogni giorno.

Immagina che il tuo smartphone, il tuo assistente vocale o persino le pubblicità che visualizzi online stiano imparando da te. Non si tratta di magia, ma del risultato di una disciplina che permette alle macchine di analizzare dati, rilevare schemi e migliorare le proprie performance senza istruzioni esplicite. Questo è, in poche parole, il cuore del machine learning: l’apprendimento automatico delle macchine.

Ma non fermiamoci alla teoria. Il machine learning è il motore che sta spingendo in avanti interi settori. Nel marketing digitale, consente di comprendere i comportamenti degli utenti con una precisione senza precedenti. In ambito medico, contribuisce a diagnosticare malattie prima ancora che si manifestino. Nella finanza, riconosce movimenti sospetti e segnali di frode in tempo reale. Nella mobilità, è alla base dei sistemi di guida autonoma che cambieranno per sempre il nostro modo di spostarci.

Stiamo parlando di una tecnologia già attiva nelle nostre vite, anche se spesso invisibile.

In questa guida scoprirai cosa sia davvero il machine learning, da dove nasce e perché oggi se ne parla ovunque. Analizzeremo le sue diverse tipologie e vedremo come si applicano nella pratica. Esploreremo gli algoritmi e gli strumenti principali, spiegati in modo accessibile. Entreremo in esempi concreti che mostrano il valore reale del machine learning. Infine, ci interrogheremo su come potrebbe cambiare il futuro delle professioni, del business e della società intera.

Non è una moda, è una rivoluzione silenziosa. Che tu sia un curioso, un professionista o un imprenditore, capire oggi il machine learning significa essere parte attiva del cambiamento.

Pronto a scoprirlo fino in fondo?

Cos’è il Machine Learning?

Quando si parla di machine learning, il rischio più comune è pensare subito a qualcosa di troppo tecnico, distante, quasi “da scienziati”. Ma la realtà è molto diversa: il concetto di base è sorprendentemente semplice e, soprattutto, già presente nella nostra vita quotidiana.

Alla radice del machine learning c’è un’idea potente: insegnare alle macchine a imparare dai dati, proprio come facciamo noi con l’esperienza. Senza codificare regole precise, senza dire loro cosa devono fare passo dopo passo. Basta fornire esempi, osservazioni, numeri. Le macchine analizzano, elaborano e reagiscono. E più dati ricevono, più migliorano. Questa capacità di autoapprendimento rende il machine learning uno strumento straordinariamente versatile.

Il machine learning non è sinonimo di intelligenza artificiale, anche se ne è una delle componenti centrali. L’intelligenza artificiale è un campo vastissimo, che include qualsiasi tecnologia in grado di emulare comportamenti umani. Ma il machine learning è il braccio pratico di tutto questo: è l’approccio che oggi permette di ottenere risultati tangibili. È ciò che alimenta i motori di ricerca, i consigli su Netflix, le pubblicità che vedi online, le app di navigazione e persino gli assistenti vocali.

Comprendere cos’è il machine learning non significa solo memorizzare una definizione. Significa acquisire la consapevolezza che siamo immersi in una nuova fase evolutiva della tecnologia. E significa riconoscere che anche chi non ha mai scritto una riga di codice può e deve capire come funziona.

In parole semplici, il machine learning è la disciplina che consente ai sistemi di apprendere dai dati e migliorare nel tempo, senza intervento umano diretto. È una forma di intelligenza adattiva, che non smette mai di evolversi. E proprio per questo, è fondamentale iniziare a conoscerla con chiarezza.

Machine Learning: definizione, origine e concetti chiave

Per comprendere davvero il valore del machine learning, dobbiamo partire dalla sua definizione più essenziale. In termini semplici, si tratta di un metodo che consente ai sistemi informatici di apprendere dai dati e migliorare le proprie prestazioni con l’esperienza, senza essere esplicitamente programmati. In pratica, non serve scrivere ogni singola istruzione: la macchina impara osservando ciò che è già successo.

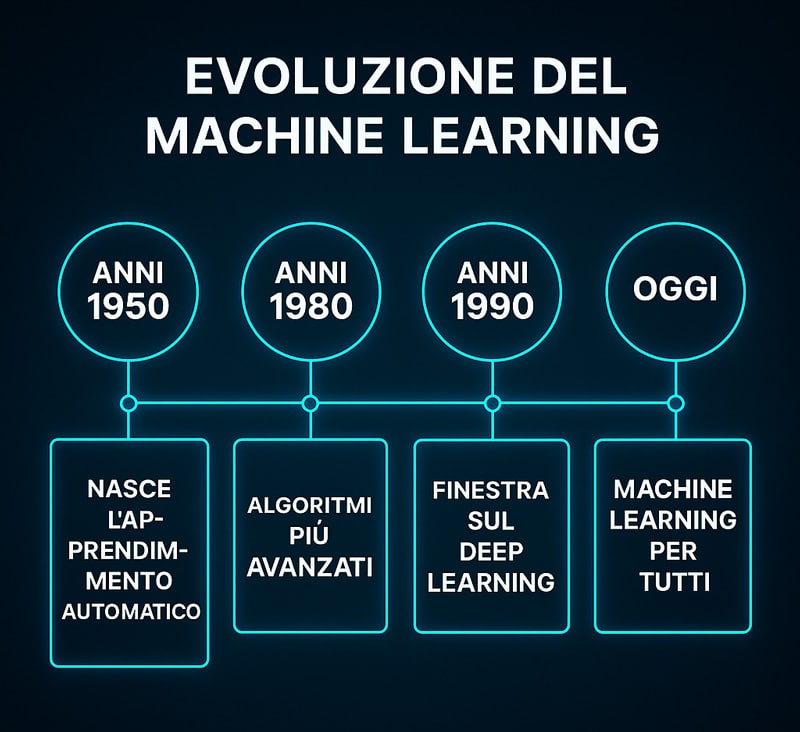

Il concetto non è affatto nuovo. Già negli anni ’50, il pioniere Arthur Samuel teorizzava che i computer potessero sviluppare comportamenti autonomi analizzando dati storici. La sua celebre frase — “la capacità di un computer di apprendere senza essere esplicitamente programmato” — è ancora oggi tra le più citate nel settore. Ma è con l’avvento di tre fattori chiave che il machine learning ha preso davvero piede: la disponibilità massiva di dati, la potenza di calcolo e lo sviluppo di algoritmi avanzati.

Tra i concetti fondamentali troviamo il modello, ovvero l’entità logica che racchiude ciò che il sistema ha “imparato”. Questo modello si costruisce tramite una fase di addestramento, detta training, dove vengono analizzati migliaia (o milioni) di esempi. Il sistema confronta, sperimenta, sbaglia e si corregge. E così migliora, iterazione dopo iterazione.

Il secondo concetto chiave è l’algoritmo, ossia il processo matematico che guida l’apprendimento. Esistono algoritmi per classificare immagini, prevedere numeri, suggerire contenuti e molto altro. Ogni algoritmo ha punti di forza, limiti e ambiti specifici di applicazione.

Va poi sottolineato che il machine learning è adattivo. Non è un software rigido ma un ecosistema in evoluzione continua. Più apprende, più diventa efficace. E questa caratteristica lo rende oggi essenziale in tantissimi ambiti: medicina, logistica, cybersecurity, automazione, retail, marketing, produzione industriale.

Conoscere questi concetti ti offre una base solida per interpretare con consapevolezza tutto ciò che viene dopo: dai tipi di apprendimento agli algoritmi specifici, fino ai casi reali di applicazione.

Differenza tra machine learning e intelligenza artificiale

Uno degli errori più diffusi quando si parla di tecnologie intelligenti è usare i termini machine learning e intelligenza artificiale come se fossero sinonimi. In realtà, pur essendo strettamente collegati, si riferiscono a concetti differenti. E capire questa distinzione è fondamentale per orientarsi nel mondo della tecnologia moderna senza cadere in semplificazioni fuorvianti.

L’intelligenza artificiale è un campo ampio e multidisciplinare, il cui obiettivo è replicare, simulare o amplificare l’intelligenza umana attraverso sistemi artificiali. Comprende tutte le tecnologie che permettono a una macchina di ragionare, apprendere, prendere decisioni o adattarsi all’ambiente. Questo significa che non si limita solo all’apprendimento automatico, ma ingloba anche approcci simbolici, sistemi esperti, logiche fuzzy, reti semantiche, e molte altre tecniche.

Il machine learning, invece, rappresenta una branca specifica dell’IA, quella più operativa e utilizzata al momento. Si basa su un paradigma completamente diverso: invece di fornire regole esplicite, si danno alla macchina esempi e dati da cui imparare modelli comportamentali. In altre parole, non si programma la soluzione: si lascia che il sistema la scopra da solo.

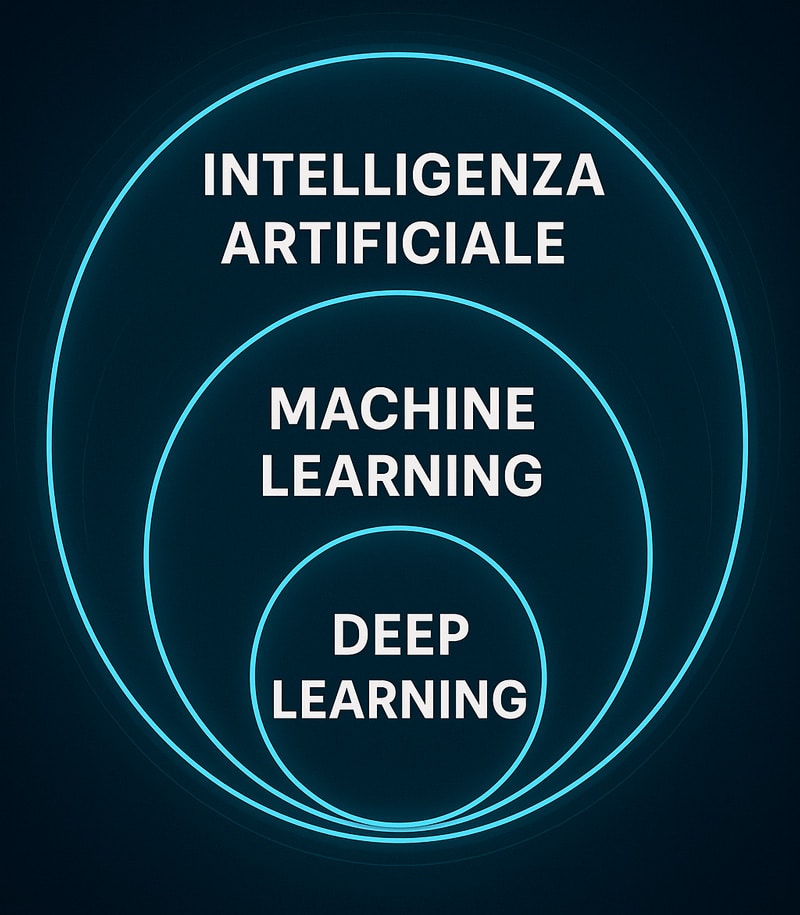

Un ulteriore livello è rappresentato dal deep learning, ovvero un sottoinsieme avanzato del machine learning che utilizza reti neurali profonde. Queste reti simulano il comportamento dei neuroni biologici, permettendo ai sistemi di apprendere anche da dati non strutturati come immagini, suoni o testi, in modo molto più raffinato. Il deep learning è ciò che rende possibili tecnologie come il riconoscimento facciale, la traduzione automatica o le auto a guida autonoma.

Una buona analogia per chiarire la gerarchia è questa: l’intelligenza artificiale è l’universo, il machine learning è una galassia all’interno di esso, e il deep learning è una stella luminosa in quella galassia. Ogni livello è più specifico del precedente, ma tutti lavorano per un obiettivo comune: creare macchine capaci di comportamenti intelligenti.

Conoscere queste differenze non è solo una questione teorica: ti permette di capire meglio le applicazioni reali che usi ogni giorno e le tecnologie che stanno trasformando interi settori.

Come funziona il Machine Learning: la logica dietro le macchine che imparano

Capire come funziona il machine learning non significa per forza addentrarsi nei dettagli matematici di ogni singolo algoritmo. Il vero obiettivo è cogliere il senso del suo processo: un sistema che, osservando grandi quantità di dati, è in grado di individuare regolarità, fare previsioni e adattarsi a nuove situazioni in modo autonomo.

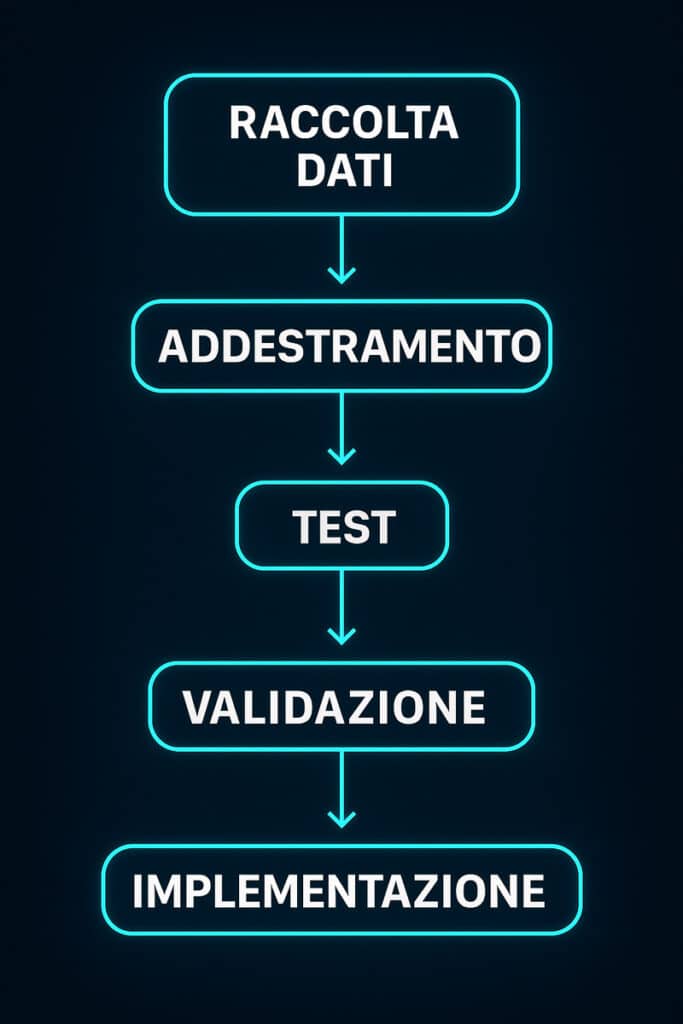

Per rendere ancora più chiaro il processo che guida il machine learning, ecco un diagramma di flusso che ne rappresenta visivamente le cinque fasi principali, dalla raccolta dei dati all’applicazione reale.

Tutto inizia dalla raccolta dei dati. Questi possono essere numerici, testuali, visivi o audio, e non devono per forza essere perfetti. Vengono forniti al sistema come esempi, senza istruzioni esplicite. Il cuore del processo è un algoritmo di machine learning che elabora questi dati per identificare correlazioni e schemi nascosti. Da questo processo nasce il modello, una struttura logica che rappresenta ciò che il sistema ha imparato.

Questo modello non viene accettato acriticamente. Prima viene testato con nuovi dati per verificare quanto è in grado di generalizzare, cioè di funzionare bene anche con esempi mai visti prima. Se i risultati sono validi, il modello è pronto per l’uso in scenari reali. Se non lo sono, viene migliorato, modificato e riaddestrato in un ciclo continuo di apprendimento.

Ciò che rende il machine learning così potente è proprio la sua natura iterativa e adattiva. Non è una tecnologia rigida: può migliorare ogni volta che riceve nuovi input. In ambito medico può aggiornarsi con nuove casistiche cliniche, nel marketing può affinare la previsione dei comportamenti di consumo, nella sicurezza può riconoscere minacce mai viste prima.

Per rendere ancora più chiaro il processo che guida il machine learning, ecco un diagramma di flusso che ne rappresenta visivamente le cinque fasi principali, dalla raccolta dei dati all’applicazione reale.

In sintesi, il machine learning funziona perché riesce a convertire la complessità dei dati grezzi in decisioni intelligenti. Automatizza attività che richiederebbero ore di elaborazione umana e lo fa con efficienza e rapidità, offrendo un vantaggio competitivo concreto. È questo il motivo per cui oggi è considerato uno dei motori più efficaci della trasformazione digitale.

Gli algoritmi di machine learning spiegati in modo semplice

Ogni volta che senti parlare di machine learning, dietro le quinte sta lavorando un algoritmo. Il termine può sembrare tecnico, ma il concetto è semplice: un algoritmo è una sequenza logica di passaggi che consente a un sistema di apprendere dai dati per prendere decisioni intelligenti. È come una ricetta per insegnare alla macchina a riconoscere schemi, fare previsioni o categorizzare informazioni.

Gli algoritmi non sono tutti uguali: ne esistono di più semplici e altri estremamente sofisticati. Alcuni analizzano dati numerici per prevedere un valore, altri cercano di classificare informazioni in categorie, altri ancora scoprono relazioni nascoste tra le variabili. La scelta dell’algoritmo dipende da vari fattori: il tipo di problema, la quantità di dati disponibili, la precisione richiesta e il grado di interpretabilità necessario.

Tra i metodi più noti troviamo quelli che cercano correlazioni lineari per prevedere un numero, come nel caso della previsione del prezzo di una casa. Esistono poi sistemi che seguono strutture ad albero, prendendo decisioni in base a condizioni logiche. Alcuni si basano sul confronto tra esempi simili, altri ancora creano “foreste” di decisioni per migliorare la precisione.

Un caso particolare sono le reti neurali artificiali. Ispirate al cervello umano, sono composte da unità che elaborano segnali e apprendono in profondità. Queste architetture sono la base delle tecnologie più evolute: riconoscimento vocale, traduzione automatica, analisi di immagini, assistenti virtuali.

Comprendere il funzionamento degli algoritmi, anche in modo generale, è fondamentale per sapere cosa succede quando una macchina ti propone qualcosa, anticipa un tuo bisogno o rileva un’anomalia. Ogni decisione automatica è il risultato di un algoritmo che ha imparato osservando, e questa capacità di apprendimento progressivo è ciò che rende il machine learning così potente e diffuso.

Il ciclo di vita di un modello di machine learning: training, test e validazione

Un modello di machine learning non nasce pronto. Per diventare realmente efficace deve seguire un processo strutturato che si articola in tre fasi fondamentali: training, test e validazione. Conoscere questo ciclo è essenziale per capire perché un modello funziona bene e un altro no.

Tutto comincia con il training, ovvero l’addestramento. In questa fase, il sistema riceve grandi quantità di dati etichettati che rappresentano esempi reali. Analizzandoli, l’algoritmo regola i propri parametri interni per minimizzare l’errore. Si tratta di un processo iterativo e raffinato, in cui il sistema sbaglia, corregge, migliora.

Dopo il training, si passa al test. Qui, il modello viene messo di fronte a dati mai visti prima. L’obiettivo è misurare quanto riesce a generalizzare l’apprendimento e produrre risultati corretti su nuovi input. Se riesce, è pronto per l’ambiente reale. Se fallisce, potrebbe soffrire di overfitting, cioè essere diventato troppo “specializzato” sui dati di partenza.

Infine, c’è la fase di validazione, che spesso avviene in parallelo. Qui si confrontano diverse versioni del modello, si misurano metriche di performance e si prende una decisione su quale sia la più adatta all’obiettivo. È in questa fase che si ottimizzano le configurazioni, si prevengono errori futuri e si verifica la stabilità del modello in condizioni reali.

Questo ciclo non è solo una procedura tecnica, ma la chiave della qualità. Ogni modello affidabile è il risultato di un processo ripetuto di apprendimento, test e miglioramento. Nulla è improvvisato: è solo attraverso questo cammino che si costruisce una vera intelligenza applicata.

Per comprendere a colpo d’occhio la struttura funzionale di un sistema di machine learning, osserva questo schema architetturale che collega dati, algoritmo, interfaccia e risultato.

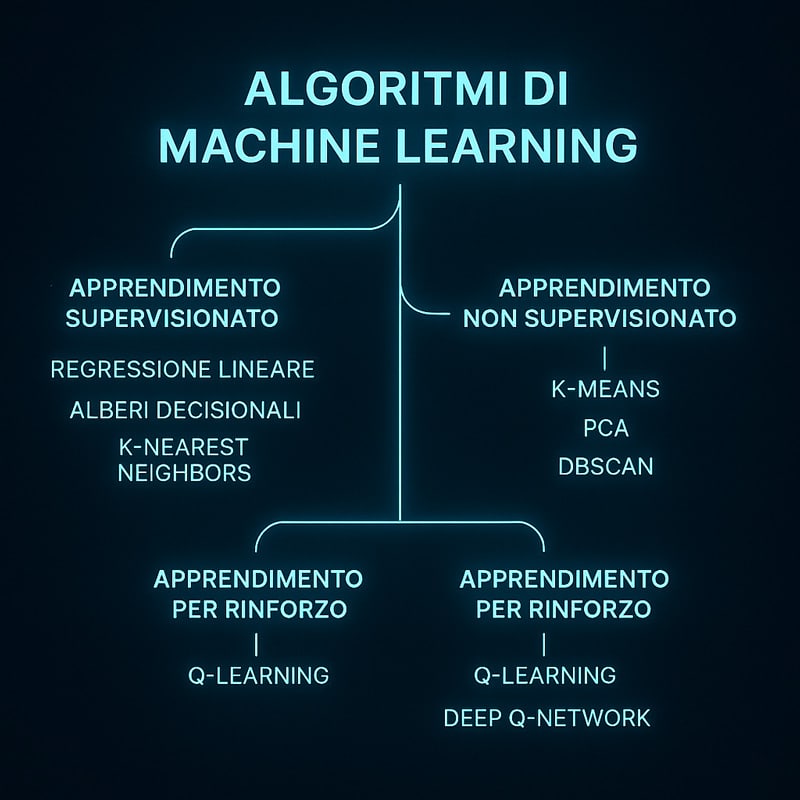

Tipi di Machine Learning: supervisionato, non supervisionato e rinforzo

Non esiste un solo modo in cui una macchina può apprendere. Nel campo del machine learning, i metodi di apprendimento si suddividono principalmente in tre grandi categorie: apprendimento supervisionato, apprendimento non supervisionato e apprendimento per rinforzo. Ognuno di questi approcci ha caratteristiche specifiche, ambiti di utilizzo diversi e modalità operative distinte. Comprendere la differenza tra questi tipi è fondamentale per sapere quale approccio adottare in base al problema da risolvere.

L’apprendimento supervisionato è il metodo più comune. In questo caso, il sistema viene addestrato su un set di dati già etichettati, ovvero contenenti sia gli input che le risposte corrette. L’obiettivo è far sì che il modello impari a prevedere l’output corretto anche per nuovi input, seguendo lo schema appreso. È il metodo usato, ad esempio, per classificare email come spam, prevedere il valore di una casa, o riconoscere immagini.

L’apprendimento non supervisionato, invece, funziona su dati non etichettati. Il sistema non conosce le risposte corrette e deve trovare da solo pattern, gruppi o strutture nascoste. È utile per segmentare clienti in base ai comportamenti, effettuare analisi esplorative, o rilevare anomalie.

Infine, l’apprendimento per rinforzo è un approccio diverso: il sistema apprende attraverso un meccanismo di prova ed errore. Non riceve etichette, ma feedback sotto forma di ricompensa o penalità. L’obiettivo è massimizzare la ricompensa totale imparando a prendere decisioni ottimali nel tempo.

Capire questi tre paradigmi significa avere una visione più chiara del panorama del machine learning. Ogni tipo ha i suoi punti di forza e può essere decisivo in contesti specifici. La chiave sta nel saper scegliere l’approccio giusto in funzione dei dati e degli obiettivi.

Apprendimento supervisionato e non supervisionato: differenze e usi pratici

Nel panorama del machine learning, due delle metodologie più utilizzate sono l’apprendimento supervisionato e quello non supervisionato. Anche se condividono lo stesso obiettivo generale – costruire modelli intelligenti a partire dai dati – differiscono completamente nel modo in cui affrontano il problema e nelle situazioni in cui trovano applicazione.

L’apprendimento supervisionato si basa sull’utilizzo di dati etichettati. Ogni esempio fornito al sistema contiene già una risposta corretta. Il compito del modello è apprendere la relazione tra input e output, in modo da poterla generalizzare e applicare a dati nuovi. È perfetto per scenari ben definiti, come la classificazione di email, la previsione di valori economici o la diagnosi medica automatizzata.

Dall’altra parte, l’apprendimento non supervisionato lavora senza etichette. Il sistema riceve solo dati grezzi e deve scoprire da solo schemi, gruppi o relazioni. È molto utile per analisi esplorative, segmentazione clienti o rilevamento di frodi.

La differenza sostanziale tra i due approcci sta nella presenza o assenza di una guida iniziale. Il supervisionato segue un percorso chiaro. Il non supervisionato esplora. Entrambi possono essere usati in combinazione: uno scopre le strutture, l’altro le consolida.

Capire questa distinzione permette di scegliere in modo strategico. Non esiste una soluzione unica: tutto dipende dal tipo di dati a disposizione e dagli obiettivi da raggiungere.

Apprendimento per rinforzo: la frontiera dell’intelligenza artificiale

L’apprendimento per rinforzo rappresenta uno degli sviluppi più avanzati e affascinanti del machine learning. A differenza degli altri approcci, qui il sistema non si limita ad osservare i dati: interagisce direttamente con un ambiente dinamico, prendendo decisioni e ricevendo feedback.

Un agente intelligente esplora un ambiente e riceve ricompense o penalità in base alle azioni compiute. L’obiettivo è massimizzare le ricompense cumulative imparando a scegliere le azioni migliori nel tempo. Non ci sono etichette preimpostate: è l’esperienza a costruire la conoscenza.

Questo metodo è ideale per contesti in evoluzione continua, dove serve adattamento strategico. Viene impiegato nei videogiochi, nella robotica autonoma, nella finanza computazionale e nel controllo intelligente del traffico.

Un concetto chiave dell’apprendimento per rinforzo è quello di politica, ossia la strategia che l’agente segue. Ogni volta che interagisce con l’ambiente, l’agente aggiorna la propria politica per migliorare. Questo ciclo continuo di prova, errore e ottimizzazione lo rende altamente adattivo.

Spesso, questo tipo di apprendimento è combinato con il deep learning, dando vita a modelli avanzati come le Deep Q-Networks. È grazie a queste tecnologie che alcune AI sono riuscite a battere i campioni umani in giochi come Go o a guidare robot in scenari complessi.

Comprendere questo approccio significa entrare nel cuore della moderna intelligenza artificiale. Non si tratta solo di imparare, ma di imparare a imparare.

Per riflettere sul significato profondo del machine learning, ecco una pillola visiva che racchiude in poche parole l’essenza del suo potere trasformativo.

Machine Learning nella vita quotidiana e nel business

Il machine learning non è un concetto astratto riservato a scienziati o ingegneri: è una tecnologia concreta, già profondamente integrata nelle nostre vite quotidiane. Ogni giorno, spesso senza rendercene conto, interagiamo con sistemi intelligenti che apprendono dalle nostre azioni, osservano i nostri comportamenti e adattano le loro risposte per offrirci esperienze più rapide, utili e personalizzate.

Pensiamo ai motori di ricerca che completano le frasi mentre digitiamo, agli assistenti vocali che rispondono in modo naturale, agli suggerimenti di acquisto che sembrano leggere nella nostra mente. Tutto questo è possibile grazie a modelli di machine learning che analizzano enormi quantità di dati, imparano costantemente dalle interazioni e si adattano in tempo reale. È il principio base che alimenta le funzionalità di streaming, social media, app di navigazione e sistemi di riconoscimento facciale.

Nel mondo del business, l’impatto è ancora più evidente. Le aziende usano il machine learning per ottimizzare campagne di marketing, personalizzare offerte, analizzare comportamenti d’acquisto, prevedere la domanda, rilevare frodi e persino automatizzare la customer care. In campo medico, supporta diagnosi più accurate, scoperta di pattern clinici nascosti e proposte di terapie predittive. Nel settore finanziario, contribuisce a individuare transazioni sospette, calcolare il rischio e fare previsioni di mercato in tempo reale.

Anche il comparto industriale è coinvolto. Il machine learning permette di implementare manutenzione predittiva, controlli qualità automatici, gestione logistica proattiva e ottimizzazione energetica. Il risultato è una riduzione dei costi operativi, minori interruzioni, migliore efficienza produttiva.

Il vero punto di forza di questa tecnologia è che non sostituisce l’uomo, ma ne potenzia la capacità decisionale. Permette di trasformare l’informazione in valore, convertendo dati grezzi in azioni concrete e misurabili. Ed è proprio questa capacità di apprendere, adattarsi e anticipare che rende il machine learning una delle leve strategiche più potenti dell’era digitale, tanto per i consumatori quanto per le organizzazioni più evolute.

Come il machine learning cambia il marketing, la medicina e la finanza

Il machine learning sta trasformando radicalmente tre settori chiave dell’economia: marketing, medicina e finanza. In ognuno di questi ambiti, la capacità di analizzare grandi volumi di dati e generare previsioni affidabili sta rivoluzionando processi, ruoli e strategie operative.

Per comprendere dove il machine learning sta generando il maggiore impatto, osserva questo grafico che ne visualizza le applicazioni principali nei diversi settori industriali e professionali.

Nel marketing, il machine learning è diventato uno strumento essenziale per personalizzare l’esperienza dell’utente. Analizzando in tempo reale dati come comportamenti di navigazione, cronologia degli acquisti e interazioni con campagne pubblicitarie, le aziende riescono a costruire profili comportamentali dettagliati. Il risultato è una comunicazione mirata, segmentata e orientata alla conversione. Non solo: grazie agli algoritmi predittivi, è possibile ottimizzare la distribuzione del budget pubblicitario, individuare i canali più performanti e adattare le strategie in tempo reale.

Nel settore medico, il valore aggiunto è ancora più evidente. I modelli di machine learning sono in grado di rilevare pattern nascosti nei dati clinici, spesso invisibili all’occhio umano. Questo permette di ottenere diagnosi più rapide e accurate, proporre piani terapeutici personalizzati, monitorare l’evoluzione delle patologie e persino anticipare complicazioni prima che si manifestino. In ambito diagnostico, ad esempio, gli algoritmi possono analizzare immagini radiologiche con una precisione comparabile – o in certi casi superiore – a quella degli specialisti.

Anche la finanza sta vivendo una rivoluzione. Il machine learning viene applicato per rilevare frodi in tempo reale, analizzare flussi monetari, valutare il rischio di credito e prevedere l’andamento dei mercati. Banche, assicurazioni e fintech sfruttano questi strumenti per automatizzare la concessione di prestiti, ottimizzare i portafogli di investimento, e offrire servizi di consulenza intelligente tramite chatbot evoluti.

In tutti e tre i settori, i benefici sono evidenti: più efficienza, meno errori, maggiore velocità nelle decisioni. Ma il vero cambiamento è concettuale: i dati non sono più solo una memoria del passato, bensì una bussola per orientare il futuro in modo consapevole e strategico.

Esempi di machine learning: dalle raccomandazioni Netflix alla guida autonoma

Capire l’impatto reale del machine learning diventa molto più semplice quando si osservano esempi concreti di applicazione. Oggi, questa tecnologia è ovunque, anche in contesti che diamo per scontati.

Nel settore dell’intrattenimento, piattaforme come Netflix, YouTube e Spotify utilizzano modelli predittivi per analizzare le preferenze individuali e offrire suggerimenti personalizzati. Ogni serie consigliata, ogni playlist automatica, è il risultato di algoritmi che apprendono dai tuoi comportamenti passati per anticipare quelli futuri. Più interagisci, più il sistema impara, e più accurata sarà la prossima proposta.

Lo stesso principio si applica allo shopping online. Marketplace come Amazon, Zalando o AliExpress monitorano in tempo reale clic, tempi di permanenza, acquisti precedenti e persino carrelli abbandonati. I dati raccolti alimentano motori di raccomandazione intelligenti, che personalizzano l’offerta, ottimizzano l’interfaccia e guidano il processo d’acquisto. Non stai solo navigando: il sistema sta imparando da te mentre lo usi.

Nel mondo della mobilità, il machine learning è il cuore della guida autonoma. Le auto dotate di sensori e videocamere elaborano migliaia di segnali al secondo: posizione di pedoni, semafori, altri veicoli, condizioni stradali. Tutte queste informazioni vengono elaborate da modelli intelligenti che decidono quando frenare, accelerare o correggere la traiettoria. E più chilometri percorrono, più le auto imparano a farlo meglio. Il machine learning viene inoltre utilizzato per ottimizzare il traffico urbano, adattando i semafori in base al flusso reale e prevenendo congestioni in tempo reale.

Anche nelle app che usiamo ogni giorno, il machine learning è invisibile ma presente. Dalle notifiche intelligenti delle app news, ai coach virtuali nelle app di fitness, fino alla gestione automatica delle finanze personali, ogni funzione che sembra “capirti” è il risultato di un modello che si adatta al tuo comportamento.

Non è fantascienza. È tecnologia che lavora in silenzio, ma trasforma la tua esperienza digitale in qualcosa di più efficace, intuitivo e personale. E tutto questo accade, ogni giorno, grazie al machine learning.

Strumenti e linguaggi per lavorare con il Machine Learning

Il machine learning, per quanto affascinante sul piano teorico, si realizza davvero solo attraverso strumenti concreti, linguaggi di programmazione e ambienti di sviluppo. È proprio grazie a queste tecnologie che idee e modelli diventano soluzioni applicabili, testabili e ottimizzabili.

Il punto di partenza per chi vuole iniziare è la scelta del linguaggio di programmazione. Il più diffuso è senza dubbio Python, scelto per la sua semplicità sintattica, flessibilità e vasto ecosistema di librerie. Python è oggi lo standard de facto nel campo del machine learning, grazie alla sua capacità di integrarsi con strumenti di calcolo scientifico, visualizzazione e modellazione. Esistono però anche altre opzioni, come R, particolarmente usato in ambito accademico e statistico, oppure Java e Scala, impiegati per applicazioni ad alte prestazioni o in contesti produttivi molto esigenti.

Oltre al linguaggio, contano soprattutto le librerie e i framework. Tra le più note troviamo TensorFlow e PyTorch, vere potenze per la creazione di reti neurali e modelli di deep learning. Queste piattaforme permettono di definire architetture complesse, gestire i dati di addestramento e monitorare l’evoluzione delle prestazioni in modo integrato. Per chi è all’inizio, strumenti come Scikit-learn rappresentano un’ottima base: semplici da usare ma abbastanza completi da coprire la maggior parte degli algoritmi supervisionati e non supervisionati. Anche Keras, spesso utilizzato in combinazione con TensorFlow, è ideale per chi vuole costruire modelli senza dover gestire ogni dettaglio tecnico.

Un vantaggio significativo del mondo machine learning è l’approccio open source. Quasi tutte queste tecnologie sono gratuite e supportate da comunità globali che condividono codici, dataset, esperienze. Questo riduce le barriere all’ingresso, accelera l’apprendimento e stimola l’innovazione. A questo si aggiungono le piattaforme cloud, come Google Colab, AWS SageMaker e Azure ML, che mettono a disposizione potenza computazionale on demand e ambienti preconfigurati.

Conoscere questi strumenti non è un lusso da sviluppatori, ma una leva strategica per chi vuole innovare. Permette di passare dalla teoria alla pratica, di costruire prototipi, di testare idee e di trasformare dati in decisioni intelligenti.

Il machine learning è codice che apprende, ed è proprio questa concretezza operativa ad aver reso possibile la sua diffusione trasversale in ogni settore.

Python, R e TensorFlow: i tool più usati

Nel vasto ecosistema del machine learning, alcuni strumenti si sono affermati come pilastri fondamentali. Tra questi, il linguaggio che domina la scena è senza dubbio Python. Apprezzato per la sua sintassi semplice, versatilità e capacità di integrazione, è il punto di partenza più consigliato per chi vuole analizzare dati, costruire modelli predittivi o sperimentare con reti neurali.

Python è molto più di un linguaggio: è un intero ambiente costruito per il lavoro con i dati. Offre librerie dedicate come NumPy per il calcolo numerico, Pandas per la manipolazione dei dati, Matplotlib e Seaborn per la visualizzazione, e naturalmente Scikit-learn, TensorFlow e PyTorch per l’apprendimento automatico. Ma ciò che rende Python davvero potente è la comunità globale che lo supporta: migliaia di sviluppatori, data scientist e ricercatori che contribuiscono con tutorial, documentazione aggiornata e pacchetti sempre nuovi.

Accanto a Python troviamo R, il linguaggio storico dell’analisi statistica. Anche se meno accessibile per i principianti, R è molto apprezzato per la visualizzazione dei dati, l’esplorazione statistica e la reportistica automatizzata. In ambiti accademici, biostatistici o di ricerca sociale, resta uno standard riconosciuto e aggiornato.

Tra i framework, spicca TensorFlow, sviluppato da Google e progettato per addestrare modelli complessi di deep learning. Grazie alla sua architettura modulare, può essere eseguito su CPU, GPU e anche su mobile, rendendolo adatto sia a progetti di ricerca che a soluzioni industriali su larga scala. TensorFlow si integra perfettamente con Keras, un’interfaccia più semplice che consente di costruire reti neurali senza dover gestire ogni dettaglio tecnico.

Questi strumenti non sono solo software: sono ecosistemi completi in cui teoria, sperimentazione e produzione si incontrano. Conoscerli e saperli usare significa aprire le porte a un mondo dove le idee possono trasformarsi in modelli intelligenti funzionanti, capaci di portare valore in qualsiasi ambito.

Come iniziare a creare un modello di machine learning passo dopo passo

Iniziare a costruire un modello di machine learning può sembrare complesso, ma seguendo un percorso strutturato diventa accessibile anche a chi è alle prime armi. Non serve essere un programmatore esperto: serve un approccio chiaro, pazienza e la voglia di sperimentare.

Il primo passo è comprendere il problema da risolvere. Si tratta di una classificazione, di una previsione numerica o di un raggruppamento non supervisionato? Definire con precisione l’obiettivo è fondamentale per scegliere il tipo di algoritmo da utilizzare.

Segue la fase cruciale: la raccolta e preparazione dei dati. I dati sono la base di tutto. Vanno puliti, normalizzati, trasformati. Si devono affrontare problemi di dati mancanti, formati incoerenti, outlier e altre anomalie che possono compromettere l’efficacia del modello. Questa è spesso la fase più lunga dell’intero progetto, ma anche la più determinante.

Una volta pronti i dati, si sceglie l’algoritmo di machine learning più adatto. La scelta dipende dalla natura del problema e dalla struttura del dataset. A questo punto si passa al training, ovvero all’addestramento del modello, usando una porzione dei dati. Poi si procede con la fase di test, in cui si verifica la capacità del modello di generalizzare su dati mai visti prima.

La valutazione delle performance avviene con metriche specifiche: accuratezza, precisione, richiamo, AUC-ROC. Questi indicatori aiutano a capire se il modello sta funzionando bene o se ha bisogno di ulteriori ottimizzazioni. In caso di risultati deludenti, si può agire su più fronti: migliorare la qualità dei dati, modificare l’algoritmo scelto, regolare i parametri.

Una volta ottenute prestazioni soddisfacenti, il modello è pronto per la fase di deployment, ovvero l’implementazione nel mondo reale: su un’app, un sito, un gestionale. Ma il lavoro non finisce qui. Un modello, per restare efficace, deve essere monitorato nel tempo, aggiornato con nuovi dati e riconfigurato quando cambiano le condizioni operative.

Questa capacità di adattamento continuo è ciò che distingue il machine learning da qualsiasi altra soluzione tradizionale: non è un blocco fisso, ma un sistema vivo che evolve insieme ai dati.

Sfide, limiti e rischi del Machine Learning

Per quanto potente e promettente, il machine learning non è una bacchetta magica. Dietro ogni algoritmo si nascondono limiti tecnici, rischi etici e criticità operative che devono essere conosciute, valutate e affrontate. Solo così questa tecnologia può essere applicata in modo consapevole, efficace e responsabile.

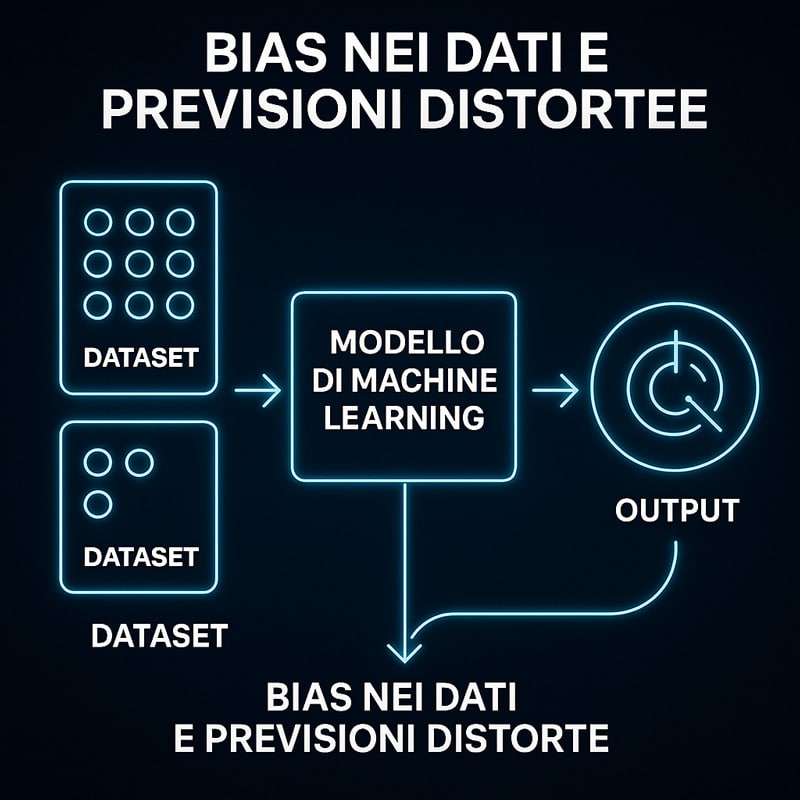

Una delle sfide più grandi è legata ai dati. Il machine learning vive di informazioni: più ne ha, meglio funziona. Ma se i dati sono incompleti, distorti, sbilanciati o contaminati da pregiudizi, anche il modello finale sarà imperfetto o discriminante. La regola “garbage in, garbage out” descrive perfettamente il problema: se inserisci dati sbagliati, otterrai risultati inutili o pericolosi.

Un altro limite critico è quello dell’interpretabilità. Molti modelli – in particolare quelli basati su deep learning – funzionano come scatole nere: generano previsioni accurate, ma non spiegano in modo chiaro come ci arrivano. In settori regolamentati come la sanità, la giustizia o la finanza, questa opacità può diventare un ostacolo all’adozione o addirittura una violazione normativa.

Esistono poi seri rischi di sicurezza. I modelli possono essere manipolati, ingannati, violati da attacchi informatici sofisticati. Basta una variazione impercettibile in un input (un’immagine, un testo, un dato) per indurre il sistema a prendere decisioni sbagliate. Quando il machine learning viene utilizzato in scenari critici, questa vulnerabilità non può essere ignorata.

Non meno importante è la questione della privacy. I modelli spesso trattano informazioni personali, sensibili o riservate. È quindi essenziale che ogni fase del processo – dalla raccolta al training, dall’archiviazione all’utilizzo – rispetti le normative sulla protezione dei dati (come il GDPR). Trascurare questo aspetto può portare a sanzioni, danni reputazionali e perdita di fiducia.

Infine, c’è il rischio dell’entusiasmo cieco. Usare il machine learning perché “fa tendenza” o viene percepito come soluzione universale è pericoloso. Non tutte le sfide richiedono un algoritmo predittivo. A volte, strumenti più semplici o approcci tradizionali sono più efficienti, economici e trasparenti.

Affrontare il machine learning con uno sguardo critico significa riconoscerne i limiti, prevederne le conseguenze e mitigarne i rischi. Solo così potremo davvero sfruttarne il potenziale, senza esserne travolti.

I bias nei dati e nei modelli: come nascono e come evitarli

Uno dei temi più delicati e discussi nel mondo del machine learning è quello dei bias, ovvero le distorsioni sistematiche che si insinuano nei dati o nei modelli, influenzandone le previsioni e le decisioni. Se non gestiti correttamente, i bias possono portare a risultati ingiusti, discriminatori o pericolosamente fuorvianti.

I bias possono nascere già nella fase di raccolta dei dati. Se il dataset rappresenta in modo squilibrato certi gruppi sociali – ad esempio per genere, età, etnia, provenienza geografica – il modello costruito su quei dati replicherà e amplificherà questi squilibri. Questo è ciò che accade, per esempio, quando un algoritmo penalizza candidati provenienti da certe zone o valuta in modo distorto il merito di un soggetto rispetto a un altro.

È il caso, ad esempio, di modelli che penalizzano determinati gruppi sociali nei processi di selezione del personale o di concessione di credito.

Per comprendere visivamente l’effetto dei dati sbilanciati sul risultato di un modello di machine learning, osserva questo schema che mostra come nascano previsioni distorte.

Ma il problema non si ferma ai dati. Anche le scelte progettuali possono introdurre bias. La selezione delle variabili, la formulazione dell’obiettivo, la struttura dell’algoritmo stesso sono tutti punti sensibili. A volte, modelli sviluppati in perfetta buona fede finiscono per incorporare stereotipi o automatizzare pregiudizi preesistenti.

Per ridurre questi effetti, è essenziale adottare un approccio rigoroso e trasparente. I dati devono essere analizzati per evidenziare eventuali squilibri, bilanciati attraverso tecniche di resampling o reweighting, e verificati rispetto a standard di rappresentatività. Anche durante il test, è buona norma includere valutazioni differenziate per sottogruppi, per controllare se il modello funziona in modo equo su tutte le categorie.

Un altro elemento fondamentale è la documentazione accurata del processo. Rendere esplicite le scelte fatte, descrivere i limiti del modello, dichiarare gli obiettivi reali permette a terze parti di valutare, replicare e – se necessario – correggere il sistema.

Infine, serve una cultura della consapevolezza: nessun modello è neutro e nessun sistema è immune dal rischio di errore. I bias non si eliminano completamente, ma possono essere misurati, monitorati e contenuti.

Solo attraverso questa vigilanza attiva e continua il machine learning potrà diventare uno strumento giusto, inclusivo e affidabile per tutti.

Etica, sicurezza e privacy nell’intelligenza artificiale

Man mano che il machine learning e l’intelligenza artificiale entrano in ambiti sempre più sensibili, è impossibile ignorare le implicazioni etiche, le problematiche di sicurezza e le criticità legate alla privacy. Non si tratta più solo di efficienza o performance. Oggi conta anche come, dove e perché un algoritmo prende decisioni, e quali conseguenze possono derivarne.

Dal punto di vista etico, la prima domanda è chiara: chi è responsabile quando un algoritmo sbaglia? Se un modello decide chi assumere, chi concedere un mutuo o come assegnare una priorità medica, chi risponde delle sue azioni? In scenari reali, come sanità, giustizia e finanza, una singola predizione errata può avere effetti concreti, talvolta drammatici, sulla vita delle persone. La questione della responsabilità algoritmica è aperta, e richiede un nuovo quadro normativo, trasparente e verificabile.

Sul fronte della sicurezza, i modelli sono vulnerabili. Esistono attacchi specifici, come gli adversarial attacks, che alterano impercettibilmente i dati in ingresso per ingannare il sistema e provocare comportamenti anomali. Un algoritmo che classifica immagini, ad esempio, può confondere un segnale stradale con un volto umano, se manipolato ad arte. Proteggere i modelli significa proteggere chi li utilizza: aziende, enti pubblici, cittadini.

Il tema della privacy è altrettanto cruciale. I modelli di machine learning si allenano su enormi volumi di dati personali: abitudini, cronologia, preferenze, conversazioni, geolocalizzazioni. È fondamentale che questi dati siano raccolti con consenso informato, trattati in modo anonimo e sicuro, e soprattutto non condivisi impropriamente con terze parti. Il rispetto delle normative come il GDPR non è un optional: è una garanzia di fiducia e legittimità.

Infine, il rischio più sottovalutato è quello della disumanizzazione delle decisioni. Quando un algoritmo prende il posto dell’interazione umana, si rischia di normalizzare l’automazione anche in ambiti dove l’empatia, il contesto e l’etica sono insostituibili. Per questo motivo, ogni sistema intelligente deve essere progettato con trasparenza, controllo umano costante e rispetto dei diritti fondamentali.

L’intelligenza artificiale deve essere al servizio delle persone, non sostituirsi ad esse. Solo mettendo al centro la dimensione umana, sarà possibile costruire una tecnologia che ispiri fiducia, produca valore reale e sia sostenibile nel tempo.

Il futuro del Machine Learning: tendenze e scenari emergenti

Il machine learning ha già rivoluzionato il modo in cui interagiamo con la tecnologia, ma ciò che ci attende è ancora più radicale. Non siamo alla fine di un processo, ma all’inizio di una nuova fase: un’evoluzione continua, spinta da progressi tecnologici, esigenze di mercato e cambiamenti sociali profondi.

Per capire come siamo arrivati all’attuale centralità del machine learning, è utile ripercorrere le tappe fondamentali della sua evoluzione. Questa timeline ti mostra i passaggi chiave, decennio dopo decennio.

Una delle tendenze più forti è l’automazione decisionale autonoma. I sistemi intelligenti non si limiteranno più a suggerire scelte: saranno in grado di prendere decisioni contestuali in tempo reale, basandosi su flussi costanti di dati. Questo ridefinirà ruoli e processi in settori come finanza, logistica, agricoltura di precisione, sanità predittiva. Le macchine non solo reagiranno, ma agiranno, alleggerendo l’intervento umano dove la velocità è cruciale.

Parallelamente, cresce la spinta verso la trasparenza algoritmica. La diffusione di sistemi automatici porta con sé la necessità di spiegare le decisioni. Per questo si affermeranno sempre di più le tecnologie di Explainable AI (XAI): modelli in grado di fornire motivazioni comprensibili delle proprie scelte, anche quando alla base ci sono reti neurali complesse. Questo sarà indispensabile in contesti pubblici, sanitari e finanziari.

Un altro fronte emergente è l’apprendimento continuo e adattivo. I modelli del futuro non saranno statici. Saranno in grado di aggiornarsi costantemente, di cambiare insieme ai dati, di adattarsi a nuovi comportamenti, condizioni e ambienti. Questo sarà fondamentale per sistemi in tempo reale, come la guida autonoma, la sicurezza informatica e il marketing predittivo.

Infine, si assiste a una crescente democratizzazione del machine learning. Librerie più semplici, modelli pre-addestrati e interfacce no-code stanno aprendo le porte dell’IA anche a chi non ha competenze di programmazione. Questo amplifica l’adozione da parte di startup, PMI e professionisti indipendenti, rendendo l’innovazione più accessibile, inclusiva e diffusa.

Il futuro del machine learning sarà dunque più autonomo, spiegabile, adattivo e inclusivo. Una tecnologia che non si limita a supportare l’innovazione, ma la guida attivamente, diventando una colonna portante della nuova società digitale.

Automazione, adattività e apprendimento continuo

Il machine learning sta compiendo un’evoluzione profonda: da strumento reattivo a sistema proattivo e intelligente. Se in passato si limitava ad analizzare dati e restituire risultati, oggi i modelli più avanzati sono in grado di prendere decisioni autonome, adattarsi a nuovi contesti e apprendere in tempo reale. Questa trasformazione si fonda su tre pilastri: automazione, adattività e apprendimento continuo.

L’automazione rappresenta la capacità di svolgere compiti complessi senza supervisione umana diretta. Non si tratta più solo di automatizzare operazioni ripetitive, ma di gestire attività ad alto valore: analisi di immagini mediche, classificazione documentale, ottimizzazione della supply chain, monitoraggio dei social media o rilevamento di anomalie in tempo reale. Questi sistemi non solo velocizzano i processi, ma migliorano l’accuratezza, scalano su larga scala e liberano risorse umane per attività a maggior impatto decisionale.

L’adattività è il cuore pulsante dell’AI moderna. Un sistema adattivo è in grado di interpretare variazioni nei dati, comprendere cambiamenti di contesto e ricalibrare il proprio comportamento per mantenere prestazioni elevate. In scenari dinamici come la cybersecurity, il trading algoritmico o la mobilità urbana, questa capacità di risposta immediata è essenziale. Il modello non è più fisso: si riconfigura, si riaddestra, si ottimizza in corsa.

Infine, il vero salto è dato dall’apprendimento continuo. Non si addestra un modello una volta sola: si costruisce un sistema che impara giorno dopo giorno, aggiorna le sue regole, corregge i propri errori, integra nuove fonti di dati e anticipa nuove esigenze. Questo approccio è fondamentale per evitare il cosiddetto data drift – il decadimento delle prestazioni nel tempo – e per mantenere un vantaggio competitivo costante.

L’unione di questi tre elementi sta dando forma a una nuova generazione di modelli: sistemi vivi, reattivi, intelligenti e autosufficienti, in grado di affrontare l’incertezza, crescere insieme ai dati e generare valore in modo continuo.

La democratizzazione del machine learning e l’accesso per tutti

Un tempo riservato a laboratori universitari, data scientist e colossi tecnologici, il machine learning sta vivendo un momento di democratizzazione reale. Oggi, questa tecnologia non è più dominio esclusivo di pochi esperti: sta diventando accessibile, sperimentabile, applicabile da chiunque abbia una buona idea e una connessione a internet.

Sul piano tecnico, questa rivoluzione è alimentata da piattaforme cloud sempre più user-friendly. Strumenti come Google Colab, Azure ML o AWS SageMaker offrono ambienti preconfigurati, modelli pre-addestrati e risorse scalabili, eliminando la necessità di hardware costoso o competenze avanzate. Basta un browser per iniziare a sperimentare con dataset reali e modelli predittivi professionali.

Accanto al cloud, stanno emergendo strumenti no-code e low-code che abbassano ulteriormente la soglia d’ingresso. Grazie a interfacce visuali, flussi guidati, librerie modulari e sistemi drag-and-drop, è possibile costruire modelli di machine learning funzionanti senza scrivere una sola riga di codice. Questo apre le porte dell’innovazione a designer, marketer, imprenditori, educatori, trasformandoli in creatori di soluzioni intelligenti.

Sul piano culturale, la spinta è ancora più forte. L’enorme disponibilità di corsi online gratuiti, MOOC, bootcamp, community open source e contenuti educativi accessibili consente a chiunque, in ogni parte del mondo, di formarsi rapidamente. Si passa da semplici curiosi a professionisti competenti in pochi mesi, con il solo investimento del proprio tempo.

Tuttavia, l’accesso diffuso implica anche una responsabilità maggiore. Democratizzare il machine learning significa anche diffondere consapevolezza etica, formare all’uso critico degli algoritmi, prevenire abusi e distorsioni. La tecnologia non è mai neutrale: il modo in cui viene costruita e utilizzata definisce l’impatto che avrà sulla società.

In questo contesto, la vera innovazione non risiede solo nei modelli o negli strumenti, ma nella possibilità che ogni individuo, indipendentemente dal background tecnico, possa contribuire alla costruzione di un futuro più intelligente, giusto e condiviso. È questa la forza della democratizzazione: fare spazio, non creare distanza.

Machine Learning e Intelligenza Artificiale: differenze, connessioni e complementarità

Machine learning e intelligenza artificiale sono due termini spesso usati come sinonimi, ma in realtà rappresentano due ambiti distinti e complementari. Comprendere la relazione tra questi concetti è fondamentale per orientarsi con chiarezza nel panorama delle tecnologie intelligenti e per sviluppare una visione realmente strategica nel loro utilizzo.

Per comprendere chiaramente come machine learning, deep learning e intelligenza artificiale si relazionano tra loro, guarda questa semplice infografica che ne mostra la struttura gerarchica in modo visivo ed efficace.

L’intelligenza artificiale (IA) è il campo più ampio. Comprende l’insieme delle tecniche, metodologie e approcci progettati per permettere alle macchine di riprodurre comportamenti che riteniamo “intelligenti”, come comprendere il linguaggio, risolvere problemi complessi, prendere decisioni autonome o interagire con l’ambiente circostante. L’obiettivo dell’IA non è solo eseguire compiti, ma farlo in modo razionale, flessibile e contestualmente consapevole.

All’interno di questo quadro generale, il machine learning rappresenta una sottoarea specifica, ma di enorme importanza. È l’approccio che consente ai sistemi di apprendere direttamente dai dati, senza istruzioni esplicite. Anziché essere programmato in ogni dettaglio, il sistema impara a riconoscere schemi e regole basandosi sull’esperienza e l’osservazione continua. È questo che rende il machine learning così potente, scalabile e adattivo.

A differenza dell’IA classica – spesso simbolica, basata su regole logiche e sistemi esperti – il machine learning utilizza modelli matematici e algoritmi statistici per generare conoscenza a partire da grandi volumi di informazioni. La sua forza sta proprio nella capacità di generalizzare, cioè di applicare ciò che ha imparato a situazioni nuove, mai viste prima.

Il rapporto tra machine learning e intelligenza artificiale è dunque profondamente sinergico. L’IA fornisce l’orizzonte, la visione, l’architettura complessiva. Il machine learning ne rappresenta il motore, la componente adattiva, il meccanismo evolutivo. Le due tecnologie si alimentano a vicenda: da un lato l’IA sfrutta la capacità predittiva del learning machine, dall’altro il machine learning trova contesti applicativi più ampi e articolati in cui operare.

Comprendere questa distinzione e allo stesso tempo la loro complementarità permette di affrontare con maggiore lucidità progetti complessi, valutare le soluzioni più adatte e integrare i modelli in ecosistemi tecnologici coerenti e funzionali. Perché nel futuro che ci attende, non sarà sufficiente saper costruire modelli intelligenti: occorrerà saperli inserire in sistemi capaci di ragionare, adattarsi e agire in modo consapevole.

Che cos’è davvero l’IA e dove finisce il machine learning

Quando si parla di intelligenza artificiale, l’immaginario collettivo tende ad associare il termine a macchine capaci di pensare come esseri umani. Ma questa visione, pur affascinante, è solo una parte del quadro. L’IA è in realtà un campo di ricerca molto più ampio, che comprende approcci, metodi e tecnologie anche molto diversi tra loro.

Un esempio emblematico è l’IA simbolica. Questa branca si basa su regole logiche esplicite, sistemi esperti e strutture semantiche. Qui la conoscenza viene formalizzata, scritta in forma di “se… allora…”, e le macchine ragionano attraverso inferenze deterministiche. È l’approccio alla base di molti sistemi diagnostici, motori di ricerca accademici, software legali o applicazioni regolamentate, dove l’ambiente è stabile e le regole sono chiare.

Per chiarire le differenze operative tra machine learning e intelligenza artificiale simbolica, ecco una tabella comparativa che mette in evidenza input, adattabilità e livello di spiegabilità.

| Tipo | Input richiesto | Capacità adattiva | Spiegabilità | Esempi pratici |

|---|---|---|---|---|

| Machine Learning | Grandi quantità di dati storici | Alta – apprende e si adatta in base ai dati | Limitata – spesso definito come “black box” | Sistemi di raccomandazione, riconoscimento facciale, diagnostica predittiva |

| IA Simbolica (basata su regole) | Regole logiche definite manualmente | Bassa – segue istruzioni fisse | Alta – ogni decisione è tracciabile e spiegabile | Motori fiscali, software legali, sistemi di diagnosi medica esperta |

Il machine learning, invece, appartiene a una famiglia diversa. Non parte da regole predefinite, ma dai dati. Apprende in modo probabilistico, ricercando correlazioni, pattern nascosti, relazioni non lineari. È perfetto per gestire l’incertezza, adattarsi a nuovi contesti e generalizzare da ciò che ha osservato. Il suo successo in ambiti come la classificazione di immagini, la previsione di comportamenti o l’analisi del linguaggio naturale ne ha fatto uno degli strumenti più utilizzati nel campo dell’IA.

Tuttavia, non tutto ciò che è IA è machine learning, e viceversa. Esistono sistemi intelligenti che non apprendono (come chatbot basati su regole) ed esistono modelli di machine learning che operano autonomamente, senza essere inseriti in architetture cognitive più ampie. Questa distinzione è fondamentale per evitare confusione nell’approccio progettuale.

Il confine tra le due aree è fluido, ma non per questo trascurabile. L’IA fornisce la visione, l’intento, il comportamento intelligente complessivo. Il machine learning ne è spesso il meccanismo di apprendimento sottostante, ma non necessariamente l’unico. Quando queste due anime si combinano in modo armonico, si ottengono i risultati più innovativi: sistemi capaci di adattarsi, ragionare e agire in ambienti complessi.

Capire dove finisce il machine learning e dove comincia l’IA significa anche comprendere due modi diversi di costruire intelligenza artificiale: uno deduttivo, basato su regole e logica, l’altro induttivo, basato su osservazione ed esperienza. E proprio dalla loro sinergia nasce la prossima generazione di sistemi intelligenti.

Quando usarli separatamente e quando integrarli

Capire la differenza tra intelligenza artificiale e machine learning non è solo una questione teorica: ha implicazioni pratiche che influenzano direttamente le scelte progettuali, i tempi di sviluppo e l’efficacia delle soluzioni tecnologiche. Saper riconoscere quando utilizzare uno, l’altro o entrambi è fondamentale per costruire sistemi realmente intelligenti, funzionali ed efficienti.

Il machine learning è la scelta ideale quando si ha una grande quantità di dati storici e si intende predire un comportamento, classificare informazioni o scoprire pattern nascosti. È perfetto per applicazioni dove la variabilità è alta e le regole non sono chiaramente definibili. Esempi concreti sono i sistemi di raccomandazione, le previsioni di vendita, le diagnosi mediche assistite e la manutenzione predittiva industriale.

L’intelligenza artificiale simbolica, invece, trova la sua forza in contesti regolamentati, dove le decisioni devono essere spiegabili, tracciabili e coerenti con normative formali. In ambiti come la finanza, il diritto, la contabilità o le procedure sanitarie, l’uso di regole esplicite permette di garantire trasparenza, conformità e affidabilità.

Ma è nella combinazione strategica delle due tecnologie che si esprime la loro massima potenza. Un modello di machine learning può generare previsioni, raccomandazioni, segmentazioni basate sui dati, che vengono poi interpretate, filtrate o attivate da un sistema esperto in base a regole definite. Allo stesso modo, un motore simbolico può richiamare modelli predittivi nei passaggi più critici di un flusso decisionale.

Integrare non significa sovrapporre. Significa progettare architetture ibride in cui ogni componente ha un ruolo preciso e complementare. Il machine learning apporta adattività, scalabilità, potere predittivo. L’intelligenza artificiale simbolica fornisce struttura, interpretabilità, governance.

Questa sinergia consente di costruire sistemi intelligenti evoluti, capaci non solo di apprendere dai dati, ma anche di motivare le proprie decisioni, adattarsi ai cambiamenti, rispettare vincoli e normative. È così che si realizzano applicazioni affidabili, sostenibili e realmente integrate nella vita reale.

Sapere quando usare separatamente e quando integrare queste due anime dell’intelligenza artificiale significa padroneggiare la complessità, ridurre i rischi progettuali e massimizzare l’efficacia tecnologica.

Conclusioni: perché il machine learning è una competenza chiave per il presente (e per il futuro)

Dopo aver esplorato cos’è il machine learning, come funziona, quali strumenti utilizza, in che ambiti si applica e quali sono le sue sfide e implicazioni etiche, emerge una consapevolezza netta: non si tratta solo di una tecnologia, ma di un nuovo paradigma per comprendere, progettare e trasformare la realtà.

Il machine learning ha già superato i confini dei laboratori e dei team di ricerca. È pienamente integrato nelle nostre vite quotidiane: nei motori di ricerca, negli algoritmi dei social media, nei consigli degli e-commerce, nei sistemi di traduzione, nella diagnostica sanitaria, nelle analisi di rischio, nella gestione predittiva delle infrastrutture. E lo fa in modo sempre più silenzioso, ma incisivo. È ovunque, anche quando non ce ne accorgiamo.

Comprendere il machine learning oggi – non solo dal punto di vista tecnico, ma anche strategico, culturale e sociale – significa dotarsi di uno strumento cognitivo essenziale per il presente. Significa capire come si prendono le decisioni automatizzate, anticipare dinamiche di mercato, sviluppare prodotti intelligenti, ottimizzare processi complessi. Ma anche assumersi la responsabilità etica di un uso consapevole, trasparente e inclusivo delle tecnologie intelligenti.

In un mondo che corre verso l’automazione, l’iper-personalizzazione e l’economia dei dati, il machine learning non è più un’opzione da valutare, ma una leva trasversale per l’innovazione e la competitività. È la base su cui si costruiscono nuovi modelli di business, nuovi prodotti, nuovi servizi. È il linguaggio della trasformazione digitale.

Ecco perché oggi non basta sapere che cos’è il machine learning. Occorre interiorizzarne le logiche, comprenderne i limiti, valutarne l’impatto sociale, e soprattutto imparare a integrarlo in modo intelligente e strategico nelle proprie attività. È questa la competenza chiave che distingue chi subisce il cambiamento da chi lo guida.

Il machine learning non definisce solo il futuro della tecnologia: contribuisce a scrivere il futuro della nostra società. E tu, da che parte vuoi stare?

Domande Frequenti sul Machine Learning

❓ Cos’è il machine learning e a cosa serve esattamente?

Il machine learning è un insieme di tecniche che permettono a un sistema informatico di apprendere dai dati senza essere programmato esplicitamente. Serve per creare modelli capaci di riconoscere pattern, fare previsioni e prendere decisioni in modo autonomo in una vasta gamma di settori, dalla medicina al marketing.

❓ Qual è la differenza tra machine learning e intelligenza artificiale?

L’intelligenza artificiale è il campo generale che comprende tutti i sistemi in grado di simulare comportamenti intelligenti. Il machine learning è una branca dell’IA che si concentra sull’apprendimento automatico dai dati attraverso modelli statistici. Tutto il machine learning è IA, ma non tutta l’IA è machine learning.

❓ Quali sono i principali tipi di apprendimento automatico?

tre principali tipi sono: apprendimento supervisionato, in cui il modello apprende da dati etichettati; apprendimento non supervisionato, che scopre pattern nascosti senza etichette; e apprendimento per rinforzo, dove il modello impara tramite ricompense e penalità.

❓ Come viene utilizzato il machine learning nella vita quotidiana?

Il machine learning è presente nei suggerimenti di Netflix, nella classificazione delle email, nei chatbot, nei motori di ricerca, nelle raccomandazioni di prodotto, nelle previsioni meteo e persino nei sistemi antifrode bancari. È integrato in molte esperienze digitali quotidiane, anche quando non ce ne accorgiamo.

❓ Che differenza c’è tra machine learning e deep learning?

Il deep learning è una sottocategoria del machine learning che utilizza reti neurali profonde ispirate al funzionamento del cervello umano. È particolarmente efficace per compiti complessi come il riconoscimento di immagini, la traduzione automatica e l’elaborazione del linguaggio naturale.

❓ Cosa significa overfitting e perché è un problema nei modelli?

L’overfitting si verifica quando un modello apprende troppo bene i dati di addestramento, perdendo la capacità di generalizzare su dati nuovi. È un problema perché rende il modello meno affidabile in contesti reali, eccessivamente rigido e non adattivo.

❓ Quali sono le metriche principali per valutare un modello di machine learning?

Le metriche più utilizzate includono l’accuratezza, la precisione, il recall, la F1-score e l’AUC-ROC. La scelta della metrica dipende dal tipo di problema e dagli obiettivi: in alcuni casi è più importante ridurre i falsi positivi, in altri i falsi negativi.

❓ Il machine learning può essere utilizzato anche da chi non sa programmare?

Sì, grazie agli strumenti no-code e low-code, oggi anche chi non ha competenze di programmazione può creare modelli di machine learning. Piattaforme come Google AutoML o Teachable Machine rendono il processo accessibile a studenti, professionisti e imprenditori.

❓ Quali sono i rischi etici legati al machine learning?

I principali rischi includono la riproduzione di bias nei dati, la mancanza di trasparenza nelle decisioni automatizzate, l’uso improprio delle informazioni personali e la possibilità di discriminazione automatica. È fondamentale adottare modelli spiegabili e valutare sempre l’impatto sociale delle tecnologie.

❓ Come iniziare a imparare il machine learning da zero?

Il percorso migliore inizia con la comprensione dei concetti base, come regressione, classificazione e reti neurali. Seguono i corsi online, le esercitazioni pratiche con Python, l’uso di dataset pubblici e la partecipazione a community. Anche senza un background matematico avanzato è possibile apprendere in modo efficace.