Hai mai avuto la sensazione che i dati sapessero più di quanto mostrano? In un’epoca in cui ogni clic, ogni transazione e ogni segnale viene registrato, i modelli predittivi emergono come strumenti fondamentali per trasformare questo rumore in intelligenza utile. Non si tratta solo di statistiche avanzate o formule complesse, ma di un vero e proprio cambio di paradigma nel modo in cui interpretiamo il futuro attraverso il presente.

Capire cosa sono i modelli predittivi significa avventurarsi in un territorio dove il passato non è un archivio, ma una mappa. Questi modelli, basati su tecniche di predictive modeling e predictive analytics, sfruttano serie storiche e pattern nascosti per anticipare comportamenti, eventi o tendenze. Che si tratti di prevedere l’abbandono di un cliente, il guasto di un macchinario o l’andamento di una campagna di marketing, il cuore pulsante rimane lo stesso: apprendere dai dati per prendere decisioni fondate su probabilità reali.

L’idea alla base di questi sistemi non è semplicemente quella di fornire una fotografia precisa del passato, bensì costruire una proiezione probabilistica del futuro. E qui entra in gioco il predittivo come significato, come funzione e come rivoluzione. Non si può parlare solo di “algoritmi” o “machine learning”: la vera chiave è l’integrazione di questi approcci all’interno di flussi operativi, dove la previsione diventa un asset strategico.

Domandarsi “cosa sono i sistemi predittivi?” non è più una curiosità tecnica, ma una necessità aziendale. Chi riesce ad adottarli con consapevolezza non ottiene soltanto vantaggi competitivi, ma riscrive le proprie logiche decisionali. Ogni modello, se ben progettato, porta con sé una capacità predittiva che va ben oltre le previsioni superficiali, aprendo a scenari dove l’incertezza viene contenuta e la conoscenza amplificata.

In questo articolo entreremo nel cuore di queste tecnologie, esplorandone i metodi, i vantaggi e le applicazioni più concrete. Lo faremo seguendo una linea guida scientifica e aggiornata, basata su criteri di efficacia, verificabilità e adattabilità. Perché oggi, più che mai, comprendere i modelli predittivi non è solo un’opzione: è un’abilità cruciale per chiunque voglia navigare con intelligenza nel mondo dei dati.

Fondamenti dei modelli predittivi

Comprendere i fondamenti dei modelli predittivi significa entrare in una nuova visione del dato: non più come archivio passivo, ma come sistema attivo, capace di trasformarsi in anticipazione. Non è una questione di quantità o di potenza computazionale, ma di capacità progettuale e logica.

Quando si parla di analisi modelli predittivi, si intende un insieme di approcci orientati a identificare strutture informative capaci di generare valore previsionale. Qui il concetto di predittività non è un’opinione statistica, ma un parametro strategico. È ciò che consente a un sistema di anticipare un comportamento, un’anomalia, una tendenza prima che emerga visibilmente.

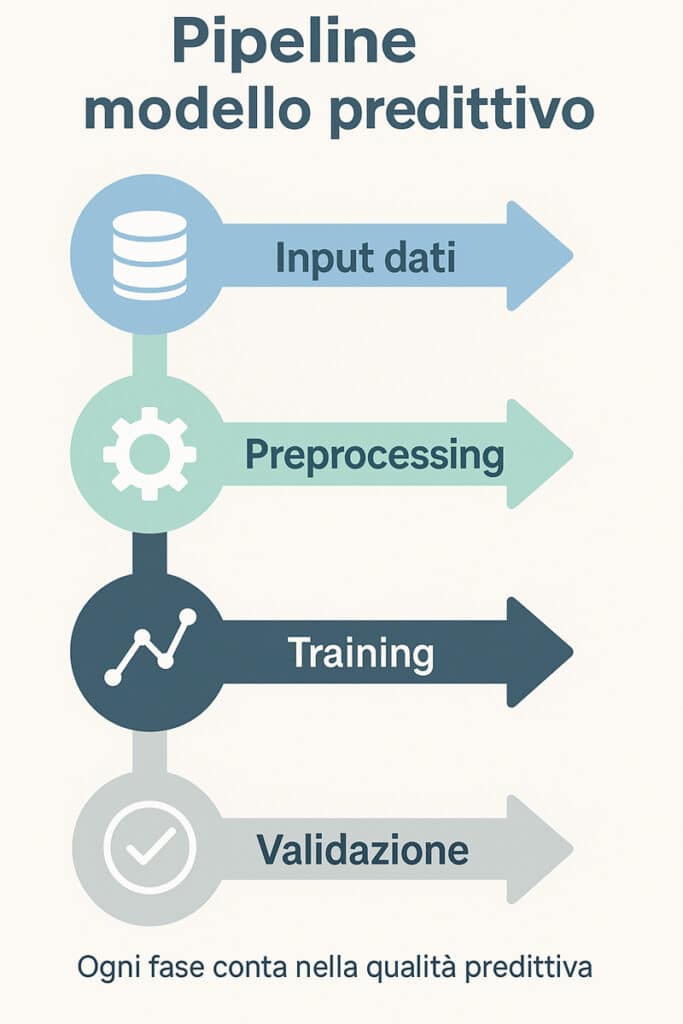

Per comprendere il flusso operativo alla base di un modello predittivo, osserviamo ora la pipeline completa rappresentata visivamente.

Il vero salto avviene nella comprensione di ciò che rende predittivo un modello: non è sufficiente raccogliere dati. È necessario selezionare fattori predittivi in grado di agire come variabili guida all’interno del contesto osservato. Una pipeline di valore nasce dall’accuratezza nelle fasi di data collection, dalla profondità nella data cleaning e dalla coerenza tra i blocchi della data pipeline. Non esiste modello predittivo efficace senza una struttura dati solida, continua e semanticamente stabile.

Domandarsi come funziona un modello predittivo significa immergersi in una serie di passaggi interdipendenti. Ogni scelta compiuta in fase preliminare – dal tipo di dato raccolto al modo in cui viene normalizzato – ha un impatto diretto sulla qualità della previsione. A fare la differenza non è solo l’algoritmo, ma l’intero flusso operativo in cui l’algoritmo è immerso.

Data quality, training e validazione non sono fasi isolate: sono lo scheletro su cui poggia l’intero impianto predittivo. Trascurarle significa compromettere il risultato prima ancora che venga calcolato. Per questo motivo, ogni approccio serio all’intelligenza predittiva parte da qui: dai fondamenti, dalla struttura, dalla disciplina che ne governa lo sviluppo.

Definizione, workflow e importanza dei dati

Definire con precisione cosa sono i modelli predittivi è il punto di partenza per qualsiasi strategia orientata all’analisi dei dati. Un modello predittivo è una struttura matematica o algoritmica in grado di generare una stima probabilistica di eventi futuri partendo da dati storici. Il suo obiettivo non è descrivere ciò che è accaduto, ma anticipare ciò che potrebbe accadere. La definizione di predittivo ruota attorno a un concetto chiave: imparare dai dati per influenzare il presente. In tal senso, il valore di un modello non risiede solo nei numeri che produce, ma nel modo in cui questi numeri si inseriscono nei processi decisionali.

All’interno di un sistema predittivo maturo, i dati grezzi devono essere trasformati in conoscenza strutturata. Questo processo non è banale e coinvolge pratiche complesse come l’ETL (Extract, Transform, Load), che permette di centralizzare, filtrare e rimodellare le informazioni. La feature engineering, ovvero la creazione e selezione di variabili informative, è uno degli snodi centrali della pipeline. Le decisioni prese in questa fase definiscono il livello di efficacia futura. La dataset preparation diventa quindi un vero e proprio atto strategico.

In ambito data mining, i modelli predittivi vengono spesso utilizzati per estrarre pattern e relazioni latenti da volumi di dati eterogenei. La previsione non nasce dal caso, ma da un’elaborazione strutturata e mirata. Il modello ha senso solo se è capace di interpretare il contesto, identificare variabili rilevanti e mantenerle coerenti lungo il tempo. Non si tratta di costruire un oggetto statico, ma un sistema adattivo.

Il valore predittivo di un sistema non è mai assoluto. Ogni modello è sensibile al contesto, ai vincoli e alla struttura interna dei dati che lo alimentano. Non basta disporre di molte informazioni: è fondamentale che siano pertinenti e coerenti. La solidità predittiva si costruisce nelle fasi invisibili: là dove si aggregano e si sintetizzano elementi dati. Solo chi padroneggia questi passaggi sarà in grado di sviluppare sistemi realmente intelligenti.

Pipeline: raccolta, pulizia, training e validazione

Un modello predittivo non si costruisce semplicemente scegliendo un algoritmo. Si costruisce lungo una pipeline precisa, articolata e logica che parte dalla raccolta dati, attraversa fasi critiche come la pulizia, l’addestramento e culmina nella validazione. Comprendere come creare un modello predittivo significa entrare nel merito di ogni passaggio operativo, valutando come ogni scelta possa incidere sul comportamento del sistema in fase di inferenza.

Tutto parte dalla data collection. Una raccolta disorganizzata o incoerente introduce errori strutturali che si propagano in tutte le fasi successive. La qualità dell’informazione iniziale rappresenta il primo atto predittivo. La successiva data cleaning mira a rimuovere inconsistenze, valori anomali, dati mancanti. È un momento in cui si separa il segnale dal rumore. Solo un dataset pulito può entrare in un processo di training efficace.

Durante la fase di addestramento, il modello apprende relazioni e pattern impliciti nei dati. Questo avviene attraverso processi iterativi che ottimizzano la sua capacità di previsione. È qui che entrano in gioco strumenti come la cross-validation, fondamentale per misurare la capacità del modello di generalizzare. Senza questo meccanismo, si rischia l’overfitting, ovvero un’eccessiva specializzazione sui dati noti.

Organizzazioni come IBM hanno sviluppato flussi standardizzati per gestire queste fasi in modo sistemico. Ogni passaggio viene documentato, testato e reiterato fino a raggiungere stabilità. Il preprocessing non si esaurisce nella fase iniziale: è un ciclo continuo, da aggiornare costantemente. Il monitoraggio continuo diventa essenziale in ambienti dinamici, dove i dati cambiano frequentemente. La capacità di aggiornarsi in modo automatico attraverso il retraining è ciò che garantisce efficacia duratura.

In questo quadro, la tracciabilità e il versionamento diventano componenti chiave della governance predittiva. Ogni iterazione del modello deve poter essere ricostruita, verificata e confrontata con le versioni precedenti. Questo approccio, ormai adottato dai maggiori framework professionali, permette di assicurare trasparenza, controllo e miglioramento continuo. Non si tratta solo di performance: si tratta di responsabilità algoritmica.

Metodi tradizionali e algoritmi base

I modelli predittivi non nascono con l’intelligenza artificiale contemporanea: affondano le loro radici in tecniche statistiche e matematiche classiche che hanno formato le fondamenta dell’analisi predittiva. I modelli previsionali tradizionali rappresentano la prima linea di strumenti per ogni analista, per la loro efficienza, semplicità e interpretabilità.

Per chiarire meglio le differenze tra le principali famiglie di modelli predittivi, osserviamo ora una sintesi comparativa illustrata.

L’utilizzo di questi approcci in contesti produttivi e scientifici ha consentito di affinare previsioni, migliorare la gestione dei processi, e ottimizzare le risorse. Molti modelli di questa categoria si basano su algoritmi predittivi consolidati: dalla regressione alla classificazione, passando per le analisi di serie temporali e il clustering.

La loro logica si fonda su relazioni statistiche e su dati storici, piuttosto che su apprendimento profondo. Per questo sono utilizzati anche come baseline nei confronti dei modelli più avanzati.

In questa prospettiva, non si tratta di una semplice eredità, ma di un’attualità ancora viva: i metodi tradizionali sono preferiti in scenari ad alta regolamentazione o quando la trasparenza del modello è essenziale. Non a caso, sono adottati nei settori sanitario, finanziario e industriale per via della loro robustezza interpretativa.

Questi approcci trovano applicazione in contesti dove i dati sono abbondanti ma la necessità di interpretazione è prioritaria. La regressione lineare, ad esempio, è ancora oggi impiegata in modelli previsionali per valutare l’andamento delle vendite o prevedere la domanda sanitaria.

Nonostante l’evoluzione degli algoritmi, la chiarezza offerta da questi metodi li rende fondamentali per il dialogo tra team tecnici e decisori strategici. La loro compatibilità con strumenti di business intelligence e ambienti di sviluppo semplificati ne ha favorito l’adozione su larga scala.

Inoltre, la capacità di rivelare relazioni causali dirette tra le variabili rappresenta un punto di forza cruciale. Non sono strumenti obsoleti, ma architravi di ogni architettura predittiva.

In un’epoca dominata da modelli opachi e algoritmi sempre più complessi, la semplicità strutturale di questi strumenti è una forma di sapienza ingegneristica stabile, capace di offrire previsioni affidabili con costi computazionali contenuti. La loro forza è la chiarezza, la coerenza, la concretezza predittiva.

Regressione, classificazione, time series e clustering

Tra gli approcci più utilizzati nei modelli predittivi di base si trovano regressione, classificazione, analisi di serie temporali e clustering. Questi metodi forniscono una solida base per costruire previsioni affidabili e rappresentano spesso il primo passo nell’analisi predittiva.

La regressione — sia lineare che logistica — è impiegata per modellare la relazione tra una variabile dipendente e una o più variabili indipendenti. È efficace nel prevedere valori numerici (come vendite, costi, performance) oppure, nella forma logistica, nel classificare eventi binari, ad esempio “acquisto” o “non acquisto”.

La classificazione amplia questa logica su variabili categoriali: modelli come Naive Bayes o k-Nearest Neighbors vengono adottati in ambiti come la diagnosi medica o la rilevazione di frodi, dove serve distinguere tra più classi in modo predittivo. La loro precisione dipende strettamente dalla qualità del dataset e dalla selezione delle feature.

Le serie temporali, invece, analizzano i dati distribuiti nel tempo. Tecniche come ARIMA, SARIMA o modelli autoregressivi vengono adottati per individuare pattern ciclici e tendenze future, soprattutto in ambiti come la meteorologia, la finanza e la gestione delle scorte. I dati devono però rispettare condizioni di stazionarietà e granularità costante.

Infine, il clustering non richiede variabili target: consente di scoprire segmentazioni naturali nei dati. Algoritmi come k-means, DBSCAN o gerarchici sono utilizzati per esplorare comportamenti simili, raggruppare utenti, individuare anomalie o ottimizzare strategie di marketing.

Tutti questi approcci condividono una struttura chiara, una robusta base matematica e un’alta efficienza computazionale. Sono quindi ideali in scenari dove si richiede predittività ma anche piena interpretabilità. In molte pipeline moderne, questi modelli fungono da benchmark per valutare l’efficacia di algoritmi più sofisticati.

Decision tree, reti neurali e ensemble methods

I decision tree rappresentano una delle forme più intuitive ed efficaci di apprendimento supervisionato nei modelli predittivi. La loro struttura gerarchica ad albero consente di suddividere progressivamente un dataset in sottogruppi coerenti, in base a test logici su variabili esplicite. Ogni nodo interno rappresenta una condizione decisionale, mentre ogni foglia definisce un esito. La forza di questi modelli risiede nella loro capacità di essere letti, compresi e spiegati senza necessità di decifrazione tecnica.

A fianco dei modelli ad albero, troviamo le reti neurali, ispirate alla struttura del cervello umano. Composte da strati di neuroni artificiali interconnessi, queste reti sono progettate per apprendere relazioni non lineari anche in contesti ad altissima dimensionalità. Il loro potenziale è emerso in scenari dove modelli classici falliscono, come l’elaborazione di immagini, suoni, testi e pattern comportamentali complessi. Tuttavia, la loro interpretabilità è ridotta: spesso vengono considerate “scatole nere”.

Per superare i limiti dei singoli modelli e migliorare la generalizzazione, si utilizzano tecniche come gli ensemble methods, che combinano più modelli deboli per ottenere una previsione complessiva più robusta. Il random forest è un esempio celebre: genera molteplici decision tree e ne aggrega le risposte. I metodi di boosting, come il gradient boosting, perfezionano progressivamente i modelli correggendo gli errori residui.

La selezione dei modelli da includere in un ensemble è cruciale: serve diversificare, non solo aggregare. Ogni singolo modello deve contribuire con una visione leggermente differente del problema, altrimenti il risultato collettivo risulta ridondante. Questo principio, noto come diversità degli apprenditori, è alla base dell’efficacia predittiva complessiva.

La robustezza degli ensemble methods emerge quando vengono integrati in una pipeline che prevede validazioni incrociate, tuning dei parametri e strategie di regolarizzazione. In un mondo in cui i dati sono sempre più eterogenei e i contesti decisionali sempre più dinamici, questi modelli offrono una forma di intelligenza collettiva predittiva, capace di adattarsi, apprendere e migliorare in continuo.

Tecniche emergenti e modelli predittivi avanzati

L’universo dei modelli predittivi si sta espandendo ben oltre i confini delle tecniche classiche, abbracciando approcci che rispondono alla crescente complessità dei dati, alla necessità di interpretabilità e alla domanda di personalizzazione. In questo scenario emergono tecnologie che promettono non solo maggiore precisione, ma anche una profonda trasformazione nel modo in cui i sistemi predittivi interagiscono con il mondo reale.

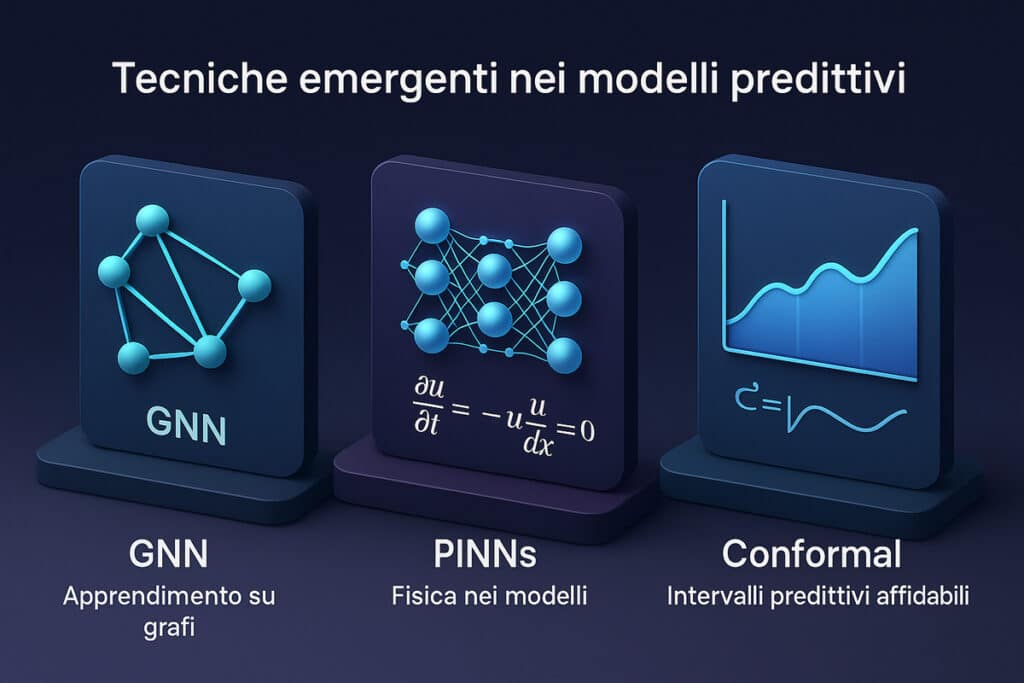

Modelli avanzati come la conformal prediction, le Physics-Informed Neural Networks (PINNs), le Graph Neural Networks (GNN) e l’AI causale offrono nuove modalità di comprensione delle relazioni nei dati, aprendo la strada a sistemi adattivi, robusti e più affidabili in condizioni di incertezza. Sono strumenti che incarnano un salto di paradigma: non semplici estensioni dei modelli predittivi precedenti, ma veri e propri ambienti matematici capaci di integrare conoscenza strutturale, fisica e causale nei processi di previsione.

Ecco una rappresentazione visiva delle principali tecniche emergenti utilizzate nei modelli predittivi di nuova generazione.

La conformal prediction, ad esempio, permette di produrre intervalli di confidenza adattivi su ogni singola previsione, migliorando significativamente la quantificazione dell’incertezza, elemento centrale in contesti come la medicina di precisione e il rischio finanziario. Le PINNs, invece, sfruttano equazioni differenziali note per vincolare l’apprendimento delle reti neurali, generando modelli predittivi coerenti con leggi fisiche, anche in assenza di dati completi.

Nel campo della rappresentazione dei dati strutturati, le Graph Neural Networks stanno rivoluzionando il modo in cui si analizzano relazioni complesse: reti sociali, connessioni biologiche, topologie urbane. Non si tratta solo di migliorare l’accuratezza, ma di interpretare la topologia nascosta nei dati.

Infine, l’AI causale non si limita a osservare correlazioni ma indaga le vere catene causali: una frontiera cruciale per costruire modelli predittivi realmente affidabili. Il suo utilizzo, in combinazione con la conformal prediction e le GNN, potenzia l’intera pipeline predittiva.

Tutti questi strumenti hanno un denominatore comune: rendere i modelli predittivi intelligenti, adattivi e consapevoli dei propri limiti. In un panorama in rapida evoluzione, costituiscono il cuore delle tecnologie predittive più avanzate e rappresentano il ponte tra AI moderna, scienza dei dati e inferenza di prossima generazione.

Conformal prediction, PINNs, causal AI e GNN

Nel cuore dell’evoluzione dei modelli predittivi, alcune tecniche stanno ridefinendo radicalmente la capacità delle macchine di gestire l’incertezza, apprendere da leggi fisiche e inferire causalità. La conformal prediction è una metodologia statistica che consente di costruire intervalli di predizione calibrati, fornendo non solo un output puntuale, ma un range di valori entro cui è altamente probabile che la previsione cada. Questo approccio risulta particolarmente utile nei settori in cui l’affidabilità delle previsioni è cruciale.

Accanto a questa, le Physics-Informed Neural Networks (PINNs) combinano la potenza delle reti neurali con vincoli fisici noti. Non imparano solo dai dati, ma incorporano conoscenze derivate da equazioni differenziali parziali, garantendo che le previsioni rispettino leggi naturali anche in assenza di dati completi. È un cambio di prospettiva profondo: si passa da una previsione estrattiva a una previsione vincolata dalla realtà fisica, cruciale in ingegneria, fisica computazionale e medicina.

Un’altra frontiera sono le Graph Neural Networks (GNN), modelli capaci di apprendere da dati rappresentati come grafi. A differenza delle reti neurali tradizionali, che elaborano dati tabellari o sequenziali, le GNN analizzano strutture connesse: relazioni tra pazienti e diagnosi, molecole e proprietà chimiche, utenti e comportamenti. La topological deep learning si fonda proprio su questa capacità: individuare pattern non solo nei nodi, ma nelle strutture complesse dei dati.

Infine, l’AI causale rappresenta il tentativo più ambizioso di trasformare correlazioni in conoscenza causale. L’utilizzo della causal inference permette di costruire modelli predittivi che vanno oltre la descrizione statistica e arrivano alla simulazione di scenari controfattuali.

Quando integrate all’interno di pipeline predittive complesse, queste tecniche non solo migliorano le performance, ma rendono il sistema più adattivo alle condizioni reali. In un panorama sempre più instabile, dove i dati possono cambiare nel tempo o risultare incompleti, l’adozione di conformal prediction, PINNs, GNN e causal AI costituisce una strategia resiliente. Sono queste le basi della nuova generazione di modelli predittivi intelligenti, capaci non solo di rispondere a una domanda, ma di contestualizzarla nel suo scenario causale, fisico e strutturale.

Federated learning e privacy-preserving AI

Nel contesto attuale, in cui i dati personali sono diventati risorsa e rischio, i modelli predittivi devono evolversi in direzione della privacy-preserving AI. Tra le tecnologie più innovative spicca il federated learning, un paradigma che consente di addestrare modelli predittivi distribuiti senza mai trasferire i dati grezzi. L’apprendimento avviene localmente, su dispositivi o nodi, e solo gli aggiornamenti dei modelli vengono aggregati centralmente.

Questo approccio ha un impatto decisivo in termini di protezione dei dati e rispetto delle normative come il GDPR, poiché riduce la necessità di centralizzare informazioni sensibili. È già impiegato in settori come la diagnostica mobile, le app sanitarie e l’analisi comportamentale in dispositivi edge. Tuttavia, questa architettura distribuita introduce nuove sfide: la sincronizzazione asincrona, la qualità eterogenea dei dati locali e il rischio di data drift sono problemi concreti.

I modelli predittivi in questo contesto devono adattarsi a condizioni operative variabili. I sistemi devono essere in grado di apprendere da fonti disomogenee mantenendo stabilità e robustezza nel tempo. Inoltre, le tecniche di differential privacy e secure multiparty computation stanno emergendo come strumenti chiave per garantire l’anonimizzazione e la sicurezza dei dati anche durante la fase di training.

L’edge computing gioca un ruolo cruciale: spostando parte dell’elaborazione vicino alla fonte del dato, si riducono latenze e si migliora la responsività del sistema. In ambito predittivo, questo consente una maggiore tempestività e localizzazione delle previsioni, elemento chiave per applicazioni mediche, industriali e nei trasporti autonomi.

Nei prossimi scenari operativi, sarà sempre più strategico disporre di modelli predittivi decentralizzati, capaci di apprendere anche in presenza di connessioni intermittenti, limiti hardware e standard normativi locali. Questo significa progettare sistemi adattivi, modulabili, ottimizzati per contesti edge e al tempo stesso allineati con i più recenti criteri di compliance algoritmica. La sfida non è solo tecnologica, ma culturale: serve ripensare l’intero ciclo di vita del modello predittivo con al centro la privacy e la fiducia.

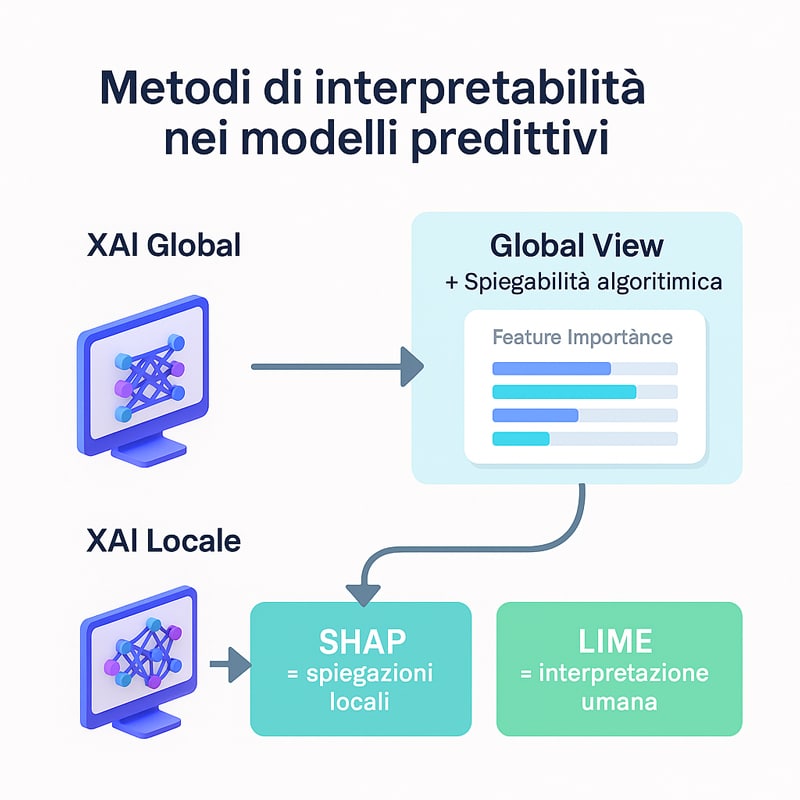

Interpretabilità, incertezza e aspetti XAI

Nel cuore dell’evoluzione dei modelli predittivi si nasconde un’esigenza sempre più pressante: la capacità di comprendere perché un algoritmo prende una certa decisione. La trasparenza decisionale non è più una qualità opzionale, ma un imperativo etico e tecnico. In un panorama in cui le analisi predittive influenzano ambiti critici come la salute, la finanza e la giustizia, serve un cambio di paradigma: non è più sufficiente che un modello predica bene, deve anche spiegare il proprio funzionamento.

Il concetto di incertezza nei modelli predittivi va ben oltre il margine di errore: riguarda la confidenza associata a ogni decisione, l’abilità di stimare quanto fidarsi di una previsione. Tecniche come gli intervalli predittivi conformi (conformal prediction intervals) permettono di visualizzare lo spettro di possibilità legate a un output. Questi intervalli non sono fissi, ma adattivi, legati ai dati osservati. Permettono di trasformare l’informazione predittiva in conoscenza utile per la scelta.

Per comprendere il funzionamento dei metodi di interpretabilità, osserviamo ora una panoramica visiva dei livelli XAI globale e locale nei modelli predittivi.

All’interno di contesti regolamentati, come quello sanitario e creditizio, le implicazioni dell’explainable AI (XAI) diventano ancora più complesse. Non basta rendere interpretabili le scelte: bisogna giustificare le motivazioni alla base di ogni output, garantire che non vi siano discriminazioni implicite.

Strumenti come SHAP, LIME e i modelli controfattuali non servono solo a comprendere, ma anche a dimostrare l’assenza di bias strutturali. Il passaggio da sistemi opachi a modelli leggibili rende possibile una governance algoritmica efficace, basata su accountability e spiegabilità.

L’adozione sistematica di strumenti XAI non è solo un atto tecnico, ma un gesto di fiducia verso l’utente finale. Solo così è possibile costruire un’intelligenza artificiale giustificabile nei suoi processi decisionali, anche quando l’output è incerto. Un modello predittivo capace di spiegarsi è un modello che può essere accettato, integrato e controllato.

Quantificazione dell’incertezza e Intervalli predittivi

La capacità di un modello predittivo di quantificare l’incertezza delle proprie previsioni è diventata una prerogativa irrinunciabile in settori ad alto impatto. La semplice previsione puntuale non è più sufficiente: ciò che oggi viene richiesto a un sistema predittivo è di indicare con quale grado di sicurezza stia producendo un output.

Tecniche come la conformal prediction rappresentano uno dei progressi più rilevanti in quest’ambito. Attraverso questa metodologia, è possibile costruire intervalli predittivi conformi — regioni adattive attorno al valore stimato — che garantiscono una copertura statistica coerente con il livello di confidenza desiderato. Rispetto agli intervalli di confidenza tradizionali, quelli conformi sono distribuzionalmente agnostici, cioè non richiedono ipotesi forti sulla distribuzione sottostante dei dati.

Questa proprietà rende i modelli predittivi non solo più robusti, ma anche più trasparenti: l’utente non riceve semplicemente una risposta, ma una mappa delle possibilità plausibili. La differenza tra una previsione rigida e una dotata di confidence bands sta proprio nella capacità di rappresentare l’ambiguità insita nei dati. Quando un modello è in grado di dichiarare esplicitamente la propria incertezza, si aprono nuove opportunità in termini di stima del rischio, calibrazione operativa e decisionalità umana.

Un altro aspetto cruciale è l’uso degli ensemble calibrati per migliorare la rappresentazione dell’incertezza nei modelli predittivi. Tecniche come la bagging-based uncertainty o l’uso di dropout in reti neurali permettono di stimare una varianza predittiva significativa anche in sistemi ad alta complessità. Questo permette di integrare la stima dell’incertezza direttamente nella logica di inferenza, fornendo predizioni più cautelative nei casi limite.

L’impiego sistematico di queste metodologie è oggi una delle direttrici strategiche per l’adozione responsabile della predictive AI.

Metodi avanzati di interpretabilità nel settore sanitario e creditizio

La trasparenza dei modelli predittivi assume un ruolo critico nei settori dove le decisioni automatizzate impattano direttamente la vita delle persone. In ambito sanitario e finanziario, infatti, non basta avere un modello preciso: è necessario che le sue scelte siano comprensibili, tracciabili e difendibili.

Strumenti come LIME (Local Interpretable Model-agnostic Explanations) e SHAP (SHapley Additive exPlanations) sono stati sviluppati proprio per rispondere a questa esigenza. Permettono di analizzare localmente il contributo delle singole feature alla previsione finale, fornendo una spiegazione post-hoc anche in presenza di modelli complessi come le reti neurali profonde o gli ensemble methods.

Nel contesto sanitario, questa interpretabilità può fare la differenza tra accettare o rifiutare un trattamento consigliato da un sistema di supporto decisionale. Un paziente o un medico che comprende il “perché” dietro una raccomandazione avrà maggiore fiducia nel modello. Lo stesso principio si applica nel credito al consumo, dove l’uso di spiegazioni controfattuali permette di rispondere a domande cruciali come: “cosa sarebbe cambiato se il reddito del richiedente fosse stato più alto?”

Oltre alla comprensibilità, questi metodi facilitano l’individuazione di bias nascosti. Se alcune variabili influenzano sistematicamente l’output in modo discriminatorio, gli strumenti XAI possono segnalarlo, contribuendo al miglioramento del modello e alla tutela della fairness.

Non va trascurato il ruolo crescente dei criteri normativi come il Regolamento Europeo sull’IA, che impongono requisiti espliciti di spiegabilità per ogni modello utilizzato in processi decisionali automatizzati ad alto rischio. In questo scenario, la capacità di spiegare le decisioni predittive non è solo una questione etica o tecnica, ma un vincolo legale che impatta su progettazione, audit e deployment dei sistemi.

La combinazione tra strumenti XAI e requisiti normativi getta le basi per un nuovo ecosistema predittivo: non solo più trasparente, ma anche conforme e verificabile.

Implementazione operativa e MLOps

L’adozione dei modelli predittivi non si esaurisce con la fase di sviluppo algoritmico: inizia, anzi, una nuova complessità quando si passa all’implementazione operativa. Il deployment di un modello predittivo nel mondo reale richiede un’infrastruttura tecnica e metodologica capace di sostenere la continuità, la scalabilità e l’evolutività nel tempo. Qui entra in gioco il paradigma MLOps, che rappresenta la convergenza tra machine learning, ingegneria del software e operazioni DevOps.

Per visualizzare come si struttura operativamente un flusso MLOps in un sistema predittivo, osserviamo il mockup seguente.

Una pipeline predittiva moderna non può prescindere da un’integrazione continua (CI) e da un rilascio continuo (CD) dei modelli. Questo consente di aggiornare i modelli con nuovi dati in modo fluido, mantenendo coerenza tra ambiente di sviluppo e produzione. Piattaforme come MLflow, Kubeflow e TFX sono oggi i riferimenti principali per costruire architetture in grado di gestire l’intero ciclo di vita del modello: dal tracciamento delle metriche alla registrazione dei modelli fino al monitoraggio in produzione.

In parallelo, la gestione del data drift è una delle priorità emergenti. Non è sufficiente addestrare un modello su dati storici: bisogna garantire che esso resti affidabile anche quando il contesto cambia. Questo implica la necessità di sistemi di allerta che rilevino variazioni nei pattern dei dati in tempo reale, evitando che il modello perda efficacia in modo silente.

Ogni decisione infrastrutturale deve considerare anche l’impatto energetico e la sostenibilità computazionale. In uno scenario in cui l’adozione massiva dell’AI può generare costi ambientali non trascurabili, l’ottimizzazione delle risorse (CPU, GPU, memoria) diventa un elemento chiave della progettazione. Le pratiche di Green AI si stanno affermando come standard responsabile nell’implementazione di sistemi predittivi industriali.

Questa transizione verso una gestione operativa intelligente dei modelli predittivi comporta anche un cambiamento culturale nelle organizzazioni. Serve una governance condivisa tra data scientist, ingegneri del software e responsabili IT, capace di trasformare i modelli da prototipi accademici in strumenti funzionali, affidabili e mantenibili nel tempo.

Pipeline MLOps e infrastrutture scalabili

La trasformazione di un algoritmo predittivo in un sistema operativo affidabile dipende dalla costruzione di una pipeline MLOps solida, progettata per gestire con efficienza il ciclo di vita del modello. L’obiettivo non è solo sviluppare un modello accurato, ma anche garantirne la riproducibilità, la tracciabilità e l’adattabilità nel tempo. Il cuore di questa trasformazione è rappresentato dalle pratiche di CI/CD: l’integrazione continua e il rilascio continuo dei modelli predittivi, supportati da repository versionati, test automatici e deployment controllati.

Un ecosistema MLOps maturo prevede componenti modulari: un model registry per tenere traccia delle versioni validate, strumenti di monitoring automatico per rilevare degrado delle prestazioni, e un sistema di rollback per rilasci controllati. L’utilizzo di container come Docker e orchestratori come Kubernetes rende possibile il deployment scalabile su infrastrutture cloud o ibride, aumentando la disponibilità e la resilienza operativa.

L’infrastruttura sottostante diventa così un elemento strategico nella vita dei modelli predittivi. È necessario garantire l’indipendenza tra codice, dati e ambienti, evitando che piccole modifiche compromettano la stabilità complessiva del sistema. Questo approccio si traduce in un paradigma DevOps esteso al machine learning, dove la collaborazione tra team tecnici e data scientist è supportata da processi automatizzati e ambienti riproducibili.

Un ulteriore elemento spesso trascurato è l’automazione dei test per la validazione del comportamento predittivo. Prima di essere rilasciato in produzione, un modello dovrebbe essere sottoposto a verifiche strutturate non solo sulla performance, ma anche sulla robustezza rispetto a dati perturbati e alla stabilità delle previsioni nel tempo.

Questo implica la costruzione di test unitari per i componenti del flusso ML, nonché la simulazione di scenari edge-case. Strumenti come Great Expectations o Evidently AI supportano la definizione di questi protocolli, rendendo il processo conforme a requisiti di affidabilità industriale.

Gestione dati, monitoraggio, drift e sostenibilità dei modelli predittivi

Il funzionamento stabile e affidabile di un sistema predittivo in produzione dipende in modo cruciale dalla qualità dei dati in input e dalla sua capacità di adattarsi ai cambiamenti nel tempo. I modelli predittivi, per quanto accurati, possono perdere efficacia se i dati cambiano. Questo fenomeno prende il nome di data drift e rappresenta una delle principali minacce operative nella predictive analytics.

Monitorare il drift significa rilevare deviazioni statisticamente significative tra i dati storici usati per l’addestramento e i dati in tempo reale. Strumenti come evidently, NannyML o meccanismi personalizzati di drift detection consentono di intercettare tempestivamente segnali deboli, evitando che la qualità delle previsioni si deteriori. Ma la sola rilevazione non basta: servono strategie adattive che permettano di retrainare i modelli predittivi in modo continuo o on-demand, garantendo resilienza operativa.

Oltre alla variabilità dei dati, un ulteriore aspetto riguarda il monitoraggio delle metriche di performance e l’uso responsabile delle risorse computazionali. In un contesto in cui l’AI si diffonde a larga scala, emerge l’esigenza di contenere il consumo energetico e ottimizzare l’efficienza delle pipeline. Questo porta alla nascita di pratiche come la Green AI, che promuove l’uso di modelli leggeri, tecniche di pruning, quantizzazione e deployment edge.

La dimensione economica gioca anch’essa un ruolo chiave. Ottimizzare i costi computazionali senza sacrificare l’accuratezza predittiva è una sfida concreta. Tecniche come il dynamic model selection, la compressione adattiva e l’utilizzo di modelli ensemble solo quando necessario permettono di ridurre il consumo di energia e i tempi di inferenza, senza compromettere la qualità.

La sostenibilità non riguarda solo l’ambiente, ma anche la scalabilità finanziaria dei progetti di intelligenza artificiale predittiva.

L’integrazione tra gestione del drift, ottimizzazione energetica e architetture elastiche rappresenta oggi un fattore predittivo per la sostenibilità operativa dei sistemi intelligenti. Le organizzazioni che investono in infrastrutture capaci di bilanciare precisione, costi e impatto ambientale si pongono in una posizione privilegiata rispetto alla concorrenza. I modelli predittivi più efficaci non sono quelli solo più accurati, ma quelli più resilienti, sostenibili e governabili nel tempo.

Casi verticali e applicazioni avanzate dei modelli predittivi

I modelli predittivi stanno evolvendo da strumenti teorici a soluzioni ad alto impatto operativo in diversi settori verticali, dimostrando la loro capacità di adattarsi a contesti altamente specializzati. Le applicazioni reali non si limitano più a casi generici di business intelligence, ma si spingono in profondità in ambiti come meteorologia, farmaceutica, sanità, automotive e industria 4.0.

Nel campo della previsione meteorologica, ad esempio, l’impiego di modelli ensemble permette di combinare simulazioni multiple per ottenere scenari climatici più robusti. Organizzazioni come l’ECMWF (European Centre for Medium-Range Weather Forecasts) utilizzano reti neurali profonde e simulazioni numeriche integrate per prevedere eventi estremi con maggiore accuratezza.

Nel settore sanitario e farmaceutico, l’adozione dei modelli predittivi sta trasformando la diagnostica e lo sviluppo dei farmaci. In oncologia, approcci in silico come quelli proposti da DeepMind accelerano l’identificazione di strategie terapeutiche. Nei laboratori farmaceutici, i modelli di virtual screening basati su tecniche di machine learning consentono di individuare molecole promettenti riducendo drasticamente tempi e costi di sperimentazione.

Anche l’ambito del process mining sfrutta oggi modelli predittivi per anticipare colli di bottiglia, anomalie e ritardi nei flussi operativi complessi. L’interazione tra dati di processo e algoritmi di apprendimento automatico consente di ottimizzare l’efficienza in tempo reale, supportando decisioni strategiche data-driven.

Un altro aspetto cruciale riguarda la disponibilità di dataset di dominio, spesso limitata o soggetta a forte rumore. La progettazione dei modelli predittivi in questi contesti richiede quindi una fase preliminare di ingegnerizzazione delle feature estremamente accurata, e l’impiego di algoritmi robusti alla scarsità o eterogeneità dei dati. Tecniche come il transfer learning e l’adaptive fine-tuning possono contribuire ad aumentare l’efficacia dei modelli in ambienti complessi e dinamici.

La collaborazione tra esperti di dominio, data scientist e sviluppatori AI è fondamentale per generare valore reale. I modelli predittivi di nuova generazione, per avere un impatto tangibile, devono superare la semplice accuratezza statistica e diventare strumenti integrati nei flussi decisionali quotidiani delle organizzazioni.

Meteorologia, sanità, pharma e process mining

Nel panorama applicativo dell’intelligenza artificiale, i modelli predittivi stanno diventando strumenti essenziali per settori complessi come meteorologia, sanità, industria farmaceutica e process mining. Ognuno di questi ambiti presenta peculiarità profonde che richiedono una configurazione mirata degli algoritmi e una conoscenza approfondita dei processi sottostanti.

In ambito meteorologico, la combinazione tra modelli ensemble e deep learning ha permesso una svolta nella previsione climatica. Strutture come quelle adottate dal centro ECMWF sfruttano simulazioni multiple, integrate con reti neurali ricorrenti, per ottenere previsioni più stabili. L’uso di tecniche di assimilazione dati migliora l’inizializzazione dei modelli, aumentando la robustezza delle previsioni in condizioni estreme.

Nel settore sanitario, l’emergere dell’oncologia computazionale in silico ha aperto a scenari innovativi. Sistemi basati su AI come quelli implementati da DeepMind sono capaci di analizzare enormi volumi di dati clinici, genomici e radiologici per suggerire protocolli personalizzati. In particolare, i modelli predittivi consentono una valutazione anticipata della risposta ai trattamenti e una stratificazione più accurata del rischio.

La drug discovery beneficia enormemente di modelli predittivi applicati al virtual screening, con reti neurali convoluzionali addestrate su database molecolari. Questo approccio riduce il ciclo di R&D e permette di identificare lead compound con un’efficacia potenziale elevata.

Nel process mining, i modelli predittivi trovano impiego nel mappare e anticipare l’evoluzione dei processi aziendali. Integrando algoritmi di time-series con dati di log, è possibile intercettare colli di bottiglia, anomalie o ritardi prima che si verifichino. Questo porta a un’ottimizzazione in tempo reale delle operations, supportando una gestione reattiva e proattiva dei flussi produttivi.

Un altro elemento chiave è la disponibilità di dati etichettati di alta qualità. In contesti medici e chimici, la presenza di dataset ben curati migliora la generalizzazione del modello. Inoltre, la collaborazione tra data scientist e specialisti clinici consente di validare i modelli in scenari reali, evitando l’overfitting su dati sintetici o teorici. Questo approccio condiviso garantisce che i modelli predittivi possano non solo analizzare, ma anche agire in modo affidabile all’interno di ambienti critici.

IoT, veicoli autonomi e manutenzione predittiva

L’integrazione dei modelli predittivi nei sistemi intelligenti dell’Internet of Things (IoT) e nei veicoli autonomi rappresenta una delle frontiere più avanzate dell’intelligenza artificiale applicata. In questi scenari, la capacità di anticipare eventi critici, malfunzionamenti o condizioni operative anomale diventa una leva strategica per la sicurezza, l’efficienza e la continuità operativa.

Nel contesto industriale, la manutenzione predittiva sta sostituendo i modelli reattivi e programmati. Sensori distribuiti su macchine e infrastrutture raccolgono continuamente dati vibrazionali, termici e acustici che vengono elaborati in tempo reale da algoritmi di machine learning. Il modello predittivo, una volta addestrato, segnala la probabilità di guasto imminente, consentendo interventi mirati solo quando necessari. Questo approccio riduce i tempi di fermo, ottimizza l’uso delle risorse e allunga la vita utile degli impianti.

Nel campo della mobilità autonoma, i veicoli integrano modelli predittivi per stimare il comportamento di pedoni, altri veicoli e condizioni stradali. Grazie all’elaborazione edge e a reti neurali ottimizzate per il low latency, è possibile aggiornare le previsioni in millisecondi, migliorando la reattività e la sicurezza su strada. L’impiego di edge AI consente inoltre di decentralizzare il calcolo, aumentando la resilienza e riducendo la dipendenza dal cloud.

La disponibilità di dati massivi provenienti da dispositivi IoT apre anche nuove prospettive per il condition monitoring e il controllo predittivo in settori come logistica, energia e agricoltura di precisione. Le aziende che riescono a integrare questi modelli nei propri sistemi gestionali ottengono vantaggi in termini di efficienza, sostenibilità e riduzione dei costi.

Un’ulteriore frontiera è rappresentata dalla manutenzione predittiva multi-variate, che considera simultaneamente dati ambientali, comportamentali e storici per affinare le previsioni. L’integrazione tra sensori edge e cloud ibrido consente l’aggiornamento continuo dei modelli predittivi in base alle condizioni operative in tempo reale, migliorando l’adattabilità in ambienti dinamici.

Questi sistemi sono ormai alla base della transizione verso l’industria 5.0, in cui le macchine non solo rispondono, ma prevedono e collaborano, anticipando le necessità operative con una precisione mai vista prima.

Sfide etiche, governance e sostenibilità nei modelli predittivi

La crescente diffusione dei modelli predittivi all’interno di ecosistemi decisionali sempre più automatizzati impone una riflessione profonda sulle implicazioni etiche, normative e ambientali. Non si tratta solo di perfezionare gli algoritmi dal punto di vista tecnico, ma di costruire strutture trasparenti, responsabili e sostenibili che garantiscano la fiducia degli utenti e la conformità ai principi fondamentali della società.

Uno dei principali nodi critici è rappresentato dalla predittività mal calibrata su dati parziali o distorti, che può generare conseguenze discriminatorie. La questione del bias algoritmico assume particolare rilevanza nei settori finanziario, sanitario e giudiziario, dove un modello predittivo scorretto può rafforzare pregiudizi sistemici, perpetuare disuguaglianze e compromettere l’equità delle decisioni automatizzate. Il concetto di algorithmic fairness richiede quindi un’analisi continua e approfondita dei dataset, delle metriche utilizzate e degli impatti sistemici.

Per sintetizzare visivamente le tre aree chiave che definiscono l’etica nei modelli predittivi, ecco una rappresentazione grafica tematica.

Accanto alla dimensione etica, si apre quella normativa. La data governance moderna deve affrontare la sfida di bilanciare l’innovazione con la tutela della privacy e la trasparenza. I regolamenti emergenti promuovono la tracciabilità dei processi decisionali basati su AI, ponendo l’accento su requisiti di spiegabilità e auditabilità. L’applicazione di queste normative richiede un ripensamento delle pipeline di sviluppo dei modelli predittivi, affinché ogni passaggio sia documentato e revisionabile.

Un ulteriore livello di complessità riguarda la sostenibilità ambientale. L’addestramento di reti neurali profonde o modelli di ensemble richiede un’enorme quantità di risorse computazionali, con un impatto diretto sulla carbon footprint del sistema. In questo scenario, l’efficienza energetica diventa una metrica tanto rilevante quanto la precisione. Approcci come la green AI, l’ottimizzazione algoritmica e l’adozione di infrastrutture distribuite mirano a ridurre l’impatto ambientale pur mantenendo performance elevate.

È inoltre fondamentale considerare la dimensione della responsabilità collettiva: sviluppatori, stakeholder e legislatori devono cooperare nella definizione di standard condivisi. Solo attraverso una governance partecipata, e strumenti di valutazione come gli audit indipendenti, sarà possibile garantire che l’evoluzione dei modelli predittivi rimanga allineata ai valori umani fondamentali.

Bias, governance e regolamentazione

La crescente adozione di modelli predittivi nei sistemi automatizzati ha posto in evidenza un’urgenza etica: quella di garantire l’equità e la trasparenza delle decisioni algoritmiche. Molti modelli, se non opportunamente monitorati, tendono a riflettere e amplificare i bias insiti nei dati su cui sono addestrati. In ambiti come credito, selezione del personale o sanità, un errore predittivo non è solo una stima sbagliata: può significare discriminazione sistemica.

La nozione di algorithmic fairness impone una revisione del concetto stesso di accuratezza, che non può più essere valutata solo in termini numerici, ma anche morali e sociali. È qui che entrano in gioco strumenti di bias mitigation, capaci di identificare e ridurre i pregiudizi durante o dopo la fase di addestramento del modello. Tecniche come la reweighting dei dati, l’analisi delle distribuzioni condizionate o le verifiche post-hoc vengono integrate nei flussi MLOps per assicurare maggiore bilanciamento.

Sul fronte normativo, regolamenti come il GDPR hanno spinto verso una maggiore attenzione alla spiegabilità delle decisioni automatizzate. L’esigenza di una AI etica si traduce nella necessità di auditabilità costante e rendicontazione trasparente. Le piattaforme moderne devono dunque prevedere non solo modelli accurati, ma anche sistemi capaci di documentare ogni passaggio della pipeline, dalle feature utilizzate ai pesi finali, con metodi compatibili con i principi della privacy by design.

La tracciabilità si fonde con la governance dei dati, che implica una gestione controllata degli accessi, una documentazione rigorosa e una visione strategica della qualità del dato. Entità come Red Hat o Investopedia hanno promosso linee guida per costruire modelli responsabili, mostrando come l’allineamento tra etica, compliance e tecnologia non sia solo auspicabile, ma necessario per garantire la fiducia nel modello predittivo.

Inoltre, è indispensabile introdurre percorsi formativi per team cross-funzionali che lavorano con i modelli, al fine di rafforzare la consapevolezza sui rischi etici e giuridici associati all’AI predittiva.

Impronta ambientale e sostenibilità

L’espansione dei modelli predittivi ha portato con sé una crescente preoccupazione riguardo al loro impatto ambientale. Addestrare reti neurali profonde, ensemble complessi o modelli con milioni di parametri richiede una quantità significativa di potenza di calcolo, spesso erogata da data center ad alta intensità energetica.

La green AI si è sviluppata proprio per affrontare questa problematica, promuovendo algoritmi efficienti dal punto di vista computazionale, senza compromettere le prestazioni predittive. Tra le soluzioni emergenti vi sono approcci che ottimizzano l’architettura del modello in base all’efficienza energetica, non solo alla precisione, e strategie di pruning per ridurre il numero di parametri mantenendo l’efficacia del modello.

Un altro elemento critico è la misurazione dell’impronta di carbonio associata all’intero ciclo di vita del modello predittivo, dalla fase di training fino all’inferenza. Le metriche standard per la carbon footprint stanno diventando parte integrante delle valutazioni di sostenibilità AI, influenzando anche le decisioni di deployment in funzione della disponibilità di energia rinnovabile nei data center.

La sostenibilità non è solo una questione di emissioni: riguarda anche la gestione intelligente delle risorse computazionali, la scalabilità controllata, l’adozione di pratiche energy-efficient e la scelta di architetture modulari. In questo senso, modelli predittivi eseguiti su edge device o in ambienti federati offrono vantaggi sostanziali, riducendo la latenza, il traffico dati e la dipendenza dal cloud centralizzato.

Progetti di machine learning sostenibile, in cui l’ottimizzazione delle risorse diventa parte del design iniziale del modello, stanno emergendo come standard auspicabili. La combinazione tra prestazioni elevate e responsabilità ambientale costituisce oggi un valore competitivo strategico.

Anche la scelta dei linguaggi e delle librerie può incidere sull’efficienza: framework ottimizzati come JAX o ONNX permettono di eseguire modelli predittivi in maniera più efficiente rispetto a implementazioni generiche. Parallelamente, l’uso di hardware dedicato come i TPU consente una drastica riduzione dei tempi di training e del consumo energetico.

Questi elementi rendono evidente come la progettazione di modelli predittivi non possa più ignorare la sostenibilità: deve essere un pilastro sin dalle prime fasi del design.

Conclusione: roadmap per un approccio completo ai modelli predittivi

Affrontare in modo consapevole e strategico il mondo dei modelli predittivi significa costruire una visione integrata tra potenzialità algoritmica, impatto etico e sostenibilità operativa. Un modello efficace non si limita a fornire previsioni accurate: diventa strumento di governance decisionale, innovazione continua e adattamento intelligente al contesto.

Dalla comprensione di come funziona un modello predittivo, passando per la sua corretta costruzione, fino alla scelta delle architetture computazionali e delle pratiche etiche, ogni fase richiede rigore, metodo e allineamento con obiettivi concreti. Integrare i fondamenti teorici con l’esperienza sul campo, utilizzare le metriche giuste, analizzare la qualità dei dati e interrogarsi sulla spiegabilità del modello rappresentano elementi non negoziabili per raggiungere un equilibrio stabile tra efficacia e responsabilità.

All’interno di una roadmap operativa, la prima fase è dedicata alla raccolta, pulizia e valutazione dei dati. La fase successiva riguarda la modellazione, con particolare attenzione alle scelte tra algoritmi tradizionali e tecniche avanzate. L’implementazione concreta passa quindi attraverso una pipeline MLOps ben definita, con CI/CD, controllo delle dipendenze, tracciabilità e gestione dell’overfitting.

Parallelamente, un modello davvero maturo prevede momenti di validazione continua, aggiornamento in tempo reale e gestione proattiva del drift. La capacità di adattarsi a nuove condizioni e di preservare la propria affidabilità nel tempo è il segno distintivo di un’AI ben progettata. I modelli predittivi migliori sono quelli che evolvono con i dati, non che si fossilizzano su un dataset passato.

La consapevolezza delle sfide etiche, la valutazione dell’impatto ambientale, la capacità di interpretare le previsioni e di comunicarle in modo chiaro ai decisori sono parte integrante di questo percorso. Non è più sufficiente creare un modello predittivo tecnicamente valido. Serve progettare sistemi che interagiscano in modo trasparente, interpretabile e responsabile con il mondo reale.

In definitiva, padroneggiare i modelli predittivi oggi richiede molto più di competenze tecniche. Serve una visione trasversale, multidisciplinare e continuamente aggiornata. È in questo approccio olistico, che integra conoscenza, etica e sostenibilità, che si colloca la vera frontiera della predictive intelligence.

Domande frequenti sui modelli predittivi: guida completa alle risposte chiave

❓Che cosa sono i modelli predittivi e come funzionano?

I modelli predittivi sono strumenti che utilizzano dati storici per prevedere eventi futuri. Funzionano tramite algoritmi che apprendono correlazioni nei dati e generano risultati su situazioni non ancora osservate.

❓Come si crea un modello predittivo passo dopo passo?

Per creare un modello predittivo servono: raccolta dati, pulizia, scelta dell’algoritmo, addestramento, validazione e test. Ogni fase incide sulla precisione e sulla robustezza del modello finale.

❓Quali sono i principali algoritmi utilizzati nei modelli predittivi?

Gli algoritmi più usati nei modelli predittivi includono regressione lineare, alberi decisionali, reti neurali e metodi ensemble come random forest e boosting.

❓Cosa significa predittività e quali sono i fattori predittivi?

La predittività misura quanto un modello anticipa correttamente un evento. I fattori predittivi sono le variabili che influenzano la previsione, scelte in base alla loro rilevanza statistica.

❓Che cos’è l’incertezza nei modelli predittivi e come viene quantificata?

L’incertezza predittiva indica quanto è affidabile una previsione. Si stima con intervalli di confidenza, conformal prediction e analisi della varianza.

❓Come si garantisce interpretabilità e fairness nei modelli predittivi?

L’interpretabilità si ottiene con metodi come LIME e SHAP, che spiegano le decisioni. La fairness richiede controlli sui bias e trasparenza negli algoritmi.

❓Quali sono le sfide etiche e normative nell’uso dei modelli predittivi?

I rischi includono bias algoritmici, uso scorretto dei dati e non conformità al GDPR. Serve governance, audit e attenzione all’equità nelle decisioni.

❓Come ridurre l’impronta ambientale dei modelli predittivi?

Si può usare green AI, modelli ottimizzati per l’efficienza, e sistemi distribuiti che riducono i consumi, come il federated learning e l’edge computing.